سام بانكمان - فريد يستأنف إدانته بالاحتيال من خلال ملف مكون من 102 صفحة، ويزعم التحيز القضائي والمحاكمة غير العادلة

لم ينته سام بانكمان فريد، مؤسس بورصة العملات المشفرة المنهارة FTX، من سرد قصته بعد.

XingChi

XingChi

في أحد أيام شهر ديسمبر من عام 2012، كان هناك مزاد سري في أحد فنادق الكازينو في منتجع التزلج الأمريكي في بحيرة تاهو.

تقع بحيرة تاهو عند تقاطع كاليفورنيا ونيفادا وهي أكبر بحيرة جبال الألب في أمريكا الشمالية ولها سطح بحيرة يشبه الياقوت وأعلى. مسارات ثلجية ظهرت في فيلم "The Godfather 2" الذي تم تصويره هنا، حيث بقي مارك توين هنا ذات مرة، ولأنها تبعد أكثر من 200 ميل فقط عن منطقة خليج سان فرانسيسكو، غالبًا ما يطلق عليها "حديقة وادي السيليكون الخلفية". وأسماء كبيرة مثل زوكربيرج ولاري إليسون موجودة أيضًا هنا. يحتل هذا العلبة منطقة جبلية ويستخدم لبناء القصور.

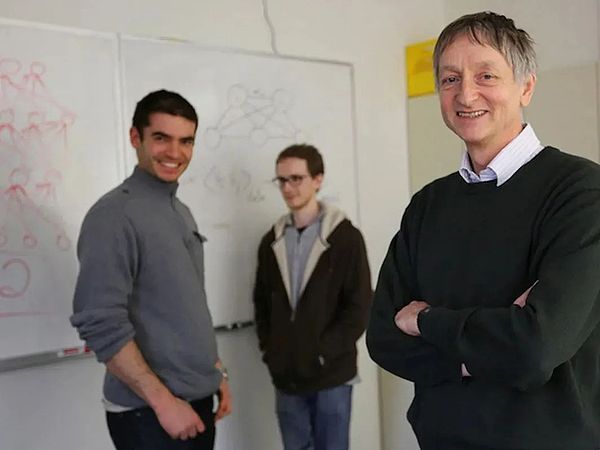

الهدف من المزاد السري هو DNNresearch، وهي شركة تم تأسيسها للتو لمدة شهر واحد ولديها ثلاثة موظفين فقط. المؤسس هو جيف، أستاذ في جامعة تورنتو جيفري هينتون واثنين من طلابه.

لا تمتلك هذه الشركة أي منتجات أو أصول ملموسة، لكن هوية الخاطبين تشير إلى ثقلها -المشترون الأربعة هم جوجل، ومايكروسوفت، ديب مايند وبايدو.

فندق هارا يعقد مزادًا سريًا، بحيرة تاهو، 2012

هينتون، 65 عامًا، عجوز ونحيف ويعاني من مشاكل في القرص في بلده العمود الفقري القطني، وهو يعاني من الألم، جلس على أرضية الغرفة 703 بالفندق ووضع قواعد المزاد - عرض مبدئي بقيمة 12 مليون دولار، مع عرض بقيمة مليون دولار على الأقل.

اتصل بالتوقف وقرر بيع الشركة لآخر مزايد - Google.

ومن المثير للاهتمام أن أحد مصادر هذا المزاد الذي تبلغ قيمته 44 مليون دولار جاء من Google قبل 6 أشهر.

في يونيو 2012، كشف قسم أبحاث Google Google Brain عن نتائج بحث مشروع Cat Neurons (أي "Google Cat"). ببساطة، يهدف هذا المشروع إلى استخدام الخوارزميات للتعرف على القطط في مقاطع الفيديو على YouTube، وقد بدأه Andrew Ng، الذي انتقل إلى Google من جامعة ستانفورد، وقد اجتذب أسطورة Google Jeff Dean للانضمام إلى الفريق، وحصل أيضًا على ميزانية كبيرة من مؤسس Google لاري بيج.

قام مشروع Google Cat ببناء شبكة عصبية، وتنزيل عدد كبير من مقاطع الفيديو من YouTube، ولم يضع علامة عليها، مما يسمح للنموذج بملاحظة الخصائص والتعرف عليها من القطط بمفردها، ثم تم استخدام 16000 وحدة معالجة مركزية منتشرة عبر مراكز بيانات Google للتدريب (تم رفض وحدات معالجة الرسومات داخليًا لأنها كانت معقدة للغاية ومكلفة)، وحققت أخيرًا دقة التعرف بنسبة 74.8%. لقد صدم هذا الرقم الصناعة.

ترك Ng Enda مشروع "Google Cat" قبل النهاية وكرس نفسه لمشروعه الخاص للتعليم عبر الإنترنت، وقبل مغادرته، أوصى Hinton للشركة ليحل محله العمل له. وفي مواجهة الدعوة، قال هينتون إنه لن يترك الكلية، وإنه على استعداد للذهاب إلى جوجل فقط من أجل "البقاء في الصيف". ونظرًا للطبيعة الخاصة لقواعد التوظيف في جوجل، أصبح هينتون، البالغ من العمر 64 عامًا، أقدم متدرب صيفي في تاريخ جوجل.

كان هينتون في طليعة الذكاء الاصطناعي منذ الثمانينيات كأستاذ، لديه عائلة ثرية (بما في ذلك إنج إندا) وهو ماجستير في الذكاء الاصطناعي مجال التعلم العميق الشكل. لذلك عندما علم بالتفاصيل الفنية لمشروع Google Cat، رأى على الفور الخلل الخفي وراء نجاح المشروع: "لقد كانوا يقومون بتشغيل شبكة عصبية خاطئة ويستخدمون قوة حاسوبية خاطئة."

نفس المهمة، يعتقد هينتون أن بإمكانه القيام بعمل أفضل. لذلك بعد انتهاء "فترة التدريب" القصيرة، قفز على الفور إلى العمل.

وجد هينتون اثنين من طلابه - إيليا سوتسكيفر وألكس كريزيفسكي، وكلاهما يهوديان ولدا في الاتحاد السوفيتي، وكان الأول موهوبًا للغاية في الرياضيات. الأخير جيد في التنفيذ الهندسي. عمل الثلاثة معًا بشكل وثيق لإنشاء شبكة عصبية جديدة، ثم شاركوا على الفور في مسابقة ImageNet للتعرف على الصور (ILSVRC)، وفازوا أخيرًا بالبطولة بمعدل دقة التعرف المذهل الذي بلغ 84%.

في أكتوبر 2012، قدم فريق هينتون الخوارزمية الرائدة AlexNet في مؤتمر رؤية الكمبيوتر في فلورنسا، مقارنةً بـ Google Cat، الذي يستخدم 16000 وحدة معالجة مركزية، بينما يستخدم AlexNet 4 فقط لقد أحدثت وحدات معالجة الرسومات NVIDIA ضجة كبيرة في الأوساط الأكاديمية والصناعة. وأصبحت ورقة AlexNet واحدة من أكثر الأوراق البحثية تأثيرًا في تاريخ علوم الكمبيوتر، وقد تم الاستشهاد بها أكثر من 120 ألف مرة، بينما تم نسيان Google Cat بسرعة.

DNNresearch trio

كان يو كاي، الذي فاز بأول بطولة لمسابقة ImageNet، متحمسًا للغاية بعد قراءة الورقة، "كما لو أنه تعرض للصعق بالكهرباء". يو كاي هو خبير في التعلم العميق ولد في جيانغشي، وقد انتقل للتو من شركة NEC إلى بايدو وكتب على الفور بريدًا إلكترونيًا إلى هينتون وأعرب عن فكرة التعاون التي وافق عليها هينتون ببساطة وقام بجمع نفسه مع اثنين من الطلاب في عائلة دعت الشركة المشترين لتقديم عطاءاتهم، وهكذا كان المشهد الافتتاحي.

بعد سقوط المزاد، بدأت منافسة أكبر: تابعت Google النصر واستحوذت على DeepMind في عام 2014، "كل أبطال العالم فيها"؛ وأطلقت شركة AlphaGo في عام 2016، مما صدم العالم، وقررت شركة Baidu، التي خسرت أمام Google، الرهان على الذكاء الاصطناعي واستثمرت مئات المليارات في عشر سنوات، وساعد Yu Kai لاحقًا شركة Baidu في دعوة Ng Enda، وترك وظيفته بعد بضع سنوات في وقت لاحق لبدء الأفق.

بدت مايكروسوفت بطيئة بعض الشيء، لكنها في النهاية فازت بالجائزة الكبرى - OpenAI، والتي من بين مؤسسيها هينتون، أحد الطلاب هو إيليا سوتسكيفر. وسيبقى هينتون نفسه في جوجل حتى عام 2023، حيث فاز بجائزة ACM Turing. وبطبيعة الحال، بالمقارنة مع جائزة جوجل البالغة 44 مليون دولار (حصل هينتون على 40%)، فإن جائزة تورينج البالغة مليون دولار تبدو وكأنها مصروف جيب.

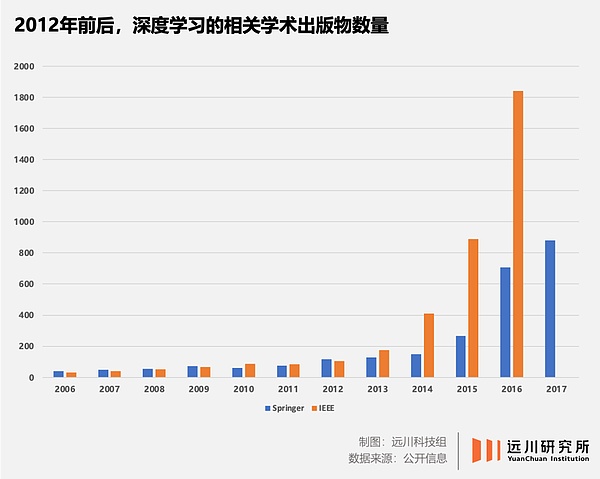

من Google Cat في يونيو، إلى صحيفة AlexNet في أكتوبر، إلى مزاد بحيرة تاهو في ديسمبر، في ما يقرب من 6 أشهر، كل ما تنبأ به الذكاء الاصطناعي تقريبًا لقد تم دفن هذه الموجة – ازدهار التعلم العميق، وصعود GPU وNVIDIA، وهيمنة AlphaGo، وولادة Transformer، وظهور ChatGPT... لعبت الحركة الكبرى لعصر الازدهار القائم على السيليكون دورًا أولًا ملحوظة.

في غضون 180 يومًا من يونيو إلى ديسمبر 2012، تغير مصير البشر الذين يعتمدون على الكربون إلى الأبد - ولم يدرك ذلك سوى عدد قليل من الناس.

من بين هؤلاء الأشخاص القلائل جدًا، ستانفورد الأستاذ الجامعي لي فيفي هو واحد منهم.

في عام 2012، عندما ظهرت نتائج مسابقة ImageNet التابعة لـ Hinton، كانت Li Feifei، التي أنجبت للتو طفلها، لا تزال في إجازة أمومة، لكن معدل الخطأ الذي ارتكبه فريق هينتون جعلها تدرك أن التاريخ يُعاد كتابته. وباعتبارها مؤسسة تحدي ImageNet، فقد اشترت الرحلة الأخيرة في اليوم إلى فلورنسا لتمنح فريق هينتون شخصيًا [2].

ولدت لي فايفي في بكين ونشأت في تشنغدو عندما كانت في السادسة عشرة من عمرها، هاجرت إلى الولايات المتحدة مع والديها وكانت تساعد في غسيل الملابس أنهت دراستها في برينستون. في عام 2009، دخلت لي فايفي جامعة ستانفورد كأستاذة مساعدة. اتجاه بحثها هو رؤية الكمبيوتر والتعلم الآلي. الهدف من هذا الموضوع هو تمكين أجهزة الكمبيوتر من فهم معنى الصور والصور بنفسها مثل البشر.

على سبيل المثال، عندما تلتقط الكاميرا صورة قطة، فإنها تقوم فقط بتحويل الضوء إلى بكسلات من خلال المستشعر، ولا تعرف ما إذا كان الشيء الموجود في العدسة أم لا هو قطة أو كلب. إذا تمت مقارنة الكاميرا بالعين البشرية، فإن المشكلة التي يتم حلها عن طريق الرؤية الحاسوبية هي تزويد الكاميرا بعقل بشري.

الطريقة التقليدية هي تجريد الأشياء في العالم الحقيقي إلى نماذج رياضية. على سبيل المثال، يمكن أن يؤدي تجريد خصائص القطة إلى أشكال هندسية بسيطة إلى تقليل خصائص الآلة بشكل كبير صعوبة تحديد الهوية.

مصدر الصورة: خطاب Li Feifei في TED

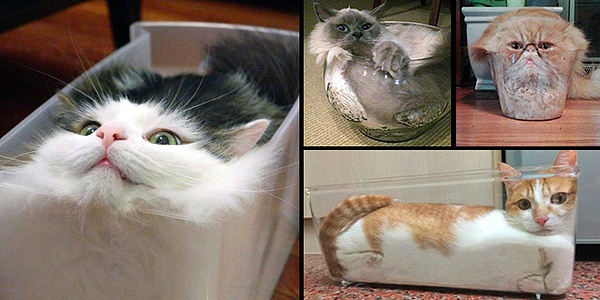

لكن هذه الفكرة لها قيود كبيرة جدًا، لأن القطط من المرجح أن تبدو هكذا:

من أجل تمكن أجهزة الكمبيوتر من التعرف على "القطط السائلة"، بدأ استكشافها عدد كبير من رواد التعلم العميق مثل جيف هينتون ويان ليكون في الثمانينيات. ومع ذلك، سيكون هناك دائمًا عنق الزجاجة في قوة الحوسبة أو الخوارزمية - تفتقر الخوارزميات الجيدة إلى قوة حوسبة كافية للقيادة، ولا يمكن للخوارزميات ذات متطلبات طاقة الحوسبة الصغيرة تلبية دقة التعرف ولا يمكن تصنيعها.

إذا لم يكن من الممكن حل مشكلة "القط السائل"، فإن جاذبية التعلم العميق يمكن أن تظل على المستوى النظري فقط، في صناعات مثل القيادة الذاتية، والتصوير الطبي ، والإعلان الدقيق هو مجرد قلعة في الهواء.

ببساطة، يتطلب تطوير التعلم العميقالخوارزمياتوقوة الحوسبة والبيانات. <باستخدام الترويكا، تحدد الخوارزميات كيفية تعرف أجهزة الكمبيوتر على الأشياء؛ لكن الخوارزميات تتطلب ما يكفي من قوة حاسوبية ليتم تشغيلها، وفي الوقت نفسه، يتطلب تحسين الخوارزميات أيضًا حجمًا كبيرًا - بيانات عالية الجودة؛ وتتكامل هذه العناصر الثلاثة مع بعضها البعض ولا غنى عنها.

بعد عام 2000، على الرغم من القضاء على عنق الزجاجة في قوة الحوسبة تدريجيًا مع التقدم السريع في قدرات معالجة الرقائق، إلا أن الدوائر الأكاديمية السائدة لا تزال تظهر القليل من الاهتمام بمسار التعلم العميق. أدرك لي فيفي أن عنق الزجاجة قد لا يكون في دقة الخوارزمية نفسها، ولكن في الافتقار إلى مجموعات بيانات عالية الجودة وواسعة النطاق.

يأتي إلهام Li Feifei من الطريقة التي يفهم بها الأطفال في سن الثالثة العالم - بأخذ القطط كمثال، سيلتقي الأطفال بالقطط مرارًا وتكرارًا تحت التوجيه. من البالغين، وفهم تدريجيا معنى القط. إذا تم التعامل مع عيون الطفل ككاميرا، وحركة عين واحدة تساوي نقرة واحدة على مصراع الكاميرا، فإن طفل يبلغ من العمر ثلاث سنوات قد التقط مئات الملايين من الصور.

طبق هذه الطريقة على الكمبيوتر إذا عرضت على الكمبيوتر صور قطط وحيوانات أخرى، اكتب الإجابة الصحيحة خلف كل صورة. وفي كل مرة ينظر فيها الكمبيوتر إلى الصورة، فإنه يقوم بمقارنتها بالإجابة الموجودة في الخلف. وبعد ذلك، مع مرور الوقت الكافي، من الممكن للكمبيوتر أن يفهم معنى "قطة" تمامًا مثل الطفل.

المشكلة الوحيدة التي تحتاج إلى حل هي: أين يمكنني العثور على الكثير من الصور مع الإجابات المكتوبة؟

جاء Li Feifei إلى الصين في عام 2016 وأعلن عن إنشاء مركز Google AI الصيني

كانت هذه فرصة ولادة ImageNet . في ذلك الوقت، حتى أكبر مجموعة بيانات، PASCAL، كانت تحتوي على أربع فئات فقط بإجمالي 1578 صورة، وكان هدف Li Feifei هو إنشاء مجموعة بيانات تحتوي على مئات الفئات بإجمالي عشرات الملايين من الصور. قد لا يبدو الأمر صعبًا الآن، ولكن عليك أن تتذكر أنه كان ذلك في عام 2006 وكان الهاتف المحمول الأكثر شهرة في العالم هو Nokia 5300.

بالاعتماد على منصة Amazon للتعهيد الجماعي، تمكن فريق Li Feifei من حل عبء العمل الضخم للتعليقات التوضيحية اليدوية. في عام 2009، تم إنشاء مجموعة بيانات ImageNet التي تحتوي على 3.2 مليون صورة. باستخدام مجموعة بيانات الصورة، يمكن تدريب الخوارزمية على هذا الأساس للسماح للكمبيوتر بتحسين قدرات التعرف عليه. ولكن بالمقارنة مع مئات الملايين من الصور لأطفال في سن الثالثة، فإن 3.2 مليون صورة لا تزال صغيرة جدًا.

من أجل توسيع مجموعة البيانات بشكل مستمر، قرر Li Feifei اتباع الممارسة الشائعة في الصناعة وعقد مسابقة للتعرف على الصور. أحضر المشاركون خوارزمياتهم الخاصة التعرف على الصور الموجودة في مجموعة البيانات بدقة أكبرها يفوز. ومع ذلك، لم يكن مسار التعلم العميق سائدًا في ذلك الوقت، ولم يكن بإمكان ImageNet سوى "الانتساب" ضمن المنافسة الأوروبية المعروفة PASCAL في البداية للحصول على عدد من المشاركين بالكاد.

بحلول عام 2012، زاد عدد صور ImageNet إلى 1000 فئة، بإجمالي 15 مليون صورة، أمضى Li Feifei 6 سنوات في تعويض أوجه القصور فيها بيانات. ومع ذلك، فإن أفضل نتيجة لـ ILSVRC لديها معدل خطأ يبلغ 25%، والذي لا يزال لا يظهر ما يكفي من الإقناع من حيث الخوارزمية وقوة الحوسبة.

في هذا الوقت، ظهر المعلم هينتون ومعه AlexNet وبطاقتي رسومات GTX580.

خوارزمية بطل فريق هينتون AlexNet، باستخدام خوارزمية تسمى الشبكات العصبية التلافيفية (CNN للاختصار). "الشبكة العصبية" هي كلمة عالية التردد للغاية في مجال الذكاء الاصطناعي وهي أيضًا فرع من فروع التعلم الآلي. اسمها وبنيتها مأخوذة من الطريقة التي يعمل بها الدماغ البشري.

تتمثل عملية التعرف على الأشياء لدى البشر في أن حدقة العين تأخذ وحدات البكسل أولاً، وتقوم القشرة الدماغية بالمعالجة الأولية من خلال الحواف والاتجاهات، ثم يصدر الدماغ الأحكام من خلال التجريد المستمر. لذلك، يمكن للعقل البشري التعرف على الأشياء بناءً على بعض الخصائص.

على سبيل المثال، بدون إظهار الوجه بالكامل، يمكن لمعظم الأشخاص التعرف على هوية الشخص الموجود في الصورة أدناه:

الشبكة العصبية تحاكي في الواقع الدماغ البشري يمكن تحقيق آلية التعرف بواسطة أجهزة كمبيوتر ذكية يمكن تحقيقها نظريًا بواسطة الدماغ البشري. بالمقارنة مع SVM وشجرة القرار والغابة العشوائية وغيرها من الأساليب، فإن محاكاة الدماغ البشري فقط هي التي يمكنها معالجة البيانات غير المنظمة مثل "Liquid Cat" و"Half Trump".

لكن المشكلة هي أن الدماغ البشري يحتوي على حوالي 100 مليار خلية عصبية، وهناك تريليونات من العقد (أي المشابك العصبية) بين الخلايا العصبية لتشكل مجموعة معقدة للغاية شبكة. للمقارنة، فإن "Google Cat" المكون من 16000 وحدة معالجة مركزية كان يحتوي على إجمالي مليار عقدة بداخله، وكان هذا بالفعل نظام الكمبيوتر الأكثر تعقيدًا في ذلك الوقت.

وهذا هو السبب الذي جعل حتى "أبو الذكاء الاصطناعي" مارفن مينسكي غير متفائل بهذا الطريق عندما نشر كتابه الجديد "آلة العاطفة" عام 2007 لا يزال مينسكي يعرب عن تشاؤمه بشأن الشبكات العصبية. من أجل تغيير الموقف السلبي طويل الأمد لمجتمع التعلم الآلي تجاه الشبكات العصبية الاصطناعية، أعاد هينتون تسميتها ببساطة بالتعلم العميق (التعلم العميق).

في عام 2006، نشر هينتون ورقة بحثية في مجلة العلوم، يقترح فيها مفهوم "شبكة المعتقد العميق العصبية (DBNN)" ويعطي أسلوب تدريب متعدد الطبقات تعتبر الشبكة العصبية العميقة إنجازًا كبيرًا في التعلم العميق. ومع ذلك، تتطلب طريقة هينتون قدرًا كبيرًا من القدرة الحاسوبية والبيانات، مما يجعل من الصعب تنفيذها في التطبيقات العملية.

يتطلب التعلم العميق تغذية مستمرة للبيانات للخوارزمية، وكان حجم مجموعات البيانات في ذلك الوقت صغيرًا جدًا حتى ظهور ImageNet.

في أول مسابقتين من ImageNet، استخدمت الفرق المشاركة طرقًا أخرى للتعلم الآلي، وكانت النتائج متواضعة تمامًا. تم تحسين الشبكة العصبية التلافيفية AlexNet التي استخدمها فريق هينتون في عام 2012 من رائد آخر للتعلم العميق، وهو يان ليكون، وقد سمحت شبكة LeNet التي اقترحها في عام 1998 للخوارزمية باستخراج السمات الرئيسية للصور، مثل صورة ترامب الأشقر.

وفي الوقت نفسه، ستنزلق نواة الالتواء على الصورة المدخلة، لذلك بغض النظر عن مكان وجود الكائن المكتشف، يمكن اكتشاف نفس الميزات، وهو أمر كبير يقلل من كمية العمليات.

استنادًا إلى بنية الشبكة العصبية التلافيفية الكلاسيكية، تتخلى AlexNet عن الطريقة السابقة غير الخاضعة للرقابة طبقة تلو الأخرى وتجري تعلمًا خاضعًا للإشراف لقيم الإدخال، مما يؤدي إلى تحسين الدقة بشكل كبير.

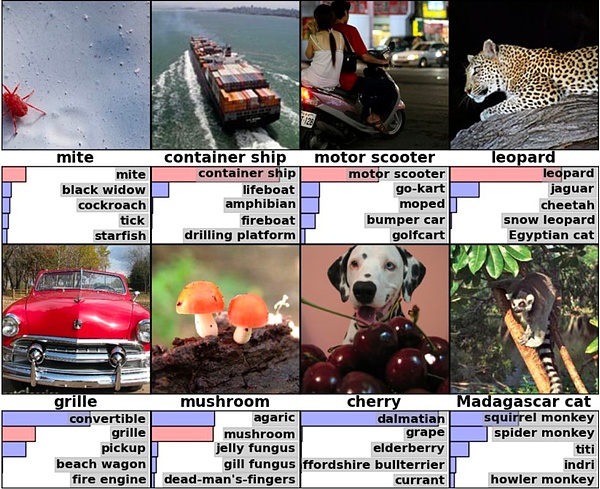

على سبيل المثال، في الصورة الموجودة في الزاوية اليمنى السفلية من الصورة أدناه، لم تحدد AlexNet فعليًا الإجابة الصحيحة (قطة مدغشقر)، ولكنها أدرجت نفس الإجابات مثل قطة مدغشقر وهي ثدييات صغيرة يمكنها تسلق الأشجار، مما يعني أن الخوارزمية لا يمكنها فقط تحديد الكائن نفسه، ولكن أيضًا إجراء استنتاجات بناءً على كائنات أخرى [5].

مصدر الصورة: ورقة AlexNet

الصناعة متحمسة لأن AlexNet لديها 60 مليون معلمة و650.000 خلية عصبية، لتدريب بيانات ImageNet بشكل كامل. تتطلب المجموعة ما لا يقل عن 262 بيتافلوب. . لكن فريق هينتون استخدم فقط بطاقتي رسوميات Nvidia GTX 580 خلال أسبوع من التدريب.

بعد فوز فريق هينتون بالبطولة، من الواضح أن الأكثر إحراجًا هو Google.

يقال إن Google أجرت أيضًا اختبارات داخلية على مجموعة بيانات ImageNet، لكن دقة التعرف متخلفة كثيرًا عن فريق هينتون. بالنظر إلى أن Google لديها موارد أجهزة لا مثيل لها في الصناعة، بالإضافة إلى حجم البيانات الضخم للبحث ويوتيوب، فقد قام قادة Google Brain بتعيين مهام خاصة خصيصًا، ومن الواضح أن النتائج ليست مقنعة بدرجة كافية.

بدون هذا التباين الهائل، ربما لم يكن التعلم العميق ليهز الصناعة ويكتسب الاعتراف والشعبية في فترة قصيرة من الزمن. السبب وراء حماسة الصناعة هو أن فريق هينتون استخدم أربع وحدات معالجة رسوميات فقط لتحقيق مثل هذه النتائج الجيدة، لذلك لم تعد قوة الحوسبة تمثل عنق الزجاجة.

عندما يتم تدريب الخوارزمية، ستقوم بإجراء عمليات هرمية على وظائف ومعلمات كل طبقة من الشبكة العصبية للحصول على نتائج الإخراج، ويحدث GPU أن يكون لديك عمليات موازية قوية جدًا. لقد أثبت إنج ذلك بالفعل في ورقة بحثية عام 2009، ولكن عند تشغيل "Google Cat" مع جيف دين، استمروا في استخدام وحدة المعالجة المركزية. في وقت لاحق، طلب جيف دين بشكل خاص معدات بقيمة 2 مليون دولار أمريكي، والتي لا تزال لا تشمل وحدة معالجة الرسومات[6].

Hinton هو أحد الأشخاص القلائل الذين أدركوا القيمة الهائلة لوحدة معالجة الرسومات للتعلم العميق في وقت مبكر جدًا، ومع ذلك، قبل تصنيف AlexNet في القائمة، كانت التكنولوجيا الفائقة الشركات عموما لم تكن مهتمة بموقف GPU غير واضح.

في عام 2009، تمت دعوة هينتون إلى Microsoft ليكون مستشارًا فنيًا قصير المدى لمشروع التعرف على الكلام، واقترح أن يقوم قائد المشروع Deng Li بشراء الجزء العلوي نفيديا GPU، ولكن أيضا مع الخادم المقابل. وقد أيد دينغ لي هذه الفكرة، لكن رئيس دينغ لي، أليكس أسيرو، رأى أن هذا مجرد مضيعة للمال [6]. "تُستخدم وحدات معالجة الرسومات لممارسة الألعاب، وليس لأبحاث الذكاء الاصطناعي."

دنغ لي

ومن المثير للاهتمام أن Alex Acero قام لاحقًا بتحويل وظائفه إلى Apple وكان مسؤولاً عن برنامج Siri للتعرف على الكلام من Apple.

من الواضح أن عدم التزام Microsoft بوحدات معالجة الرسومات جعل هينتون غاضبًا بعض الشيء. واقترح لاحقًا في رسالة بريد إلكتروني أن يشتري Deng Li مجموعة من المعدات وسيشتري ثلاث مجموعات ويقولون بسخرية [6]: في نهاية المطاف، نحن جامعة كندية تتمتع بموارد مالية قوية، ولسنا بائع برمجيات يعاني من ضائقة مالية.

ولكن بعد تحدي ImageNet لعام 2012، تحول جميع علماء الذكاء الاصطناعي وشركات التكنولوجيا 180 درجة نحو وحدات معالجة الرسومات. في عام 2014، فازت شركة Google GoogLeNet بالبطولة بدقة تعرف بلغت 93%، باستخدام وحدات معالجة الرسومات NVIDIA. وفي هذا العام، ارتفع عدد وحدات معالجة الرسومات المستخدمة من قبل جميع الفرق المشاركة إلى 110.

إن السبب وراء اعتبار هذا التحدي بمثابة "لحظة الانفجار الكبير" يكمن في ثلاثية خوارزميات التعلم العميق، وقوة الحوسبة، والبيانات تم تجديده، والتصنيع هو مجرد مسألة وقت.

على مستوى الخوارزميات، أصبحت الورقة البحثية حولAlexNet التي نشرها فريق هينتون هيعلوم الكمبيوتر الأولى. من الأوراق الأكثر ذكرا في هذا المجال. أصبح المسار التقني الذي كان في الأصل يضم مائة مدرسة فكرية متنافسة أحدالتعلم العميق وحده، وجميعالرؤية الحاسوبية تقريبًا >تحولت الأبحاث إلىالشبكات العصبية.

مستوى قوة الحوسبة، وحدة معالجة الرسومات تم التعرف بسرعة على قدرةالحوسبة المتوازيةوالتعلم العميقوالقدرة على التكيف من قبل الصناعة، وبدأ التخطيط قبل ستة أعوام، أصبحت NVIDIA من /strong>CUDA هي الفائز الأكبر.

مستوى البيانات، ImageNetيصبح تعتبر خوارزميات معالجة الصور، مع مجموعات البيانات عالية الجودة، دقة التعرف على الخوارزميات تتحسن يومًا بعد يوم. وفي التحدي الأخير عام 2017، وصلت دقة التعرف على الخوارزمية البطلة إلى 97.3%، متجاوزة البشر.

في نهاية أكتوبر 2012، نشر أليكس كريزيفسكي، طالب هينتون، ورقة بحثية في مؤتمر رؤية الكمبيوتر في فلورنسا، إيطاليا. بعد ذلك، بدأت شركات التكنولوجيا المتقدمة في جميع أنحاء العالم في القيام بأمرين بغض النظر عن التكلفة: كان الأول هو شراء جميع بطاقات الرسوميات من NVIDIA، وكان الآخر هو القيام بذلك سرقة جميع بطاقات الرسومات الخاصة بالجامعات قوية>الذكاء الاصطناعيالباحث.

أعادت تكلفة بحيرة تاهو البالغة 44 مليون دولار تسعير أساتذة التعلم العميق في العالم.

من المعلومات المتاحة للعامة، يو وكان كاي، الذي كان لا يزال في بايدو في ذلك الوقت، أول شخص قام بحفر هينتون.

في ذلك الوقت، شغل يو كاي منصب رئيس قسم بايدو للوسائط المتعددة في بايدو، والذي كان سلف معهد بايدو للتعلم العميق (IDL). بعد تلقي البريد الإلكتروني من يو كاي، رد هينتون سريعًا بأنه وافق على التعاون، وبالمناسبة، أعرب عن رغبته في أن تقدم بايدو بعض الأموال. طلب يو كاي رقمًا محددًا، وقال هينتون إن مليون دولار أمريكي سيكون كافيًا - وكان هذا الرقم منخفضًا بشكل لا يصدق ويمكنه استئجار اثنين فقط من P8.

طلب يو كاي من روبن لي الحصول على التعليمات، ووافق الأخير بسهولة. بعد أن رد يو كاي بأنه لا توجد مشكلة، ربما شعر هينتون بجوع الصناعة، فسأل يو كاي عما إذا كان يمانع في سؤال شركات أخرى، مثل جوجل. يتذكر يو كاي لاحقًا [6]:

"شعرت ببعض الندم في ذلك الوقت. أعتقد أنني أجبت بسرعة كبيرة جدًا، مما جعل هينتون يدرك الفرصة الهائلة. ومع ذلك، لا يسعني إلا أن أقول بسخاء إنني لا أمانع.» وفي النهاية، أخطأ فريق بايدو وهينتون في ذلك. لكن يو كاي لم يكن مستعدًا لهذه النتيجة. فمن ناحية، يعاني هينتون من مشاكل صحية خطيرة في القرص القطني ولا يستطيع القيادة أو الطيران، مما يجعل من الصعب عليه تحمل الرحلة عبر المحيط الهادئ إلى الصين، ومن ناحية أخرى، لدى هينتون عدد كبير جدًا من الطلاب والأصدقاء الذين يعملون في جوجل، وكلاهما الأطراف الأصل عميق جدًا، والشركات الثلاث الأخرى ترافق العطاء بشكل أساسي.

إذا كان تأثير AlexNet لا يزال يتركز في الدائرة الأكاديمية، فإن المزاد السري في بحيرة تاهو صدم الصناعة تمامًا - لأن Google تتمتع بتأثير كبير على العالم شركات التكنولوجيا، أنفق 44 مليون دولار لشراء شركة عمرها أقل من شهر، ولم يكن لديها منتجات ولا إيرادات، فقط ثلاثة موظفين وعدد قليل من الأوراق.

من الواضح أن بايدو هي الأكثر إثارة، على الرغم من فشلها في المزاد، إلا أن إدارة بايدو شهدت بشكل مباشر كيف استثمرت جوجل في التعلم العميق بأي ثمن، مما دفع بايدو إلى القيام بذلك. قررت الاستثمار، وأعلنت عن إنشاء معهد أبحاث التعلم العميق IDL في الاجتماع السنوي في يناير 2013. وفي مايو 2014، دعت بايدو أندرو نج، وهو شخصية رئيسية في مشروع "Google Cat"، وفي يناير 2017، دعت لو تشي، الذي ترك مايكروسوفت.

واصلت جوجل جهودها بعد الفوز بفريق هينتون، واشترت شركة ديب مايند، المنافس في ذلك العام، مقابل 600 مليون دولار أمريكي في عام 2014.

في ذلك الوقت، أوصى " ماسك " بشركة DeepMind، التي استثمر فيها، لمؤسس Google "Larry Page" من أجل اصطحاب "هينتون" معه إلى لندن لاختبار الجودة. كما قام فريق جوجل أيضًا بتأجير طائرة خاصة وتعديل المقاعد لحل مشكلة هينتون المتمثلة في عدم قدرته على الطيران [6].

"اللاعب البريطاني" DeepMind هزم Lee Sedol في لعبة Go عام 2016

كان Facebook هو الذي تنافس مع Google على DeepMind. عندما سقطت شركة DeepMind في يد Google، لجأ زوكربيرج إلى اصطياد يانج ليكون، أحد "الثلاثة الكبار" في مجال التعلم العميق. من أجل وضع يانغ ليكون تحت إمرته، وافق زوكربيرج على العديد من متطلباته الصعبة، مثل إنشاء مختبر الذكاء الاصطناعي في نيويورك، ورسم خط واضح تمامًا بين المختبر وفريق المنتج، والسماح ليانغ ليكون الاستمرار في العمل في جامعة نيويورك، الخ.

بعد تحدي 2012ImageNet، يواجه مجال الذكاء الاصطناعي تحديًا خطيرًا للغاية " مشكلة "عدم تطابق العرض والطلب على المواهب":

مع الانفتاح السريع لمساحات التصنيع مثل خوارزميات التوصية والتعرف على الصور والقيادة الذاتية ، زاد الطلب على المواهب بشكل حاد. ومع ذلك، نظرًا لأنه لم يكن مفضلاً لفترة طويلة، فإن الباحثين في مجال التعلم العميق ليسوا سوى دائرة صغيرة، ويمكن حساب كبار العلماء على يدين، والإمدادات غير كافية على الإطلاق.

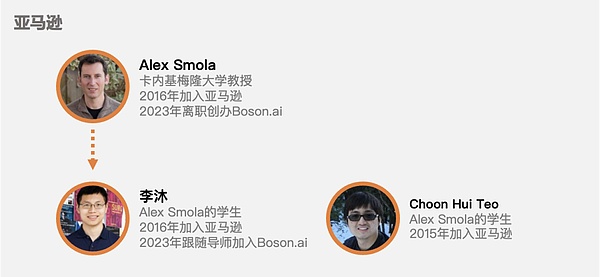

في هذه الحالة، لا تستطيع شركات التكنولوجيا المتعطشة سوى شراء "مستقبل المواهب":تصيد الأساتذة، ثم تنتظرهم حتى يقوموا بتوظيف طلابهم وإحضارهم .

بعد انضمام يانغ ليكون إلى فيسبوك، تبعه ستة طلاب للانضمام إلى الشركة. قامت شركة أبل، التي هي على استعداد لإحداث قفزة في صناعة السيارات، بتعيين طالب هينتون رسلان سالاخوتدينوف ليكون أول مدير للذكاء الاصطناعي في شركة أبل. حتى صندوق التحوط Citadel انضم إلى المنافسة وسرق دينج لي، الذي عمل في مجال التعرف على الكلام مع هينتون وشارك لاحقًا في مزايدة سرية نيابة عن مايكروسوفت.

نحن نعرف التاريخ بوضوح شديد: التعرف على الوجه، والترجمة الآلية، والقيادة الذاتية، وغيرها من السيناريوهات الصناعية تتقدم آلاف الأميال يوميًا يومًا بعد يوم، تتساقط طلبات GPU مثل رقاقات الثلج على مقر NVIDIA في سانتا كلارا، كما يتدفق البناء النظري للذكاء الاصطناعي يومًا بعد يوم.

في عام 2017، اقترحت Google نموذج Transformer في الورقة البحثية "الانتباه هو كل ما تحتاجه"، إيذانا ببدء عصر النماذج الكبيرة اليوم. وبعد سنوات قليلة، ولد ChatGPT.

يمكن إرجاع ولادة كل هذا إلى تحديImageNet2012 .

إذن، في أي عام ظهرت العملية التاريخية التي عززت ميلاد "لحظة الانفجار الكبير" في عام 2012؟

الإجابة هي 2006.

رائع

قبل عام 2006، كان التعلم العميق الوضع الحالي ويمكن تلخيص ذلك بمقولة البارون كلفن الشهيرة: لقد اكتمل بناء التعلم العميق بشكل أساسي، ولكن هناك ثلاث سحب داكنة صغيرة تطفو تحت السماء المشمسة.

هذه السحب المظلمة الثلاثة الصغيرة هي الخوارزميات وقوة الحوسبة والبيانات.

كما ذكرنا من قبل، يعد التعلم العميق حلاً مثاليًا من الناحية النظرية لأنه يحاكي آلية الدماغ البشري. لكن المشكلة تكمن في أن البيانات التي تحتاج إلى استيعابها والقدرة الحاسوبية التي تحتاج إلى استهلاكها كانت على مستوى الخيال العلمي في ذلك الوقت، بدءًا من الخيال العلمي وحتى العالم الأكاديمي، وكانت النظرة السائدة للتعلم العميق هي: العلماء مع العقول الطبيعية لن تقوم بالبحثالشبكات العصبية.

ولكن حدثت ثلاثة أشياء في عام 2006 غيرت هذا:

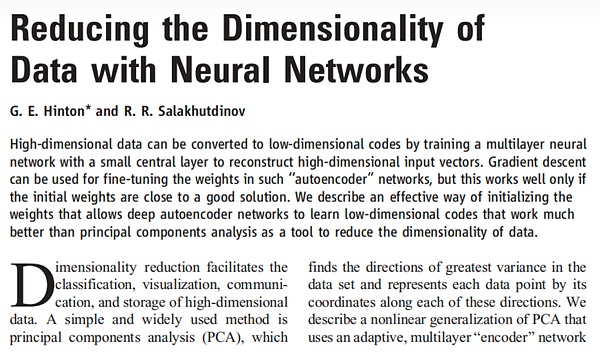

نشر هينتون وطالبه سالاخوتدينوف (الذي ذهب لاحقًا إلى شركة Apple) ورقة بحثية بعنوان تقليل أبعاد البيانات باستخدام الشبكات العصبية في العلوم، وكانت هذه هي المرة الأولى التي تكون فيها هذه الورقة فعالة تم اقتراح حل لمشكلة التدرج المتلاشي، وهي خطوة كبيرة إلى الأمام على مستوى الخوارزمية.

سالاخوتدينوف (أول اليسار) وهينتون (الأوسط)، 2016

أدرك فيفي لي من جامعة ستانفورد أنه إذا كانت البيانات كبيرة الحجم من الصعب استعادة المظهر الأصلي للعالم الحقيقي، لذلك بغض النظر عن مدى جودة الخوارزمية، فمن الصعب تحقيق تأثير "محاكاة الدماغ البشري" من خلال التدريب. لذلك، بدأت في إنشاء مجموعة بياناتImageNet.

تطلق Nvidia وحدة معالجة الرسومات الجديدة المستندة إلى Tesla وتطلقها وفقًا لذلك < /strong>CUDAالنظام الأساسي، يستخدم المطورون وحدة معالجة الرسومات لتدريب الشبكات العصبية العميقةبصعوبة أقل بكثير وثقة >< قوي>قوة الحوسبةلقد تم تخفيض الحد الأدنى كثيرًا.

أدى حدوث هذه الأشياء الثلاثة إلى إبعاد الغيوم السوداء الثلاث التي تحيط بالتعلم العميق، وتقاربت في تحدي ImageNet لعام 2012، وقد أعادت كتابتها بالكامل مصير صناعة التكنولوجيا الفائقة وحتى المجتمع البشري بأكمله.

ولكن في عام 2006، لم يتمكن جيف هينتون، أو لي فايفي، أو هوانغ رينكسون، أو غيرهم من الذين روجوا لتطوير التعلم العميق، من التنبؤ بمستقبل الذكاء الاصطناعي والازدهار الذي أعقب ذلك، ناهيك عن الأدوار التي لعبوها.

ورقة هينتون وسالاخوتدينوف

اليوم، بدأت الثورة الصناعية الرابعة التي يقودها الذكاء الاصطناعي باعتباره جوهرًا، مرة أخرى، وستكون سرعة تطور الذكاء الاصطناعي أسرع وأسرع. إذا تمكنا من تحديد مقدار الإلهام الذي يمكننا الحصول عليه، فقد لا يكون أكثر من النقاط الثلاث التالية:

1 ذروة الابتكار.

عندما ولد ChatGPT، كانت هناك أصوات كثيرة تقول "لماذا عادت الولايات المتحدة مرة أخرى؟" ولكن إذا قمت بتمديد الوقت، فستجد أنه من الترانزستورات والدوائر المتكاملة إلى بنية Unix وx86، والآن إلى التعلم الآلي، فإن الأوساط الأكاديمية والصناعة الأمريكية هي الرائدة دائمًا تقريبًا.

وهذا لأنه على الرغم من وجود مناقشات لا نهاية لها حول "تفريغ الصناعة" في الولايات المتحدة، إلا أن صناعة علوم الكمبيوتر التي تعتبر البرمجيات جوهرها لم تتغير بعد. فقط "النزوح الجماعي" لا يحدث أبدًا. "في الاقتصادات الأخرى، أصبحت المزايا أكبر وأكبر. وحتى الآن، فإن جميع الفائزين بجائزة ACM Turing، البالغ عددهم أكثر من 70 شخصًا تقريبًا، هم أمريكيون.

يرجع السبب وراء اختيار Andrew Ng لـ Google للتعاون مع مشروع "Google Cat" إلى حد كبير إلى أن Google هي الوحيدة التي تمتلك البيانات والقدرة الحاسوبية المطلوبة للتدريب على الخوارزميات، و وهذا أيضًا مبني على ربحية Google القوية. هذه هي الميزة التي توفرها كثافة الصناعة - فالمواهب والاستثمار وقدرات الابتكار ستقترب جميعها من أرض الصناعة المرتفعة.

تعكس الصين أيضًا "ميزة السُمك" هذه في صناعاتها المفيدة. في الوقت الحاضر، الأكثر شيوعًا هي سيارات الطاقة الجديدة. فمن ناحية، تقوم شركات السيارات الأوروبية برحلات جوية مستأجرة للقدوم إلى معرض السيارات الصيني للتعلم من القوى الجديدة، ومن ناحية أخرى، كثيرًا ما يغير المسؤولون التنفيذيون في شركات السيارات اليابانية وظائفهم إلى. BYD - لماذا؟ من الواضح أنني لا أحاول فقط دفع الضمان الاجتماعي في شنتشن.

2. كلما كان المجال التقني أكثر تطورًا، زادت أهمية المواهب.

السبب وراء استعداد Google لإنفاق 44 مليون دولار لشراء شركة هينتون هو أنه في مجال التقنيات المتطورة مثل التعلم العميق، غالبًا ما يكون الدور أكبر من دور 10000 خريج جديد متخصصين في رؤية الكمبيوتر. ولو نجحت بايدو أو مايكروسوفت في تقديم العطاءات في ذلك الوقت، فربما تمت إعادة كتابة تطوير الذكاء الاصطناعي.

هذا النوع من السلوك المتمثل في "شراء الشركة بأكملها لك" هو في الواقع أمر شائع جدًا. في المرحلة الحرجة من التطوير الذاتي للرقائق من قبل شركة أبل، اشترت شركة صغيرة تدعى PASemi فقط من أجل الاستيلاء على خبير هندسة الرقائق جيم كيلر - كل من رقائق A4 من Apple، ورقائق Zen من AMD، ورقائق FSD من Tesla، جميعها حصلت على تخفيف جيم كيلر للفقر من خلال التكنولوجيا.

وهذه أيضًا أكبر ميزة تجلبها القدرة التنافسية الصناعية - جذب المواهب.

لم يكن أي من "الثلاثة الكبار" في مجال التعلم العميق أمريكيًا. ويأتي اسم AlexNet من طالب هينتون أليكس كريزفسكي، الذي ولد في أوكرانيا في ظل الاتحاد السوفييتي. لقد نشأت في إسرائيل وأتيت إلى كندا للدراسة. ناهيك عن الوجوه الصينية العديدة التي لا تزال نشطة في شركات التكنولوجيا الفائقة الأمريكية اليوم.

3. تكمن صعوبة الابتكار في كيفية مواجهة عدم اليقين.

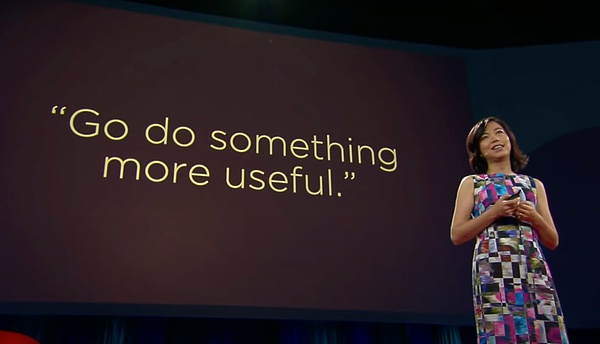

بالإضافة إلى معارضة "أبو الذكاء الاصطناعي" مارفن مينسكي للتعلم العميق، هناك معارض آخر معروف للتعلم العميق وهو جيتندرا من لقد سخر منه جامعة كاليفورنيا وبيركلي مالك وهينتون ونج. استشارت Li Feifei أيضًا مالك عند بناء ImageNet، وقدمت لها الأخيرة نصيحتها: افعل شيئًا أكثر فائدة.

خطاب تيد لي فيفي

إن الافتقار إلى التفاؤل لدى رواد الصناعة هؤلاء هو الذي تسبب في تجربة التعلم العميق لعقود من الصمت. على الرغم من أن هينتون قد أطلق شعاع الضوء في عام 2006، إلا أن يانغ ليكون، وهو عضو آخر في الشركات الثلاث الكبرى، كان لا يزال يثبت مرارًا وتكرارًا للمجتمع الأكاديمي أن "التعلم العميق له أيضًا قيمة بحثية".

كان يانغ ليكون يدرس الشبكات العصبية منذ الثمانينيات أثناء وجوده في مختبرات بيل، صمم يانغ ليكون وزملاؤه شريحة تسمى ANNA لمحاولة حل المشكلات الحسابية. مشكلة القوة. لاحقًا، طلبت AT&T من قسم الأبحاث "تمكين الأعمال" بسبب ضغوط التشغيل وكانت إجابة يانغ ليكون "أريد فقط أن أدرس رؤية الكمبيوتر. إذا كنت تستطيع ذلك، فاطردني". في النهاية، حصلت على المطرقة، ويسعدني أن أذكر N+1[6].

يجب أن يواجه الباحثون في أي مجال تكنولوجي متطور مشكلة -ماذا لو لم يكن من الممكن صنع هذا الشيء؟

منذ دخوله جامعة إدنبرة عام 1972، ظل هينتون يناضل في الخطوط الأمامية للتعلم العميق لمدة 50 عامًا. كان يبلغ من العمر 65 عامًا عندما أقيم تحدي ImageNet لعام 2012. من الصعب أن نتخيل مقدار الشك الذاتي والإنكار الذي كان عليه التغلب عليه في مواجهة الشكوك المختلفة في العالم الأكاديمي على مدى فترة طويلة من الزمن.

الآن نعلم أن هينتون في عام 2006 قد صمد حتى آخر ظلام قبل الفجر، لكنه هو نفسه ربما لا يعرف ذلك، ناهيك عن المجتمع الأكاديمي بأكمله صناعة. تمامًا كما حدث عندما تم إصدار iPhone في عام 2007، ربما كان لدى معظم الناس نفس رد فعل الرئيس التنفيذي لشركة Microsoft آنذاك بالمر:

حاليًا، لا يزال iPhone أغلى هاتف محمول في العالم، ولا يحتوي على لوحة مفاتيح

أولئك الذين يروجون للتاريخ غالبًا ما يفشلون في تخمين إحداثياتهم في العملية التاريخية.

إن السبب في عظمة العظمة ليس بسبب مظهرها المذهل عند ظهورها، بل لأنه يجب عليها أن تتحمل فترة طويلة من الغموض والغموض في اللامحدود الظلام. ولا يمكن للناس أن يتبعوا هؤلاء الحكام إلا بعد مرور سنوات عديدة، ويتحسرون على أن النجوم كانت تتألق بشكل مشرق وظهر العباقرة بأعداد كبيرة في ذلك الوقت.

في مجال تلو الآخر من مجالات البحث العلمي، لم يرَ عدد لا يحصى من العلماء بصيص أمل طوال حياتهم. لذلك، من وجهة نظر معينة، فإن هينتون وغيره من مروجي التعلم العميق محظوظون، فقد خلقوا العظمة وعززوا بشكل غير مباشر النجاح تلو الآخر في الصناعة.

سوف يحدد سوق رأس المال سعرًا عادلاً للنجاح، وسيسجل التاريخ الوحدة والعرق اللذين يخلقان العظمة.

المواد المرجعية

[1] 16000 جهاز كمبيوتر معًا يبحثون لـ Cat، نيويورك تايمز

[2] سعي Fei-Fei Li لجعل الذكاء الاصطناعي أفضل للإنسانية، Wired

[3] حديث TED الخاص بـ Li Feifei

[4] عرض جميع نماذج ImageNet في 21 ثانية، وتم تنفيذ أكثر من 60 نموذجًا معماريًا على نفس المسرح , قلب الآلة

[5] "الطريق إلى الآلهة" للشبكات العصبية التلافيفية: كل شيء يبدأ مع AlexNet، الحكمة الجديدة

[6] ثورة التعلم العميق، كيد ميتز

[7] للعثور على مهندسي الذكاء الاصطناعي، تقوم Google وFacebook بتعيين أساتذتهم، المعلومات

[8] ثلاثون عامًا من الابتكار في التعلم العميق، تشو لونغ

[ 9] ImageNet في السنوات الثماني الماضية: Li Feifei وعالم الذكاء الاصطناعي الذي غيرته، الكيوبتات

[10] التعلم العميق: التطبيقات السابقة والحالية، راميرو فارغاس

[11] مراجعة التعلم العميق: المفاهيم، بنيات CNN، التحديات، التطبيقات، الاتجاهات المستقبلية، ليث الزبيدي وآخرون

[12] مراجعة الأدبيات لمجالات أبحاث التعلم العميق، Mutlu Yapıcı، وما إلى ذلك.

[13] البطل الحقيقي وراء ChatGPT : قفزة الإيمان التي قام بها كبير العلماء في OpenAI إيليا سوتسكيفر، الحكمة الجديدة

[14] بعد مرور 10 سنوات، تحتدم "ثورة" التعلم العميق، كما يقول رواد الذكاء الاصطناعي هينتون ولوكون ولي، Venturebeat

[15] من عدم العمل إلى الشبكات العصبية، The Economist

[16] "النماذج الأساسية" الضخمة تحفز تقدم الذكاء الاصطناعي، مجلة الإيكونوميست

[17] 2012: عام اختراق للتعلم العميق، براين هاوس

p> p>[18] التعلم العميق: "العصا السحرية" للذكاء الاصطناعي، Essence Securities

[19] تطوير خوارزميات التعلم العميق: من التنوع إلى الوحدة، Guojin Securities

لم ينته سام بانكمان فريد، مؤسس بورصة العملات المشفرة المنهارة FTX، من سرد قصته بعد.

XingChi

XingChiهنية توفي في هجوم طهران. وغيرت بايدو صفحتها إلى الأبيض والأسود تخليدا لذكراه، مما أثار جدلا.

ZeZheng

ZeZhengيقدم Changpeng Zhao، مؤسس Binance، أكاديمية Giggle، وهي منصة تعليمية غير ربحية عبر الإنترنت، وسط تحديات قانونية. وعلى الرغم من الانتقادات، تهدف المبادرة إلى توفير تعليم مجاني وممتع على مستوى العالم. وتسعى رؤية تشاو إلى معالجة الفوارق التعليمية، والتأكيد على إمكانية الوصول والقدرة على التكيف.

Sanya

Sanyaتطلق Golden Finance العدد 2251 من التقرير الصباحي لصناعة العملات المشفرة و blockchain "Golden Morning 8:00" لتزويدك بأحدث وأسرع أخبار صناعة العملات الرقمية و blockchain.

JinseFinance

JinseFinanceتتوصل Robinhood إلى تسوية مع هيئة الأوراق المالية في ولاية ماساتشوستس، حيث توافق على غرامة قدرها 7.5 مليون دولار ومراجعة سياسات المشاركة الرقمية. ويتناول القرار مزاعم التلاعب بالتداول وتضليل المستثمرين عديمي الخبرة. وتتطلب التسوية إجراء تغييرات على الممارسات، بما في ذلك وقف بعض عناصر التلعيب، والتأكيد على حماية المستثمر والأمن السيبراني.

Xu Lin

Xu Linاستكشف رؤى لاري فينك، الرئيس التنفيذي لشركة BlackRock، حول Bitcoin وEthereum والإمكانات التحويلية لصناديق الاستثمار المتداولة والترميز في تشكيل مستقبل التمويل.

Miyuki

Miyukiيقول الرئيس التنفيذي لشركة BlackRock Larry Fink أن هناك اهتمامًا عالميًا متزايدًا بالعملات المشفرة و ...

dailyhodl

dailyhodlشبه فينك العملة المشفرة بـ "رقمنة الذهب" وحدد البيتكوين على أنه "أصل دولي" يمكن أن يكون بمثابة تحوط ضد التضخم.

cryptopotato

cryptopotato据OpenSea官方社交媒体账号披露,OpenSea现已推出个人资料页面收藏卡更新、收藏页最佳报价(在NFT集合页面上显示最高报价和其他顶级指标)、以及活动Mint价格(在活动源中显示 Polygon、Klaytn 和 以太坊铸币活动的价格)三项新功能。

链向资讯

链向资讯 Cointelegraph

Cointelegraph