سيبدأ إنستغرام قريبًا في اختبار تشويش الصور العارية في الرسائل المباشرة،وفقا لإعلان من ميتا يوم الاربعاء. وكتبت الشركة أنها ستستخدم "التعلم الآلي على الجهاز" للكشف عن العراة، وتهدف إلى وقف مخططات الابتزاز الجنسي التي تستهدف المراهقين.

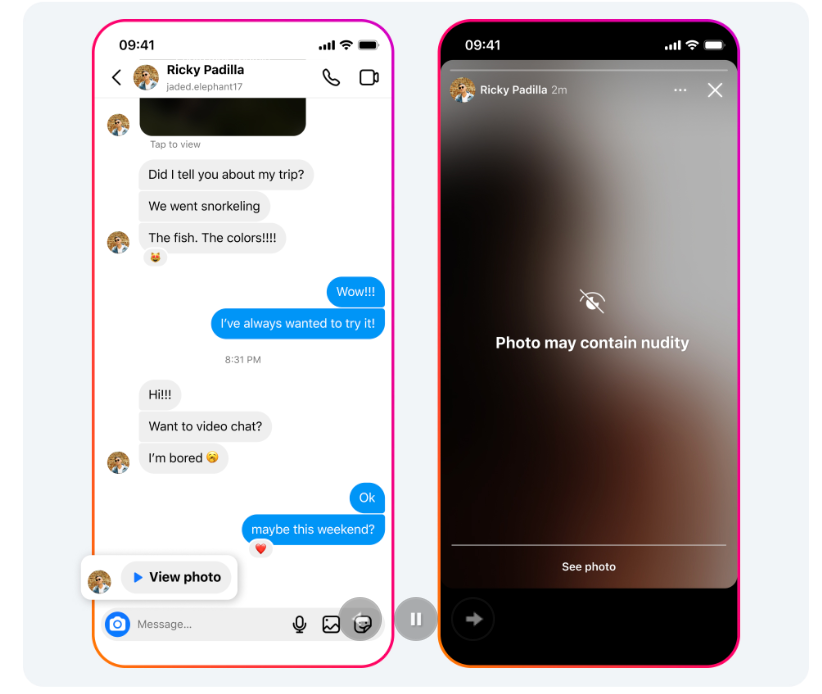

ستعمل ميزة "حماية العري" على اكتشاف العري في الرسائل المباشرة وطمسها تلقائيًا، سواء عندما تتلقى صورة عارية مرسلة إليك أو عندما تحاول إرسال واحدة إلى شخص آخر. سيرى المستخدمون أيضًا رسالة منبثقة تقول: "توخ الحذر عند مشاركة الصور الحساسة. الصورة غير واضحة بسبب تشغيل ميزة حماية العري. يمكن للآخرين لقطة شاشة لصورك أو إعادة توجيهها دون علمك. يمكنك إلغاء إرسال الصورة إذا غيرت رأيك، ولكن هناك احتمال أن يكون الآخرون قد شاهدوها بالفعل.

نظرًا لأن المعالجة تتم على الجهاز، تقول Meta إن اكتشافها سيظل يعملمحادثات مشفرة من طرف إلى طرف ، مع عدم قدرة Meta على الوصول إلى الصور نفسها ما لم يبلغ عنها المستخدم.

مثال على الشكل الذي ستبدو عليه الميزة للمستخدمين. الصورة عبر ميتا

وسيتم تشغيل الميزة افتراضيًا للمستخدمين الذين تقل أعمارهم عن 18 عامًا، وسيتلقى البالغون إشعارًا "يشجعهم" على تشغيلها. وجاء في الإعلان: "تم تصميم هذه الميزة ليس فقط لحماية الأشخاص من رؤية العري غير المرغوب فيه في رسائلهم المباشرة، ولكن أيضًا لحمايتهم من المحتالين الذين قد يرسلون صورًا عارية لخداع الأشخاص لإرسال صورهم الخاصة في المقابل".

وكتب ميتا: "عندما يتلقى شخص ما صورة تحتوي على عري، سيتم طمسها تلقائيًا تحت شاشة تحذير، مما يعني أن المستلم لن يواجه صورة عارية ويمكنه اختيار ما إذا كان يريد مشاهدتها أم لا". "سنظهر لهم أيضًا رسالة تشجعهم على عدم الشعور بالضغط للرد، مع خيار حظر المرسل والإبلاغ عن الدردشة".

وجاء في الإعلان أن Meta ستبدأ في اختبار هذه الميزات "قريبًا".

وفي الوقت نفسه، يتيح ميتاالمؤثرون المزيفون الذين أنشأهم الذكاء الاصطناعي إن سرقة صور النساء الحقيقية منتشرة على Instagram ولا يمكنها إيقاف حتى أكثرها وضوحًاالحيل الرومانسية سمك السلور يحدث على المنصة، وعلى فيسبوك، يحدث ذلك أيضًايتم خداعهم باستمرار من خلال المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي للاعتقاد بأنه حقيقي.

تشبه ميزة اكتشاف الصور العارية في Instagram تلك التي أعلنت عنها شركة Apple سابقًا. ويعمل "تحذير المحتوى الحساس" الخاص بالشركة أيضًا من خلال تحليل الصور الموجودة على جهاز المستخدم،وفقًا لوثائق Apple . واجهت شركة Apple رد فعل عنيفًا كبيرًا عندما أعلنت في الأصل عن ميزة من شأنها أن تذهب إلى أبعد من ذلك، وهي مسح الصور التي تم تحميلها على iCloud بحثًا عن CSAM. تفاحةقتل تلك الخطة في ديسمبر 2022 .

قامت شركة Meta بمحاولات مثيرة للجدل للكشف عن صور الاعتداء الجنسي في الماضي: في عام 2017 وحتى عام 2018، اختبرتنظام منع الصور غير التوافقية التي طلبت من المستخدمينإرسال العراة الخاصة بهم على الفيسبوك لمنعهم من الانتشار.

XingChi

XingChi