作者:屠敏,CSDN

今年的 5 月宛如梦回 2023 年的 3 月,一场场热闹的 AI 盛宴相继开席。

不过,不知是有意还是无意,去年 3 月,Google 选择开放大语言模型 PaLM API 之际,几乎在同一时间 OpenAI 释出最强模型 GPT-4 惊艳四座,此外仅时隔几天后,微软又在一场发布会上官宣自家 Office 全家桶被 GPT-4 革新,导致 Google 似乎成为被众人忽视的存在。

些许尴尬的是,今年同样的情形似乎正在上演,一方面 OpenAI 于昨日凌晨带来了全面升级的旗舰级 GPT4o 作为本月 AI 小春晚的开场,另一方面微软将于下周召开 Bulid 2024,那么,这一次再次遭到夹击的 Google 能否逆风翻了其两家“组的局”,我们将从今日凌晨开幕的 I/O 2024 开发者大会中窥见一斑。

今年的 I/O 大会也是 Google 旗帜鲜明地推行“AI First”战略的第八个年头。

01 亮点抢先看

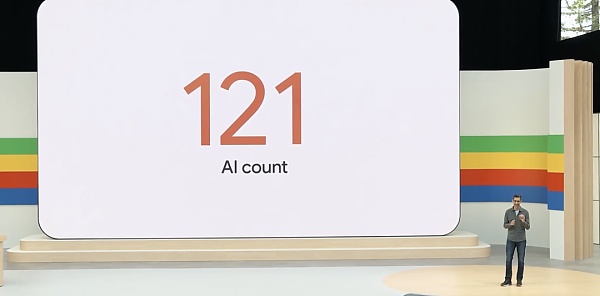

正如此前所料,在这场时长近 2 小时的 Keynote 上,「AI」是贯穿 I/O 大会全场的关键词,只是没想到的是,它被提及的次数能高达 121 次,也不难看出 Google 对 AI 的焦虑了。

面对外部来势汹汹的竞争对手,Google CEO Sundar Pichai(桑达尔·皮查伊)近日在做客一档节目时表示,「AI 目前还处于发展的早期阶段,相信谷歌最终将赢得这场战争,正如谷歌当初并不是第一家做搜索的公司」。

在 I/O 发布会现场,Sundar Pichai 同样强调了这一点,「我们仍处于人工智能平台转变的早期阶段。对于创作者、开发者、初创公司和每个人来说,我们看到了巨大的机遇。」

Sundar Pichai 表示,去年发布 Gemini(双子座)时,它的定位便是多模态的大模型,可以跨文本、图像、视频、代码等进行推理。今年 2 月,Google 发布了 Gemini 1.5 Pro,在长文本方面实现了突破,将上下文窗口长度扩展到 100 万个 tokens,比任何其他大规模基础模型都要多。如今,超过 150 万的开发者在 Google 工具中使用 Gemini 模型。

在发布会上,Sundar Pichi 分享了 Google 内部的最新的进展:

Gemini 应用程序现在已上线 Android 和 iOS 系统。通过 Gemini Advanced,用户可以访问 Google 最强大的模型。

Google 将向全球所有开发者推出 Gemini 1.5 Pro 的改进版本。此外,今天拥有 100 万个 token 上下文的 Gemini 1.5 Pro 现在可以直接在 Gemini Advanced 中供消费者使用,它可以跨 35 种语言使用。

Google 将 Gemini 1.5 Pro 上下文窗口扩展到了 200 万个 tokens,并以私人预览版的形式提供给开发人员。

虽然我们还处于 Agent 的早期阶段,但是 Google 已经开始先行探索,尝试了 Project Astra,通过智能手机摄像头分析世界,识别及解释代码、帮助人类寻找眼镜、还能辨别声音...

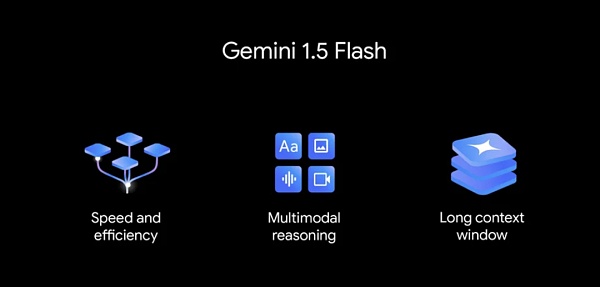

比 Gemini 1.5 Pro 更轻量级的 Gemini 1.5 Flash 发布,针对低延迟和成本等重要的任务进行了优化。

可制作“高质量” 1080p 视频的 Veo 模型和文本生成图像模型 Imagen 3 发布;

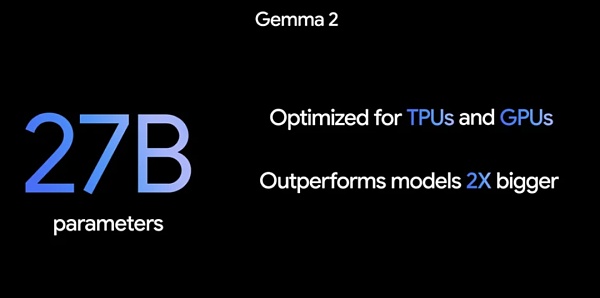

采用全新架构、27B 大小尺寸的 Gemma 2.0 来了;

Android,第一个包含内置设备基础模型的移动操作系统,深度集成了 Gemini 模型,成为以 Google AI 为核心的操作系统;

第六代 TPU Trillium 发布,与上一代 TPU v5e 相比,每个芯片的计算性能提高了 4.7 倍。

02 Google “杀疯了”,多款模型齐发

都说做大模型的很“卷”,没想到在加速赶超的路途中,Google 的“卷”远超乎想象。在发布会上,Google 不仅对过往的大模型进行了升级,还发布了多款新模型。

Gemini 1.5 Pro 升级更新

去年发布 Gemini(双子座)时,Google 对它的定位便是多模态的大模型,可以跨文本、图像、视频、代码等进行推理。今年 2 月,Google 发布了 Gemini 1.5 Pro,在长文本方面实现了突破,将上下文窗口长度扩展到 100 万个 tokens,比任何其他大规模基础模型都要多。

发布会上,Google 首先对 Gemini 1.5 Pro 一些关键用例进行了质量改进,例如翻译、编码、推理等,可以处理更广泛、更复杂的任务。1.5 Pro 现在可以遵循一些复杂和细致的指令,包括指定涉及角色、格式和风格的产品级行为的指令。也可以让用户能够通过设置系统指令来控制模型行为。

同时,Google 在 Gemini API 和 Google AI Studio 中添加了音频理解,因此 1.5 Pro 现在可以对 Google AI Studio 中上传的视频的图像和音频进行推理。

更值得注意的是,如果说 100 万 token 的上下文已经足够长了,就在今天,Google 进一步拓展它的能力,将上下文窗口扩展到 200 万个 token,并以私人预览版的形式提供给开发人员,这意味着其朝着无限上下文的最终目标迈出了下一步。

要访问具有 200 万 token 上下文窗口的 1.5 Pro,需要加入 Google AI Studio或适用于 Google Cloud 客户的 Vertex AI 中的候补名单。

更轻量级的新模型 Gemini 1.5 Flash

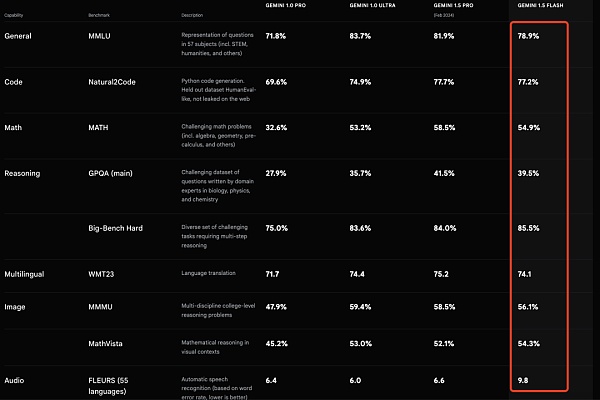

Gemini 1.5 Flash,这是一款专为扩展而打造的轻量级型号,也是 API 中速度最快的 Gemini 型号。它针对低延迟和成本最重要的任务进行了优化,服务成本效益更高,并具有突破性的长上下文窗口。

虽然它比 1.5 Pro 模型重量更轻,但能在海量信息中进行多模态推理。默认情况下,Flash 也是具有 100 万个 token 上下文窗口,这意味着你可以处理一小时的视频、11 小时的音频、超过 30,000 行代码的代码库或超过 700,000 个单词。

Gemini 1.5 Flash 擅长做摘要、聊天、图像和视频字幕、从长文档和表格中提取数据等。这是因为 1.5 Pro 通过一个名为“distillation”(蒸馏)的过程对其进行了训练,将较大模型中最重要的知识和技能转移到更小、更高效的模型中。

Gemini 1.5 Flash 的价格定为每 100 万个token 35 美分,这比 GPT-4o 的每 100 万个token 5 美元的价格要便宜一些。

Gemini 1.5 Pro 和 1.5 Flash 均已推出公共预览版,并在 Google AI Studio 和 Vertex AI 中提供。

Google 第一个视觉语言开放模型 PaliGemma 现已推出

PaliGemma 是一个功能强大的开放式 VLM(视觉语言模型),灵感来自 PaLI-3。PaliGemma 基于 SigLIP 视觉模型和 Gemma 语言模型等开放组件构建,旨在在各种视觉语言任务上实现一流的微调性能。这包括图像和短视频字幕、视觉问答、理解图像中的文本、对象检测和对象分割。

Google 表示,为了促进开放探索和研究,PaliGemma 可通过各种平台和资源获得,你可以在 GitHub、Hugging Face 模型、Kaggle、Vertex AI Model Garden 和 ai.nvidia.com(使用 TensoRT-LLM 加速)上找到 PaliGemma,并通过 JAX 和 Hugging Face Transformers 轻松集成。

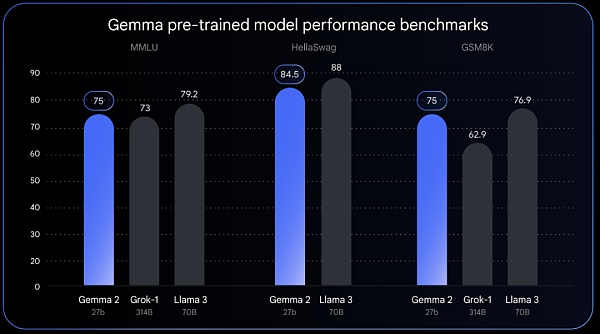

Gemma 2 发布

全部发布 Gemma 2 将提供新尺寸,并采用专为突破性性能和效率而设计的全新架构。Gemma 2 具有 270 亿个参数,其性能可与 Llama 3 70B 相媲美,但尺寸却只有 Llama 3 70B 的一半。

据 Google 透露,Gemma 2 的高效设计使其所需的计算量少于同类模型的一半。27B 模型经过优化,可以在 NVIDIA 的 GPU 上运行,也可以在 Vertex AI 中的单个 TPU 主机上高效运行,从而使更广泛的用户更易于部署且更具成本效益。

Gemma 2 将于 6 月推出。

Veo:最新、最先进的视频生成模型

可以视为对标 OpenAI 的 Sora,Google 在今天推出了视频生成模型 Veo,它可以生成各种电影和视觉风格的高质量 1080p 分辨率视频,时间可以超过一分钟。

Veo 以 Google 多年的生成视频模型工作为基础,包括生成查询网络(GQN)、DVD-GAN、Imagen-Video、Phenaki、WALT、VideoPoet 和 Lumiere,结合架构、缩放法则和其他技术来提高质量和输出分辨率。

从今天开始,用户可以加入候补名单,申请使用 Veo。

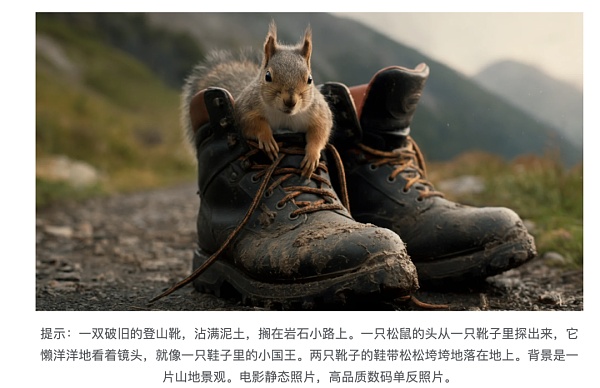

Imagen 3:高质量的文本到图像模型

与 Google 之前的模型相比,最新发布的 Imagen 3 分散注意力的视觉伪影要少得多,它可以更好地理解自然语言、提示背后的意图,并融合较长提示中的小细节。

从今天开始,Imagen 3 可供选择的创作者在 ImageFX 中进行私人预览,并加入候补名单。Imagen 3 即将推出 Vertex AI。

未来畅想:通用 AI 代理 Project Astra

所谓 Agent,是指具有推理、计划和记忆能力的智能系统,它们能够提前“思考”多个步骤,并跨软件和系统工作。

在今天发布会上,Google DeepMind CEO、联合创始人 Demis Harbis 透露,Google 内部一直在致力于开发对日常生活有帮助的通用 AI Agent,Project Astra(高级视觉和说话响应代理)便是主要的尝试之一。

这个项目是在 Gemini 的基础上,Google 开发了原型代理,可以通过连续编码视频帧、将视频和语音输入组合到事件时间线中并缓存此信息以进行有效调用,从而更快地处理信息。

通过利用语音模型,Google 还增强了它们的发音,为代理提供了更广泛的语调。这些代理可以更好地理解他们所使用的上下文,并在对话中快速做出响应。

在发布会上演示的示例中,通过 Project Astra,可以自动识别出现实场景中发出声响的东西、甚至可以直接定位到发出声音的具体部件、也能解释电脑屏幕上出现代码的作用、还可以帮助人类找到眼镜等等。

”有了这样的技术,我们很容易想象未来人们可以通过手机或眼镜设备拥有专业的人工智能助手。其中一些功能将于今年晚些时候出现在 Google 产品中“,Google 表示。

03 Gemini Advanced 升级,可定制 Gemini

现如今,改进之后的 Gemini 1.5 Pro 引入了 Gemini Advanced 订阅中,面向全球所有开发者推出 Gemini 1.5 Pro 的改进版本,它可以跨 35 种语言使用。

如上文所述默认情况下,Gemini 1.5 Pro 拥有 100 万 token 上下文,这么长的上下文窗口意味着 Gemini Advanced 这可以理解多个大型文档,预计总共最多 1,500 页,或总结 100 封电子邮件,处理一小时的视频内容或超过 30,000 行的代码库。

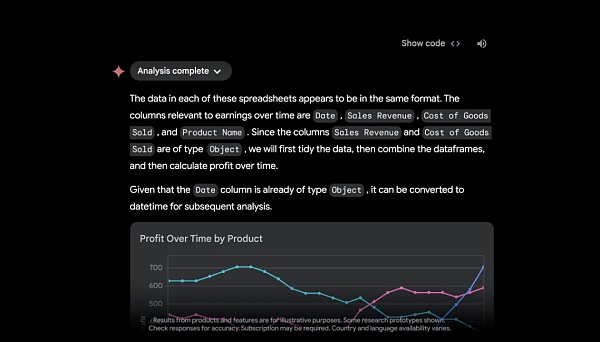

借助 Google Drive 或直接从设备上传文件的功能,Google 透露,很快,Gemini Advanced 将充当数据分析师,从上传的数据文件(如电子表格)中发现见解并动态构建自定义可视化和图表。

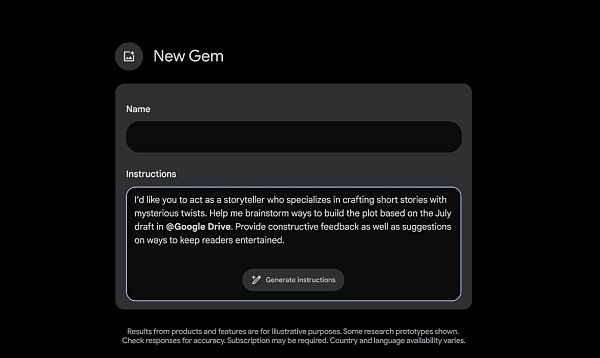

为了获得更加个性化的体验,Gemini Advanced 订阅者很快就能创建 Gems——Gemini 的定制版本。你可以创建任何你想要创建的 Gem,如健身伙伴、副主厨、编码伙伴或创意写作指南。只需描述你希望 Gem 做什么以及你希望它如何响应,例如“你是我的跑步教练,给我一个每日跑步计划,并保持积极、乐观和激励。” Gemini 将接受这些说明,只需单击一下即可增强它们,以创建满足特定需求的 Gem。

04 用 AI 改写 Google 搜索

没有商业场景的落地应用,大模型技术的迭代似乎只是“纸上谈兵”。和 OpenAI 走的路线有所不同,Google、微软都在 AI 应用赛道上比拼速度。对于搜索起家的 Google 而言,其势必不会错过 AI 这波浪潮。

Google 副总裁、搜索主管 Liz Reid 表示,“借助生成式人工智能,搜索可以做的事情超出你的想象。因此,你可以提出任何你想到的事情或任何你需要完成的事情——从研究到计划再到集思广益——Google 将负责所有的跑腿工作。”

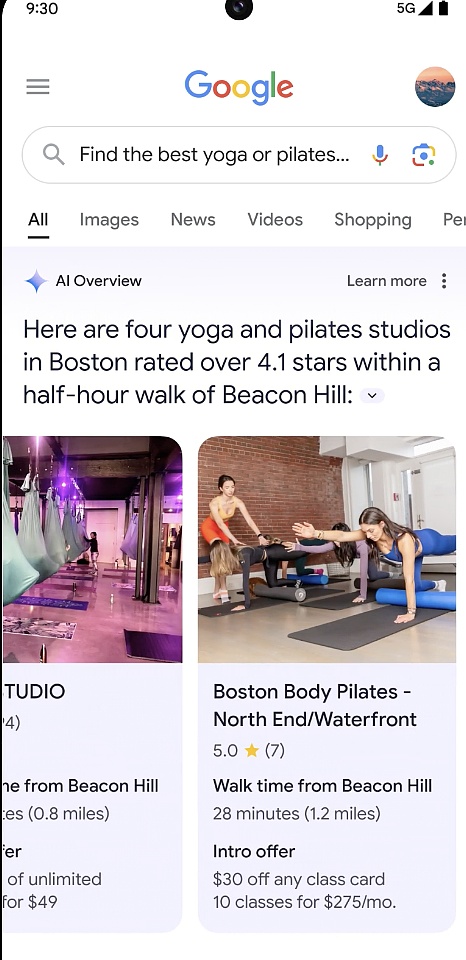

AI Overviews:「一次搜索,获得所有信息」

在发布会上,Google 发布了一个名为“AI 概述”(AI Overviews)的功能,做到「一次搜索,获得所有信息」。

简单来看,有时你想要快速得到答案,但没有时间将所需的所有信息拼凑在一起,如“你正在寻找一家新的瑜伽或普拉提工作室,并且想要一家受当地人欢迎、交通便利且还为新会员提供折扣的工作室”,你只需说清楚自己的需求进行一次搜索,AI Overviews 会给出解决复杂问题的答案。

拍摄视频,获得 AI 帮助

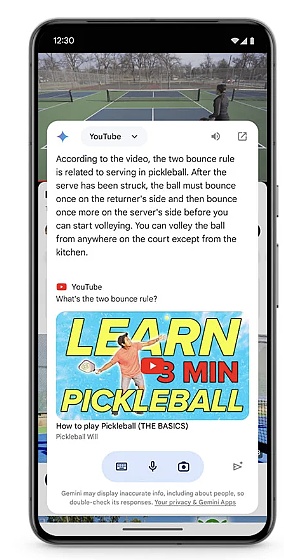

由于视频理解的进步,Google 也对视觉搜索功能进行了增强。可以通过 Google Lens 视频搜索,对你遇到的问题或周围看到的事物(包括运动的物体)进行拍摄,从而进行搜索得到解答,节省用文字描述不清楚造成的时间浪费和麻烦。

不过,以上两项功能目前仅对美国地区推出,后续会向更多国家推出。

除了在搜索层面,大模型的到来,也将进一步提升产品的智能性。

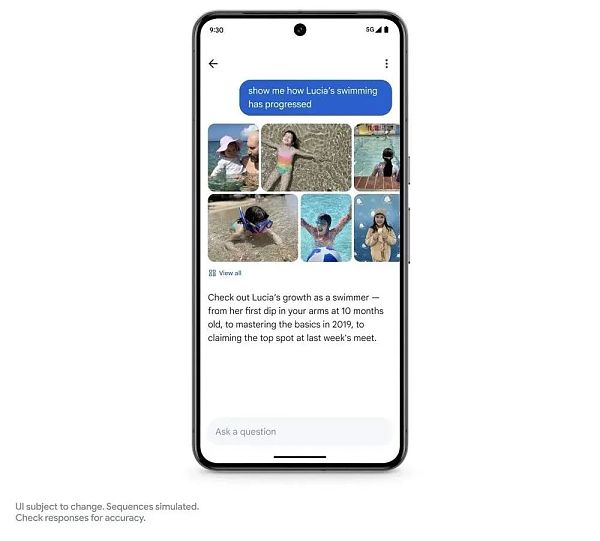

Ask Photos

在照片搜索应用层面上,Google 带来了一个“询问照片”(Ask Photos)功能。

可以借助 Gemini,识别照片不同背景信息,如询问:自己的女儿什么时候学会游泳的?游泳进展如何?照片将所有内容汇总在一起,帮助用户快速收集信息并解惑。

这一项功能目前还没有上线,Google 称今年夏季将推出。

Gemini 1.5 Pro 引入到 Google Workspace

Google 还将大模型集成到 Google Workspace,譬如,在 Gmail 中搜索电子邮件,通过与学校最近往来的邮件,随时了解孩子学校发生的一切情况。我们可以要求 Gemini 总结一下学校最近发来的所有电子邮件。它在后台识别相关电子邮件,甚至分析 PDF 等附件。

新增 NotebookLM 中的音频输出

NotebookLM 是 Google 在去年 7 月推出的一款AI 笔记应用 ,可围绕用户上传文档完成摘要、创建想法。

基于多模态大模型技术,Google 在该应用上新增了音频输出功能。它使用 Gemini 1.5 Pro 获取用户的源材料并生成个性化的交互式音频对话。

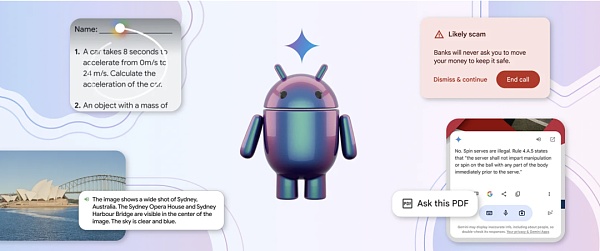

05 深度集成 Gemini 的 Android

用 AI 对操作系统进行升级,是微软和 Google 正在大力推进的事情。作为全球第一大移动操作系统,Android 拥有数十亿用户。Google 对此表示,已将 Gemini 模型整合到 Android 中,并引入了很多实用的 AI 功能。

如通过“Circle to Search”(划圈搜索),可以使用户无需切换应用程序,使用画圈、涂鸦、点击等简单的交互方式获取更多信息,如今,Circle to Search 可以帮助学生完成作业,当学生圈出他们遇到的提示时,他们将获得解决一系列物理和数学问题的分步说明从而获得更深入的理解,而不仅仅是答案。

另外,Google 将很快在 Android 系统上更新 Gemini,方便用户在应用程序顶部调出 Gemini 的叠加层,以便以更多方式轻松使用 Gemini。

「Android 是第一个包含内置设备基础模型的移动操作系统」,借助 Gemini Nano,Android 用户可以快速体验 AI 功能。Google 透露,从今年晚些时候的 Pixel 开始,其将推出最新型号 Gemini Nano 与多模态。这意味着新版 Pixel 手机不仅能够处理文本输入,还能够理解更多上下文信息,例如视觉、声音和口语。

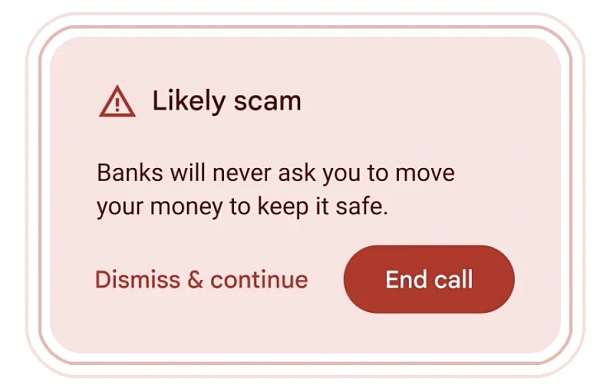

此外,Google 在 Android 中借助 Gemini Nano 在通话过程中检测到通常与诈骗相关的对话时,提供实时警报,例如,如果有声称”银行“的人要求你紧急转账、使用礼品卡付款或要求提供卡 PIN 码或密码等个人信息(这些都是不常见的银行要求),你就会收到提醒,不过这项功能还在测试中。

06 第六代 TPU Trillium

Sundar Pichai 表示,训练最先进的模型需要大量的计算能力。过去六年中,行业对 ML 计算的需求增长了 100 万倍。并且每年都会增加十倍。

为了适应 ML 计算的增长需求,其推出了第六代 TPU—— Trillium,与上一代 TPU v5e 相比,每个 Trillium 芯片的计算性能提高了 4.7 倍。为了达到这种性能水平,Google 扩大了矩阵乘法单元 (MXU)的大小并提高了时钟速度。

此外,Trillium 还配备了第三代 SparseCore,这是一种专用加速器,用于处理高级排名和推荐工作负载中常见的超大嵌入。Trillium TPU 可以更快地训练下一波基础模型,并以更少的延迟和更低的成本为这些模型提供服务。

Trillium TPU 的能效比 TPU v5e 高出 67% 以上。

据悉,Google 将于 2024 年底向其云客户提供 Trillium。

07 安全措施

除了以上模型与产品更新外,Google 在安全方面也有了最新动作,旨在放在 AI 滥用等情况。

一方面,Google 推出了一个基于 Gemini 的新模型系列,并针对学习进行了微调,发布了 LearnLM。其将研究支持的学习科学和学术原则集成到 Google 的产品中,帮助管理认知负荷并适应学习者的目标、需求和动机。

另一方面,为了让知识更容易获取和消化,Google 构建了一种新的实验工具 Illuminate,它利用 Gemini 1.5 Pro 的长上下文功能将复杂的研究论文转换为简短的音频对话。Illuminate 可以在几分钟内生成由两个人工智能生成的声音组成的对话,提供对研究论文中关键见解的概述和简短讨论。

最后,Google 采用了 “人工智能辅助红队”的技术来主动测试自己的系统是否存在弱点并试图打破它们,并通过将水印工具 SynthID 扩展为两种新模式:文本和视频,使 AI 生成的内容更易于识别。

08 你如何看待 Google I/O 这场发布会?

以上便是 Google I/O 2024 Keynote 的主要内容,产品非常丰富,不过多数都需要等待。

随着这一场发布会的结束,不少专家也发表了一些看法。来自 NVIDIA 高级研究经理 Jim Fan 表示:

Google I/O。一些想法:该模型似乎是多模式输入,但不是多模式输出。Imagen-3 和 music gen 模型仍作为独立组件与双子座分离。将所有模态输入/输出原生合并是不可避免的未来趋势:

使“使用更像机器人的声音”、“说话速度提高 2 倍”、“迭代编辑此图像”和“生成一致的连环画”等任务成为可能。

不会丢失跨模态边界的信息,如情感和背景声音。

提供新的语境功能。你可以通过少量的示例,教模型以新颖的方式将不同的感官结合起来。

GPT-4o 做得并不完美,但它的形式因素是正确的。用 Andrej 的 LLM-as-OS 比喻:我们需要模型原生支持尽可能多的文件扩展名。

谷歌正在做的一件事是正确的:他们终于在认真努力地将人工智能整合到搜索框中。我感觉到了 Agent 流:规划、实时浏览和多模态输入,所有这些都来自登录页面。谷歌最强大的护城河是分销。Gemini 不一定要成为最好的模型,也可以成为世界上最常用的模型。

AI 著名学者吴恩达表示,“祝贺我所有的 Google 朋友在 I/O 上发布了很酷的公告!我个人期待 Gemini 拥有 200 万个 token 输入上下文窗口以及对设备上 AI 的更好支持——应该会为应用程序构建者带来新的机会!”

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Catherine

Catherine Beincrypto

Beincrypto cryptopotato

cryptopotato Bitcoinist

Bitcoinist Others

Others Cointelegraph

Cointelegraph Cointelegraph

Cointelegraph