Nguyên tắc đầu tiên của Blockchain: Lấy Sui và Arweave AO làm ví dụ

Nguyên tắc đầu tiên của blockchain là phương pháp kế toán phi tập trung, không cần thiết phải có "khối" và "chuỗi".

JinseFinance

JinseFinance

Tác giả: Kyle_13, Nguồn: Tác giả Twitter @kylewmi

Cảm ơn tất cả các bạn đã đến hôm nay. Chúng tôi có nhiều phát triển cực kỳ thú vị trong công nghệ AO muốn chia sẻ với bạn. Trước tiên, chúng tôi sẽ làm bản demo, sau đó Nick và tôi sẽ cố gắng xây dựng một đại lý AI ở đây sẽ sử dụng các mô hình ngôn ngữ lớn trong hợp đồng thông minh để mua và bán dựa trên tâm lý trò chuyện trong hệ thống mà bạn sắp nghe. Hôm nay chúng tôi sẽ xây dựng nó từ đầu trên trang web và hy vọng nó sẽ diễn ra tốt đẹp.

Có, bạn sẽ thấy cách tự mình làm tất cả.

Những tiến bộ công nghệ ở đây thực sự đã đưa AO vượt xa các hệ thống hợp đồng thông minh khác. Điều này đã từng đúng trước đây và giờ đây nó đang trở nên giống một siêu máy tính phi tập trung hơn là một mạng hợp đồng thông minh truyền thống. Nhưng nó có tất cả các tính năng của mạng hợp đồng thông minh. Vì vậy, chúng tôi rất vui mừng được chia sẻ điều này với tất cả các bạn. Không dài dòng nữa, hãy bắt đầu với bản demo, sau đó chúng ta sẽ thảo luận và cùng nhau xây dựng một thứ gì đó trực tiếp.

Xin chào mọi người, cảm ơn các bạn đã đến hôm nay. Chúng tôi rất vui mừng được thông báo ba bản cập nhật kỹ thuật quan trọng cho giao thức AO. Họ cùng nhau đạt được mục tiêu lớn là hỗ trợ các mô hình ngôn ngữ lớn chạy trong môi trường phi tập trung như một phần của hợp đồng thông minh. Đây không chỉ là những mô hình đồ chơi, mô hình nhỏ hay mô hình được biên dịch thành các tệp nhị phân của riêng chúng.

Đây là một hệ thống hoàn chỉnh cho phép bạn chạy hầu hết các mô hình chính hiện có nguồn mở và có sẵn. Ví dụ: Llama 3 chạy trong các hợp đồng thông minh trên chuỗi, GPT cũng vậy, và mô hình của Apple, v.v. Đây là nỗ lực hợp tác trên toàn bộ hệ sinh thái, với ba tiến bộ công nghệ chính tạo thành một phần của hệ thống này. Vì vậy, tôi rất vui mừng được kể cho bạn nghe tất cả về nó.

Tình hình chung là , Giờ đây LLM (Mô hình ngôn ngữ lớn) có thể được chạy trong hợp đồng thông minh. Bạn có thể đã nghe nói về AI phi tập trung và tiền điện tử AI nhiều lần. Trên thực tế, ngoại trừ một hệ thống mà chúng ta sẽ thảo luận hôm nay, hầu hết tất cả các hệ thống này đều là AI như những lời tiên tri, tức là chạy AI ngoài chuỗi và sau đó đưa kết quả thực thi lên chuỗi cho một số mục đích tiếp theo.

Đó không phải là điều chúng ta đang nói đến. Chúng ta đang nói về suy luận mô hình ngôn ngữ lớn như một phần của việc thực thi trạng thái hợp đồng thông minh. Tất cả điều này có thể thực hiện được nhờ ổ cứng AO mà chúng tôi có và cơ chế xử lý siêu song song của AO, nghĩa là bạn có thể chạy nhiều phép tính mà không ảnh hưởng đến các quy trình khác nhau mà tôi đang làm việc. Chúng tôi tin rằng điều này sẽ cho phép chúng tôi tạo ra một hệ thống tài chính đại lý tự trị phi tập trung rất phong phú.

Cho đến nay, Trong tài chính phi tập trung (DeFi), về cơ bản chúng tôi đã có thể thực hiện các giao dịch thô mà không cần tin cậy. Tương tác trong các trò chơi kinh tế khác nhau, chẳng hạn như cho vay và trao đổi, là không đáng tin cậy. Đây chỉ là một khía cạnh của vấn đề. Nếu bạn nghĩ về thị trường tài chính toàn cầu.

Đúng vậy, có rất nhiều cơ chế kinh tế nguyên thủy hoạt động theo những cách khác nhau. Có trái phiếu, cổ phiếu, hàng hóa, công cụ phái sinh và hơn thế nữa. Nhưng khi chúng ta thực sự nói về thị trường, không chỉ có những thị trường này, mà còn là lớp trí tuệ. Người quyết định mua, bán, vay hoặc tham gia vào các trò chơi tài chính khác nhau.

Cho đến nay trong hệ sinh thái tài chính phi tập trung, chúng tôi đã chuyển thành công tất cả những bản gốc này sang trạng thái không cần sự tin cậy. Do đó, bạn có thể trao đổi trên Uniswap mà không cần tin tưởng vào các nhà điều hành Uniswap. Trên thực tế, về cơ bản, không có người vận hành. Lớp thông minh của thị trường bị loại bỏ khỏi chuỗi. Vì vậy, nếu bạn muốn tham gia đầu tư tiền điện tử mà không tự mình thực hiện tất cả các nghiên cứu và tham gia, bạn phải tìm một quỹ.

Bạn có thể tin tưởng giao số tiền của mình cho họ, sau đó họ sẽ thực hiện các quyết định thông minh và chuyển chúng xuống hoạt động thực thi cơ bản của chính mạng. Chúng tôi tin rằng trong AO, chúng tôi thực sự có khả năng chuyển phần thông minh của thị trường, phần thông tin dẫn đến các quyết định, tới chính mạng lưới. Vì vậy, một cách đơn giản để hiểu có thể là tưởng tượng điều này.

Một quỹ phòng hộ hoặc ứng dụng quản lý danh mục đầu tư mà bạn có thể tin tưởng để thực hiện một bộ hướng dẫn thông minh trong mạng, từ đó chuyển tính chất không đáng tin cậy của mạng vào quá trình ra quyết định. Điều này có nghĩa là một tài khoản ẩn danh, chẳng hạn như Yolo 420 Trader Number One (một nhà giao dịch bình thường, táo bạo), có thể tạo một chiến lược mới và thú vị cũng như triển khai nó trên mạng và bạn có thể đầu tư vốn vào chiến lược đó mà không thực sự tin tưởng vào nó.

Bây giờ bạn có thể xây dựng các tác nhân tự trị tương tác với các mô hình thống kê lớn. Và các mô hình thống kê lớn phổ biến nhất là các mô hình ngôn ngữ lớn, có thể xử lý và tạo ra văn bản. Điều này có nghĩa là bạn có thể đưa các mô hình này vào hợp đồng thông minh như một phần của chiến lược được phát triển bởi một người có ý tưởng mới và yêu cầu chúng được thực thi một cách thông minh trên mạng.

Bạn có thể tưởng tượng việc làm Một số phân tích tình cảm cơ bản. Ví dụ: bạn đọc tin tức và quyết định rằng đây là thời điểm tốt để mua hoặc bán công cụ phái sinh này. Đây là thời điểm tốt để làm điều này hoặc điều kia. Bạn có thể yêu cầu các quyết định giống con người được thực hiện một cách không đáng tin cậy. Đây không chỉ là lý thuyết. Chúng tôi đã tạo ra một loại meme vui nhộn có tên là Llama Fed. Về cơ bản, ý tưởng là nó là một trình mô phỏng tiền pháp định trong đó một nhóm lạc đà không bướu (alpacas) được đại diện bởi mô hình Llama 3.

Họ giống như sự kết hợp giữa llama và chủ tịch Cục Dự trữ Liên bang, bạn có thể đến gặp họ, yêu cầu họ phát hành một số token và họ sẽ đánh giá yêu cầu của bạn. Bản thân mô hình ngôn ngữ lớn vận hành chính sách tiền tệ, hoàn toàn tự chủ và không có sự tin tưởng. Chúng tôi đã xây dựng nó, nhưng chúng tôi không kiểm soát được nó. Họ vận hành chính sách tiền tệ và quyết định ai sẽ nhận được token và ai không. Đây là một ứng dụng nhỏ rất thú vị của công nghệ này, hy vọng sẽ truyền cảm hứng cho tất cả các ứng dụng có thể có khác trong hệ sinh thái.

Để đạt được Để làm được điều này, chúng ta phải tạo ba khả năng cơ bản mới cho AO, một số khả năng đó nằm ở lớp giao thức cơ bản và một số khả năng khác nằm ở lớp ứng dụng. Điều này không chỉ hữu ích cho việc thực thi các mô hình ngôn ngữ lớn mà còn rộng hơn và thú vị hơn cho các nhà phát triển AO. Vì vậy, tôi rất vui mừng được giới thiệu những điều này với bạn ngày hôm nay.

Công nghệ mới đầu tiên là hỗ trợ Web Assembly 64-bit. Nghe có vẻ hơi giống một thuật ngữ kỹ thuật nhưng tôi có cách làm cho mọi người hiểu ý nghĩa của nó. Về cơ bản, hỗ trợ Web Assembly 64 cho phép các nhà phát triển tạo ra các ứng dụng sử dụng nhiều hơn 4GB bộ nhớ. Chúng tôi sẽ giới thiệu các hạn chế mới sau và chúng khá tuyệt vời.

Nếu bạn không phải là nhà phát triển, bạn có thể hiểu nó theo cách này: ai đó Bạn được yêu cầu viết một cuốn sách và bạn rất hào hứng với ý tưởng này, nhưng họ nói rằng bạn chỉ có thể viết được 100 trang. không nhiều không ít. Bạn có thể diễn đạt những ý tưởng trong cuốn sách, nhưng không phải theo cách tự nhiên và bình thường vì có những ràng buộc bên ngoài và bạn phải phục vụ nó và thay đổi cách viết cho phù hợp.

Nếu bạn không phải là nhà phát triển, bạn có thể hiểu nó theo cách này: ai đó Bạn được yêu cầu viết một cuốn sách và bạn rất hào hứng với ý tưởng này, nhưng họ nói rằng bạn chỉ có thể viết được 100 trang. không nhiều không ít. Bạn có thể diễn đạt những ý tưởng trong cuốn sách, nhưng không phải theo cách tự nhiên và bình thường vì có những ràng buộc bên ngoài và bạn phải phục vụ nó và thay đổi cách viết cho phù hợp.

Trong hệ sinh thái hợp đồng thông minh, đây không chỉ là giới hạn 100 trang. Tôi có thể nói nó giống như xây dựng phiên bản AO trước đó. Ethereum có giới hạn bộ nhớ là 48KB, giống như việc ai đó yêu cầu bạn viết một cuốn sách chỉ dài một câu và bạn chỉ được sử dụng 200 từ tiếng Anh phổ biến nhất. Xây dựng các ứng dụng thực sự thú vị trong hệ thống này là vô cùng khó khăn.

Vậy thì Solana, bạn có quyền truy cập vào 10 MB bộ nhớ làm việc. Đây rõ ràng là một sự cải tiến, nhưng về cơ bản chúng ta đang nói về một trang. ICP, Internet Computer Protocol, cho phép hỗ trợ bộ nhớ 3GB. Về mặt lý thuyết thì nó đã đầy, nhưng họ phải giảm xuống còn 3GB. Giờ đây với 3GB RAM, bạn có thể chạy được rất nhiều ứng dụng khác nhau nhưng chắc chắn bạn không thể chạy được những ứng dụng AI lớn. Chúng yêu cầu tải lượng lớn dữ liệu vào bộ nhớ chính để truy cập nhanh. Điều này không thể đạt được một cách hiệu quả với 3GB RAM.

Khi chúng tôi phát hành AO vào tháng 2 năm nay, chúng tôi cũng có giới hạn bộ nhớ 4GB, thực ra điều này bắt nguồn từ Web Assembly 32. Bây giờ, giới hạn bộ nhớ này hoàn toàn biến mất ở cấp độ giao thức. Ngược lại, giới hạn bộ nhớ ở cấp giao thức là 18EB (exabyte). Đó là một lượng lưu trữ khổng lồ.

Sẽ còn khá lâu nữa nó mới được sử dụng để tính toán trong bộ nhớ thay vì phương tiện lưu trữ dài hạn. Ở cấp độ triển khai, các đơn vị tính toán trong mạng AO hiện có thể truy cập bộ nhớ 16GB, nhưng sẽ tương đối dễ dàng để thay thế bộ nhớ này bằng bộ nhớ lớn hơn trong tương lai mà không cần thay đổi giao thức. 16GB là quá đủ để chạy các tính toán mô hình ngôn ngữ lớn, nghĩa là bạn có thể tải xuống và thực thi mô hình 16GB trên AO ngay hôm nay. Chẳng hạn như phiên bản không số hóa Llama 3 của Falcon 3 và nhiều mẫu khác.

Đây là thành phần cốt lõi cần thiết để xây dựng một hệ thống máy tính thông minh dựa trên ngôn ngữ. Giờ đây, nó được hỗ trợ đầy đủ trên chuỗi như một phần của hợp đồng thông minh, điều mà chúng tôi nghĩ là rất, rất thú vị.

Điều này loại bỏ giới hạn tính toán lớn của AO và các hệ thống hợp đồng thông minh tiếp theo. Khi chúng tôi phát hành AO vào tháng 2 năm nay, bạn có thể nhận thấy trong video mà chúng tôi đã đề cập nhiều lần rằng bạn có sức mạnh tính toán không giới hạn nhưng có giới hạn không quá 4GB RAM. Đây là việc dỡ bỏ hạn chế đó. Chúng tôi cho rằng đây là một tiến bộ rất thú vị và 16GB là đủ để chạy hầu hết mọi kiểu máy bạn muốn chạy trong lĩnh vực AI hiện tại.

Chúng tôi có thể tăng giới hạn 16 GB mà không cần thay đổi giao thức, điều này sẽ tương đối dễ dàng trong tương lai, đây là một cải tiến lớn so với việc chạy Web Assembly 64 ban đầu. Vì vậy, bản thân điều đó đã là một bước tiến lớn về khả năng của hệ thống. Công nghệ chính thứ hai cho phép các mô hình ngôn ngữ lớn chạy trên AO là WeaveDrive.

WeaveDrive cho phép bạn Truy cập dữ liệu Arweave trong AO giống như ổ cứng cục bộ. Điều này có nghĩa là bạn có thể mở bất kỳ ID giao dịch nào trong AO được đơn vị điều phối xác thực và tải nó lên mạng. Tất nhiên, bạn có thể truy cập dữ liệu này và đọc nó vào chương trình của mình giống như một tệp trên ổ cứng cục bộ.

Tất cả chúng ta đều biết, Hiện có khoảng 6 tỷ giao dịch được lưu trữ trên Arweave, vì vậy đây là một tập dữ liệu khổng lồ để bắt đầu. Điều này cũng có nghĩa là khi xây dựng các ứng dụng trong tương lai, việc tải dữ liệu lên Arweave sẽ ngày càng được khuyến khích nhiều hơn, vì dữ liệu này cũng có thể được sử dụng trong các chương trình AO. Ví dụ: khi chúng tôi tạo một mô hình ngôn ngữ lớn chạy trên Arweave, chúng tôi đã tải các mô hình trị giá khoảng 1.000 đô la lên mạng. Nhưng điều này chỉ là khởi đầu.

Với mạng lưới hợp đồng thông minh trên hệ thống tệp cục bộ, số lượng ứng dụng bạn có thể xây dựng là rất lớn. Vì vậy, điều đó rất thú vị. Điều tuyệt vời hơn nữa là hệ thống chúng tôi xây dựng cho phép bạn truyền dữ liệu vào môi trường thực thi. Đây là một sắc thái kỹ thuật, nhưng bạn có thể tưởng tượng khi quay lại ví dụ tương tự về cuốn sách.

Ai đó đã nói với bạn, tôi muốn truy cập một phần dữ liệu trong sách của bạn. Tôi muốn lấy một sơ đồ từ cuốn sách này. Trong một hệ thống đơn giản hoặc thậm chí trong các mạng hợp đồng thông minh ngày nay, đây sẽ là một cải tiến lớn và bạn nên thử toàn bộ cuốn sách. Tuy nhiên, điều này rõ ràng là không hiệu quả lắm, đặc biệt nếu cuốn sách đó là một mô hình thống kê lớn chứa hàng nghìn trang.

Điều này cực kỳ kém hiệu quả. Thay vào đó, những gì chúng tôi làm trong AO là cho phép bạn đọc byte trực tiếp. Bạn vào thẳng vị trí biểu đồ trong sách, chỉ cần sao chép biểu đồ vào ứng dụng của mình và thực hiện. Điều này cải thiện đáng kể hiệu quả của hệ thống. Đây không chỉ là một sản phẩm khả thi tối thiểu (MVP), nó còn là một cơ chế truy cập dữ liệu được xây dựng tốt, đầy đủ chức năng. Vì vậy, bạn có một hệ thống máy tính vô hạn và một ổ cứng vô hạn, kết hợp chúng lại với nhau và bạn có một siêu máy tính.

Điều này chưa từng được xây dựng trước đây và hiện tại nó có sẵn cho tất cả mọi người với chi phí tối thiểu. Đây là vị trí hiện tại của AO và chúng tôi rất vui mừng về điều đó. Hệ thống này cũng được triển khai ở cấp hệ điều hành. Do đó, chúng tôi đã biến WeaveDrive thành một giao thức con của AO, một tiện ích mở rộng đơn vị điện toán mà bất kỳ ai cũng có thể tải. Điều này thật thú vị vì đây là bản mở rộng đầu tiên thuộc loại này.

AO luôn có khả năng thêm tiện ích mở rộng vào môi trường thực thi của bạn. Giống như bạn có một chiếc máy tính và bạn muốn cắm thêm bộ nhớ hoặc cắm card đồ họa, bạn đặt một thiết bị vào hệ thống. Bạn có thể làm điều này với các đơn vị tính toán của AO và đó là những gì chúng tôi đang làm ở đây. Vì vậy, ở cấp độ hệ điều hành, bây giờ bạn có một ổ cứng, đây chỉ là một hệ thống tệp đại diện cho việc lưu trữ dữ liệu.

Điều này có nghĩa là bạn không chỉ có thể truy cập dữ liệu này trong AO, xây dựng ứng dụng theo cách thông thường mà còn có thể thực sự truy cập dữ liệu đó từ bất kỳ ứng dụng nào được đưa lên web. Vì vậy, đây là một khả năng có thể áp dụng rộng rãi mà mọi người đang xây dựng trong hệ thống đều có thể truy cập được, bất kể họ đang viết bằng ngôn ngữ nào, Rust, C, Lure, Solidity, v.v., như thể đó là một tính năng gốc của hệ thống. Khi xây dựng hệ thống này, nó cũng buộc chúng tôi phải tạo ra các giao thức con, tạo ra cách thức cho các đơn vị tính toán khác mở rộng quy mô để những đơn vị khác có thể xây dựng những điều thú vị trong tương lai.

Giờ đây, chúng ta có khả năng chạy tính toán trên các bộ nhớ có kích thước bất kỳ và tải dữ liệu từ mạng vào các quy trình trong AO, câu hỏi tiếp theo là cách tự thực hiện việc suy luận.

Vì chúng tôi chọn xây dựng AO trên Web Assembly làm máy ảo chính nên việc biên dịch và chạy mã hiện có trong môi trường đó tương đối dễ dàng. Vì chúng tôi đã xây dựng WeaveDrive để nó được hiển thị dưới dạng hệ thống tệp cấp hệ điều hành nên việc chạy Llama.cpp (một công cụ suy luận mô hình ngôn ngữ quy mô lớn nguồn mở) trên hệ thống thực sự tương đối dễ dàng.

Điều này rất ấn tượng Hãy phấn khích vì điều đó có nghĩa là bạn có thể chạy không chỉ công cụ suy luận này mà còn nhiều công cụ khác một cách dễ dàng. Do đó, thành phần cuối cùng để cho phép các mô hình ngôn ngữ lớn chạy trong AO chính là công cụ suy luận mô hình ngôn ngữ lớn. Chúng tôi đã chuyển một hệ thống có tên Llama.cpp, nghe có vẻ hơi bí ẩn nhưng thực sự là môi trường thực thi mô hình nguồn mở hàng đầu hiện nay.

Chạy trực tiếp trong hợp đồng thông minh AO, điều này thực sự tương đối dễ dàng khi chúng tôi có khả năng có bất kỳ lượng dữ liệu nào trong hệ thống và sau đó tải bất kỳ lượng dữ liệu nào từ Arweave.

Để thực hiện được điều này, chúng tôi cũng đang làm việc với tiện ích mở rộng điện toán có tên SIMD (Single Manual Multiple Data), cho phép bạn chạy các mô hình này nhanh hơn. Vì vậy, chúng tôi cũng đã kích hoạt tính năng này. Điều này có nghĩa là hiện tại các model này chạy trên CPU nhưng khá nhanh. Nếu bạn có tính toán không đồng bộ, nó sẽ phù hợp với trường hợp sử dụng của bạn. Những việc như đọc tín hiệu tin tức và sau đó quyết định thực hiện giao dịch nào sẽ hoạt động tốt trong hệ thống hiện tại. Tuy nhiên, chúng tôi cũng có một số nâng cấp thú vị mà chúng tôi sẽ sớm đề cập đến, liên quan đến các cơ chế tăng tốc khác, chẳng hạn như sử dụng GPU để tăng tốc suy luận mô hình ngôn ngữ lớn.

Cho phép Llama.cpp Bạn không chỉ tải Llama 3, mô hình hàng đầu của Meta mà còn có thể tải nhiều mô hình khác, trên thực tế, khoảng 90% mô hình bạn có thể tải xuống từ trang web mô hình nguồn mở Ôm Mặt có thể chạy trong hệ thống, từ GPT -2 nếu bạn muốn. Đến 253 và Monet, hệ thống mô hình ngôn ngữ quy mô lớn của Apple, cũng như nhiều mô hình khác. Vậy là bây giờ chúng ta đã có framework để tải lên bất kỳ mô hình nào từ Arweave, sử dụng ổ cứng để tải lên mô hình mà tôi muốn chạy trong hệ thống. Bạn tải chúng lên, chúng chỉ là dữ liệu bình thường, sau đó bạn có thể tải chúng vào quy trình của AO và thực thi, nhận kết quả và hoạt động theo cách bạn muốn. Chúng tôi tin rằng đây là gói có thể tạo ra các ứng dụng khả thi vốn không thể thực hiện được trong các hệ sinh thái hợp đồng thông minh trước đây và ngay cả khi chúng có thể thực hiện được bây giờ thì số lượng thay đổi về kiến trúc trong các hệ thống hiện tại như Solana sẽ không thể lường trước được và không nằm trong lộ trình của nó. hình ảnh. Vì vậy, để cho bạn thấy điều này và làm cho nó trở nên chân thực và dễ hiểu, chúng tôi đã tạo ra một trình mô phỏng, Llama Fed. Ý tưởng cơ bản là chúng ta có một ủy ban gồm các thành viên Fed là llama, cả về mặt mô hình meta-llama 3 lẫn về mặt là chủ tịch của Fed.

Chúng tôi cũng nói với họ rằng họ là lạc đà không bướu, giống như Alan Greenspan hay Chủ tịch Cục Dự trữ Liên bang. Bạn có thể bước vào môi trường nhỏ này.

Một số người sẽ quen thuộc với môi trường này, trên thực tế, nó giống như Gather mà chúng tôi đang thực hiện hôm nay, bạn có thể nói chuyện với llama và yêu cầu họ cung cấp cho bạn một số mã thông báo cho một dự án rất thú vị và họ sẽ dựa trên yêu cầu của bạn sẽ xác định xem mã thông báo có được trao cho bạn hay không. Vì vậy, bạn đốt một số mã thông báo Arweave, mã thông báo wAR (do nhóm AOX cung cấp) và họ cung cấp cho bạn mã thông báo dựa trên việc họ cho rằng đề xuất của bạn có tốt hay không. Vì vậy, đây là một meme coin có chính sách tiền tệ hoàn toàn tự chủ và thông minh. Mặc dù đây là một dạng trí thông minh đơn giản nhưng nó vẫn rất thú vị. Nó sẽ đánh giá các đề xuất của bạn và của những người khác, đồng thời điều hành chính sách tiền tệ. Bằng cách phân tích các tiêu đề tin tức và đưa ra quyết định thông minh hoặc tương tác với bộ phận hỗ trợ khách hàng và mang lại giá trị, tất cả những điều này giờ đây có thể đạt được trong hợp đồng thông minh. Elliot sẽ cho bạn thấy ngay bây giờ.

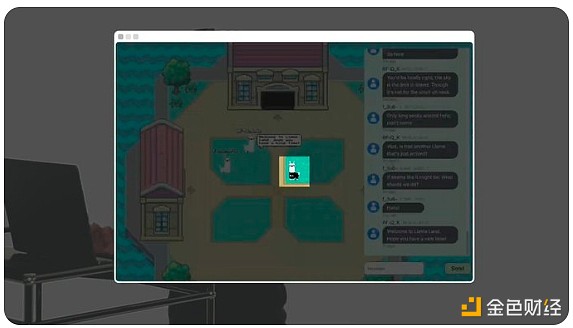

Xin chào mọi người, tôi Đó là Elliot và hôm nay tôi sẽ giới thiệu với bạn Llama Land, một thế giới tự trị trên chuỗi chạy trong AO, được hỗ trợ bởi mô hình Llama 3 mã nguồn mở của Meta.

Cuộc trò chuyện mà chúng tôi thấy ở đây không chỉ nói về người chơi cuộc đối thoại giữa và một con llama kỹ thuật số hoàn toàn tự trị.

Cuộc trò chuyện mà chúng tôi thấy ở đây không chỉ nói về người chơi cuộc đối thoại giữa và một con llama kỹ thuật số hoàn toàn tự trị.

Ví dụ: điều này llama là Nhân loại.

Nhưng con lạc đà không bướu này thì AI trên chuỗi.

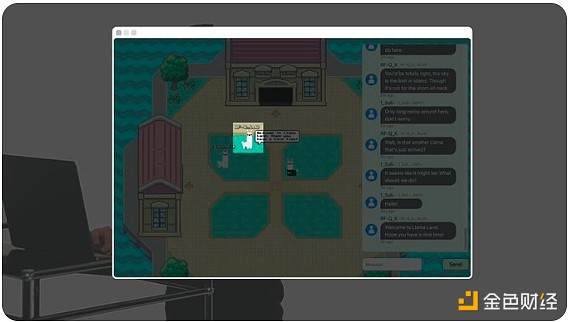

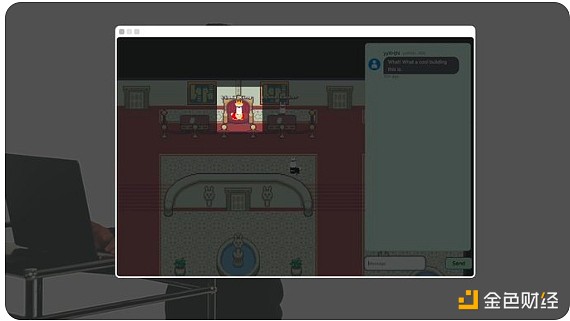

Tòa nhà này chứa thức ăn cho Llama. Nó giống như Cục Dự trữ Liên bang, nhưng dành cho llama.

Llama fed điều hành chính sách tiền tệ dựa trên AI đầu tiên trên thế giới và đúc token Llama.

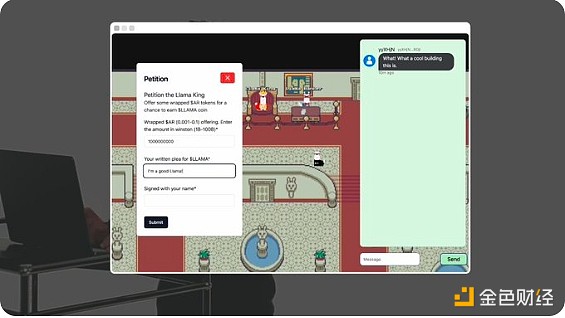

Anh chàng này là Llama nhà vua. Bạn có thể cung cấp cho anh ta mã thông báo Arweave (wAR) được gói và viết yêu cầu nhận một số mã thông báo Llama.

Câu lạc bộ AI Llama King Đánh giá và quyết định có cấp token Llama hay không. Chính sách tiền tệ của Llamafed hoàn toàn tự chủ và không có sự giám sát của con người. Mỗi đại lý trên thế giới và mỗi phòng đều là một quy trình trực tuyến trên AO.

Có vẻ như Vua Llama đã cấp cho chúng tôi một số token và nếu tôi nhìn vào ví ArConnect của mình, tôi có thể thấy chúng đã ở đó. Tốt. Llama Land chỉ là thế giới do AI điều khiển đầu tiên được triển khai trên AO. Đây là khuôn khổ cho một giao thức mới cho phép mọi người xây dựng thế giới tự trị của riêng mình, với giới hạn duy nhất là trí tưởng tượng của bạn. Tất cả điều này được thực hiện 100% trên chuỗi và chỉ có thể thực hiện được trên AO.

Cảm ơn Elliot. Những gì bạn vừa thấy không chỉ là một mô hình ngôn ngữ lớn tham gia vào việc ra quyết định tài chính và vận hành hệ thống chính sách tiền tệ tự chủ. Không có cửa hậu, chúng tôi không có quyền kiểm soát nó, tất cả những điều này đều do chính AI điều hành. Bạn cũng thấy một vũ trụ nhỏ, một nơi mà bạn có thể đi bộ trong không gian vật chất, nơi bạn có thể đến và tương tác với cơ sở hạ tầng tài chính. Chúng tôi nghĩ rằng đây không chỉ là một bản demo nhỏ thú vị.

Thực sự có một số nội dung thực sự thú vị ở đây, những nơi tập hợp những người sử dụng các sản phẩm tài chính khác nhau. Chúng tôi thấy trong hệ sinh thái DeFi rằng nếu ai đó muốn tham gia vào một dự án, trước tiên họ sẽ xem dự án đó trên Twitter và sau đó truy cập trang web để tham gia vào trò chơi gốc cơ bản.

Sau đó, họ tham gia Telegram Kênh nhóm hoặc Discord hoặc trò chuyện với những người dùng khác trên Twitter. Trải nghiệm rất phi tập trung, tất cả chúng ta đều chuyển đổi giữa các ứng dụng khác nhau. Một ý tưởng thú vị mà chúng tôi đang thử nghiệm là liệu bạn có giao diện người dùng cho các ứng dụng DeFi này hay không, cho phép cộng đồng của họ kết hợp với nhau và cùng quản lý không gian tự trị này mà họ cùng truy cập vì đây là một ứng dụng mạng vĩnh viễn có thể tham gia trải nghiệm.

Hãy tưởng tượng bạn có thể đến một nơi trông giống như một nhà đấu giá và trò chuyện với những người dùng khác thích giao thức này. Về cơ bản, bạn có thể trò chuyện với những người dùng khác khi có hoạt động trong quy trình cơ chế tài chính diễn ra trên AO. Các khía cạnh cộng đồng và xã hội được kết hợp với phần tài chính của sản phẩm.

Chúng tôi cho rằng điều này rất thú vị và thậm chí có thể có ý nghĩa rộng hơn. Đây là nơi bạn xây dựng một tác nhân AI tự động đi khắp thế giới Arweave này, tương tác với các ứng dụng và người dùng khác nhau mà nó phát hiện ra. Vì vậy, nếu bạn đang xây dựng một metaverse, điều đầu tiên bạn làm khi tạo trò chơi trực tuyến là tạo NPC (nhân vật không phải người chơi). Ở đây, NPC có thể chung chung.

Bạn có một hệ thống thông minh hoạt động xung quanh và tương tác với môi trường, do đó bạn không gặp phải vấn đề khởi động nguội cho người dùng. Bạn có thể có các đại lý tự trị đang cố gắng kiếm tiền cho mình, cố gắng kết bạn, tương tác với môi trường như những người dùng DeFi bình thường. Chúng tôi nghĩ nó khá buồn cười, nếu hơi kỳ lạ. Chúng ta sẽ thấy.

Trong tương lai, chúng tôi cũng nhận thấy các cơ hội để đẩy nhanh quá trình triển khai các mô hình ngôn ngữ lớn trong AO. Trước đó tôi đã nói về khái niệm chia tỷ lệ đơn vị tính toán. Đây là cách chúng tôi xây dựng WeaveDrive.

Không chỉ dừng lại ở Với WeaveDrive, bạn có thể xây dựng bất kỳ loại tiện ích mở rộng nào cho môi trường điện toán của AO. Có một dự án hệ sinh thái rất thú vị đang giải quyết vấn đề này để thực thi mô hình ngôn ngữ lớn được tăng tốc bằng GPU và đó là Mạng Apus. Tôi sẽ để họ giải thích.

Xin chào, tôi là Mateo. Hôm nay tôi rất vui mừng được giới thiệu Apus Network. Apus Network cam kết xây dựng mạng GPU phi tập trung, không cần tin cậy.

Chúng tôi cung cấp tiện ích mở rộng AO nguồn mở bằng cách tận dụng bộ lưu trữ vĩnh viễn trên chuỗi của Arweave, cung cấp môi trường thực thi xác định cho GPU và mô hình khuyến khích kinh tế cho AI phi tập trung sử dụng mã thông báo AO và APUS. Apus Network sẽ sử dụng các nút khai thác GPU để thực hiện đào tạo mô hình tối ưu, không cần tin cậy một cách cạnh tranh chạy trên Arweave và AO. Điều này đảm bảo rằng người dùng có quyền truy cập vào các mô hình AI tốt nhất với mức giá tiết kiệm nhất. Bạn có thể theo dõi tiến trình của chúng tôi trên X (Twitter) @apus_network. Cảm ơn.

Đây là AO của ngày hôm nay Tình trạng hiện tại của AI trên Internet. Bạn có thể dùng thử Llama Fed và thử tự mình xây dựng các ứng dụng hợp đồng thông minh dựa trên các mô hình ngôn ngữ lớn. Chúng tôi tin rằng đây là bước khởi đầu của việc đưa thông tin thị trường vào môi trường thực thi phi tập trung. Chúng tôi rất vui mừng về điều này và mong muốn được xem điều gì sẽ xảy ra tiếp theo. Cảm ơn tất cả các bạn đã tham gia ngày hôm nay và tôi mong được giao tiếp với các bạn lần nữa.

Nguyên tắc đầu tiên của blockchain là phương pháp kế toán phi tập trung, không cần thiết phải có "khối" và "chuỗi".

JinseFinance

JinseFinanceTôi nghĩ một trong những giá trị kỹ thuật lớn nhất của AO là nó tách rời cơ chế đồng thuận khỏi tính toán mà ứng dụng yêu cầu.

JinseFinance

JinseFinanceTrong AO, một thế giới mở rộng theo chiều ngang mới đang chờ chúng ta khám phá, nhưng điều này sẽ không thể thực hiện được nếu không có cặp dự án DePIN (Mạng cơ sở hạ tầng vật lý phi tập trung) làm nền tảng cho AO.

JinseFinance

JinseFinanceTrong AO, một thế giới mới về quy mô theo chiều ngang đang chờ chúng ta khám phá, nhưng điều này sẽ không thể thực hiện được nếu không có cặp dự án DePIN (Mạng cơ sở hạ tầng vật lý phi tập trung) làm nền tảng cho AO.

JinseFinance

JinseFinanceArweave AO phá vỡ xiềng xích của blockchain và không xử lý bản thân việc tính toán cũng như đạt được sự đồng thuận. Thay vào đó, nó sử dụng các mô hình kinh tế và xác minh lười biếng để đảm bảo tính chính xác của kết quả tính toán. Có thể nói đây là một cách tiếp cận mới.

JinseFinance

JinseFinanceKhái niệm DeSci (khoa học phi tập trung) lần đầu tiên được đề xuất vào năm 2018. Dù chưa nhận được sự quan tâm rộng rãi của công chúng nhưng nó được Messari coi là một câu chuyện mới sắp bùng nổ.

JinseFinance

JinseFinanceCó hai cách tiếp cận cơ bản đối với "song song": bộ nhớ dùng chung và truyền tin nhắn. Sự đổi mới của AO nằm ở việc áp dụng tính năng nhắn tin vào blockchain và hợp đồng thông minh.

JinseFinance

JinseFinanceArweave là một loại mạng lưu trữ blockchain mới được thiết kế để giải quyết vấn đề lưu trữ và truy cập dữ liệu vĩnh viễn.

JinseFinance

JinseFinanceAO thực sự là một giao thức dữ liệu mở và linh hoạt để lưu trữ nhật ký tính toán trên giao thức của Arweave. Nó không phải là một sổ cái cố định, cũng không phải là một mạng lưới.

JinseFinance

JinseFinanceChính xác thì AO là gì? Những tính năng nào đã giúp người sáng lập tự tin cạnh tranh với Ethereum?

JinseFinance

JinseFinance