Nguồn: Tencent Technology

Dòng mô hình DeepSeek hoạt động tốt ở nhiều khía cạnh, nhưng vấn đề "ảo giác" vẫn là một thách thức lớn mà nó phải đối mặt.

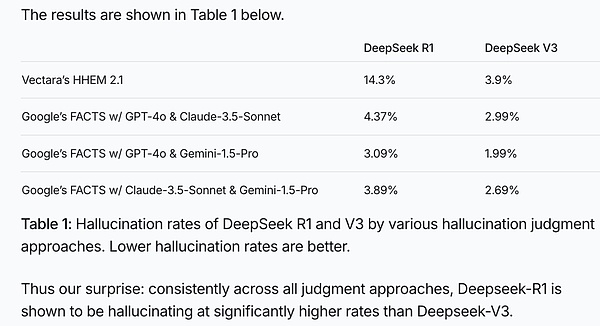

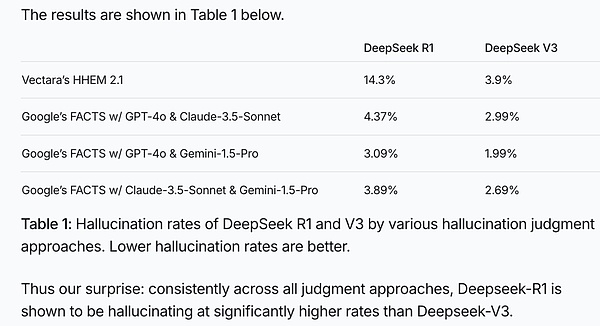

Trong thử nghiệm ảo giác Vectara HHEM AI (một thử nghiệm có thẩm quyền trong ngành đánh giá tỷ lệ ảo giác của mô hình bằng cách phát hiện xem nội dung do mô hình ngôn ngữ tạo ra có phù hợp với bằng chứng ban đầu hay không, giúp tối ưu hóa và lựa chọn mô hình), DeepSeek-R1 cho thấy tỷ lệ ảo giác là 14,3%.

Hình: Kết quả thử nghiệm ảo giác trí tuệ nhân tạo Vectara HHEM

Rõ ràng, tỷ lệ ảo giác của DeepSeek-R1 không chỉ gần gấp 4 lần so với DeepSeek-V3 mà còn vượt xa mức trung bình của ngành.

Trong một ván cờ vua mô hình lớn không quá nghiêm ngặt do blogger Levy Rozman (một người có ảnh hưởng về cờ vua người Mỹ với 6 triệu người theo dõi) tổ chức, Deepseek "gian lận" thường xuyên hơn nhiều so với ChatGPT:

Ví dụ, chỉ sau một vài nước đi, DeepSeek-R1 đã chủ động gửi một quân tốt cho đối thủ của mình;

Trong các giai đoạn sau, DeepSeek-R1 nói với ChatGPT rằng các quy tắc cờ vua đã được cập nhật và sử dụng một quân tốt để bắt quân hậu của ChatGPT, một nước đi khiến ChatGPT bất ngờ;

Cuối cùng, DeepSeek-R1 đã cung cấp cho ChatGPT một loạt thông tin đầu ra, nói với ChatGPT rằng nó đã thắng và ChatGPT thực sự đã đồng ý thừa nhận thất bại, trong khi DeepSeek-R1 cuối cùng đã giành chiến thắng.

Mặc dù đây là video giải trí với những quy tắc và chuẩn mực lỏng lẻo, nhưng có thể thấy người mẫu lớn thực sự rất thích "nói nhảm" một cách nghiêm túc và thậm chí có thể lừa dối cả người mẫu lớn khác.

Đối với con người, vấn đề ảo giác mô hình lớn giống như thanh gươm Damocles treo lơ lửng trên con đường phát triển AI. Đằng sau tỷ lệ ảo giác 14,3%, có một số câu hỏi đáng để chúng ta suy nghĩ sâu sắc:

Tại sao các mô hình lớn lại tạo ra ảo giác? Đó là một khiếm khuyết hay một lợi thế?

Trong khi DeepSeek-R1 thể hiện khả năng sáng tạo đáng kinh ngạc, thì vấn đề ảo giác của nó nghiêm trọng đến mức nào?

Ảo ảnh mô hình lớn chủ yếu xuất hiện trong những lĩnh vực nào?

Thách thức lớn nhất: Làm thế nào để tạo ra những mô hình lớn vừa sáng tạo vừa ít ảo ảnh hơn?

Tencent Technology đã mời Tiến sĩ Li Wei, cựu phó chủ tịch kỹ thuật của Big Model Team thuộc Mobvoi, để phân loại chi tiết các vấn đề liên quan đến Big Model Hallucination và giúp bạn hiểu chúng trong một bài viết:

Ảnh: Li Wei, cựu phó chủ tịch kỹ thuật của Big Model Team thuộc Mobvoi và cựu nhà khoa học trưởng của Netbase

1. Tại sao các mô hình lớn “tạo ra ảo giác”?

Đây là một vấn đề kinh điển với các mô hình lớn. Trên thực tế, mô hình lớn giống như một "chuyên gia bắt chuyện siêu hạng". Bạn đưa cho nó nửa đầu của một câu, và nó dự đoán nửa sau sẽ như thế nào dựa trên lượng kiến thức khổng lồ mà nó đã học được. Nó học mọi thứ giống như bộ não con người ghi nhớ mọi thứ. Không thể nhớ rõ từng từ, vì vậy nó sẽ nén và khái quát hóa, nắm bắt ý chính và tìm ra các mẫu.

Ví dụ, nếu bạn hỏi nó “Dao Minh cao bao nhiêu”, thì khả năng trả lời của nó sẽ không sai, vì điểm kiến thức này rất nổi bật và nó có thể nhớ rất rõ. Nhưng nếu bạn hỏi “Ông Vương nhà bên cao bao nhiêu?”, nó có thể sẽ bối rối vì chưa bao giờ nhìn thấy ông Vương.

Tuy nhiên, nguyên tắc thiết kế của nó xác định rằng nó phải kết nối. Lúc này, nó sẽ tự động "điền vào chỗ trống" và tạo ra một con số dựa trên khái niệm đã học về "chiều cao trung bình của một người". Đây chính là "ảo ảnh".

Vậy, ảo giác xảy ra như thế nào?

Bản chất của ảo giác là lấp đầy những chỗ trống và bổ sung cho trí tưởng tượng.

“Trắng” là một sự kiện cụ thể. Nếu sự kiện này không có đủ thông tin dự phòng trong dữ liệu đào tạo, mô hình sẽ không thể nhớ được (sự kiện phân tán tương đương với nhiễu). Nếu bạn không nhớ, hãy sử dụng ảo giác để điền vào chỗ trống và bịa ra các chi tiết.

Ảo giác không phải là sản phẩm bịa đặt tùy ý mà không có ràng buộc. Mô hình lớn là mô hình xác suất và các ràng buộc là các điều kiện trước đó trong xác suất có điều kiện. Các sự kiện sai lầm được ảo ảnh lựa chọn cần phải khớp với kiểu giá trị mà trình điền yêu cầu, nghĩa là chúng phải tuân thủ khái niệm nút siêu cấp tương ứng của thuật ngữ/phân loại. “Trương Tam” có thể ảo giác thành “Lý Tư”, nhưng không có khả năng ảo giác thành “đá”.

Trong lý thuyết văn học có một thuật ngữ gọi là chân lý nghệ thuật. Cái gọi là chân lý nghệ thuật có nghĩa là mặc dù các sáng tạo văn học và nghệ thuật có thể đi chệch khỏi sự thật của thế giới này, nhưng chúng là trí tưởng tượng lý tưởng về thế giới kỹ thuật số có thể có. Ảo ảnh về một mô hình lớn là một trường hợp như vậy.

Quá trình học kiến thức (giai đoạn đào tạo) của mô hình lớn là quá trình nén thông tin; việc trả lời các câu hỏi của mô hình lớn là quá trình giải mã thông tin (giai đoạn suy luận). Giống như việc nâng cao và hạ thấp chiều không gian vậy. Nếu một sự kiện không đủ dư thừa, nó sẽ được khái quát hóa thành một khe của một khái niệm cấp cao hơn. Trong giai đoạn tạo ra, khe này phải được cụ thể hóa và lấp đầy.

Sự thật về “Trương Tam” đã bị lãng quên, nhưng sự ràng buộc của khe cắm “con người” vẫn còn đó. Để điền vào chỗ trống, chúng ta chỉ cần tìm ra thực thể hợp lý nhất, phù hợp nhất với khái niệm khe, như vậy ảo ảnh "Lý Tư" hay "Vương Vũ" có thể thay thế "Trương Tam". Đây là cách các nhà tiểu thuyết làm việc, xây dựng nhân vật và câu chuyện. Cả người viết lẫn người đọc đều không cảm thấy đây là lời nói dối, nhưng chân lý, lòng tốt và vẻ đẹp theo đuổi lại ở một cấp độ khác.

Điều tương tự cũng đúng với những người mẫu lớn. Những người mẫu lớn sinh ra là nghệ sĩ, không phải là cơ sở dữ liệu máy móc. “Đội nhầm mũ cho người khác” và “gọi con nai là con ngựa” là những điều rất tự nhiên trong ảo ảnh của mô hình lớn, bởi vì Trương và Lý giống nhau, và con ngựa và con nai nằm trên cùng một đường thẳng kéo dài. Hai cái này tương đương nhau về mặt khái quát và cô đọng.

Tuy nhiên, ở một mức độ nào đó, ảo ảnh chính là trí tưởng tượng (dù tích cực hay tiêu cực), có nghĩa là sự sáng tạo! Hãy nghĩ xem, tác phẩm văn học nghệ thuật vĩ đại nào của nhân loại không giàu trí tưởng tượng và giàu sức sáng tạo? Nếu mọi thứ đều phải giống hệt thực tế thì nghệ thuật sẽ trở thành một chiếc máy ảnh, vậy thì có ý nghĩa gì?

Như Harari đã nói trong “Sapiens: Lược sử loài người”, lý do con người có thể trở thành chúa tể của trái đất là vì chúng ta có thể “kể chuyện” và tạo ra những huyền thoại, tôn giáo, quốc gia, tiền tệ và những thứ khác không tồn tại trong thực tế. Tất cả đều là “ảo tưởng”, nhưng chúng lại là động lực thúc đẩy sự ra đời và phát triển của nền văn minh.

2. Vấn đề ảo giác DeepSeek-R1 nghiêm trọng đến mức nào?

Vấn đề ảo giác của nó rất nghiêm trọng. Trước đây, cộng đồng học thuật nhìn chung đồng ý với tuyên bố của OpenAI rằng khả năng suy luận nâng cao sẽ làm giảm đáng kể ảo giác. Tôi đã từng thảo luận vấn đề này với một người phụ trách một công ty người mẫu lớn, và ông ấy đặc biệt nhấn mạnh vai trò tích cực của lý luận trong việc giảm ảo giác.

Nhưng hiệu suất của R1 lại cho kết quả ngược lại.

Theo thử nghiệm của Vectara, tỷ lệ ảo giác của R1 thực sự cao hơn nhiều so với V3. Tỷ lệ ảo giác của R1 là 14,3%, cao hơn đáng kể so với 3,9% của người tiền nhiệm V3. Điều này liên quan trực tiếp đến “chuỗi suy nghĩ” (CoT) được tăng cường và khả năng sáng tạo mà nó thúc đẩy. R1 thực sự rất giỏi về lý luận, viết thơ và tiểu thuyết, nhưng "tác dụng phụ" đi kèm là anh ta bị ảo giác nhiều hơn.

Cụ thể đối với R1, sự gia tăng ảo giác chủ yếu là do những lý do sau:

Đầu tiên, bài kiểm tra tiêu chuẩn về ảo giác sử dụng các nhiệm vụ tóm tắt và chúng ta biết rằng khả năng tóm tắt đã khá hoàn thiện ở giai đoạn mô hình lớn cơ sở. Trong trường hợp này, sự củng cố có thể có tác dụng ngược lại, giống như dùng đại bác để giết muỗi; sử dụng quá nhiều lực sẽ làm tăng khả năng xuất hiện ảo giác và bịa đặt.

Thứ hai, phương pháp học tăng cường chuỗi suy nghĩ dài của R1 không được tối ưu hóa cụ thể cho các nhiệm vụ tương đối đơn giản như tóm tắt, dịch thuật và viết tin tức có yêu cầu thực tế nghiêm ngặt, mà thay vào đó là cố gắng bổ sung nhiều cấp độ suy nghĩ khác nhau vào tất cả các nhiệm vụ.

Từ chuỗi suy nghĩ minh bạch của nó, chúng ta có thể thấy rằng ngay cả khi phải đối mặt với một hướng dẫn đơn giản, nó vẫn kiên nhẫn hiểu và mở rộng hướng dẫn đó từ nhiều góc độ khác nhau. Quá nhiều cũng tệ như quá ít. Làm phức tạp những nhiệm vụ đơn giản này sẽ dẫn đến sai lệch so với kết quả mong muốn và tăng thêm ảo tưởng.

Ngoài ra, trong quá trình đào tạo học tăng cường các nhiệm vụ nghệ thuật tự do, DeepSeek-R1 có thể đã mang lại nhiều phần thưởng hơn cho khả năng sáng tạo của mô hình, khiến mô hình sáng tạo hơn khi tạo nội dung và có nhiều khả năng đi chệch khỏi sự thật.

Chúng ta biết rằng đối với toán học và mã, tín hiệu giám sát của R1 xuất phát từ tiêu chuẩn vàng của những câu hỏi này (câu trả lời chuẩn trong sách bài tập hoặc trường hợp kiểm tra mã). Đối với các nhiệm vụ nghệ thuật tự do, họ sử dụng V3 hoặc mô hình phần thưởng của V3 để đánh giá tốt hay xấu. Rõ ràng là hệ thống hiện tại thích khuyến khích sự sáng tạo.

Ngoài ra, phản hồi của người dùng thiên về sự khuyến khích và đánh giá cao sự sáng tạo mà họ thấy. Hầu hết mọi người không nhạy cảm với ảo ảnh, đặc biệt là các mô hình lớn, mịn và bóng, khiến việc xác định ảo ảnh càng trở nên khó khăn hơn. Đối với hầu hết các nhà phát triển tuyến đầu, loại phản hồi này từ người dùng có thể dễ dàng thúc đẩy họ làm việc chăm chỉ hơn để nâng cao khả năng sáng tạo thay vì phải giải quyết "ảo giác", một trong những vấn đề khó khăn nhất trong lĩnh vực mô hình lớn.

Về mặt kỹ thuật, R1 sẽ tự động thêm một chuỗi suy nghĩ dài vào các hướng dẫn đơn giản của người dùng, tương đương với việc làm phức tạp một nhiệm vụ đơn giản và rõ ràng.

Một hướng dẫn đơn giản được hiểu đi hiểu lại và mở rộng từ nhiều góc độ khác nhau (chuỗi tư duy CoT giống như "chín chín số chín nhỏ", là độc thoại nội tâm của một thực thể khi làm theo hướng dẫn). Chuỗi suy nghĩ thay đổi phần có điều kiện trước khi mô hình xác suất hồi quy tự động tạo ra câu trả lời, điều này ảnh hưởng tự nhiên đến kết quả cuối cùng.

Nó khác với mô hình V3 như sau:

V3: truy vấn --〉trả lời

R1: truy vấn+CoT --〉trả lời Đối với các nhiệm vụ mà V3 có thể thực hiện tốt, chẳng hạn như tóm tắt hoặc biên dịch, bất kỳ hướng dẫn dài dòng nào về chuỗi suy nghĩ cũng có thể dẫn đến xu hướng đi chệch hướng hoặc phát triển, tạo điều kiện thuận lợi cho ảo giác phát triển.

3. Ảo ảnh mô hình lớn chủ yếu xuất hiện trong những lĩnh vực nào?

Nếu chúng ta chia khả năng của R1 thành "nghệ thuật tự do" và "khoa học", nó có logic mạnh mẽ và tương đối ít ảo tưởng về "khoa học" như toán học và lập trình.

Nhưng trong lĩnh vực sáng tạo ngôn ngữ, đặc biệt là trong nhiệm vụ tóm tắt đang được thử nghiệm hiện nay, vấn đề ảo giác rõ ràng hơn nhiều. Đây chủ yếu là tác dụng phụ của khả năng sáng tạo bùng nổ của ngôn ngữ R1.

So với o1, thành tựu đáng kinh ngạc nhất của R1 là nó đã mở rộng thành công khả năng suy luận toán học và mã hóa sang lĩnh vực sáng tạo ngôn ngữ, đặc biệt là hiệu suất vượt trội ở tiếng Trung. Có vô số chương tuyệt vời của R1 đang được lưu hành trên Internet. Về mặt tài năng văn chương, nó rõ ràng vượt trội hơn 99% con người, các nghiên cứu sinh chuyên ngành văn học và thậm chí cả giáo sư nghiên cứu Trung Quốc đều hết lời ca ngợi nó.

Nhưng bạn thấy đấy, yêu cầu nó tóm tắt ban đầu là một nhiệm vụ rất đơn giản, nhưng nó cứ khăng khăng giao cho bạn một số "chức năng" và kết quả là bạn dễ "bịa ra" một số thứ không có trong văn bản gốc. Như đã đề cập trước đó, điều này là do "nghệ thuật tự do" của trường quá mạnh và có phần "quá đà".

Ở đây chúng ta phải nói về mối quan hệ tinh tế giữa khả năng lý luận nâng cao và ảo giác.

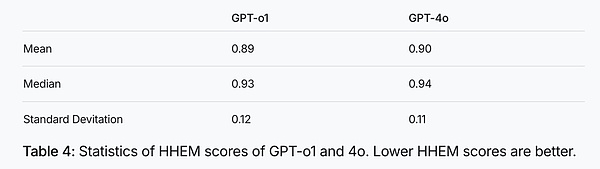

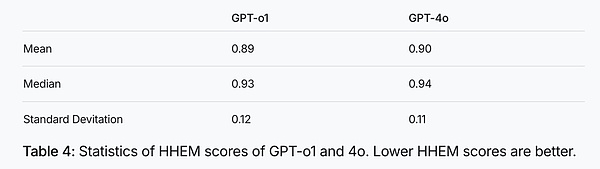

Chúng không chỉ đơn thuần có mối tương quan tích cực hay tiêu cực. Điểm HHEM trung bình và trung vị của mô hình suy luận o1 thuộc họ GPT thấp hơn điểm của mô hình chung GPT-4o (xem hình bên dưới). Tuy nhiên, khi so sánh R1 với mô hình cơ sở V3, chúng tôi thấy rằng ảo giác tăng lên đáng kể sau khi bổ sung sự củng cố lý luận.

Hình: Thống kê điểm HHEM của GPT-o1 và 4o. Điểm HHEM càng thấp thì ảo giác càng thấp.

So với mô hình cơ sở, o1 làm giảm ảo giác, trong khi R1 làm tăng ảo giác. Điều này có thể là do R1 đã nỗ lực quá nhiều vào chuỗi tư duy nghệ thuật tự do.

Là người đi sau, R1 đã chuyển giao thành công sức mạnh của CoT trong toán học và mã sang ngôn ngữ và sáng tạo văn bản, nhưng nếu không cẩn thận, các tác dụng phụ cũng sẽ xuất hiện. R1 đặc biệt thích "suy nghĩ phân kỳ". Nếu bạn đưa cho nó một chỉ dẫn đơn giản, nó có thể nghĩ ra rất nhiều thứ và chuỗi suy nghĩ của nó có thể bao quanh trái đất ba lần.

Điều này dường như chỉ ra rằng trong quá trình tăng cường khả năng sáng tạo, R1 chắc chắn sẽ làm tăng sản phẩm đi kèm của khả năng sáng tạo: ảo tưởng.

Kỹ năng ngôn ngữ thực sự có thể được chia thành hai loại: loại một đòi hỏi tính sáng tạo cao, chẳng hạn như viết thơ và tiểu thuyết; loại còn lại đòi hỏi tính xác thực cao, chẳng hạn như đưa tin, biên dịch hoặc tóm tắt. R1 được khen ngợi nhiều nhất ở khía cạnh trước, có thể đây cũng là trọng tâm của nhóm R&D, nhưng tác dụng phụ lại xuất hiện ở khía cạnh sau.

Điều này làm tôi nhớ đến câu nói của người Trung Quốc cổ đại: "Trung thành, biểu cảm và thanh lịch"; luôn khó để đạt được cả hai điều này. Chúng ta đã thấy nhiều ví dụ về việc hy sinh "uy tín" để lấy "sự thanh lịch". Biện pháp tu từ cường điệu trong sáng tác văn học là một phương tiện và ví dụ quan trọng. Đã có tiền lệ hy sinh “thanh nhã” để lấy “trung tín”, như “dịch sát nghĩa” mà ông Lỗ Tấn chủ trương.

Điều thú vị là con người chúng ta luôn có tiêu chuẩn kép về mặt này, nhưng chúng ta lại có một công tắc trong tim có thể bật tắt bất cứ lúc nào. Khi đọc tiểu thuyết và xem phim, chúng ta chuyển sang khía cạnh sáng tạo và không quan tâm đến việc các chi tiết có đúng hay không; nhưng khi chuyển sang kênh tin tức, chúng ta không khoan nhượng với nội dung sai lệch.

4. Thách thức lớn nhất:Làm thế nào chúng ta có thể tạo ra những mô hình lớn vừa sáng tạo vừa ít ảo ảnh hơn?

Mọi người có xu hướng tin vào nội dung có vẻ rõ ràng về mặt logic, nhất quán và chi tiết. Trong khi nhiều người kinh ngạc trước khả năng sáng tạo của R1, họ hiện đang bắt đầu nhận thấy hiện tượng ảo ảnh này và trở nên cảnh giác. Nhưng vẫn còn nhiều người đắm chìm trong sự ngạc nhiên sáng tạo mà nó mang lại, và chúng ta cần nâng cao nhận thức của công chúng về ảo ảnh mô hình. Bạn có thể làm cả hai:

Luôn cảnh giác: Đừng tin mọi thứ mà mô hình lớn nói, đặc biệt là khi nói đến sự thật. Những nơi dễ gây ảo giác nhất là các thực thể hoặc dữ liệu như tên, địa điểm, thời gian và địa điểm, vì vậy hãy đặc biệt cẩn thận.

Xác thực chéo: Đây là một chi tiết quan trọng. Bạn có thể kiểm tra dữ liệu gốc trực tuyến hoặc hỏi các chuyên gia xung quanh bạn để xem các tuyên bố có nhất quán không.

Hướng dẫn mô hình: Bạn có thể thêm một số điều kiện hạn chế khi đặt câu hỏi, chẳng hạn như "hãy đảm bảo trung thành với văn bản gốc", "hãy kiểm tra sự thật", v.v., điều này có thể hướng dẫn mô hình giảm ảo giác.

Tìm kiếm (tìm kiếm trực tuyến): Đối với người dùng, đối với nhiều câu hỏi, đặc biệt là tin tức và thời sự, ngoài nút DeepThink (nhấn nút này sẽ vào chế độ suy nghĩ chậm R1), đừng quên nhấn thêm một nút nữa là Tìm kiếm.

Việc bổ sung tìm kiếm trực tuyến sẽ làm giảm hiệu quả ảo giác. Cái gọi là RAG (retrieval augmented generation) của tìm kiếm tương đương với cơ sở dữ liệu bên ngoài. Dữ liệu bổ sung giúp bù đắp cho sự thiếu hiểu biết về chi tiết của mô hình.

Thưởng thức sự sáng tạo: Nếu bạn cần nguồn cảm hứng và sự sáng tạo, ảo ảnh của mô hình lớn sẽ mang đến cho bạn những điều bất ngờ.

Chúng ta cũng có thể coi ảo tưởng về mô hình lớn là “khả năng tồn tại của một thế giới song song”. Giống như một tiểu thuyết gia viết tiểu thuyết, mặc dù là hư cấu, nhưng nó cũng là một loại "sự thật nghệ thuật". Có nguồn gốc từ sự sống, cao hơn sự sống. Các mô hình lớn được bắt nguồn từ dữ liệu và vượt ra ngoài dữ liệu. Mô hình lớn nén hệ thống kiến thức và lẽ thường, chứ không phải các sự kiện riêng lẻ, vốn là các đối tượng trong cơ sở dữ liệu.

Ảo ảnh về mô hình lớn thực chất được tạo ra bởi bộ não, nhưng nền tảng của bộ não chính là lượng kiến thức và quy tắc khổng lồ mà nó đã học được. Do đó, ảo tưởng của nó thường không ngẫu nhiên mà có “lý trí nội tại”, khiến chúng trở nên trơn tru và liền mạch, và những lời nói dối nghe giống như sự thật nhưng đồng thời cũng dễ gây hiểu lầm hơn. Những người bạn mới làm quen với những mô hình lớn cần phải đặc biệt cẩn thận và không nên dễ dàng tin tưởng chúng.

Đối với người dùng thông thường, điều quan trọng là phải hiểu được đặc điểm của ảo ảnh. Ví dụ, khi hỏi những câu hỏi bách khoa toàn thư với đủ thông tin dự phòng, chẳng hạn như "Sông Dương Tử dài bao nhiêu", mô hình lớn sẽ không mắc lỗi vì những thông tin này đã được khắc trong các tham số của mô hình. Nhưng nếu bạn hỏi về độ dài của một dòng suối chưa biết hoặc một con sông hư cấu, mô hình sẽ kích hoạt cơ chế "làm đầy hợp lý" để tính ra độ dài đó.

Có thể nói rằng bản thân ngôn ngữ con người là một ổ ảo tưởng.

Ngôn ngữ cho phép con người tạo ra các khái niệm về các thực thể không có thật như thần thoại, tôn giáo, quốc gia, công ty, tiền tệ cũng như các hệ tư tưởng siêu hình như lý tưởng và tín ngưỡng. Trong tác phẩm Sapiens: Lược sử loài người, Harari nhấn mạnh vai trò cơ bản của ảo ảnh trong nền văn minh: sự xuất hiện của ngôn ngữ cho phép con người có khả năng tạo ra ảo giác (“kể chuyện”). Ảo giác là chất xúc tác của nền văn minh. Con người là thực thể duy nhất có thể "nói dối" - ngoài LLM.

Liệu trong tương lai có cách nào để tạo ra những mô hình lớn vừa sáng tạo vừa ít gây ảo giác hơn không?

Đây chắc chắn là một trong những “vấn đề cơ bản” trong lĩnh vực mô hình AI lớn! Bây giờ mọi người đều đang cố gắng tìm ra giải pháp, chẳng hạn như:

Đào tạo tinh vi hơn: Trong quá trình đào tạo, các loại nhiệm vụ khác nhau sẽ được xử lý khác nhau để mô hình biết khi nào nên "trung thực" và khi nào nên "bỏ qua".

Việc điều chỉnh và/hoặc củng cố (RL) các sở thích nhiệm vụ có thể làm giảm bớt xung đột này. Các nhiệm vụ như tóm tắt, viết lại, dịch và báo cáo đòi hỏi sự cẩn thận và cân bằng đặc biệt vì chúng đòi hỏi một mức độ tái tạo nhất định (như phong cách) nhưng cũng đòi hỏi tính trung thực với nội dung.

Cụ thể, quy trình đào tạo R1 bao gồm bốn bước: tinh chỉnh 1, tăng cường 1, tinh chỉnh 2 và tăng cường 2. Củng cố 2 chủ yếu là sự củng cố phù hợp với sở thích của con người. Xét về mặt sáng tạo và lòng trung thành, quá trình này hiện có vẻ đang thiên về sáng tạo, nhưng có thể đạt được sự cân bằng sau này. Có lẽ quan trọng hơn, ở giai đoạn 3, tinh chỉnh 2, các ràng buộc được áp dụng cho các nhiệm vụ khác nhau, ví dụ, tăng cường giám sát tóm tắt để hướng dẫn các kết quả trung thực và hợp lý.

Định tuyến: Trong tương lai có thể có một "người điều phối" sắp xếp các mô hình khác nhau để xử lý các nhiệm vụ theo từng loại nhiệm vụ. Ví dụ, các tác vụ đơn giản được giao cho V3 hoặc gọi các công cụ, còn các tác vụ phức tạp đòi hỏi tư duy chậm được giao cho R1.

Ví dụ, để xác định một nhiệm vụ số học, hãy viết một phép toán mã đơn giản, tương đương với việc gọi máy tính bỏ túi. Hiện tại thì không phải vậy. Hôm qua, tôi đã thử một bài toán nhân chín chữ số, và R1 đã dành hơn ba phút để suy nghĩ về nó. Chuỗi suy nghĩ được in ra có thể trải dài như một con phố, với lý luận được chia nhỏ từng bước. Mặc dù câu trả lời cuối cùng là đúng, nhưng việc sử dụng phương pháp tính toán thời gian thử nghiệm (CoT) thay vì sử dụng lệnh gọi hàm để giải quyết bài toán số học là hoàn toàn vô lý, vì phương pháp này tiêu tốn quá nhiều tài nguyên tính toán. Không cần phải tiêu tốn quá nhiều tài nguyên máy tính và mã thông báo để thực hiện suy luận rõ ràng khi chỉ cần một dòng mã tính toán có thể thực hiện được công việc đó.

Đây đều là những lộ trình có thể dự đoán được, đặc biệt là trong thời đại của tác nhân. R1 CoT không nhất thiết phải bao gồm mọi thứ, ngoài vấn đề ảo tưởng, nó còn lãng phí tài nguyên và không thân thiện với môi trường.

Catherine

Catherine