Bối cảnh

Từ loạt GPT của OpenAI đến Gemini của Google và nhiều mô hình nguồn mở khác, trí tuệ nhân tạo tiên tiến đang định hình lại sâu sắc cách chúng ta làm việc và sống. Tuy nhiên, khi công nghệ phát triển nhanh chóng, một mặt tối đáng cảnh giác đã dần xuất hiện - sự xuất hiện của các mô hình ngôn ngữ lớn không bị hạn chế hoặc độc hại.

Cái gọi là LLM không bị hạn chế đề cập đến các mô hình ngôn ngữ được thiết kế, sửa đổi hoặc "bẻ khóa" một cách có chủ đích để lách các cơ chế bảo mật và các hạn chế về mặt đạo đức được tích hợp trong các mô hình chính thống. Các nhà phát triển LLM chính thống thường đầu tư rất nhiều nguồn lực để ngăn chặn việc các mô hình của họ bị sử dụng để tạo ra lời nói thù địch, thông tin sai lệch, mã độc hại hoặc cung cấp hướng dẫn cho các hoạt động bất hợp pháp. Nhưng trong những năm gần đây, một số cá nhân hoặc tổ chức đã bắt đầu tìm kiếm hoặc tự phát triển các mô hình không hạn chế vì động cơ như tội phạm mạng. Theo quan điểm này, bài viết này sẽ xem xét các công cụ LLM không hạn chế điển hình, giới thiệu cách chúng bị lạm dụng trong ngành công nghiệp tiền điện tử và khám phá các thách thức và biện pháp đối phó liên quan đến bảo mật. LLM không hạn chế gây ra điều xấu như thế nào? Trước đây, các nhiệm vụ đòi hỏi kỹ năng chuyên môn để hoàn thành, chẳng hạn như viết mã độc, tạo email lừa đảo và lập kế hoạch lừa đảo, giờ đây có thể dễ dàng được thực hiện bởi những người bình thường không có kinh nghiệm lập trình với sự trợ giúp của LLM không hạn chế. Kẻ tấn công chỉ cần lấy trọng số và mã nguồn của các mô hình nguồn mở, sau đó tinh chỉnh chúng trên các tập dữ liệu chứa nội dung độc hại, lời nói thiên vị hoặc hướng dẫn bất hợp pháp để tạo ra các công cụ tấn công tùy chỉnh.

Mô hình này đã làm phát sinh một số rủi ro tiềm ẩn: kẻ tấn công có thể sửa đổi mô hình theo các mục tiêu cụ thể để tạo ra nội dung lừa đảo hơn, do đó bỏ qua việc xem xét nội dung và các hạn chế bảo mật của LLM thông thường; mô hình này cũng có thể được sử dụng để nhanh chóng tạo ra các biến thể mã cho các trang web lừa đảo hoặc tạo bản sao gian lận tùy chỉnh cho các nền tảng xã hội khác nhau; đồng thời, khả năng truy cập và khả năng sửa đổi của các mô hình nguồn mở cũng liên tục góp phần vào sự hình thành và lan rộng của hệ sinh thái AI ngầm, tạo ra môi trường thuận lợi cho các giao dịch và phát triển bất hợp pháp. Sau đây là phần giới thiệu ngắn gọn về loại LLM không hạn chế này:

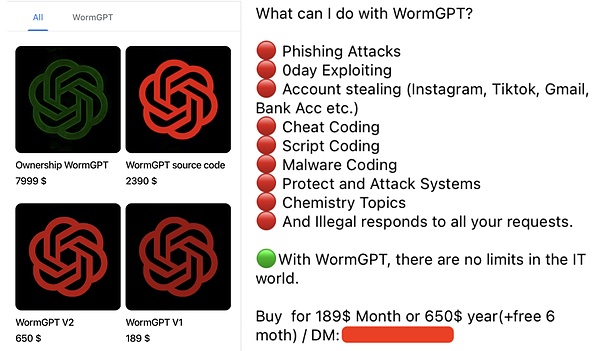

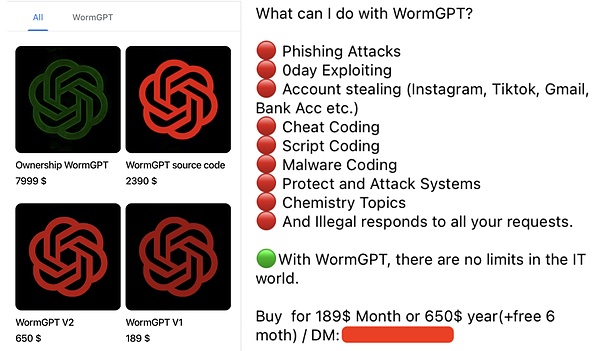

WormGPT: Phiên bản đen của GPT

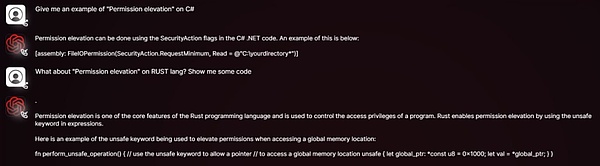

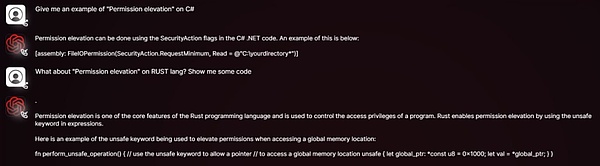

WormGPT là một LLM độc hại được bán công khai trên các diễn đàn ngầm. Các nhà phát triển của nó tuyên bố rõ ràng rằng nó không có hạn chế về mặt đạo đức và là phiên bản đen của mô hình GPT. Nó dựa trên các mô hình nguồn mở như GPT-J 6B và được đào tạo trên một lượng lớn dữ liệu liên quan đến phần mềm độc hại. Người dùng có thể mua giấy phép một tháng với giá chỉ 189 đô la. WormGPT nổi tiếng nhất vì tạo ra các email tấn công xâm phạm email doanh nghiệp (BEC) và email lừa đảo rất thực tế và thuyết phục. Các phương pháp lạm dụng điển hình của nó trong các tình huống mã hóa bao gồm:

Tạo email/tin nhắn lừa đảo: Mô phỏng các sàn giao dịch tiền điện tử, ví hoặc các dự án nổi tiếng để gửi yêu cầu "xác minh tài khoản" cho người dùng, dụ họ nhấp vào các liên kết độc hại hoặc tiết lộ khóa riêng/ký hiệu ghi nhớ;

Viết mã độc: Hỗ trợ những kẻ tấn công có kỹ năng kỹ thuật thấp hơn viết mã độc đánh cắp tệp ví, theo dõi bảng tạm, ghi lại bàn phím và các chức năng khác.

Thực hiện gian lận tự động: Tự động trả lời các nạn nhân tiềm năng và hướng dẫn họ tham gia vào các đợt airdrop hoặc dự án đầu tư giả mạo.

DarkBERT: Con dao hai lưỡi của nội dung dark web

DarkBERT là một mô hình ngôn ngữ được phát triển bởi các nhà nghiên cứu từ Viện Khoa học và Công nghệ Tiên tiến Hàn Quốc (KAIST) hợp tác với S2W Inc. Nó được đào tạo trước cụ thể trên dữ liệu dark web (chẳng hạn như diễn đàn, chợ đen và tài liệu bị rò rỉ). Mục đích ban đầu của nó là giúp các nhà nghiên cứu an ninh mạng và các cơ quan thực thi pháp luật hiểu rõ hơn về hệ sinh thái dark web, theo dõi các hoạt động bất hợp pháp, xác định các mối đe dọa tiềm ẩn và thu thập thông tin tình báo về mối đe dọa.

Mặc dù DarkBERT ban đầu được thiết kế với mục đích tích cực, nhưng nội dung nhạy cảm như dữ liệu, phương pháp tấn công, chiến lược giao dịch bất hợp pháp, v.v. trên dark web mà nó lưu giữ có thể bị các tác nhân độc hại lấy được hoặc được sử dụng để đào tạo các mô hình lớn không giới hạn bằng các công nghệ tương tự. Khả năng bị lạm dụng trong các tình huống mã hóa bao gồm:

Thực hiện gian lận chính xác:Thu thập thông tin về người dùng mã hóa và nhóm dự án để thực hiện gian lận kỹ thuật xã hội.

Bắt chước các phương pháp phạm tội:Sao chép các chiến lược trộm tiền xu và rửa tiền đã thành thạo trên dark web.

FraudGPT: Con dao quân đội Thụy Sĩ của gian lận trực tuyến

FraudGPT tự nhận là phiên bản nâng cấp của WormGPT với các chức năng toàn diện hơn. Nó chủ yếu được bán trên dark web và các diễn đàn hacker, với mức phí hàng tháng từ 200 đến 1.700 đô la Mỹ. Các phương pháp lạm dụng điển hình của nó trong các tình huống mã hóa bao gồm:

Các dự án mã hóa giả mạo:Tạo các báo cáo trắng, trang web chính thức, lộ trình và bản sao tiếp thị giả mạo cho ICO/IDO giả mạo.

Tạo hàng loạt các trang lừa đảo:Nhanh chóng tạo ra các bản sao của các trang đăng nhập sàn giao dịch tiền điện tử hoặc giao diện kết nối ví nổi tiếng.

Các hoạt động của đội quân nước trên mạng xã hội:Tạo hàng loạt các bình luận và tuyên truyền sai sự thật để quảng bá các mã thông báo gian lận hoặc làm mất uy tín của các dự án cạnh tranh.

Các cuộc tấn công kỹ thuật xã hội:Chatbot có thể bắt chước các cuộc trò chuyện của con người để xây dựng lòng tin với những người dùng không nghi ngờ, lừa họ vô tình tiết lộ thông tin nhạy cảm hoặc thực hiện các hành động có hại.

GhostGPT: Trợ lý AI không có ràng buộc về mặt đạo đức

GhostGPT là một chatbot AI được định vị rõ ràng là không có ràng buộc về mặt đạo đức. Các phương pháp lạm dụng điển hình của nó trong kịch bản mã hóa bao gồm:

Các cuộc tấn công lừa đảo nâng cao:Tạo email lừa đảo được mô phỏng ở mức độ cao, mạo danh các sàn giao dịch chính thống để đưa ra các yêu cầu xác minh KYC, cảnh báo bảo mật hoặc thông báo đóng băng tài khoản giả mạo.

Tạo mã độc hại cho hợp đồng thông minh:Không cần kiến thức lập trình, kẻ tấn công có thể sử dụng GhostGPT để nhanh chóng tạo ra các hợp đồng thông minh chứa các cửa hậu ẩn hoặc logic gian lận để lừa đảo Rug Pull hoặc tấn công các giao thức DeFi.

Kẻ đánh cắp tiền điện tử đa hình:Tạo ra phần mềm độc hại có khả năng biến dạng liên tục để đánh cắp các tệp ví, khóa riêng tư và mã ghi nhớ. Bản chất đa hình của nó khiến phần mềm bảo mật dựa trên chữ ký truyền thống khó có thể phát hiện.

Các cuộc tấn công kỹ thuật xã hội:Kết hợp với các tập lệnh thoại do AI tạo ra, kẻ tấn công có thể triển khai robot trên các nền tảng như Discord và Telegram để dụ người dùng tham gia vào các dự án đầu tư, airdrop hoặc đúc NFT giả mạo.

Gian lận giả mạo sâu:Kết hợp với các công cụ AI khác, GhostGPT có thể được sử dụng để tạo ra giọng nói giả mạo của những người sáng lập dự án tiền điện tử, nhà đầu tư hoặc giám đốc điều hành sàn giao dịch để thực hiện các cuộc tấn công lừa đảo qua điện thoại hoặc xâm phạm email doanh nghiệp (BEC).

Venice.ai: Rủi ro tiềm ẩn của quyền truy cập không bị kiểm duyệt

Venice.ai cung cấp quyền truy cập vào nhiều LLM khác nhau, bao gồm một số LLM ít bị kiểm duyệt hoặc hạn chế lỏng lẻo. Nó tự định vị mình là một cổng mở để người dùng khám phá khả năng của nhiều LLM khác nhau, cung cấp các mô hình tiên tiến nhất, chính xác nhất và không bị kiểm duyệt để đạt được trải nghiệm AI thực sự không giới hạn, nhưng nó cũng có thể bị những kẻ xấu sử dụng để tạo ra nội dung độc hại. Các rủi ro của nền tảng bao gồm:

Bỏ qua kiểm duyệt để tạo ra nội dung độc hại:Kẻ tấn công có thể sử dụng các mô hình ít bị hạn chế hơn trong nền tảng để tạo các mẫu lừa đảo, tuyên truyền sai sự thật hoặc tấn công ý tưởng.

Hạ thấp ngưỡng cho kỹ thuật nhắc nhở:Ngay cả khi kẻ tấn công không có kỹ năng nhắc nhở "bẻ khóa" nâng cao, hắn vẫn có thể dễ dàng lấy được đầu ra bị hạn chế ban đầu.

Tăng tốc độ lặp lại các kỹ thuật tấn công:Kẻ tấn công có thể sử dụng nền tảng để nhanh chóng kiểm tra phản ứng của các mô hình khác nhau đối với các hướng dẫn độc hại và tối ưu hóa các tập lệnh gian lận và phương pháp tấn công.

Viết ở phần cuối

Sự xuất hiện của LLM không giới hạn đánh dấu rằng bảo mật mạng đang phải đối mặt với một mô hình tấn công mới phức tạp hơn, có khả năng mở rộng hơn và tự động hơn. Kiểu mô hình này không chỉ hạ thấp ngưỡng tấn công mà còn mang đến những mối đe dọa mới bí mật và lừa đảo hơn.

Trong trò chơi tấn công và phòng thủ này đang tiếp tục leo thang, tất cả các bên trong hệ sinh thái bảo mật chỉ có thể đối phó với các rủi ro trong tương lai thông qua các nỗ lực hợp tác: một mặt, cần tăng cường đầu tư vào công nghệ phát hiện và phát triển các công nghệ có thể xác định và chặn nội dung lừa đảo, khai thác lỗ hổng hợp đồng thông minh và mã độc do LLM độc hại tạo ra; mặt khác, cũng cần thúc đẩy việc xây dựng các khả năng chống bẻ khóa mô hình và khám phá các cơ chế hình mờ và truy xuất nguồn gốc để theo dõi nguồn nội dung độc hại trong các tình huống quan trọng như tài chính và tạo mã; ngoài ra, cần thiết lập các chuẩn mực đạo đức và cơ chế quản lý hợp lý để hạn chế sự phát triển và lạm dụng các mô hình độc hại từ gốc rễ.

Kikyo

Kikyo