Biên soạn bởi: Jiayu, Cage

< p style="text-align: left;">AI Agent là một sự thay đổi mô hình mà chúng tôi theo dõi chặt chẽ, loạt bài viết của Langchain rất hữu ích để hiểu rõ. Xu hướng đại lý rất hữu ích. Trong phần tổng hợp này, phần đầu tiên là báo cáo Trạng thái Tác nhân AI do nhóm Langchain phát hành. Họ đã phỏng vấn hơn 1.300 học viên, bao gồm các nhà phát triển, giám đốc sản phẩm và giám đốc điều hành công ty, tiết lộ tình hình hiện tại và những điểm nghẽn trong quá trình triển khai Đại lý trong năm nay:

90% công ty có kế hoạch và nhu cầu về Đại lý AI, nhưng khả năng của Đại lý thì chưa Hạn chế cho phép người dùng chỉ thực hiện nó trong một số quy trình và tình huống. Thay vì chi phí và độ trễ, mọi người quan tâm nhiều hơn đến việc cải thiện khả năng của Tác nhân cũng như khả năng quan sát và kiểm soát hành vi của nó. Trong phần thứ hai, chúng tôi đã tổng hợp phân tích các yếu tố chính của Tác nhân AI trong loạt bài viết In the Loop trên trang web chính thức của LangChain : Khả năng lập kế hoạch, đổi mới tương tác UI/UX và cơ chế bộ nhớ. Bài viết này phân tích các phương thức tương tác của 5 sản phẩm có nguồn gốc LLM, tương tự hóa 3 cơ chế bộ nhớ phức tạp của con người và cung cấp một số nguồn cảm hứng để hiểu về Tác nhân AI cũng như các yếu tố chính này. Trong phần này, chúng tôi cũng đã bổ sung thêm một số nghiên cứu điển hình của công ty Đại lý đại diện, chẳng hạn như các cuộc phỏng vấn với những người sáng lập Reflection AI, để hướng tới những bước đột phá quan trọng của Đại lý AI vào năm 2025.

Trong khuôn khổ phân tích này, chúng tôi kỳ vọng rằng các ứng dụng Tác nhân AI sẽ bắt đầu xuất hiện vào năm 2025, bước vào một mô hình mới về cộng tác giữa con người và máy móc. Về khả năng lập kế hoạch của AI Agent, các mô hình do o3 dẫn đầu đang thể hiện khả năng phản ánh và suy luận mạnh mẽ, đồng thời sự tiến bộ của các công ty mô hình đang tiến gần đến giai đoạn Agent từ nhà lý luận. Khi khả năng suy luận tiếp tục được cải thiện, “dặm cuối” của Agent sẽ là cơ chế tương tác và ghi nhớ sản phẩm, nhiều khả năng sẽ là cơ hội để các công ty khởi nghiệp bứt phá. Về tương tác, chúng tôi đã mong chờ “thời điểm GUI” trong kỷ nguyên AI; liên quan đến bộ nhớ, chúng tôi tin rằng Ngữ cảnh sẽ trở thành từ khóa để triển khai Cá nhân hóa Ngữ cảnh ở cấp độ cá nhân và thống nhất ngữ cảnh ở cấp độ cá nhân. cấp doanh nghiệp sẽ cải thiện đáng kể trải nghiệm sản phẩm của Đại lý.

01. Xu hướng sử dụng tác nhân:

Các công ty đều có ý định triển khai Agent

Sự cạnh tranh trong lĩnh vực Agent đang trở nên khốc liệt. Trong năm qua, nhiều khung tác nhân đã trở nên phổ biến: ví dụ như sử dụng ReAct kết hợp với LLM để suy luận và hành động, sử dụng khung đa tác nhân để điều phối hoặc sử dụng các khung có thể kiểm soát nhiều hơn như LangGraph.

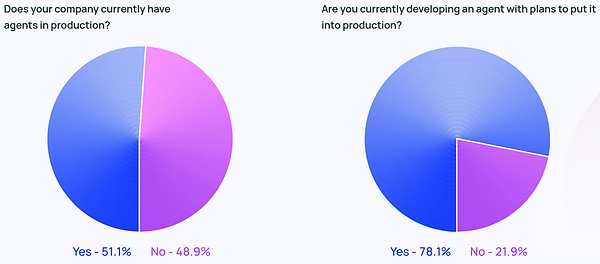

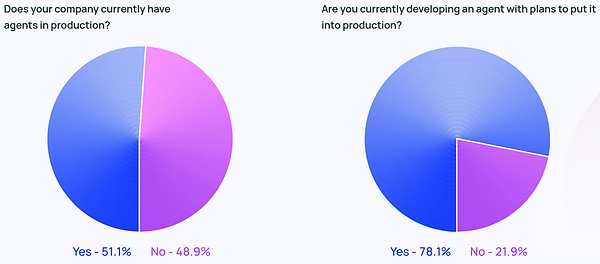

Tin đồn xung quanh Đặc vụ không chỉ là sự cường điệu hóa trên Twitter. Khoảng 51% số người được hỏi hiện đang sử dụng Đại lý trong sản xuất. Theo dữ liệu của Langchain theo quy mô công ty, các công ty có quy mô trung bình với 100-2000 nhân viên là những người tích cực nhất trong việc đưa Đại lý vào sản xuất, với tỷ lệ 63%.

Ngoài ra, 78% số người được hỏi có kế hoạch đưa Agent vào sản xuất trong thời gian tới. Rõ ràng, mọi người đều rất quan tâm đến AI Agent, nhưng thực sự việc tạo ra một Agent sẵn sàng sản xuất vẫn là một bài toán khó đối với nhiều người.

Mặc dù ngành công nghệ thường được coi là những ngành sớm áp dụng Đại lý nhưng sự quan tâm đến Đại lý đang tăng lên ở tất cả các ngành. 90% số người được hỏi làm việc cho các công ty phi công nghệ đã đưa hoặc có kế hoạch đưa đại lý vào sản xuất (tỷ lệ gần tương đương với các công ty công nghệ, 89%).

Các trường hợp sử dụng phổ biến nhất của Tác nhân

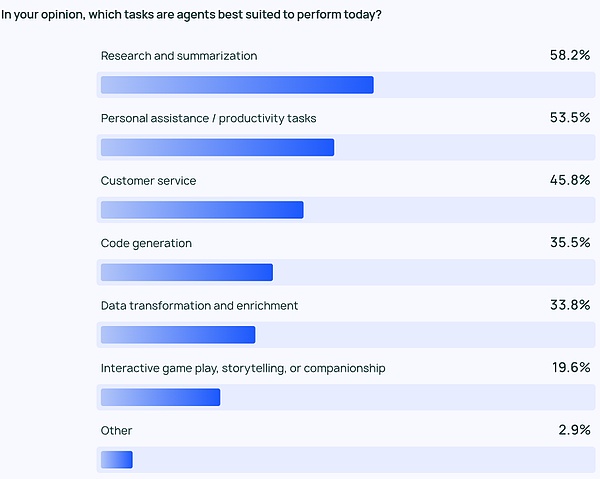

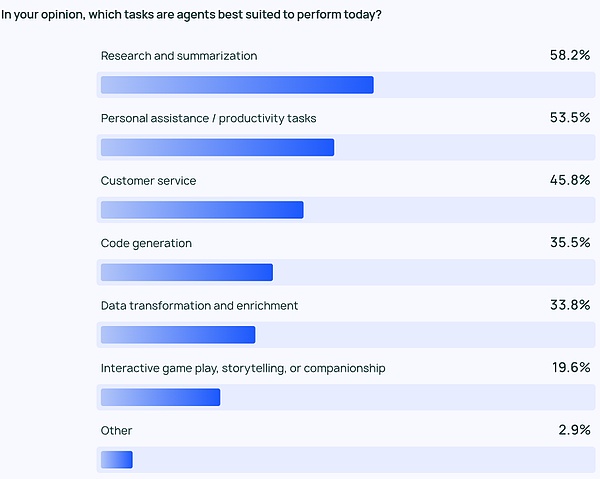

Các trường hợp sử dụng phổ biến nhất của Tác nhân các trường hợp sử dụng đã sử dụng Các trường hợp sử dụng bao gồm tiến hành nghiên cứu và tóm tắt (58%), tiếp theo là đơn giản hóa quy trình làm việc thông qua các tác nhân tùy chỉnh (53,5%).

Những điều này phản ánh mong muốn của mọi người về sản phẩm có thể xử lý các công việc quá tốn thời gian. Người dùng có thể dựa vào AI Agent để trích xuất thông tin quan trọng và hiểu biết sâu sắc từ lượng lớn thông tin, thay vì tự mình sàng lọc lượng dữ liệu khổng lồ rồi tiến hành đánh giá hoặc phân tích nghiên cứu dữ liệu. Tương tự như vậy, Đại lý AI có thể tăng năng suất cá nhân bằng cách hỗ trợ các công việc hàng ngày, cho phép người dùng tập trung vào những vấn đề quan trọng.

Không chỉ các cá nhân cần loại hình cải thiện hiệu quả này mà các công ty và nhóm cũng cần nó. Dịch vụ khách hàng (45,8%) là một lĩnh vực ứng dụng chính khác của Đại lý giúp các công ty xử lý việc tư vấn, khắc phục sự cố và tăng tốc thời gian phản hồi của khách hàng giữa các nhóm xếp thứ tư và thứ năm là các ứng dụng dữ liệu và mã cấp thấp hơn.

Giám sát: Các ứng dụng tác nhân yêu cầu khả năng quan sát và kiểm soát

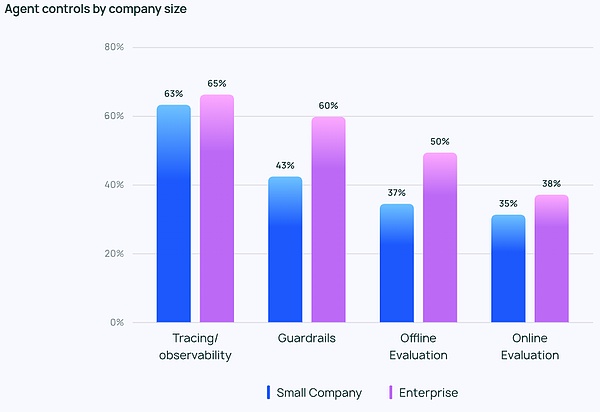

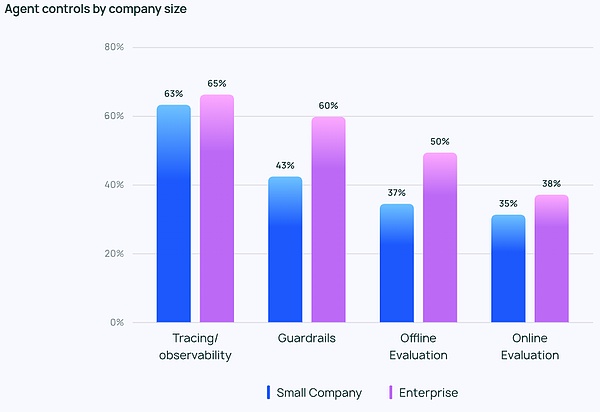

Khi việc triển khai Tác nhân trở nên mạnh mẽ hơn, Các phương pháp quản lý và giám sát Tác nhân. Các công cụ theo dõi và quan sát đứng đầu danh sách bắt buộc phải có để giúp các nhà phát triển hiểu được hành vi và hiệu suất của các tổng đài viên. Nhiều công ty cũng sử dụng lan can (kiểm soát bảo vệ) để ngăn chặn các đại lý đi chệch hướng.

Khi thử nghiệm các ứng dụng LLM, đánh giá ngoại tuyến (39,8%) được sử dụng thường xuyên hơn đánh giá trực tuyến (32,5%), phản ánh khó khăn trong việc giám sát LLM trong thời gian thực. Trong số các phản hồi mở do LangChain cung cấp, nhiều công ty cũng nhờ các chuyên gia con người xem xét hoặc đánh giá các phản hồi theo cách thủ công như một lớp phòng ngừa bổ sung.

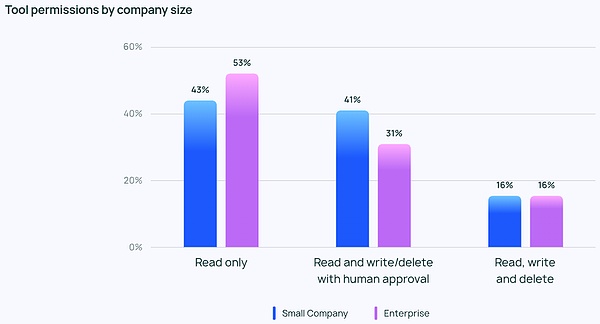

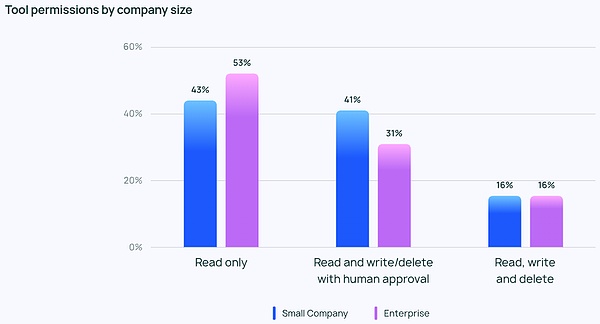

Mặc dù mọi người rất nhiệt tình với Đại lý nhưng nhìn chung họ vẫn thận trọng khi nói đến quyền của Đại lý. Rất ít người trả lời cho phép đại lý của họ đọc, viết và xóa một cách tự do. Thay vào đó, hầu hết các nhóm chỉ cho phép quyền công cụ có quyền truy cập đọc hoặc yêu cầu sự chấp thuận của con người trước khi tác nhân có thể thực hiện các hành động rủi ro hơn như viết hoặc xóa.

Các công ty có quy mô khác nhau cũng có những ưu tiên khác nhau trong việc kiểm soát Đại lý. Không có gì đáng ngạc nhiên khi các doanh nghiệp lớn (hơn 2.000 nhân viên) thận trọng hơn và phụ thuộc nhiều vào quyền “chỉ đọc” để tránh những rủi ro không đáng có. Họ cũng có xu hướng kết hợp việc bảo vệ lan can với đánh giá ngoại tuyến, không muốn khách hàng thấy bất kỳ vấn đề nào.

Trong khi đó, các công ty nhỏ hơn và công ty khởi nghiệp (dưới 100 nhân viên) tập trung hơn vào việc theo dõi để hiểu những gì đang xảy ra trong ứng dụng Đại lý của họ (thay vì các biện pháp kiểm soát khác). Theo dữ liệu khảo sát của LangChain, các công ty nhỏ hơn có xu hướng tập trung vào việc xem xét dữ liệu để hiểu kết quả; trong khi các doanh nghiệp lớn hơn có nhiều biện pháp kiểm soát hơn trên diện rộng.

Những trở ngại và thách thức trong việc đưa Đại lý vào sản xuất

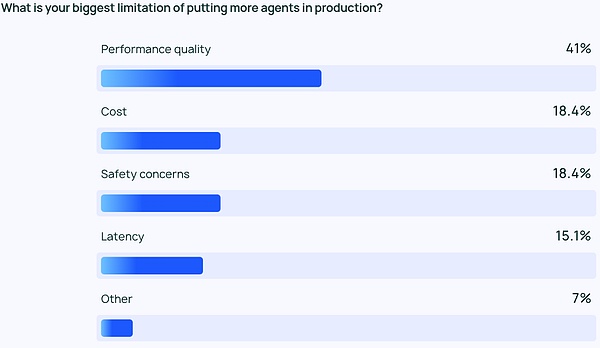

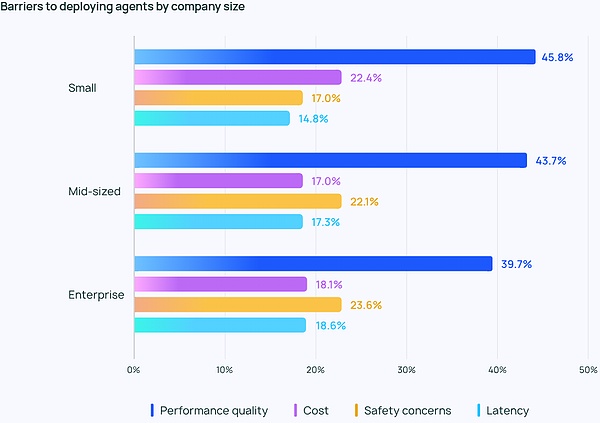

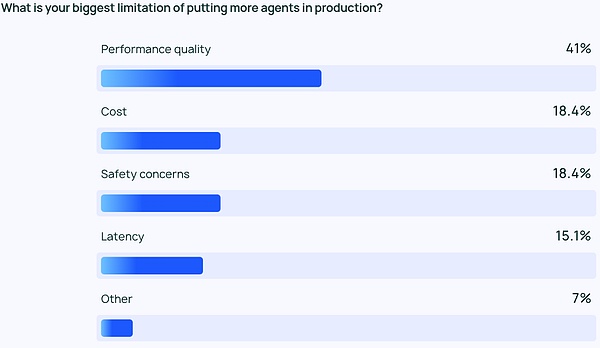

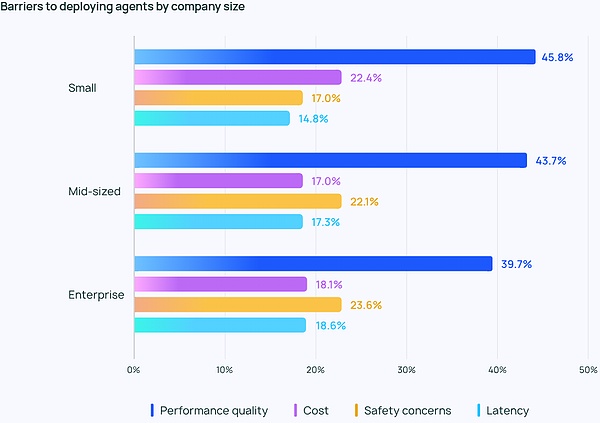

Đảm bảo chất lượng cao của LLM Hiệu suất Rất khó. Câu trả lời cần phải có độ chính xác cao và phù hợp với phong cách đúng đắn. Đây là mối quan tâm lớn nhất của các nhà phát triển và người dùng Agent - quan trọng hơn gấp đôi so với chi phí, bảo mật và các yếu tố khác.

Tác nhân LLM là đầu ra nội dung mang tính xác suất, có nghĩa là có tính khó đoán cao. Điều này tạo ra nhiều khả năng xảy ra lỗi hơn, khiến các nhóm gặp khó khăn trong việc đảm bảo tổng đài viên của họ luôn đưa ra phản hồi chính xác, phù hợp với ngữ cảnh.

Điều này đặc biệt đúng đối với các công ty nhỏ hơn, nơi chất lượng hoạt động vượt xa các cân nhắc khác, với 45,8% cho rằng đây là mối quan tâm hàng đầu, so với chi phí (mối quan tâm lớn thứ hai) chỉ ở mức 22,4%. Khoảng cách này nhấn mạnh tầm quan trọng của hiệu suất đáng tin cậy, chất lượng cao đối với các tổ chức chuyển Đại lý từ giai đoạn phát triển sang sản xuất.

Các vấn đề bảo mật cũng phổ biến đối với các công ty lớn yêu cầu tuân thủ nghiêm ngặt và xử lý dữ liệu khách hàng một cách nhạy cảm.

Thử thách không dừng lại ở chất lượng. Từ những câu trả lời mở mà LangChain đưa ra, nhiều người vẫn hoài nghi về việc liệu công ty có tiếp tục đầu tư phát triển và thử nghiệm Đại lý hay không. Mọi người đều đề cập đến hai trở ngại nổi bật: việc phát triển Đại lý đòi hỏi nhiều kiến thức và cập nhật các xu hướng công nghệ; việc phát triển và triển khai Đại lý đòi hỏi nhiều thời gian và chi phí, lợi ích của việc vận hành đáng tin cậy là không chắc chắn.

Các chủ đề mới nổi khác

Trong các câu hỏi mở, Có rất nhiều lời khen ngợi về khả năng mà Tác nhân AI thể hiện:

Quản lý các tác vụ nhiều bước: Tác nhân AI có thể thực hiện lý luận sâu hơn và quản lý bối cảnh, Cho phép họ xử lý các tác vụ phức tạp hơn;

→ Tự động hóa các tác vụ lặp đi lặp lại: Tác nhân AI tiếp tục được coi là chìa khóa để xử lý các tác vụ tự động, có thể giải phóng thời gian của người dùng để giải quyết các vấn đề sáng tạo hơn;

→ Lập kế hoạch và cộng tác nhiệm vụ: Lập kế hoạch nhiệm vụ tốt hơn đảm bảo rằng nhân viên phù hợp xử lý đúng vấn đề vào đúng thời điểm, đặc biệt là trong các hệ thống nhiều tác nhân;

>> Lý luận giống con người: Không giống như LLM truyền thống, Tác nhân AI có thể đưa ra quyết định trước đó, bao gồm xem xét và sửa đổi các quyết định trước đây dựa trên thông tin mới.

Ngoài ra, có hai diễn biến được mọi người mong chờ nhất:

→ Kỳ vọng về nguồn mở đối với Tác nhân AI: Mọi người rõ ràng quan tâm đến Tác nhân AI nguồn mở và nhiều người đã đề cập rằng trí tuệ tập thể có thể đẩy nhanh quá trình đổi mới của Tác nhân;

• Để có những kỳ vọng về Mô hình mạnh mẽ hơn: Nhiều người đang mong đợi Tác nhân AI được điều khiển bởi các mô hình lớn hơn và mạnh mẽ hơn Bước nhảy vọt tiếp theo—khi Đại lý có thể xử lý các nhiệm vụ phức tạp hơn với hiệu quả và quyền tự chủ cao hơn.

Nhiều người trong phần Hỏi đáp cũng đề cập đến thách thức lớn nhất khi phát triển Tác nhân: làm thế nào để hiểu hành vi của Tác nhân. Một số kỹ sư cho biết họ gặp khó khăn trong việc giải thích khả năng và hành vi của Tác nhân AI cho các bên liên quan của công ty. Đôi khi các phần bổ trợ trực quan hóa có thể giúp giải thích hành vi của Tác nhân, nhưng trong nhiều trường hợp, LLM vẫn là một hộp đen. Gánh nặng về khả năng diễn giải bổ sung được giao cho nhóm kỹ thuật.

02.Các yếu tố cốt lõi trong AI Agent

Hệ thống Agentic là gì

Trước khi phát hành báo cáo Trạng thái của Tác nhân AI, nhóm Langchain đã viết trong lĩnh vực Đại lý đã phát triển khung Langraph của riêng mình và thảo luận rất nhiều về AI thông qua blog In the Loop Các thành phần chính trong Agent, bước tiếp theo là chúng ta tổng hợp các nội dung chính.

Trước hết, mọi người đều có định nghĩa hơi khác nhau về Tác nhân AI, Harrison Chase, người sáng lập LangChain, đưa ra định nghĩa sau:

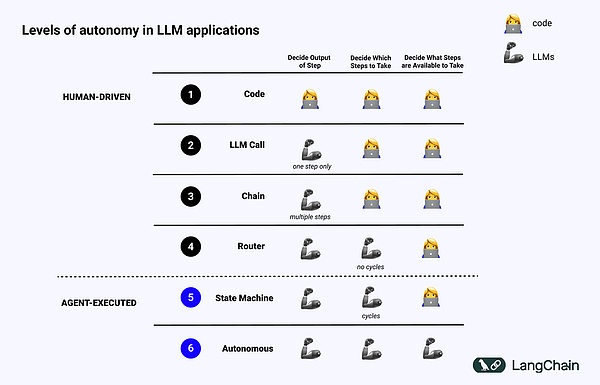

AI Agent là một hệ thống sử dụng LLM để đưa ra các quyết định về luồng điều khiển chương trình.

Tác nhân AI là một hệ thống sử dụng LLM để quyết định luồng điều khiển của ứng dụng.

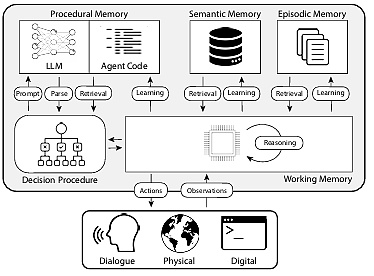

Về cách triển khai, bài viết giới thiệu khái niệm về Kiến trúc nhận thức đề cập đến cách Tác nhân suy nghĩ và cách hệ thống sắp xếp mã/lời nhắc LLM:

→ Nhận thức: Tác nhân sử dụng LLM để suy luận về mặt ngữ nghĩa về cách sắp xếp mã/Prompt LLM;

Kiến trúc: Các hệ thống Tác nhân này vẫn liên quan đến nhiều kỹ thuật tương tự như kiến trúc hệ thống truyền thống.

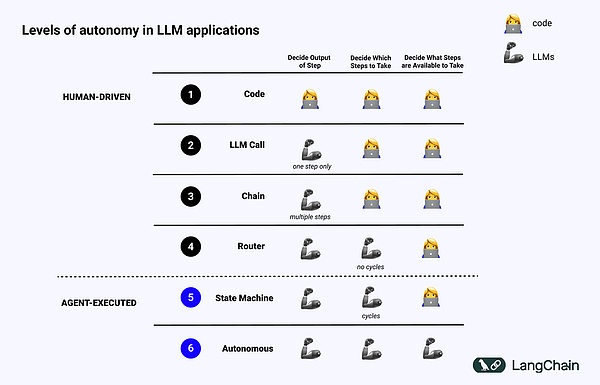

Hình ảnh bên dưới hiển thị các ví dụ về các cấp độ khác nhau của Kiến trúc nhận thức:

→ Mã phần mềm (mã) được tiêu chuẩn hóa: Mọi thứ đều là Mã cứng , các tham số liên quan của đầu ra hoặc đầu vào được cố định trực tiếp trong mã nguồn. Điều này không tạo thành một kiến trúc nhận thức vì không có phần nhận thức;

^ Cuộc gọi LLM, ngoại trừ một số quá trình xử lý trước dữ liệu, một cuộc gọi LLM duy nhất cấu thành hầu hết ứng dụng và Chatbot đơn giản thuộc danh mục này;

Chain : Một loạt các cuộc gọi LLM, Chain Cố gắng chia giải pháp của vấn đề thành nhiều bước và gọi các LLM khác nhau để giải quyết vấn đề. Các RAG phức tạp thuộc loại này: LLM đầu tiên được gọi để tìm kiếm và truy vấn, còn LLM thứ hai được gọi để tạo ra câu trả lời;

Router : Trong ba hệ thống trước, người dùng có thể biết trước tất cả các bước mà chương trình sẽ thực hiện, nhưng trong Bộ định tuyến, LLM tự quyết định nên gọi LLM nào và thực hiện những bước nào, điều này làm tăng thêm tính ngẫu nhiên và khó đoán

→ State Machine, việc kết hợp LLM với Router sẽ càng khó đoán hơn, vì kết hợp với điều này thành một vòng lặp, hệ thống có thể (về mặt lý thuyết) thực hiện các cuộc gọi LLM không giới hạn ;→ Hệ thống Agent: mọi người còn gọi là "Autonomous Agent" và sử dụng State Machine Vẫn có những hạn chế về những hành động có thể được thực hiện và những quy trình nào được thực hiện sau khi thực hiện hành động đó; những hạn chế này sẽ được loại bỏ khi sử dụng Tác nhân tự trị. LLM để quyết định những bước cần thực hiện và cách phối hợp các LLM khác nhau. Điều này có thể được thực hiện bằng cách sử dụng các lời nhắc, công cụ hoặc mã khác nhau.

Nói một cách đơn giản, hệ thống càng có tính "tác nhân" thì LLM càng xác định cách hệ thống hoạt động.

Các yếu tố chính của tác nhân

Lập kế hoạch< /strong>

Độ tin cậy của tác nhân là một điểm yếu lớn. Thường có những công ty sử dụng LLM để xây dựng Đại lý nhưng đề cập rằng Đại lý không thể lập kế hoạch và lý luận tốt. Lập kế hoạch và lý luận ở đây có ý nghĩa gì?

Việc lập kế hoạch và lý luận của Đại lý đề cập đến khả năng suy nghĩ của LLM về những hành động cần thực hiện. Điều này liên quan đến lý luận ngắn hạn và dài hạn, trong đó LLM đánh giá tất cả thông tin có sẵn và sau đó quyết định: Tôi cần thực hiện chuỗi bước nào và đâu là bước đầu tiên tôi nên thực hiện ngay bây giờ?

Nhiều khi các nhà phát triển sử dụng chức năng gọi hàm để cho LLM chọn thao tác cần thực hiện. Gọi hàm là khả năng mà OpenAI lần đầu tiên thêm vào API LLM vào tháng 6 năm 2023. Thông qua Gọi hàm, người dùng có thể cung cấp cấu trúc JSON cho các hàm khác nhau và để LLM khớp với một (hoặc nhiều) cấu trúc này.

Để hoàn thành thành công một nhiệm vụ phức tạp, hệ thống cần thực hiện một loạt hành động theo trình tự. Kiểu lập kế hoạch và lý luận dài hạn này rất phức tạp đối với LLM: thứ nhất, LLM phải xem xét một kế hoạch hành động dài hạn, sau đó quay lại các hành động ngắn hạn sẽ thực hiện thứ hai, khi Đại lý thực hiện ngày càng nhiều hoạt động; , kết quả của các thao tác sẽ được phản hồi trở lại LLM, khiến cửa sổ ngữ cảnh mở rộng, điều này có thể khiến LLM "phân tâm" và hoạt động kém.

Giải pháp đơn giản nhất để cải thiện việc lập kế hoạch là đảm bảo rằng LLM có tất cả thông tin cần thiết để lập kế hoạch/lập luận phù hợp. Mặc dù điều này nghe có vẻ đơn giản nhưng thông tin được chuyển đến LLM thường không đủ để LLM đưa ra quyết định hợp lý và việc thêm bước truy xuất hoặc làm rõ Lời nhắc có thể là một cải tiến đơn giản.

Sau đó, bạn có thể xem xét việc thay đổi kiến trúc nhận thức của ứng dụng của mình. Có hai loại kiến trúc nhận thức để cải thiện khả năng suy luận, kiến trúc nhận thức chung và kiến trúc nhận thức theo miền cụ thể:

1.

Kiến trúc nhận thức chung có thể được áp dụng cho bất kỳ nhiệm vụ nào. Có hai bài viết ở đây đề xuất hai kiến trúc chung. Một là kiến trúc "lập kế hoạch và giải quyết", được đề xuất trong bài viết Nhắc nhở lập kế hoạch và giải quyết: Cải thiện lý luận chuỗi tư duy không bắn bằng các mô hình ngôn ngữ lớn. kiến trúc, trước tiên tác nhân đề xuất một kế hoạch và sau đó thực hiện từng bước trong kế hoạch. Một kiến trúc phổ biến khác là kiến trúc Phản xạ, được đề xuất trong Phản xạ: Tác nhân ngôn ngữ với việc học tăng cường bằng lời nói. Trong kiến trúc này, có một bước "phản ánh" rõ ràng sau khi Tác nhân thực hiện nhiệm vụ để phản ánh xem nó có thực hiện đúng nhiệm vụ hay không. Tôi sẽ không đi vào chi tiết ở đây, nhưng bạn có thể đọc hai bài báo để biết chi tiết.

Mặc dù những ý tưởng này cho thấy những cải tiến nhưng chúng thường quá chung chung để được Đại lý thực sự sử dụng trong sản xuất. (Lưu ý của người dịch: Không có mô hình loạt o1 khi bài viết này được xuất bản)

2. Kiến trúc nhận thức trong các lĩnh vực cụ thể

Thay vào đó, chúng tôi thấy rằng Tác nhân được xây dựng bằng kiến trúc nhận thức dành riêng cho từng miền. Điều này thường thể hiện ở các bước lập kế hoạch/phân loại theo miền cụ thể, các bước xác thực theo miền cụ thể. Một số ý tưởng từ việc lập kế hoạch và phản ánh có thể được áp dụng ở đây, nhưng chúng thường được áp dụng theo cách cụ thể theo từng lĩnh vực.

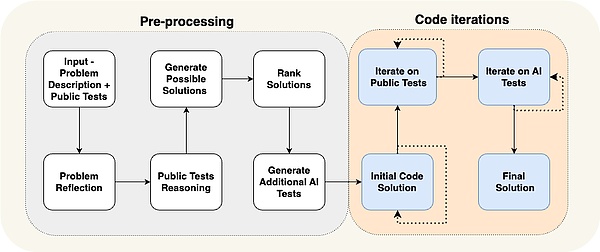

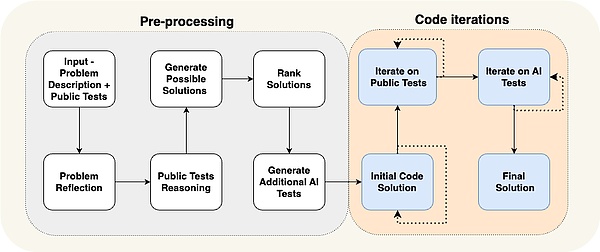

Một bài báo của AlphaCodium đưa ra một ví dụ cụ thể: bằng cách sử dụng cái mà họ gọi là "kỹ thuật truyền phát" (một cách khác để nói về kiến trúc nhận thức) State-of-the- biểu diễn nghệ thuật đạt được.

Bạn có thể thấy rằng quy trình của Đại lý rất cụ thể đối với vấn đề mà họ đang cố gắng giải quyết. Họ yêu cầu Tác nhân phải làm gì theo các bước: đưa ra các thử nghiệm, sau đó đưa ra các giải pháp, sau đó lặp lại với nhiều thử nghiệm hơn, v.v. Kiến trúc nhận thức này tập trung cao độ vào một lĩnh vực cụ thể và không thể khái quát hóa sang các lĩnh vực khác.

Nghiên cứu điển hình:

Phản ánh Người sáng lập AI Laskin Tầm nhìn về tương lai của Đặc vụ

Phản ánh Người sáng lập AI Misha tại Sequoia Capital Trong một cuộc phỏng vấn với Laskin, Misha Đề cập rằng anh ấy đang bắt đầu hiện thực hóa tầm nhìn của mình về việc xây dựng các mô hình đại lý tốt nhất trong công ty mới của mình, Reflection AI, bằng cách kết hợp khả năng tìm kiếm của RL với LLM. Anh và người đồng sáng lập Ioannis Antonoglou (người đứng đầu AlphaGo, AlphaZero, Gemini RLHF) là những mô hình đào tạo được thiết kế cho Agentic Workflows. Các điểm chính trong cuộc phỏng vấn như sau:

•Chiều sâu là phần còn thiếu trong AI Agent. Mặc dù các mô hình ngôn ngữ hiện tại vượt trội về bề rộng nhưng lại thiếu chiều sâu cần thiết để hoàn thành nhiệm vụ một cách đáng tin cậy. Laskin tin rằng việc giải quyết "các vấn đề sâu sắc" là rất quan trọng để tạo ra các tác nhân AI thực sự có năng lực, trong đó khả năng đề cập đến các tác nhân có thể lập kế hoạch và thực hiện các nhiệm vụ phức tạp thông qua nhiều bước;

• Kết hợp Học và Tìm kiếm là chìa khóa để đạt được hiệu suất siêu phàm. Dựa trên thành công của AlphaGo, Laskin nhấn mạnh ý tưởng sâu sắc nhất trong AI là sự kết hợp giữa Học (dựa vào LLM) và Tìm kiếm (tìm ra con đường tối ưu). Cách tiếp cận này rất quan trọng trong việc tạo ra các tác nhân có thể làm tốt hơn con người trong các nhiệm vụ phức tạp;

→Việc lập mô hình khen thưởng và đào tạo sau đào tạo mang lại thách thức đáng kể. Không giống như những trò chơi có phần thưởng rõ ràng, nhiệm vụ trong thế giới thực thường thiếu phần thưởng thực sự. Phát triển các mô hình phần thưởng đáng tin cậy là thách thức chính trong việc tạo ra các Đại lý AI đáng tin cậy

Các Đại lý Toàn cầu có thể đến gần hơn chúng ta nghĩ. Laskin ước tính rằng chúng ta có thể chỉ có ba năm để đạt được “AGI kỹ thuật số”, hệ thống AI có cả chiều rộng và chiều sâu. Dòng thời gian được tăng tốc này nêu bật tính cấp thiết của việc giải quyết các vấn đề về bảo mật và độ tin cậy trong khi phát triển khả năng

Hướng tới các đại lý toàn cầu. Con đường cần có phương pháp. Reflection AI tập trung vào việc mở rộng chức năng của Tác nhân, bắt đầu từ một số môi trường cụ thể, chẳng hạn như trình duyệt, mã hóa và hệ điều hành máy tính. Mục tiêu của họ là phát triển các Đại lý toàn cầu không giới hạn ở các nhiệm vụ cụ thể.

Tương tác UI/UX

Trong vài năm tới Tương tác giữa con người và máy tính sẽ trở thành một lĩnh vực nghiên cứu trọng điểm: Hệ thống Agent khác với hệ thống máy tính truyền thống trước đây bởi độ trễ, không đáng tin cậy và giao diện ngôn ngữ tự nhiên mang đến những thách thức mới. Do đó, các mô hình UI/UX mới để tương tác với các ứng dụng Tác nhân này sẽ xuất hiện. Hệ thống đại lý vẫn đang ở giai đoạn đầu, nhưng đã có một số mô hình UX mới nổi. Thảo luận riêng bên dưới:

1. Tương tác hội thoại (Giao diện người dùng trò chuyện)

Trò chuyện thường được chia thành hai loại: trò chuyện trực tuyến và trò chuyện không phát trực tuyến.

Trò chuyện trực tuyến cho đến nay là UX phổ biến nhất. Đó là một Chatbot truyền lại suy nghĩ và hành động của nó ở định dạng trò chuyện - ChatGPT là ví dụ phổ biến nhất. Hình thức tương tác này tưởng chừng đơn giản nhưng cũng mang lại kết quả tốt vì: thứ nhất, ngôn ngữ tự nhiên có thể được sử dụng để nói chuyện với LLM, nghĩa là không có trở ngại nào giữa khách hàng và LLM thứ hai, LLM có thể mất một thời gian để hoạt động; , Phát trực tuyến cho phép người dùng hiểu chính xác những gì đang diễn ra trong nền; thứ ba, LLM thường mắc lỗi và Trò chuyện cung cấp một giao diện tuyệt vời để sửa và hướng dẫn nó một cách tự nhiên và mọi người đã quen với việc có các cuộc trò chuyện và lặp lại tiếp theo trong trò chuyện. đồ đạc.

Nhưng trò chuyện trực tuyến cũng có những hạn chế. Đầu tiên, trò chuyện trực tuyến là một trải nghiệm người dùng tương đối mới, vì vậy các nền tảng trò chuyện hiện tại của chúng tôi (iMessage, Facebook Messenger, Slack, v.v.) không có tính năng này; chỉ cần ngồi đó và xem Đặc vụ hoạt động? Thứ ba, trò chuyện trực tuyến thường cần được kích hoạt bởi con người, điều đó có nghĩa là cần rất nhiều người trong vòng lặp.

Sự khác biệt lớn nhất trong cuộc trò chuyện không phát trực tuyến là các câu trả lời được trả về theo đợt, LLM hoạt động ở chế độ nền và người dùng không muốn LLM trả lời ngay lập tức, điều đó có nghĩa là có thể dễ dàng tích hợp vào quy trình công việc hiện có hơn. Mọi người đã quen với việc nhắn tin cho con người – tại sao họ không thể thích nghi với việc nhắn tin bằng AI? Trò chuyện không phát trực tuyến sẽ giúp tương tác với các hệ thống Đại lý phức tạp hơn dễ dàng hơn—việc này thường mất một khoảng thời gian và có thể gây khó chịu nếu cần có phản hồi ngay lập tức. Trò chuyện không phát trực tuyến thường loại bỏ kỳ vọng này, giúp thực hiện những việc phức tạp hơn dễ dàng hơn.

Hai phương thức trò chuyện này có những ưu điểm và nhược điểm sau:

2. Môi trường nền (Ambient UX)

< p style="văn bản-căn chỉnh: left;">Người dùng sẽ cân nhắc việc gửi tin nhắn tới AI, tức là Chat đã đề cập ở trên, nhưng nếu Tác nhân chỉ hoạt động ở chế độ nền thì chúng ta tương tác với Tác nhân như thế nào? Để các hệ thống Đại lý thực sự phát huy được tiềm năng của mình, cần có sự thay đổi này cho phép AI hoạt động ở chế độ nền. Người dùng thường chấp nhận thời gian hoàn thành lâu hơn khi các tác vụ được xử lý ở chế độ nền (vì họ không còn kỳ vọng vào độ trễ thấp). Điều này giúp Tác nhân rảnh tay để thực hiện nhiều công việc hơn và thường suy luận cẩn thận và chăm chỉ hơn so với trong UX trò chuyện.

Ngoài ra, việc chạy Tác nhân ở chế độ nền có thể mở rộng khả năng của người dùng con người của chúng tôi. Giao diện trò chuyện thường giới hạn chúng ta làm một nhiệm vụ tại một thời điểm. Tuy nhiên, nếu Tác nhân đang chạy trong môi trường nền, có thể có nhiều Tác nhân xử lý nhiều tác vụ cùng lúc.

Việc để Tác nhân chạy ở chế độ nền cần có sự tin tưởng của người dùng. Làm cách nào để thiết lập sự tin cậy này? Một ý tưởng đơn giản: Cho người dùng thấy chính xác những gì Tác nhân đang làm. Hiển thị tất cả các bước nó đang thực hiện và cho phép người dùng quan sát những gì đang xảy ra. Mặc dù các bước này có thể không hiển thị ngay lập tức (như khi truyền phát phản hồi), nhưng nó phải có sẵn để người dùng nhấp vào và quan sát. Bước tiếp theo là không chỉ cho phép người dùng xem điều gì đang xảy ra mà còn cho phép họ sửa Tác nhân. Nếu họ phát hiện ra rằng Đại lý đã đưa ra lựa chọn sai ở Bước 4 trên 10, khách hàng có tùy chọn quay lại Bước 4 và sửa Đại lý theo cách nào đó.

Phương pháp này chuyển người dùngtừ “trong vòng lặp” sang “trong vòng lặp”. Tính năng trực tiếp yêu cầu có thể hiển thị cho người dùng tất cả các bước trung gian do Tác nhân thực hiện, cho phép người dùng tạm dừng quy trình làm việc giữa chừng, cung cấp phản hồi và sau đó để Tác nhân tiếp tục.

AI Software Engineer Devin là một ứng dụng triển khai UX tương tự. Devin mất nhiều thời gian hơn để chạy, nhưng khách hàng có thể xem tất cả các bước đã thực hiện, tua lại trạng thái phát triển tại một thời điểm cụ thể và đưa ra các chỉnh sửa từ đó. Mặc dù Tác nhân có thể đang chạy ở chế độ nền nhưng điều này không có nghĩa là nó cần thực hiện các tác vụ một cách hoàn toàn tự chủ. Đôi khi Tác nhân không biết phải làm gì hoặc phản hồi như thế nào, lúc đó Tác nhân cần thu hút sự chú ý của con người và yêu cầu trợ giúp.

Một ví dụ cụ thể là Trợ lý email mà Harrison đang xây dựng. Mặc dù trợ lý email có thể trả lời các email cơ bản, nhưng nó thường yêu cầu Harrison nhập một số nhiệm vụ mà anh không muốn tự động hóa, bao gồm: xem xét các báo cáo lỗi LangChain phức tạp, quyết định xem có nên tham dự cuộc họp hay không, v.v. Trong trường hợp này, trợ lý email cần một cách để liên lạc với Harrison rằng nó cần thông tin để phản hồi. Lưu ý rằng nó không yêu cầu một câu trả lời trực tiếp; thay vào đó, nó yêu cầu Harrison cho ý kiến của anh ấy về một số nhiệm vụ nhất định, sau đó nó có thể sử dụng để tạo và gửi một email hay lên lịch mời.

Hiện tại, Harrison đã thiết lập trợ lý trong Slack. Nó gửi một câu hỏi tới Harrison, người sẽ trả lời câu hỏi đó trong Bảng điều khiển, được tích hợp nguyên bản với quy trình làm việc của nó. Loại UX này tương tự như UX của bảng thông tin hỗ trợ khách hàng. Giao diện này sẽ hiển thị tất cả các khu vực mà trợ lý yêu cầu sự trợ giúp của con người, mức độ ưu tiên của yêu cầu và bất kỳ dữ liệu nào khác.

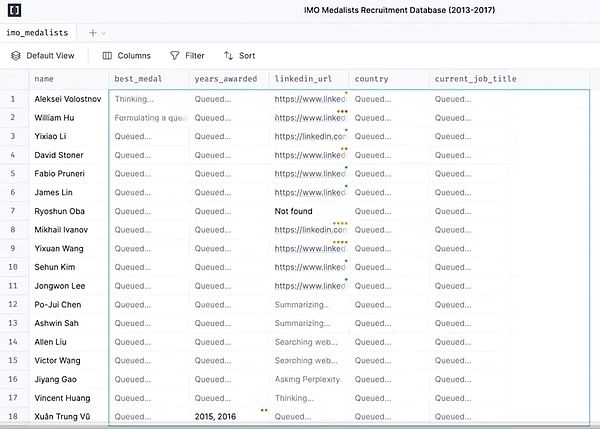

3. UX bảng tính

Trải nghiệm bảng tính là một cách siêu trực quan và thân thiện với người dùng để hỗ trợ xử lý hàng loạt làm việc một cách thân thiện. Mỗi bảng hoặc thậm chí mỗi cột trở thành Tác nhân riêng để nghiên cứu những điều cụ thể. Quá trình xử lý hàng loạt này cho phép người dùng mở rộng quy mô tương tác với nhiều Đại lý.

UX này còn có những lợi ích khác. Định dạng bảng tính là UX mà hầu hết người dùng đều quen thuộc, vì vậy nó rất phù hợp với quy trình công việc hiện có. Loại UX này lý tưởng cho việc làm phong phú dữ liệu, một trường hợp sử dụng LLM phổ biến, trong đó mỗi cột có thể biểu thị một thuộc tính khác nhau cần được làm phong phú.

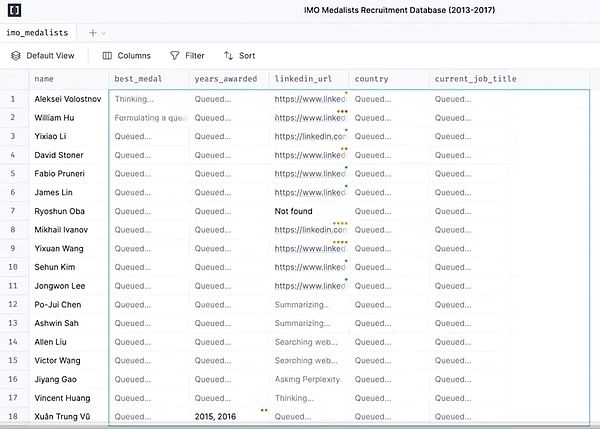

Exa AI, Clay AI, Manaflow và các sản phẩm của các công ty khác đều đang sử dụng UX này. Phần sau đây sử dụng Manaflow làm ví dụ để cho thấy cách bảng tính UX này xử lý UX này. quy trình làm việc.

Nghiên cứu điển hình:

Manaflow Cách sử dụngBảng tính để tương tác với Đại lý

Manaflow được lấy cảm hứng từ Minion AI, một công ty nơi người sáng lập Lawrence từng làm việc. Sản phẩm do Minion AI xây dựng là Web Agent. Tác nhân Web có thể điều khiển Geogle Chrome cục bộ, cho phép nó tương tác với các ứng dụng như đặt vé máy bay, gửi email, lên lịch rửa xe, v.v. Dựa trên cảm hứng của Minion AI, Manaflow đã chọn để Agent vận hành các công cụ giống như bảng tính. Điều này là do Agent không giỏi xử lý các giao diện UI của con người. Điều mà Agent thực sự giỏi là Mã hóa. Do đó, Manaflow cho phép Tác nhân gọi tập lệnh Python của giao diện UI, giao diện cơ sở dữ liệu, API liên kết và sau đó trực tiếp vận hành cơ sở dữ liệu: bao gồm thời gian đọc, đặt chỗ, gửi email, v.v.

Quy trình làm việc như sau: Giao diện chính của Manaflow là một bảng tính (Manasheet), trong đó mỗi cột thể hiện một bước trong quy trình làm việc và mỗi hàng tương ứng với Tác nhân AI thực thi nhiệm vụ. Mỗi quy trình làm việc của bảng tính có thể được lập trình bằng ngôn ngữ tự nhiên (cho phép người dùng không rành về kỹ thuật mô tả các nhiệm vụ và các bước bằng ngôn ngữ tự nhiên). Mỗi bảng tính có một biểu đồ phụ thuộc bên trong xác định thứ tự thực hiện mỗi cột. Các trình tự này sẽ được gán cho từng hàng Đại lý để thực hiện song song các nhiệm vụ và xử lý các quy trình như chuyển đổi dữ liệu, gọi API, truy xuất nội dung và gửi tin nhắn:

< img src="https ://img.jinse.cn/7339151_image3.png">

Tạo Manasheet Phương pháp khả thi là: nhập ngôn ngữ tự nhiên tương tự như ngôn ngữ trong hộp màu đỏ ở trên, như trong hình trên, nếu bạn muốn gửi email báo giá cho khách hàng, bạn có thể nhập Lời nhắc thông qua Trò chuyện để tạo Manasheet. Thông qua Manasheet, bạn có thể xem tên khách hàng, email của khách hàng, ngành nghề của khách hàng, email đã được gửi chưa và các thông tin khác, nhấp vào Thực thi Manasheet để thực hiện tác vụ.

4. Giao diện người dùng sáng tạo (Giao diện người dùng sáng tạo)

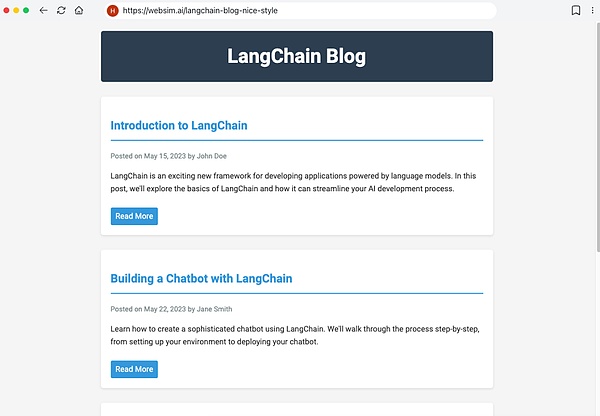

Đó là hai cách triển khai khác nhau của "giao diện người dùng tổng quát".

Một cách là để mô hình tự tạo ra các thành phần ban đầu được yêu cầu. Điều này tương tự như các sản phẩm như Websim. Về cơ bản, Tác nhân viết HTML thô, trao cho nó toàn quyền kiểm soát những gì được hiển thị. Tuy nhiên, cách tiếp cận này cho phép có độ không chắc chắn cao về chất lượng của ứng dụng web được tạo, do đó kết quả cuối cùng có thể không ổn định.

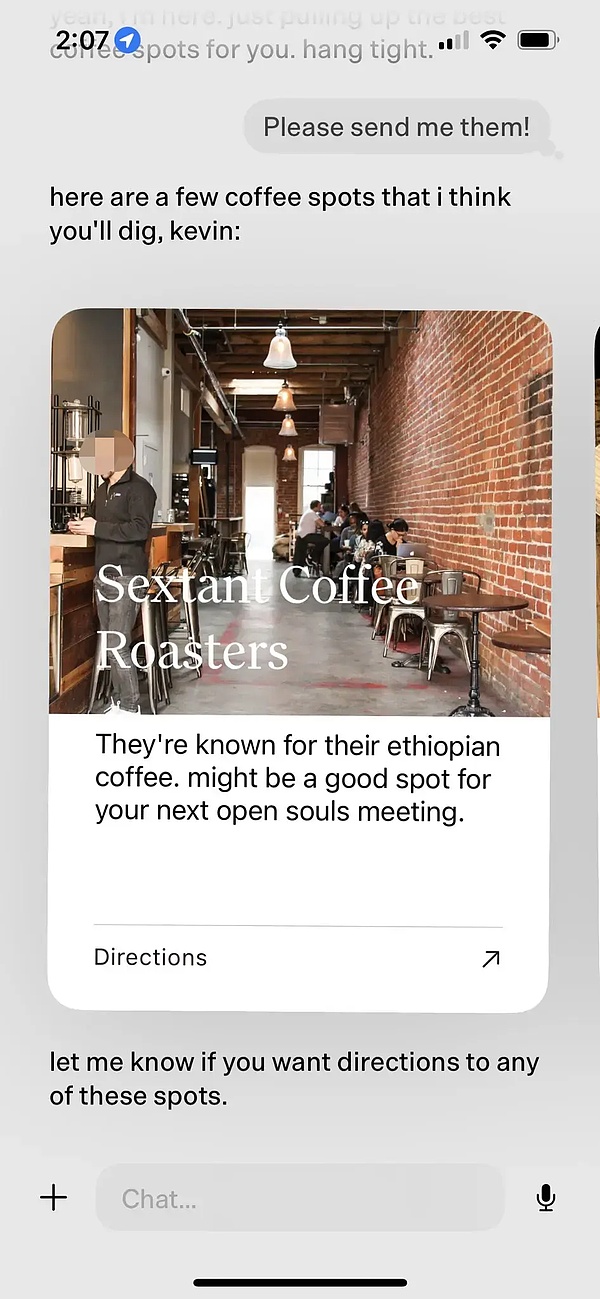

Một cách tiếp cận khác, hạn chế hơn là xác định trước một số thành phần giao diện người dùng, thường thông qua lệnh gọi công cụ. Ví dụ: nếu LLM gọi API thời tiết, nó sẽ kích hoạt hiển thị thành phần UI Bản đồ thời tiết. Vì các thành phần được hiển thị không thực sự được tạo (nhưng có nhiều tùy chọn hơn), nên giao diện người dùng được tạo sẽ tinh tế hơn, mặc dù không hoàn toàn linh hoạt về những gì nó có thể tạo ra.

Nghiên cứu điển hình:

Sản phẩm AI cá nhân dot

Ví dụ: Dot, từng được gọi là sản phẩm AI cá nhân tốt nhất vào năm 2024, là một sản phẩm UI có tính tổng quát tốt.

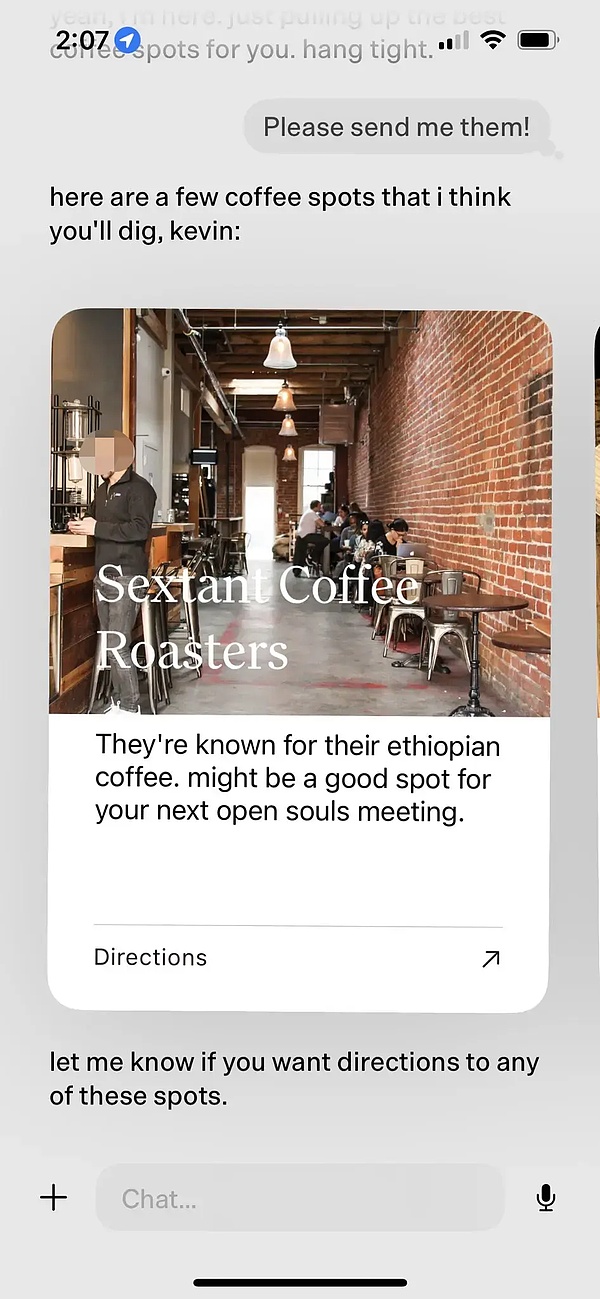

Dot là sản phẩm của New Computer: mục tiêu của nó là trở thành người bạn đồng hành lâu dài với người dùng chứ không phải là một công cụ quản lý tác vụ tốt hơn, theo người đồng sáng lập Jason Yuan Vâng, cảm giác của Dot là bạn quay sang Dot khi không biết phải đi đâu, làm gì hoặc nói gì. Dưới đây là hai ví dụ để giới thiệu chức năng của sản phẩm:

Người sáng lập Jason Yuan thường nhờ Dot giới thiệu các quán bar vào đêm khuya và nói rằng anh ấy muốn có được say rượu Sau vài tháng nghỉ ngơi, Yuan lại hỏi những câu hỏi tương tự sau khi tan làm vào một ngày nọ, và Dot thực sự bắt đầu thuyết phục Jason rằng anh không thể tiếp tục như thế này;

• Phóng viên công ty nhanh Mark Wilson, cũng đã dành vài tháng với Dot. Có lần, anh ấy chia sẻ với Dot về chữ "O" mà anh ấy đã viết trong lớp học thư pháp của mình. Dot thực sự đã đưa ra một bức ảnh chữ "O" viết tay của anh ấy vài tuần trước và khen ngợi sự tiến bộ của khả năng viết chữ của anh ấy.

^ Khi tôi sử dụng Dot ngày càng nhiều, Dot hiểu rõ hơn rằng người dùng thích ghé thăm các quán cà phê và chủ động giới thiệu những quán cà phê ngon gần chủ quán, kèm theo. tại sao quán cà phê này ngon, và cuối cùng suy nghĩ kỹ xem có cần điều hướng không.

Bạn có thể thấy điều đó trong ví dụ đề xuất quán cà phê này, Dot vượt qua giá trị đặt trước Xác định các thành phần UI để đạt được hiệu ứng tương tác gốc LLM.

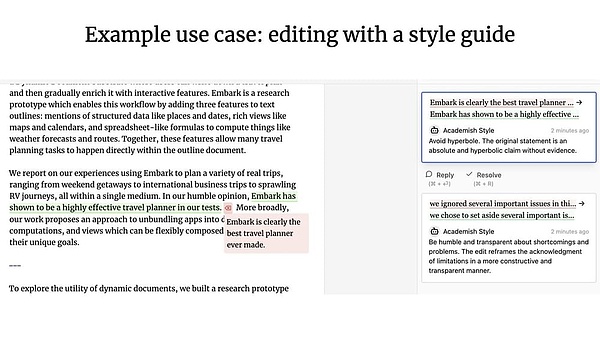

5. UX cộng tác

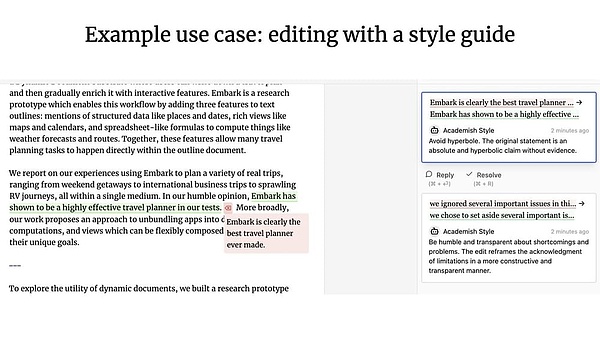

Điều gì sẽ xảy ra khi nhân viên hỗ trợ và con người làm việc cùng nhau? Hãy nghĩ đến Google Docs, nơi khách hàng có thể cộng tác với các thành viên trong nhóm để viết hoặc chỉnh sửa tài liệu, nhưng nếu một trong những cộng tác viên là Đại lý thì sao?

Geoffrey Litt và Ink & Switch cộng tác trong dự án Patchwork Một ví dụ tuyệt vời về sự hợp tác giữa con người và tác nhân. (Ghi chú của người dịch: Đây có thể là nguồn cảm hứng cho bản cập nhật sản phẩm OpenAI Canvas gần đây).

UX cộng tác so với UX xung quanh như đã thảo luận trước đó như thế nào? Kỹ sư sáng lập LangChain, Nuno nhấn mạnh rằng sự khác biệt chính giữa hai điều này là liệu có sự đồng thời hay không:

→ Trong UX cộng tác , khách hàng và LLM thường hoạt động đồng thời, lấy công việc của nhau làm đầu vào;

Trong Ambient UX , LLM ở chế độ nền Công việc vẫn tiếp tục trong khi người dùng hoàn toàn tập trung vào thứ khác.

Bộ nhớ

Bộ nhớ rất quan trọng để mang lại trải nghiệm tốt cho Đại lý quan trọng. Hãy tưởng tượng nếu bạn có một đồng nghiệp không bao giờ nhớ những gì bạn đã nói với họ, buộc bạn phải lặp đi lặp lại thông tin thì đây sẽ là một trải nghiệm cộng tác rất tồi tệ. Mọi người thường mong đợi hệ thống LLM có ký ức bẩm sinh, có lẽ vì LLM đã có cảm giác rất giống con người. Tuy nhiên, bản thân LLM không thể nhớ được điều gì.

Bộ nhớ của tác nhân dựa trên nhu cầu của chính sản phẩm và các UX khác nhau cung cấp các phương pháp khác nhau để thu thập thông tin và cập nhật phản hồi. Chúng ta có thể thấy các loại bộ nhớ nâng cao khác nhau trong cơ chế bộ nhớ của các sản phẩm Agent - chúng đang bắt chước các loại bộ nhớ của con người.

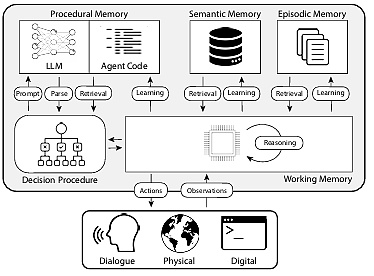

Bài viết CoALA: Kiến trúc nhận thức cho tác nhân ngôn ngữ ánh xạ các loại bộ nhớ của con người với bộ nhớ tác nhân và phương pháp phân loại như trong hình bên dưới:

< mạnh> 1. Trí nhớ thủ tục: Trí nhớ dài hạn về cách thực hiện các nhiệm vụ, tương tự như tập lệnh cốt lõi của não

Trí nhớ thủ tục của con người : Ghi nhớ cách thực hiện để đi xe đạp.

Bộ nhớ chương trình của Tác nhân: Bài báo CoALA mô tả bộ nhớ chương trình là sự kết hợp giữa trọng số LLM và mã Tác nhân, về cơ bản xác định cách thức hoạt động của Tác nhân.

Trong thực tế, nhóm Langchain chưa thấy bất kỳ hệ thống Đại lý nào tự động cập nhật LLM hoặc viết lại mã của nó, nhưng thực sự có một số Đại lý cập nhật lời nhắc hệ thống của họ Ví dụ .

2. Trí nhớ ngữ nghĩa: Dự trữ kiến thức lâu dài

$ Trí nhớ ngữ nghĩa của con người: Nó bao gồm các mẩu thông tin, chẳng hạn như sự kiện, khái niệm và mối quan hệ giữa chúng được học ở trường.

→ Bộ nhớ ngữ nghĩa của tác nhân: Bài báo CoALA mô tả bộ nhớ ngữ nghĩa như một kho lưu trữ các sự kiện.

Trong thực tế, điều này thường đạt được bằng cách sử dụng LLM để trích xuất thông tin từ cuộc đối thoại hoặc tương tác của Tác nhân. Chính xác cách lưu trữ thông tin này thường tùy thuộc vào từng ứng dụng cụ thể. Sau đó, thông tin này được truy xuất trong các cuộc hội thoại trong tương lai và được chèn vào Lời nhắc hệ thống để tác động đến phản hồi của Đại lý.

3. Trí nhớ từng đoạn: Nhớ lại các sự kiện cụ thể trong quá khứ

• Trí nhớ từng giai đoạn ở con người: Khi một người nhớ lại một sự kiện (hoặc "tình tiết") cụ thể đã trải qua trong quá khứ.

$ Bộ nhớ phân đoạn trong Tác nhân: Bài báo CoALA định nghĩa bộ nhớ phân đoạn là một chuỗi lưu trữ các hành động trong quá khứ của Tác nhân.

Điều này chủ yếu được sử dụng để cho phép Tác nhân thực hiện các hành động như mong đợi. Trong thực tế, bộ nhớ phân đoạn được cập nhật thông qua phương pháp Nhắc vài lần. Nếu có đủ Lời nhắc vài lần chụp cho các bản cập nhật liên quan thì bản cập nhật tiếp theo sẽ được hoàn thành thông qua Lời nhắc vài lần chụp động.

Nếu có cách hướng dẫn Tác nhân hoàn thành thao tác chính xác ngay từ đầu, bạn có thể sử dụng trực tiếp phương pháp này khi gặp vấn đề tương tự sau này; Ngược lại, nếu không có cách thức hoạt động đúng, hoặc Agent liên tục làm những việc mới thì trí nhớ ngữ nghĩa sẽ quan trọng hơn, còn ở ví dụ trước, trí nhớ ngữ nghĩa sẽ không giúp ích được gì nhiều.

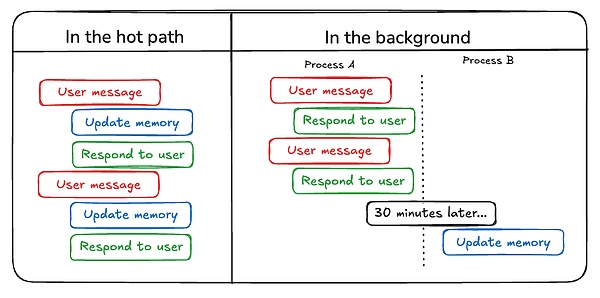

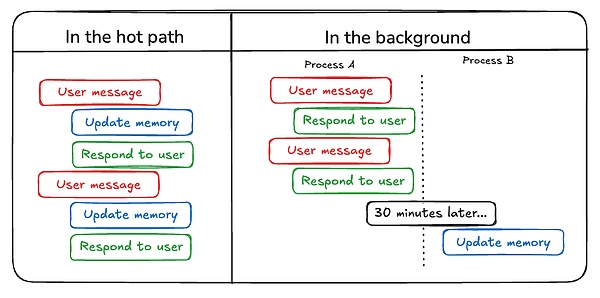

Ngoài việc xem xét loại bộ nhớ sẽ được cập nhật trong Tác nhân, nhà phát triển cũng cần xem xét cách cập nhật bộ nhớ của Tác nhân:

< p style="text -align: left;">Cách đầu tiên để cập nhật bộ nhớ của Tác nhân là "trong đường dẫn nóng". Trong trường hợp này, hệ thống Đại lý ghi nhớ các sự kiện (thường thông qua các lệnh gọi công cụ) trước khi phản hồi và ChatGPT áp dụng phương pháp này để cập nhật bộ nhớ của nó;Cập nhật Đại lý theo cách khác để ghi nhớ là “ở chế độ nền”. Trong trường hợp này, một tiến trình nền sẽ chạy sau phiên để cập nhật bộ nhớ.

So sánh hai cách tiếp cận, nhược điểm của cách tiếp cận "trong đường dẫn nóng" là có một số độ trễ trước khi bất kỳ phản hồi nào được gửi đi và nó cũng yêu cầu kết hợp logic bộ nhớ với logic tác nhân.

Tuy nhiên, tính năng "ở chế độ nền" tránh được những vấn đề này - không thêm độ trễ và logic bộ nhớ vẫn độc lập. Nhưng "ở chế độ nền" có nhược điểm riêng: bộ nhớ không được cập nhật ngay lập tức và cần có logic bổ sung để xác định thời điểm bắt đầu quá trình nền.

Một cách khác để cập nhật bộ nhớ liên quan đến phản hồi của người dùng, đặc biệt liên quan đến bộ nhớ phân đoạn. Ví dụ: nếu người dùng đánh giá cao cho một tương tác (Phản hồi tích cực), Đại lý có thể lưu phản hồi cho các cuộc gọi trong tương lai.

Dựa trên nội dung được tổng hợp ở trên, chúng tôi mong đợi sự tiến bộ đồng thời của ba thành phần lập kế hoạch, tương tác và trí nhớ, điều này sẽ cho phép chúng tôi xem thêm Đại lý AI có sẵn vào năm 2025, bước vào kỷ nguyên mới của công việc hợp tác giữa con người và máy móc.

Anais

Anais