في الأشهر الأخيرة، ظهر الذكاء الاصطناعي واحدًا تلو الآخر. وكثيرًا ما نرى الكلمات التالية في عناوين الأخبار: قام الذكاء الاصطناعي بتسريب كود الشركة ولا يمكن حذفه على الإطلاق؛ لقد انتهكت برامج الذكاء الاصطناعي خصوصية معلومات وجوه المستخدمين، وتعرض منتج معين كبير الحجم لتسريب محادثات خاصة...الخ.

ومع ذلك، ربما كانت هناك مشكلة أكثر عمقًا موجودة بهدوء قبل فترة طويلة من اندلاع جنون النماذج واسعة النطاق: التزييف العميق الذي يسمى Deepfake أدى ظهور التكنولوجيا التي يمكنها استخدام التعلم العميق لربط أي شخص في العالم بسلاسة في مقاطع فيديو أو صور لم يشارك فيها فعليًا من قبل إلى شعبية مصطلح "تغيير وجه الذكاء الاصطناعي" في عام 2018.

حتى اليوم في عام 2024، لم يتم احتواء التهديد المحتمل لـ Deepfake بشكل فعال.

أصبح الاحتيال بالذكاء الاصطناعي حقيقة واقعة، مما يثير القلق.

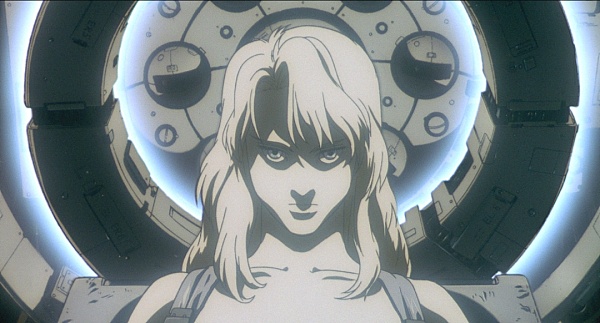

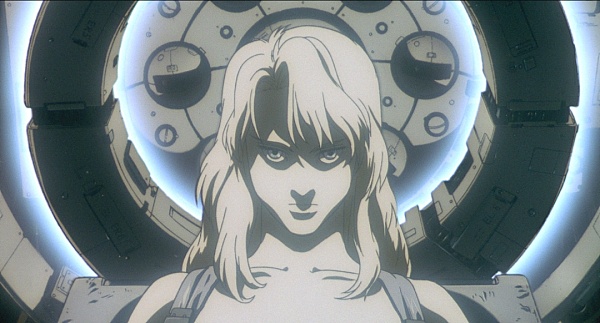

يصور فيلم الرسوم المتحركة "Ghost in the Shell" الذي صدر عام 1995 مثل هذه الحبكة: ذكاء اصطناعي يُدعى "Puppet Master" يعرف كيف يتظاهر بأنه هويات أخرى وإرباك الناس والسيطرة على أفكار الإنسان وسلوكياته، هذه القدرة تجعله غير مرئي في الإنترنت والفضاء الافتراضي. على الرغم من أن هذا السيناريو لا يظهر إلا في الأفلام، إلا أنك إذا تأثرت بتحذيرات أشخاص مثل إيلون ماسك أو سام ألتمان لفترة طويلة، فسوف تتخيل حتماً أنه بمجرد ترك الذكاء الاصطناعي دون رادع، فإنه يمكن أن يتطور إلى "سكاي نت". تهديد الأسلوب للإنسانية.

"Ghost in the Shell" سيد الدمى

لحسن الحظ، هذا هو الاهتمام لا يتم التعرف عليه بشكل عام من قبل غالبية مطوري الذكاء الاصطناعي. العديد من عمالقة الذكاء الاصطناعي في الأوساط الأكاديمية، مثل الحائز على جائزة تورينج جوزيف سيفاكيس، كشفوا في المقابلات أنهم يزدرون هذه الفكرة. في الوقت الحالي، ليس لدينا ذكاء اصطناعي يمكنه القيادة بأمان على الطريق، ناهيك عن مجاراة الذكاء البشري.

لكن هذا لا يعني أن الذكاء الاصطناعي غير ضار.

يتمتع الذكاء الاصطناعي بكل الإمكانات ليصبح واحدًا من أكثر الأدوات المدمرة التي ابتكرها البشر على الإطلاق. وفيما يتعلق بهذا، فإن المسؤول التنفيذي المالي الذي واجه للأسف مؤخرًا عملية احتيال باستخدام الذكاء الاصطناعي لديه فهم عميق لها، حيث بلغت الخسارة 25 مليون دولار أمريكي، ولم تحدث الجريمة على الجانب الآخر من المحيط، ولكن في منطقة هونغ كونغ الخاصة. المنطقة الإدارية، وهي قريبة جدا منا. وفي مواجهة جرائم الذكاء الاصطناعي هذه، هل لدينا أي إجراءات مضادة؟

تغيير اليوم

في 5 فبراير، وفقًا لإذاعة وتلفزيون هونج كونج الإعلامي في هونج كونج، تلقى مدير مالي مجهول رسالة بريد إلكتروني تدعي أنها من زميله البريطاني، يقترح صفقة سرية. المدير المالي ليس شخصًا ساذجًا ويشتبه في التصيد الاحتيالي من النظرة الأولى.

ومع ذلك، أصر المرسل على ترتيب مؤتمر فيديو عبر Zoom. وعندما انضم المدير المالي في هونج كونج إلى المؤتمر، رأى وسمع العديد من الوجوه المألوفة. الوجوه و أصوات الزملاء. وبعد أن زالت شكوكهم، بدأوا في الاستعداد للصفقة واتبعوا تعليمات زملائهم البريطانيين، وأخيرًا، قاموا بتحويل 200 مليون دولار هونج كونج (حاليًا حوالي 184 مليون يوان) في 15 مرة إلى 5 مرات. الحسابات المحلية.

ولم يتم اكتشاف هذا الخلل إلا بعد أن قام موظف آخر بالتحقق من المقر الرئيسي. وتبين أن المكتب البريطاني لم يبدأ هذه المعاملة ولم يتم استلام أي مبالغ. تخيل الندم الشديد والشعور بالذنب الذي شعر به المدير المالي بعد أن علم أنه تعرض للخداع. وبعد التحقيق تبين أن المشارك الحقيقي الوحيد في المؤتمر عبر الفيديو هو المدير المالي في هونغ كونغ، أما البقية فهم المدير المالي البريطاني وزملاء آخرون تمت محاكاتهم بواسطة تقنية الذكاء الاصطناعي Deepfake.

مع كمية صغيرة فقط من البيانات المتاحة للجمهور، ومجموعة أساسية من برامج الذكاء الاصطناعي، والخداع الماكر، هذا تمكن المحتال من الحصول على أموال كافية لشراء يخت فاخر.

في هذه اللحظة، قد يسخر بعض الأشخاص من هذه القصة ويؤكدون أن المدير المالي مهمل للغاية. بعد كل شيء، Deepfake الذي نراه عادة على Douyin وB -المحطة "كاملة"، ومن السهل التمييز بين "مقاطع الفيديو المباشرة" بين الحقيقية والمزيفة، ولكن من الصعب التمييز بين المزيفة والأصلية.

ومع ذلك، قد لا يكون الوضع الفعلي بهذه البساطة. فقد أظهرت أحدث الأبحاث أن الأشخاص لا يستطيعون في الواقع التعرف على التزييف العميق، مما يعني أن معظم الناس يتعرفون فقط على التزييف العميق على العديد من الأجهزة. المناسبات.احدس ما تراه وتسمعه. والأمر الأكثر إثارة للقلق هو أن الدراسة كشفت أيضًا أن الأشخاص أكثر عرضة للخلط بين مقاطع الفيديو المزيفة والحقيقية بدلاً من التزييف. بمعنى آخر، أصبحت تقنية التزييف العميق اليوم متطورة للغاية لدرجة أنها يمكن أن تخدع المشاهدين بسهولة.

التعلم العميق + التزييف

< p style="text-align: left;">Deepfake عبارة عن مزيج من الكلمتين "التعلم العميق" و"المزيف".

لذلك، فإن العنصر الأساسي لتقنية Deepfake هو التعلم الآلي، مما يجعل من الممكن إنتاج محتوى مزيف عميق بسرعة وبتكلفة أقل. لإنشاء مقطع فيديو مزيف عميق لشخص ما، يقوم المنشئ أولاً بتدريب شبكة عصبية باستخدام كميات كبيرة من مقاطع الفيديو الحقيقية لذلك الشخص، مما يمنحها "فهمًا" واقعيًا لكيفية ظهور الشخص من زوايا متعددة وتحت ظروف إضاءة مختلفة. ". يقوم المنشئ بعد ذلك بدمج الشبكة المدربة مع تقنيات الرسومات الحاسوبية لتركيب نسخة طبق الأصل من ذلك الشخص على شخص آخر.

يعتقد الكثير من الناس أن فئة من خوارزميات التعلم العميق تسمى شبكات الخصومة التوليدية (GANs) ستصبح القوة الدافعة الرئيسية لتطوير تقنية Deepfake في المستقبل. لا يمكن تمييز صور الوجه التي تم إنشاؤها بواسطة GAN تقريبًا عن الوجوه الحقيقية. يخصص التقرير الاستقصائي الأول في مجال التزييف العميق فصلاً لشبكات GAN، ويعد بأنها ستمكن أي شخص من إنشاء محتوى متطور للتزييف العميق.

في نهاية عام 2017، قام مستخدم Reddit يُدعى "deepfakes" بتزييف العديد من الأشياء بشكل جيد- يتم استخدام وجوه نجوم السينما المعروفين وحتى الشخصيات السياسية لإنشاء مقاطع فيديو إباحية ونشرها على الويب. انتشرت مقاطع الفيديو المزيفة هذه على الفور عبر شبكات التواصل الاجتماعي، وبعد ذلك بدأ ظهور عدد كبير من مقاطع الفيديو المزيفة الجديدة، لكن تقنية الكشف المقابلة لها لم تظهر تدريجيًا إلا بعد بضع سنوات.

ومع ذلك، هناك أمثلة إيجابية. أصبحت تقنية Deepfakes معروفة لأول مرة للجمهور على الشاشة عندما تم "إحياء" الممثل الراحل بول ووكر في فيلم Fast and Furious 7. استخدم فيلم السنة القمرية الجديدة 2023 "The Wandering Earth 2" أيضًا تقنية CG لإعادة إنتاج فيلم "Uncle Tat" Ng Man-tat الشهير. ولكن من قبل، كان الأمر يتطلب استوديوًا كاملاً من الخبراء لمدة عام لإنشاء هذه التأثيرات.

اليوم، أصبحت هذه العملية أسرع من ذي قبل.حتى الأشخاص العاديين الذين لا يعرفون شيئًا عن التكنولوجيا يمكنهم إنشاء "بديل للذكاء الاصطناعي" في بضع دقائق. " فيديو.

أدت المخاوف بشأن التزييف العميق إلى انتشار الإجراءات المضادة. في عام 2020، حظرت منصات التواصل الاجتماعي، بما في ذلك Meta وX، منتجات التزييف العميق المماثلة من شبكاتها. الخبراء مدعوون أيضًا للتحدث عن أساليب الدفاع في مؤتمرات الرؤية والرسومات الحاسوبية الكبرى.

الآن بعد أن بدأ مجرمون التزييف العميق في خداع العالم على نطاق واسع، كيف ينبغي لنا أن نقاوم؟

وسائل متعددة للدفاع ضد مخاطر Deepfake

الاستراتيجية الأساسية هي "تسميم" الذكاء الاصطناعي. لإنشاء تزييف عميق واقعي، يحتاج المهاجم إلى كميات هائلة من البيانات، بما في ذلك العديد من الصور للشخص المستهدف، والعديد من مقاطع الفيديو التي تظهر التغييرات في تعبيرات الوجه، وعينات صوتية واضحة. تستخدم معظم تقنيات التزييف العميق المواد التي يشاركها الأفراد أو الشركات علنًا على وسائل التواصل الاجتماعي.

ومع ذلك، توجد الآن برامج مثل Nightshade وPhotoGuard يمكنها تعديل هذه الملفات دون التأثير على الإدراك البشري، مما يجعل التزييف العميق غير فعال. على سبيل المثال، يستخدم Nightshade معالجة مضللة لجعل الذكاء الاصطناعي يسيء الحكم على مناطق الوجه في الصور. وقد يؤدي هذا التحديد الخاطئ إلى تعطيل آلية تعلم الذكاء الاصطناعي وراء إنشاء Deepfake.

ثانيًا، يمكن أن يؤدي تطبيق مثل هذه المعالجة الوقائية على جميع الصور ومقاطع الفيديو التي تنشرها بنفسك أو بشركتك عبر الإنترنت إلى منع استنساخ Deepfake بشكل فعال. ومع ذلك، فإن هذا النهج ليس مضمونًا، بل هو أقرب إلى لعبة طويلة الأمد. ومع تحسن الذكاء الاصطناعي تدريجياً من قدرته على تحديد الملفات التي تم العبث بها، ستحتاج برامج مكافحة التزييف العميق إلى التطوير المستمر لأساليب جديدة للحفاظ على فعاليتها.

لبناء خط دفاع أقوى، لم نعد بحاجة إلى الاعتماد فقط على طرق المصادقة التي يسهل اختراقها. في حالة هذه المقالة، اعتبر المدير المالي المعني مكالمة الفيديو بمثابة أساس مطلق لتأكيد الهوية، لكنه فشل في اتخاذ خطوات إضافية مثل الاتصال بموظفين آخرين في المقر الرئيسي أو فرع المملكة المتحدة لإجراء المصادقة الثانوية. في الواقع، تستخدم بعض البرامج بالفعل تقنية تشفير المفتاح الخاص لضمان موثوقية التحقق من الهوية عبر الإنترنت. يعد تنفيذ خطوات المصادقة متعددة العوامل لتقليل احتمالية هذا النوع من الاحتيال بشكل كبير أمرًا يجب على جميع الشركات البدء في تنفيذه على الفور.

لذا، في المرة القادمة التي تكون فيها في مؤتمر فيديو، أو تتلقى مكالمة من زميل أو قريب أو صديق، يرجى تذكر أن الشخص الموجود على الجانب الآخر من الشاشة قد لا يكون شخصا حقيقيا. خاصة عندما يُطلب منك تحويل 25 مليون دولار سرًا إلى مجموعة غير معروفة من الحسابات المصرفية، أقل ما يمكننا فعله هو الاتصال برئيسنا أولاً.

Joy

Joy