コンピュート・ネットワークを実際に機能させる

一般に信じられていることに反して、今日のWeb3分散GPU市場が直面している最大のハードルは、それらを機能させることです。

これは取るに足らない問題ではありません。

分散ネットワークにおけるGPUの調整は複雑で、多くの課題があります、データ転送、フォールトトレランス、地理的に分散した多種多様なハードウェアへの対応などです。私はもっともっと続けることができます。

これを達成するには、思慮深いエンジニアリングと、信頼性が高く、よく設計されたネットワーク・アーキテクチャが必要です。

よりよく理解するには、グーグルのKubernetesを思い浮かべてください。Kubernetes 自体は、10 年以上にわたる Google の経験に基づいて構築されていますが、それでも優れたパフォーマンスを発揮するには、何年にもわたる絶え間ない反復が必要でした。

現在稼働しているGPUコンピュート・マーケットプレイスのいくつかは、小規模なワークロードを処理できますが、スケールしようとするとすぐに問題が発生します。これは、彼らのアーキテクチャ基盤が貧弱に設計されているためだと思われます。

分散型コンピューティングネットワークのもう1つの課題/機会は、信頼性を確保することです。現在のところ、これはネットワークのレピュテーションに依存しており、場合によっては、演算プロバイダーがレピュテーションのスコアに基づいてランク付けされている。ブロックチェーンは、信頼を必要としない検証システムに適しているようだ。GensynやSpheronのような新興企業は、トラストレスアプローチを使ってこの問題を解決しようとしている。

今日でも、多くのWeb3チームがこれらの課題に取り組んでおり、これはチャンスの扉が開いていることを意味します。

分散コンピューティングの市場規模

分散コンピューティングのウェブ市場の規模はどれくらいでしょうか?

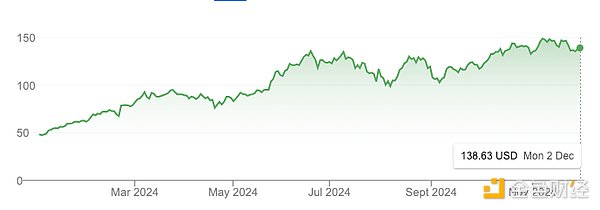

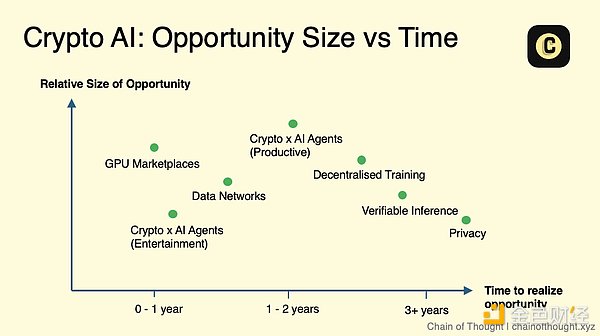

現在では、6800億ドルから2兆5000億ドルのクラウドコンピューティング産業のほんの一部でしょう。しかし、ユーザーにとっては摩擦が増えるにもかかわらず、コストが従来のプロバイダーよりも低い限り、需要は常にあるのです。

私は、トークン補助金と、価格に敏感でないユーザー向けの供給のロック解除により、コストは短期から中期にかけて低いままであると信じています(たとえば、月20ドルであろうと月50ドルであろうと、余分な現金のためにゲーミングノートPCを貸し出すことができれば、私は満足です)。

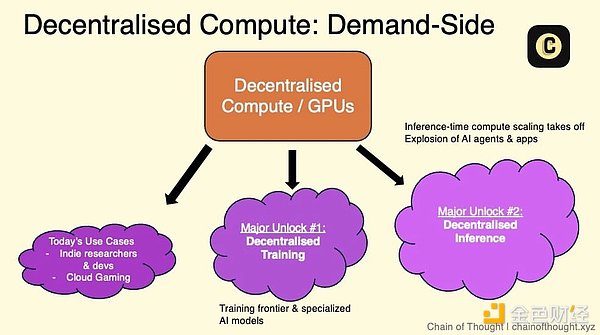

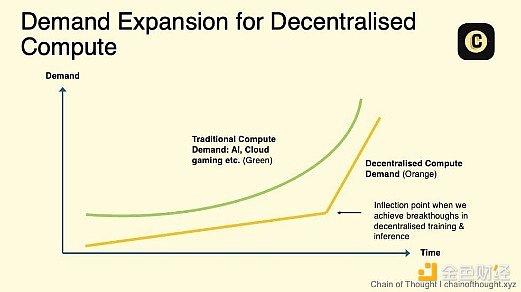

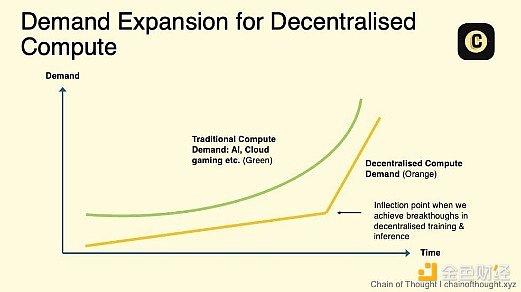

しかし、分散型コンピューティング・ネットワークの本当の成長の可能性、そしてそのTAMの本当のスケーリングは、次のようなものです。

人工知能モデルを中心としたトレーニングが実用的になります。中心のトレーニングが実用的になります。

推論の需要が急増し、既存のデータセンターでは追いつかなくなっています。これはすでに起こり始めており、ジェンセン・フアン氏は、推論の需要は「10億倍」に成長するだろうと述べています。

適切なサービス・レベル・アグリーメント(SLA)が利用可能になりつつあり、企業の採用に対する重要な障壁に対処しています。現在、分散型コンピューティングは、ユーザーがさまざまなレベルのサービス品質(稼働率など)を認識するように運用されています。SLAを使えば、これらのネットワークは標準化された信頼性とパフォーマンス指標を提供できるため、分散型コンピューティングは従来のクラウドプロバイダーに代わる実行可能な選択肢となります。

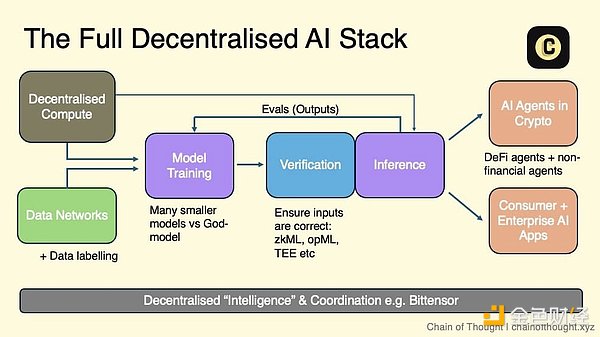

分散型パーミッションレス・コンピューティングは、分散型AIエコシステムの基盤層(インフラストラクチャー)です。

GPUのサプライチェーンは拡大していますが、私たちはまだ人間の知性の時代の夜明けにいると思います。コンピューティングに対する需要は飽くことがないでしょう。

すべての実行中のGPU市場の再評価の引き金となるような、注目すべき変曲点が間もなくやってくるかもしれません。

その他の考察:

純粋なGPU市場は混雑しています。li>

純粋なGPU市場は混雑しており、分散型プラットフォーム間の熾烈な競争や、Vast.aiやLambdaのようなWeb2 AI新興クラウドサービスの台頭があります。

小規模なノード(例えば、4 x H100)は、用途が限られているため、大きな需要はありませんが、大規模なクラスタを販売している人を見つけるのは幸運です。

支配的なプレイヤーは、分散型プロトコルのすべての演算供給を集約するのでしょうか、それとも複数の市場で演算を断片化したままにするのでしょうか?私は前者に傾いている。通常、統合はインフラ効率を向上させるからだ。しかし、それには時間がかかり、その間も断片化と混乱は続くだろう。

開発者は、デプロイや設定に対処するよりも、アプリ開発に集中したいと考えています。市場はこの複雑さを抽象化して、コンピュートへのアクセスをできるだけ摩擦のないものにしなければなりません。

2.2分散型トレーニング

スケーリングの法則が成り立つなら。">スケーリングの法則が成り立つなら、次世代の最先端AIモデルを単一のデータセンターでトレーニングすることは、いつか不可能になるでしょう。

AIモデルのトレーニングには、GPU間で大量のデータを転送する必要があります。分散GPU間のデータ転送(インターコネクト)速度の低下は、しばしば最大のハードルとなります。

研究者は複数のアプローチを並行して探求しており、ブレークスルーが起こりつつあります(Open DiLoCo、DisTrOなど)。これらの進歩が積み重なることで、この分野の進歩が集約され、加速されるでしょう。

分散型トレーニングの将来は、最先端のAGI中心のモデルではなく、ニッチなアプリケーションのための小規模な目的別モデルを設計することにあるかもしれません。

OpenAI o1のようなモデルへのシフトに伴い、推論の需要が急増し、分散型推論ネットワークの機会が生まれるでしょう。

想像してみてください。世界を変えるような巨大なAIモデルは、秘密のエリート研究所で開発されたものではなく、何百万人もの一般人によって形作られたものです。普段はGPUでCall of Dutyの劇場のような爆発を生み出しているゲーマーたちが、今、自分たちのハードウェアを、さらに壮大なもの、つまり中央の門番のいないオープンソースで集団所有のAIモデルに貸しているのです。

このような未来では、基盤規模のモデルは、トップクラスのAIラボだけに限定されるものではありません。

しかし、このビジョンを現在の現実に根付かせよう。今のところ、ヘビー級のAIトレーニングの大部分はまだ中央集中型のデータセンターに集中しており、これはしばらくの間、当たり前のことになりそうだ。

OpenAIのような企業は、大規模なクラスターを拡張している。イーロン・マスクは最近、xAIが200,000個のH100 GPUに相当するデータセンターを構築しようとしていると発表しました。

しかし、それは生のGPU数だけではありません。モデルFLOPS利用率(MFU)は、GoogleがPaLM 2022の研究論文で発表した指標で、GPUの最大容量がどれだけ効率的に使用されているかを追跡するものです。驚くべきことに、MFUは通常35~40%の間で推移しています。

なぜそんなに低いのでしょうか?ムーアの法則に従い、GPUの性能はここ数年で突然急上昇しましたが、ネットワーク、メモリ、およびストレージの改善は大幅に遅れており、ボトルネックとなっています。その結果、GPUはしばしば限界状態にあり、データを待っている状態です。

今日のAIトレーニングは、効率という一言のために、依然として高度に集中しています。

大規模なモデルのトレーニングは、以下のテクニックに依存します:

これらのアプローチでは、GPU が常にデータを交換する必要があり、インターコネクト速度(ネットワーク内のコンピューター間でデータが転送される速度)が重要になります。-- が重要になります。

最先端のAIモデルのトレーニングに10億ドル以上のコストがかかる場合、すべての効率向上が重要になります。

高速インターコネクトにより、集中型データセンターはGPU間でデータを迅速に転送することができ、分散型セットアップでは対応できないトレーニング時間の大幅なコスト削減が可能になります。

遅いインターコネクト速度を克服する

AI分野で働く人々に話を聞くと、多くの人が分散型トレーニングは単にうまくいかないと言うでしょう。

分散型セットアップでは、GPUのクラスタは物理的に共存していないため、クラスタ間のデータ転送ははるかに遅くなり、ボトルネックになります。トレーニングでは、GPUがステップごとに同期してデータを交換する必要があります。距離が離れれば離れるほど、レイテンシは高くなります。レイテンシーが高ければ高いほど、トレーニングは遅くなり、コストも高くなります。

集中型データセンターでは数日かかることが、分散型データセンターでは2週間かかることもあり、コストも高くなります。単純に実現不可能です。

しかし、それは変わろうとしている。

良いニュースは、分散トレーニングに対する研究者の関心が急増していることです。研究者たちは複数のアプローチを同時に模索しており、それは多くの研究や発表された論文からも明らかです。これらの進歩は重なり合い、収束し、この分野の進歩を加速させるでしょう。

境界をどこまで押し広げられるか、本番環境でテストすることも重要です。

いくつかの分散型トレーニング技術は、低速の相互接続環境において、より小さなモデルをすでに扱うことができます。

現在、最先端の研究が、大規模なモデルでこれらの手法を使用することを推進しています。

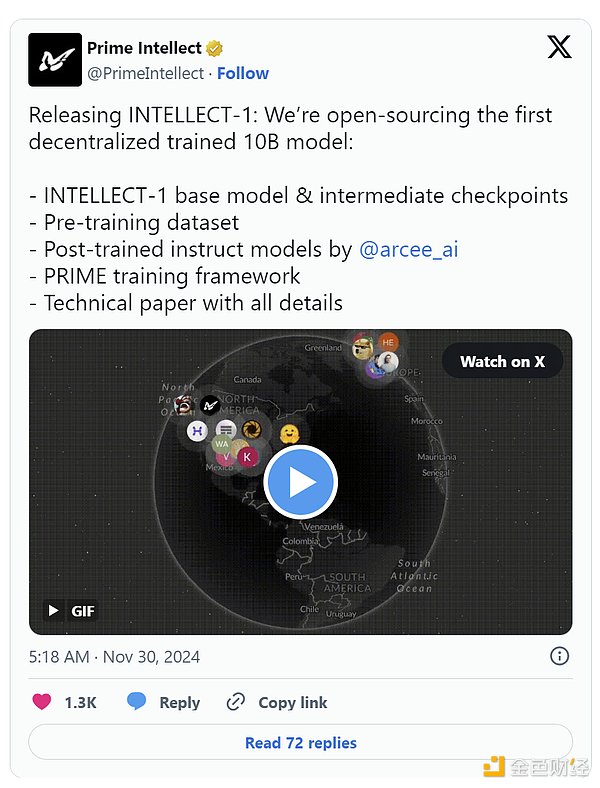

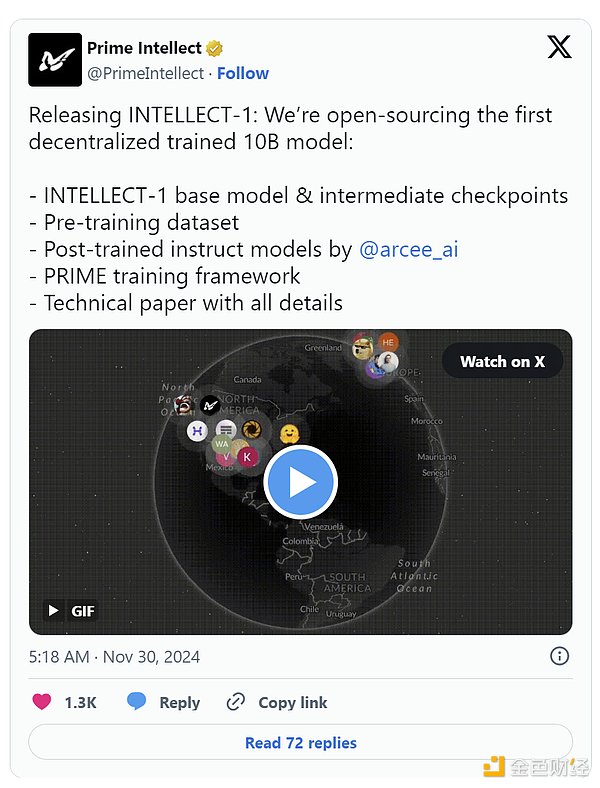

たとえば、Prime IntellectのオープンソースDiCoLoの記事では、GPUの「サイロ化」を伴う実用的なアプローチを示しており、同期する前に500のローカルステップを実行します。同期前に500のローカルステップを実行し、必要な帯域幅を500分の1に削減する。小さなモデルに関するGoogle DeepMindの研究として始まったものは、11月には100億のパラメータを持つモデルのトレーニングにまで拡大し、現在は完全にオープンソースとなっている。

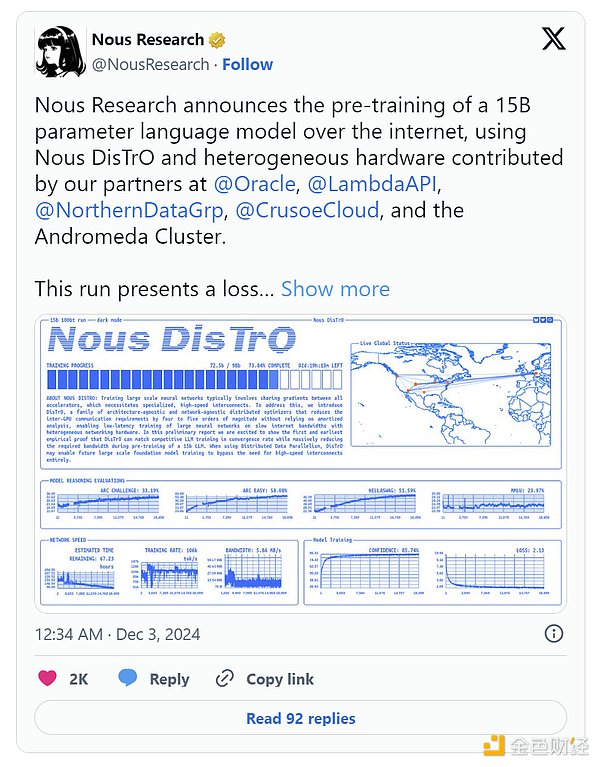

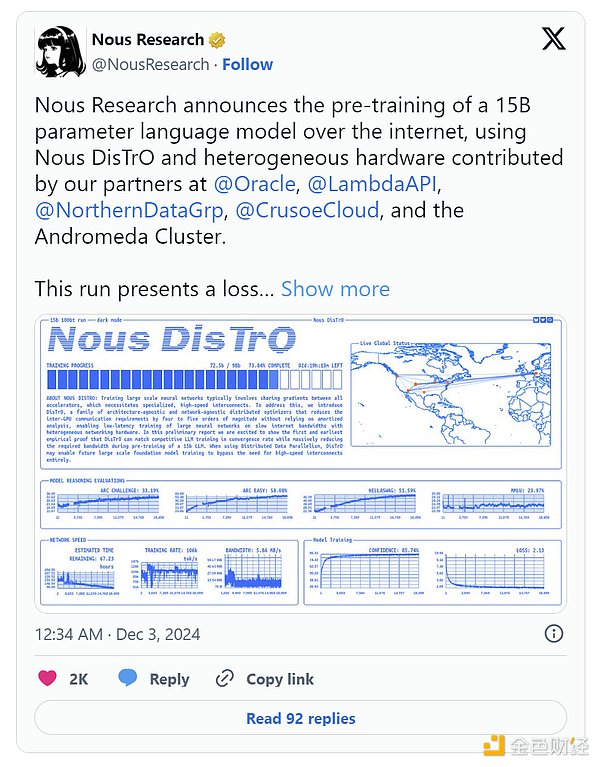

ヌース・リサーチは、彼らのDisTrOフレームワークは、1.2Bのパラメータモデルをトレーニングしながら、オプティマイザを使用してGPU間の通信要件を10,000倍という驚異的な削減を実現し、ハードルを引き上げます。

そしてその勢いはとどまるところを知りません。昨年12月、Nousは15Bのパラメトリック・モデルの事前トレーニングを発表しました。ロス・プロファイル(時間の経過とともにモデル誤差がどのように減少するか)と収束率(モデルのパフォーマンスがどの程度早く安定するか)は、集中型トレーニングの典型的な結果に匹敵するか、それを上回るものでした。そう、集中型よりも優れているのだ。

多種多様な GPU ハードウェアを管理することは、分散型ネットワークに典型的な、メモリ制約のあるコンシューマグレード GPU を含む、もう 1 つの大きな課題です。モデル並列性 (デバイス間でモデル層を分割する) のような技術は、これを可能にするのに役立ちます。

分散型トレーニングの未来

現在の分散型トレーニング手法のモデルサイズは、最先端のモデルよりもはるかに小さいままです(GPT-4のパラメーターは、1兆に近いと報告されています。兆、Prime Intellectの10Bモデルの100倍)。真のスケールを達成するためには、モデル・アーキテクチャのブレークスルー、より優れたネットワーク・インフラストラクチャ、よりスマートなデバイス間のタスク割り当てが必要です。

私たちは大きな夢を見ることができます。分散型トレーニングが、最大規模の集中型データセンターでさえ可能な以上のGPUコンピューティングパワーを集約する世界を想像してみてください。

プラリスリサーチ(分散型トレーニングに特化したエリートチームで、注目に値する)は、これは可能であるだけでなく、避けられないことだと考えています。中央集権型のデータセンターがスペースや電力の都合によって物理的な制約を受けるのに対し、分散型ネットワークは真に無限のグローバルなリソースを利用することができます。

NVIDIAのJensen Huang氏も、非同期の分散型トレーニングがAIのスケーリングの真の可能性を解き放つことができると認めています。また、分散型トレーニングネットワークは、より耐障害性に優れています。

つまり、将来起こりうる世界では、世界で最も強力なAIモデルは、分散型の方法でトレーニングされるということです。

これはエキサイティングな展望ですが、現時点では完全には納得していません。最大のモデルの分散型トレーニングが技術的にも経済的にも実現可能であるという、より強力な証拠が必要なのです。

私はこれに大きな可能性を感じています。分散型トレーニングの最良の点は、特大のAGI主導の最先端モデルと競合するのではなく、ターゲットとするユースケースのために設計された、専用の小さなオープンソースモデルにあるかもしれません。特定のアーキテクチャ、特に非変換型モデルは、分散型セットアップに適していることが証明されています。

このパズルにはもう1つ、トークンがあります。分散型トレーニングがスケールアップして実現可能になれば、トークンは貢献者にインセンティブを与え、報酬を与える上で重要な役割を果たすことができ、これらのネットワークを効果的に操縦することができます。

このビジョンを実現する道のりはまだ長いが、前進は頼もしい。将来のモデルの規模は単一のデータセンターの能力を超えるため、分散型トレーニングの進歩は、大手のハイテク企業や一流のAI研究所であっても、すべての人に利益をもたらすでしょう。

未来は分散型だ。テクノロジーがこれほど広範な可能性を秘めている場合、歴史が示すように、それは常に、誰もが予想するよりも速く、より良く機能する。

2.3.分散型推論

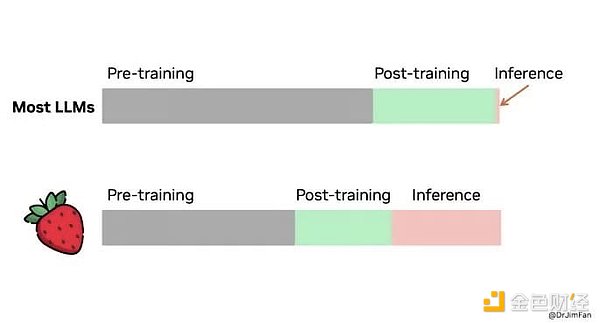

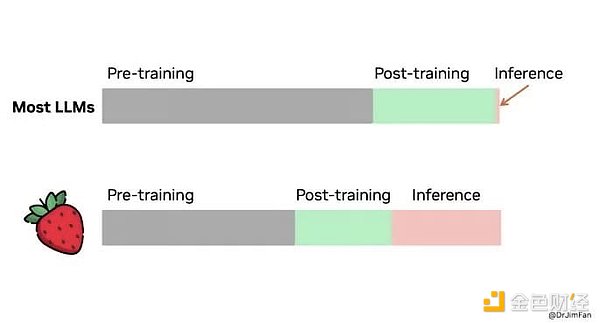

現在、AIにおける計算能力のほとんどは、大規模モデルのトレーニングに集中しています。

しかし、私の考えでは、今後数年間で、このトレーニングに焦点を当てたコンピューティングは推論にシフトするでしょう。AIがヘルスケアからエンターテイメントまで、私たちが毎日使うアプリにますます統合されるにつれ、推論をサポートするために必要な計算リソースの量は驚異的なものになるでしょう。

単なる憶測ではありません。openAIは最近、最新モデル01(コードネーム:Strawberry)のプレビュー/ミニバージョンをリリースしましたが、これは大きな転換なのでしょうか?その問いに答えるために、まずどのようなステップを踏むべきかを自問自答し、一歩一歩進むには、考える時間が必要です。

このモデルは、クロスワードパズルのような多くの計画を必要とする、より複雑なタスクや、より深い推論を必要とする問題のために設計されています。回答生成のスピードが遅く、時間がかかることにお気づきでしょうが、結果はより思慮深く、ニュアンスに富んでいます。また、実行コストもはるかに高い(GPT-4の25倍)。

焦点の転換は明らかです。AIのパフォーマンスにおける次の飛躍は、より大きなモデルのトレーニングからだけでなく、推論プロセスにおける計算アプリケーションのスケーリングからももたらされるでしょう。

もっと詳しく知りたい方は、いくつかの研究論文をご覧ください。

一度強力なモデルが訓練されると、その推論タスク(モデルが行うこと)は、脱集中化されたコンピューティングネットワークに転送することができます。集中型コンピューティング・ネットワークに移すことができます。

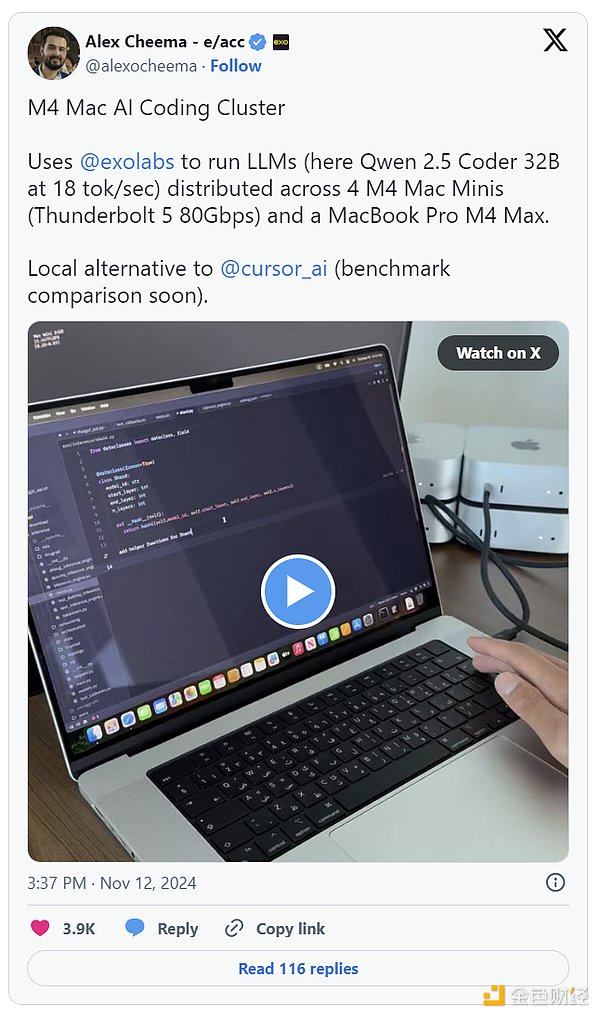

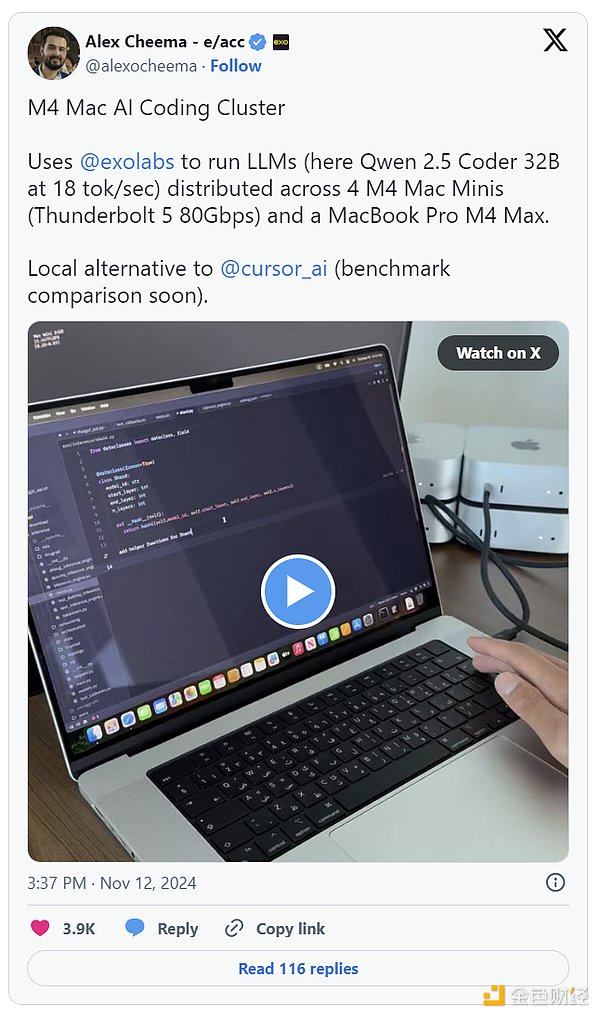

推論には、トレーニングに比べてはるかに少ないリソースしか必要ありません。トレーニング後、量子化、枝刈り、蒸留などのテクニックを使ってモデルを圧縮し、最適化することができます。さらに、日常的な消費者向けデバイスで実行できるように分解することもできます。推論をサポートするためにハイエンドのGPUは必要ありません。

これはすでに実現しています。Exo Labsは、450BパラメータのLlama3モデルを、MacBookやMac Miniなどのコンシューマーグレードのハードウェアで実行する方法を見つけ出しました。複数のデバイスに推論を分散させることで、大規模なワークロードを効率的かつコスト効率よく処理することができます。

分散推論をAIのCDN(コンテンツ・デリバリー・ネットワーク)と考えてみましょう。近くのサーバーに接続してウェブサイトを素早く提供する代わりに、分散推論はローカルの計算能力を活用して、記録的な速さでAIの応答を提供します。分散型推論を採用することで、AIアプリケーションはより効率的になり、応答性と信頼性が向上します。

その傾向は明らかです。Appleの新しいM4 Proチップは、最近までハードコア・ゲーマーの領域だったNVIDIAのRTX 3070 Tiと競合しています。私たちのハードウェアは、高度なAIワークロードを処理できるようになってきています。

暗号の付加価値

分散型推論ネットワークが成功するためには、説得力のある経済的インセンティブが必要です。ネットワーク内のノードは、算術的な貢献に対して補償される必要があります。システムは、報酬が公平かつ効率的に分配されることを保証しなければならない。地理的多様性は、推論タスクの待ち時間を減らし、耐障害性を高めるために必要である。

分散型ネットワークを構築する最善の方法とは何でしょうか。

トークンは、参加者の利害を一致させる強力なメカニズムを提供し、全員が同じ目標に向かって取り組むことを保証します。トークンの価値を高める。

トークンはまた、ネットワークの成長を加速させます。アーリーアダプターに報酬を与え、初日から参加を促進することで、ほとんどのネットワークの足かせとなっている古典的な「鶏が先か卵が先か」の問題を解決するのに役立ちます。

ビットコインとイーサの成功がこれを証明しています。

分散型推論ネットワークが次に来るでしょう。地理的な多様性により、待ち時間が短縮され、フォールトトレランスが向上し、AIがユーザーに近づきます。暗号化されたインセンティブにより、従来のネットワークよりも高速かつ優れたスケールが可能になります。

(未完成のビジネス、ご期待ください)

Jixu

Jixu