出典:InfoQ

北京時間の午前4時、海の向こう、カリフォルニア州サンノゼのサンノゼ・コンベンション・センターでは、NVIDIAの技術の饗宴として知られるGTC 2024カンファレンスが盛り上がっていました。NVIDIA 2024が華々しく幕を開けると、トレードマークの革ジャンを着た兆万長者のゴッドファーザー・ウォン氏が中央のステージに立ち、H100およびA100に続く一連の「核爆弾」スーパーチップを冷静に発表しました。

今年のGTCが注目されたのは、NVIDIAがこの1年、AIで経済的な成功を収めたからだ。Volta V100 GPUシリーズから最新のAmpere A100およびHopper H100チップまで、同社は一貫してAIチップの王者として君臨してきた。

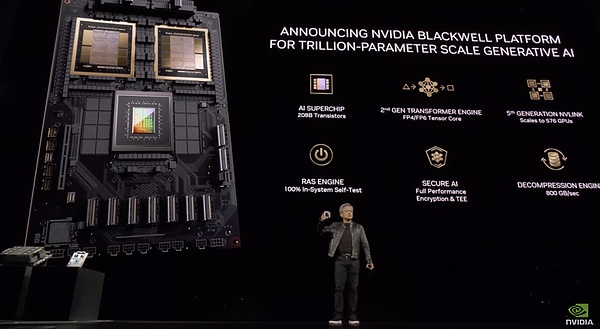

1.GPUファミリーに新メンバーが加わり、Blackwellアーキテクチャの新チップが大爆発

今年のGTCカンファレンスが始まる前、黄健薰がGTC 2024で新しいGPUファミリーを発表するという噂がありましたが、案の定、BlackwellアーキテクチャのチップであるB200とGB200がGTC 2024で発表されました。予想通り、Blackwellアーキテクチャを採用したB200およびGB200シリーズのチップが登場しました。

NVIDIAによると、Blackwellファミリーは、これまでで最も強力なAIチップファミリーだという。

ラオ・ファン氏によると、B200は2080億個のトランジスタを搭載し(H100/H200は800億個)、TSMCの4NPプロセスで製造され、1750億個のパラメータで構成されるOpenAIのGPT-3と比較して、最大10兆個のパラメータを持つAIモデルをサポートできる。また、1つのGPUで20ペタフロップスのAI性能を実現します。H100は1つで最大4ペタフロップスのAI計算が可能です。

しかし、Blackwell B200は、従来の意味での単一のGPUではなく、10 TB/秒のNV-HBI(Nvidia High Bandwidth Interface)リンクを介して接続された、緊密に結合された2つのチップで構成されており、単一の同一のチップとして機能するようになっていることは注目に値します。

数学者David Harold Blackwellにちなんで名づけられたこのGPUプラットフォームは、2年前に導入されたNvidiaのHopperアーキテクチャに続くもので、これをベースとした一連の製品はNvidiaのビジネスと株価を急上昇させました。

Blackwellは、100%システム内で自己テストするRASサービスとフルパフォーマンスの暗号化によって安全なAIを提供し、データが転送中だけでなく、静止状態や計算中も安全であることを意味します。

BlackwellはNVIDIAのGB200 Grace Blackwellスーパーチップに統合され、2つのB200 Blackwell GPUを1つのGrace CPUに接続します。

NVIDIAは価格を明らかにしていません。

新しいチップは今年後半に利用可能になる予定です。

Blackwell GPUは、2つのB200 Blackwell GPUを1つのGrace CPUに接続するものです。534d5a2c919bb3f95684ebab774ae0a9">

「ジェネレーティブAIは、私たちの時代を定義する技術です」と、ラオウ氏はプレゼンテーションの中で述べた。「BlackwellのGPUは、この新しい産業革命を推進するエンジンです。世界で最も勢いのある企業と協力することで、あらゆる産業におけるAIの約束を実現します。"

NVIDIAはまた、1,440ペタフロップス(別名1.4エクサフロップス)の推論能力を持つGB200 Grace Blackwellスーパーチップを36個搭載し、その内部には約2マイル(約5,000本)の個別のケーブルがあるGB200 NVL72液冷ラックシステムも発表しました。

NVIDIAによれば、GB200 NVL72は、推論目的で使用される同じ数のH100 Tensor Coreグラフィックス・プロセッシング・ユニットと比較して、最大30倍の性能向上を実現しています。さらに、このシステムはコストと消費電力を最大25倍削減します。

GB200 NVL72

たとえば、以前は1兆8000億のパラメータ・モデルをトレーニングするのに、8000個のHopper GPUと15メガワットの電力が必要でした。現在では、わずか4メガワットの電力で、2,000のBlackwell GPUでそれを行うことができます。

1750億のパラメーターを持つGPT-3ベンチマークでは、NVIDIAによると、GB200はH100よりも7倍高速に動作し、4倍高速に学習するとのことです。

さらにNVIDIAは、1つのサーバーノードで8つのB200 GPUとx86 CPU(おそらく2つのCPU)を使用することを前提とした、「HGX B200」と呼ばれるサーバー用マザーボードも発表すると述べています。各B200 GPUは最大1,000Wまで設定可能で、GPUは最大18ペタフロップスのFP4スループットを提供し、GB200のGPUよりも10パーセント遅くなります。

今日、企業顧客は、HGX B200およびB200 GPUとNVIDIAのGrace CPUを組み合わせたGB200を通じて、B200にアクセスすることができます。

2.完全にアップグレードされたソフトウェアサービス

市場は加熱しており、ハードウェアとソフトウェアの両面で競争が激化しています。今回のGTCでNVIDIAは、新しいハードウェアのイノベーションで競争に対応するだけでなく、AIソフトウェア戦略がこの分野でのリーダーシップを定義するのに役立ち、今後数年間でどのように進化するかを示しました。

また、Jen-Hsun Huang氏は、同社のAIソフトウェアのサブスクリプションパッケージを強力に推し進め、「ソフトウェアがハードウェアを販売する」という同社の新戦略に沿った明確な動きを見せ、「ハードウェアがソフトウェアを販売する」という以前の戦略に別れを告げました。

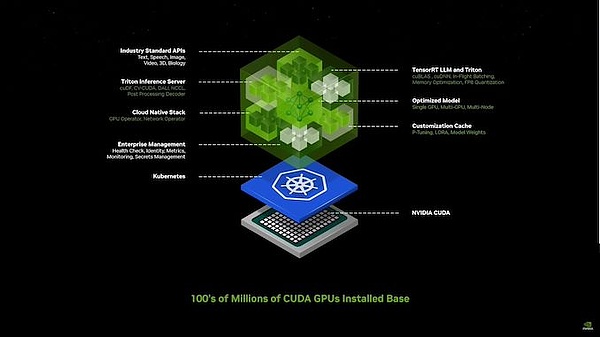

Nvidiaは、あらゆる領域にわたって膨大な数のモデルを利用できるが、企業が利用するにはまだ難しすぎると考えている。Nvidia Inference Microservices (NIM)を導入し、モデルと依存関係をクリーンなパッケージにまとめ、ユーザーのスタックに最適化し、使いやすいAPIに接続しました。

NVIDIAのインストールベース上で動作するようにパッケージ化および最適化された、事前学習済みモデルには、それを実行するために必要なすべてのソフトウェアが含まれています。パッケージであり、NV GPU用に最適化され、それらにアクセスするためのシンプルなAPIを備えています。

「これが将来、我々がソフトウェアを書く方法だ」とオールド・イエローは指摘する。

Old Yellowは、NVIDIAがNVIDIA Inference Microservices (NIM)を使用して、チップを製造する際に遭遇する一般的な問題を解決することを目的とした社内チャットボットを作成した方法を説明しました。「これらの「マイクロサービス」によって、開発者は独自のモデルやカスタムモデルを使用して「コ・パイロット」を素早く作成し、デプロイできるようになる。これらの「マイクロサービス」によって、開発者は独自のカスタムモデルを使って「コ・パイロット」やAIアシスタントを素早く作成・展開できるようになる。

同氏は、ロボット工学はAIやOminversea/Digital Twinの仕事とともにNVIDIAにとって重要な柱であり、これらすべてが同社のシステムを活用するために連携していると述べた。

Omniverseは、メタバース・アプリケーションの構築と運用のために設計されたプラットフォームと言われており、基本的には、人々が相互作用し、そこで働き、創造することができる共有仮想世界です。Omniverseプラットフォームは、デジタルツインと高度なシミュレーションの作成を可能にします。NVIDIAのOmniverseのビジョンには、クリエイターや企業が共有仮想空間でコラボレーションできるMetaverseの基盤プラットフォームとなることも含まれています。Omniverseで作成されたデジタルツインは、仮想トレーニング、製品設計、予知保全など、メタバースにおけるさまざまな用途に使用することができます。

ラオ氏によると、エヌビディアはエンタープライズグレードのジェネレーティブAIマイクロサービスを数十種類立ち上げており、企業は知的財産の完全な所有権と管理権を保持したまま、自社のプラットフォーム上でアプリケーションを作成するために利用できる。

Old Yellowはまた、Apple Vision ProヘッドフォンへのOmniverse Cloudストリーミングも発表しました。

彼はまた、NVIDIAが、人間にとってより良いコードを生成するためにAIの力を活用することを期待して、基礎となるソフトウェアスタック全体の根本的な再設計を真剣に検討していることを示唆していると述べました。

その理由は単純で、何十年もの間、世界全体がCPUを中心に開発された伝統的なコンピューティングフレームワークに制約されており、人間がアプリケーションを書いてデータベース化された情報を取得していたからです。

発表イベントでJen-Hsun Huang氏は、"今日のコンピューティング方法では、まず誰が情報を書いたのか、誰がそれを作成したのかを判断する必要があります。"つまり、情報が最初に記録されることが要求されるのです。

そして、NVIDIAのGPUは、関連する結果を決定するために(固有の論理ではなく)創造的な推論に頼ることができる加速されたコンピューティングのためのアルゴリズムコンピューティングへの新しい道を開きます。

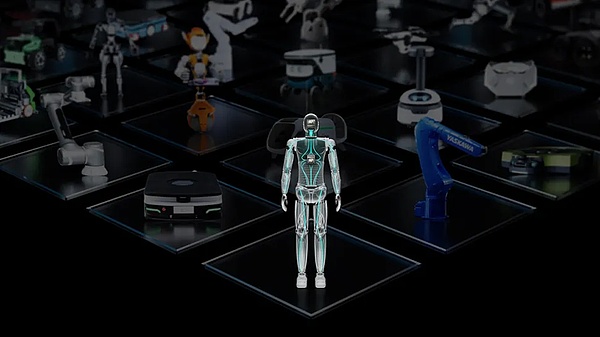

さらにNVIDIAは、もう1つの新しいAPIコレクション「Project GROOT」のリリースにより、ヒューマノイドロボットの開発を推進しようとしています。

Project GROOTは、NVIDIAがNvidia IsaacのSoCおよびアップグレードであるJetson Thorで製造しているヒューマノイドロボットモデルです。NVIDIAによると、GROOTロボットは自然言語を理解し、人間の動きを模倣して器用さを学習するとのことです。Jetson Thorは、8ビットデータ処理で800テラフロップスのAIパフォーマンスを実現するBlackwellベースのGPUを搭載しています。

Lao 氏は、このプラットフォームによって駆動されるロボットは、自然言語を理解し、人間の行動を観察するためにロボットの動きを真似るように設計されていることを明らかにした。これにより、GROOTロボットは協調性、器用さ、そして現実世界をナビゲートし、適応し、相互作用するためのその他のスキルを素早く学ぶことができます。

「汎用ヒューマノイドロボットの基本モデルを構築することは、今日のAIで解決できる最もエキサイティングな問題の1つです。"これらの実現技術が融合することで、世界中の一流のロボット工学者が人工汎用ロボットの分野で大きな飛躍を遂げることができるのです。"

3.開発者への示唆

専門家の予測によると、5年後には、テキスト、画像、ビデオ、音声の形の情報はすべて、大規模な言語モデル(LLM)にリアルタイムで入力されるようになります。そのころには、コンピューターはあらゆる情報源に直通し、マルチモーダルなインタラクションを通じて常に自分自身を向上させていることでしょう。

Jen-Hsun Huang氏は、「将来、私たちは継続的な学習の時代に足を踏み入れるでしょう。私たちは継続的学習の成果を展開するかどうかを決めることができ、コンピュータとのインタラクションはC++に助けられることはないでしょう。"

それこそがAI技術であり、人間が推論し、特定の目標を達成するためのコードを生成するようコンピュータに求めることができる。言い換えれば、将来、人間はC++でもPythonでもなく、簡単な言語でコンピュータと円滑にコミュニケーションできるようになるということだ。

"プログラミングそのものの価値は、歴史的な衰退の変曲点を静かに越えつつあるように思える。"ジェンスン・フアン氏は、AIはすでに人間とテクノロジーのギャップを埋めつつあると付け加えた。

「現在、コンピューター・プログラミングの知識を活かして地位を得たり、収入を得たりしている人は数千万人程度ですが、残りの80億人は彼らから大きく取り残されています。将来的には状況は変わるだろう。"

Jen-HsunHuang氏の見解では、英語が最も強力なプログラミング言語になり、パーソナライズされたインタラクションが技術格差を埋める重要な要素になるという。

Generative AIは、人間が簡単な言語でアプリケーションを作成するようコンピュータに指示できるマクロレベルのオペレーティングシステムになるだろう。Jen-Hsun Huang氏は、このマクロ言語モデルは、人間がインスピレーションをコンピュータを通して現実に変換するのに役立つだろうと述べています。

例えば、人間はすでにビッグランゲージに、ドメイン固有のアプリケーションのためのPythonコードを生成するよう依頼することができ、プロンプトはすべて平易な英語で書かれている。

「どうやってコンピュータに我々の望むことをさせるのか?どうやってコンピュータの命令を微調整するのか?これらの質問に対する答えが、キューワードエンジニアリングであり、それは単なる技術というよりも芸術なのです。"

つまり、人間は領域の専門知識に集中できるようになり、生成AIがプログラミングスキルのギャップを埋めるということだ。Jen-Hsun Huang氏は、これがソフトウェア開発の状況を完全に破壊すると考えている。

Jen-Hsun Huang氏は以前、大きな言語モデルを、事前に訓練された頭の切れる大卒生に例えています。NVIDIAは、企業顧客を効率的にサポートするために、ビッグモデルを中心にヘルスケアや金融などの分野で専門知識を提供しています。

JinseFinance

JinseFinance

JinseFinance

JinseFinance Edmund

Edmund Edmund

Edmund Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist