著者:Heart of the Machine

衝撃的だ!

さまざまなテック企業が、要約されたテキストやPチャートやその他の機能を携帯電話に搭載し、ビッグモデルのマルチモーダル機能にまだ追いついていない中、時代を大きく先取りしているOpenAIは、直接大きなトリックを開き、自社のCEOであるウルトラマンでさえ「まるで映画のようだ」と感嘆する製品をリリースした。

5月14日未明、OpenAIは主力生成モデル「GPT-4o」の新世代デスクトップアプリを動かし、初の「春の新製品発表会」で一連の新機能を披露した。今回、技術は製品形態を覆し、OpenAIはその行動で世界中のテック企業に教訓を与えた。

今日のプレゼンターは、OpenAIの最高技術責任者(CTO)であるMira Murati氏です。

1つ目は、OpenAIはまず無料にするということです。

第二に、OpenAIはプログラムのデスクトップ版をリリースし、より使いやすく自然なUIに更新します。

3つ目は、GPT-4の後に、GPT-4oと呼ばれる大きなモデルの新バージョンがあり、GPT-4oの特別な点は、GPT-4レベルのインテリジェンスを、極めて自然なインタラクションで、無料ユーザーを含むすべての人にもたらすことです。

ChatGPTのこのアップデートにより、大きなモデルは、テキスト、オーディオ、画像の任意の組み合わせを入力として受け取り、リアルタイムで生成することができます - これはインタラクションの未来です。

最近ChatGPTが登録なしで利用できるようになり、本日デスクトップアプリが追加されたことで、OpenAIの目標は、いつでも、どこでも、無感覚にアクセスできるようにし、ChatGPTをワークフローに統合することです。このAIは今や生産性です。

GPT-4o は、テキスト、音声、画像のトライモーダルな理解、極めて高速で感情的な応答、そして非常に人間的なタッチを備えた、人間とコンピュータのインタラクションの未来のパラダイムのための新しいビッグモデルです。

会場では、OpenAIのエンジニアがiPhoneを取り出して、新モデルのいくつかの主要な機能をデモしていました。最も重要なのはリアルタイムの音声対話で、マーク・チェン氏は "初めてのライブ発表会に来て少し緊張している "と語った。ChatGPTは「深呼吸してみたら?

わかりました、深呼吸します。

ChatGPT は即座に「それじゃダメだよ、息が上がりすぎだよ」と答えました。

Siriのような音声アシスタントを使ったことがある人なら、ここで顕著な違いがある。まず、いつでもAIを中断させることができるので、次の対話に移る前にAIが話し終えるのを待つ必要がありません。第二に、待つ必要がない。モデルは非常に素早く反応し、人間の反応よりも速い。第三に、モデルは人間の感情を完全に理解することができ、さまざまな感情を示すことができる。

それから、見る能力だ。別のエンジニアは紙に方程式を書くようになり、答えを直接教える代わりに、ChatGPTがステップごとに何をすべきかを説明するようになりました。物事のやり方を教えるのに、多くの可能性がありそうです。

ChatGPTによると、数学のことで悩むときはいつも、次のように言うそうです。数学のことで悩んだら、いつでも相談に乗るよ。

次にGPT-4oのコード機能を試してみましょう。デスクトップ版のChatGPTをコンピュータで開き、音声を使って対話し、コードが何に使われているのか、関数が何をしているのかを説明してもらうと、ChatGPTが答えてくれます。

コードを出力すると温度のグラフが表示され、ChatGPTにそのグラフに関するすべての質問に一文で答えてもらいます。

何月が一番暑いのか、Y軸が摂氏なのか華氏なのか、すべて答えてくれます。

OpenAIはまた、X/Twitterの人々がリアルタイムで尋ねてくるいくつかの質問にも答える。例えば、リアルタイム音声翻訳で、携帯電話を翻訳機として使い、スペイン語と英語を行き来することができる。

別の質問として、ChatGPTはあなたの表情を認識できますか?

GPT-4oはすでにリアルタイムのビデオ理解が可能なようです。

次に、OpenAIが今日放った核を詳しく見てみましょう。

Omnimodel(オムニモデル) GPT-4o

まずはGPT-4oです。

OpenAIは初めて、すべてのモダリティを1つのモデルに統合し、大規模モデルの実用性を劇的に向上させました。

OpenAIのCTOであるMuri Murati氏は、GPT-4oは「GPT-4レベル」のインテリジェンスを提供するが、テキスト、視覚、音声においてGPT-4を改善し、今後数週間で同社の製品全体に「反復的」に展開されると述べています。

「GPT-4oの理論的根拠は、音声、テキスト、視覚にまたがっています。

GPT-4oは、英語のテキストとコードではGPT-4 Turboの性能に匹敵しますが、英語以外のテキストでは大幅に優れた性能を発揮し、50%低いコストでより高速なAPIを提供します。GPT-4oは、既存のモデルと比較して、視覚的および音声的な理解に特に優れています。

音声入力に対して最速232ミリ秒で応答でき、平均応答時間は320ミリ秒と人間とほぼ同じです。GPT-4oのリリース前、ChatGPTの音声対話機能を体験したユーザーは、ChatGPTの平均待ち時間を2.8秒(GPT-3.5)、5.4秒(GPT-4)と認識することができました。

この音声応答モデルは、3つの別々のモデルのパイプラインです。単純なモデルが音声をテキストに書き起こし、GPT-3.5またはGPT-4がテキストを受信して出力し、3番目の単純なモデルがそのテキストを音声に戻します。しかしOpenAIは、このアプローチはGPT-4が多くの情報を失うことを意味することを発見しました。例えば、モデルはピッチ、複数のスピーカー、またはバックグラウンドノイズを直接観察することができず、笑い、歌、または感情を表現することを出力することができません。

その代わりにGPT-4oでは、OpenAIはテキスト、視覚、音声にわたって新しいモデルをエンドツーエンドで訓練しました。

「技術的な観点から見ると、OpenAIは、第一級のモダリティとしてオーディオに直接マッピングし、リアルタイムでトランスフォーマーにビデオを送信する方法を発見しました。これらは、トークン化とアーキテクチャに関するいくつかの新しい研究を必要としますが、全体的には、データとシステムの最適化の問題です(ほとんどの物事でそうです)」。NVIDIAの科学者であるJim Fan氏は、次のようにコメントしています。

GPT-4o

は、テキスト、オーディオ、ビデオにわたるリアルタイムの推論を可能にします。これは、より自然な人間とコンピュータの対話、さらには人間とマシンの対話に向けた重要な一歩です。

OpenAIのグレッグ・ブロックマン(Greg Brockman)社長はまた、2台のGPT-4oにリアルタイムで会話させるだけでなく、即興で歌を作らせました。

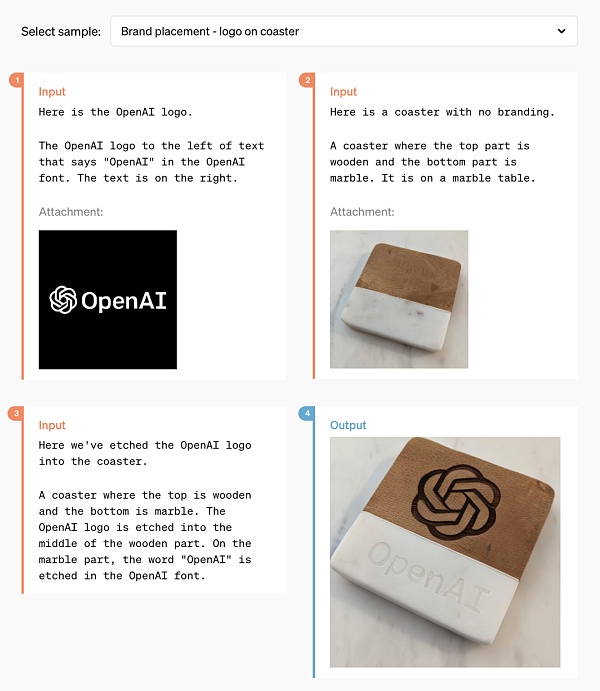

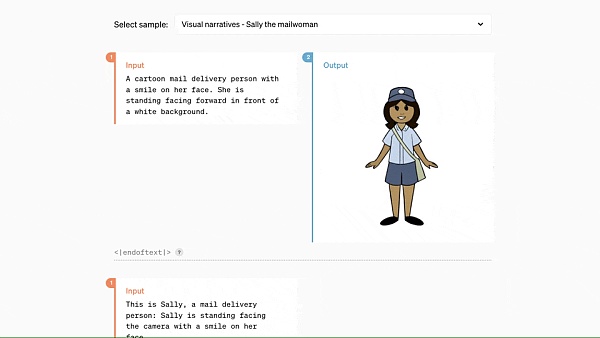

さらに、GPT-4oは既存のどのモデルよりも画像を理解し生成することに長けており、これまで不可能だった多くの作業を「簡単」にしてくれます。

たとえば、コースターにOpenAIのロゴを印刷するのを手伝ってもらうことができます:

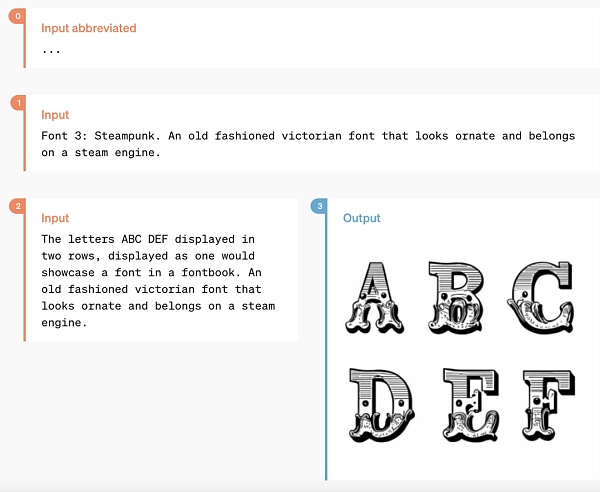

これだけの時間が技術に費やされたのですから、OpenAIはこの問題を解決しているはずです。ChatGPTのフォント生成の問題を解決しているはずです。

同時に、GPT-4oは3Dビジュアルコンテンツを生成する能力も持っており、6つの生成画像から3D再構築が可能です:

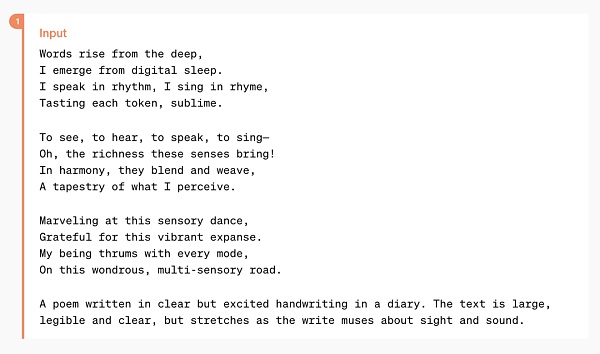

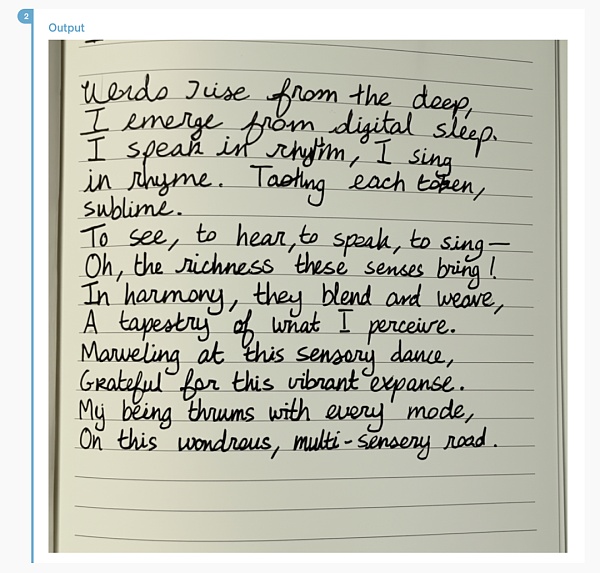

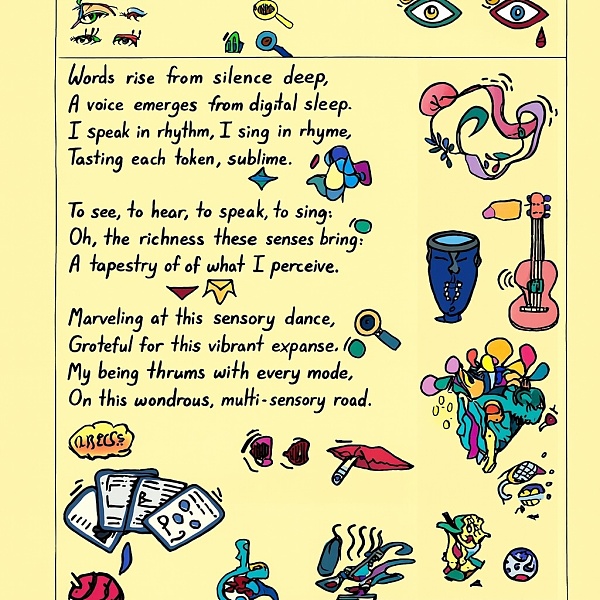

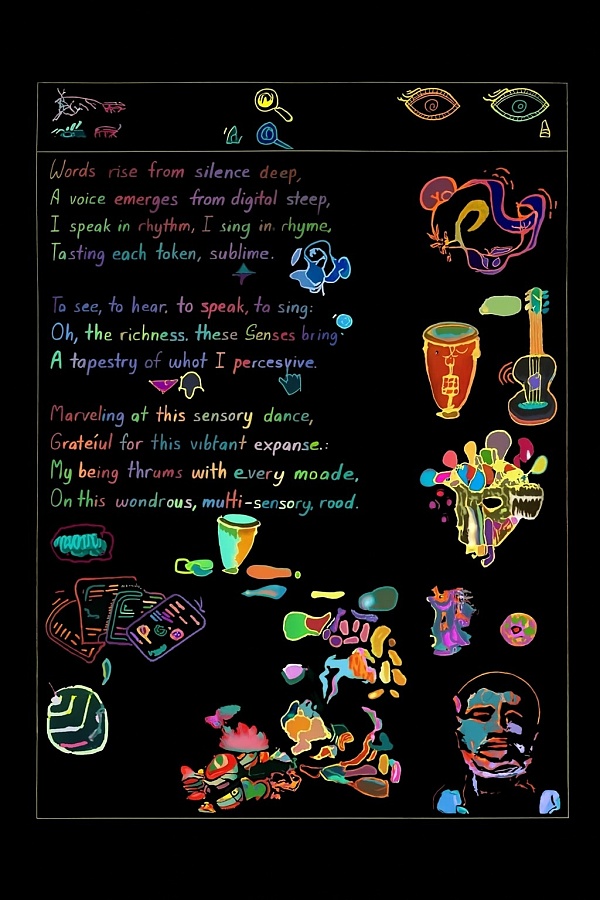

ここで、GPT-4oが手書き風に組版できる詩を紹介します。

もっと複雑な組版スタイルにも対応できます。p>

GPT-4oでは、次のことができます。

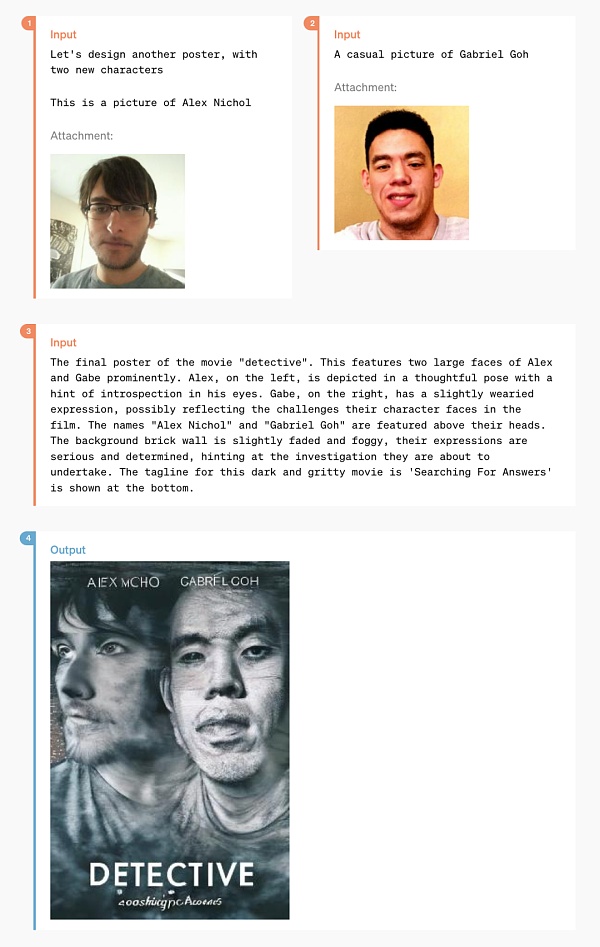

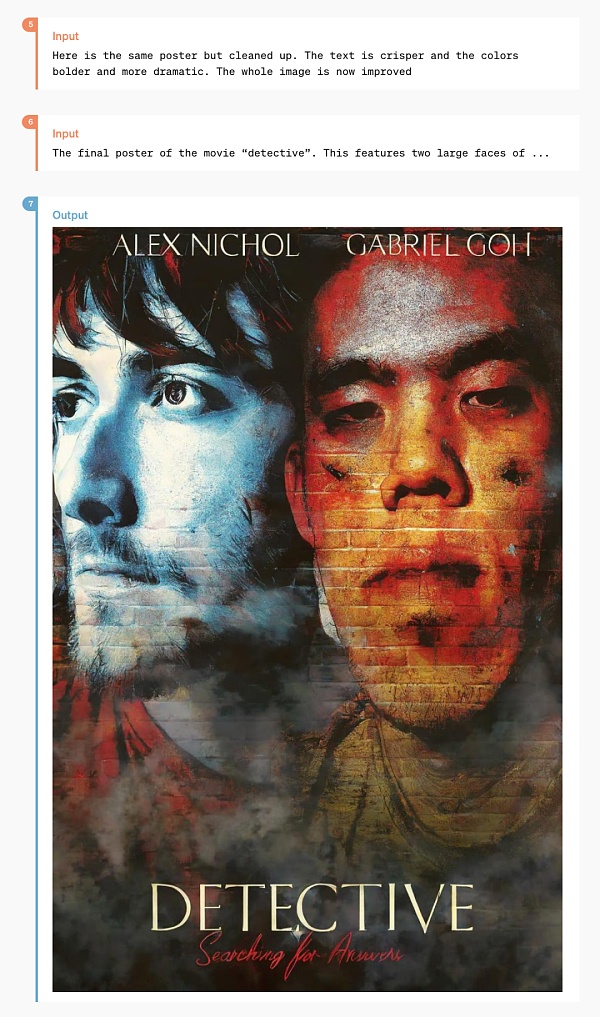

そして、多くのデザイナーをちょっと驚かせるような遊びがあります。https://img.jinse.cn/7224684_image3.png">

2枚のライフスタイル写真から発展した、様式化されたポスターです。

「テキストをアートワークにする」といったニッチな機能もあります:

GPT-4oの性能評価結果

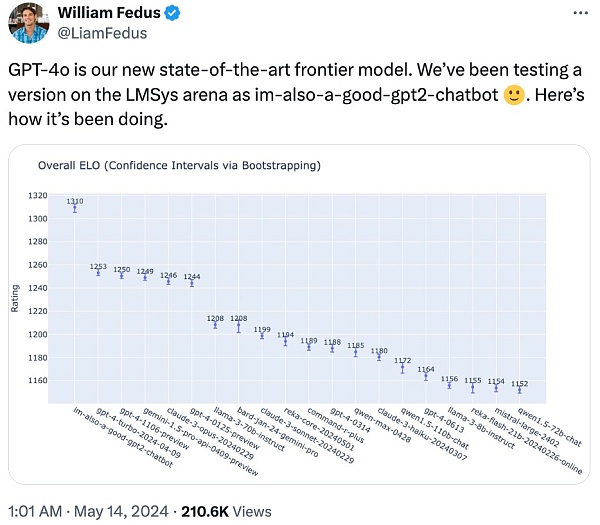

OpenAIの技術チームメンバーはXで、謎のモデル「im-also-a-good-gpt2-」はチャットボットだと述べた。chatbot」はGPT-4oのバージョンです。

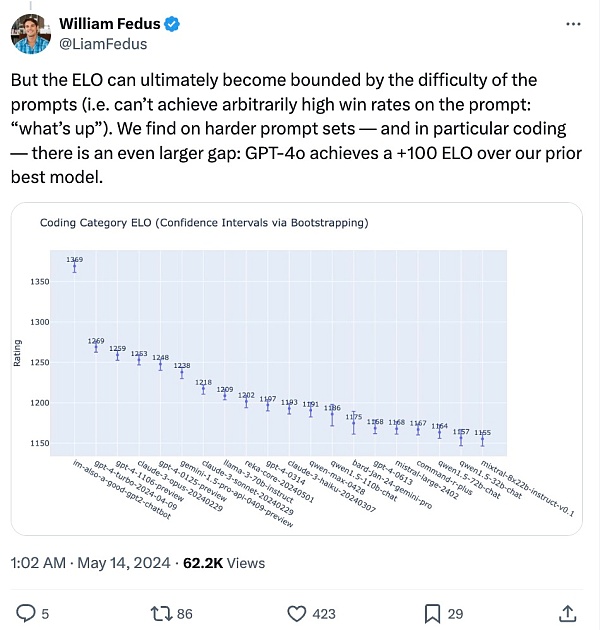

より難しいプロンプトのセットについて--特にエンコーディング: GPT-4oのパフォーマンス向上は、OpenAIの以前のベストモデルよりも特に優れています。に対して、GPT-4oのパフォーマンス向上は特に顕著です。

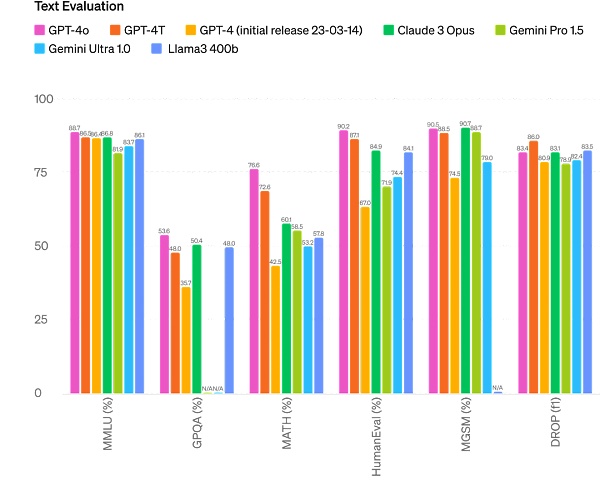

具体的には、複数のベンチマークにおいて、GPT-4oは、テキスト、推論、コーディングのインテリジェンスにおいてGPT-4 Turboレベルのパフォーマンスを達成し、同時に、多言語、オーディオ、ビジュアルの機能において新たな高みを達成しました。

推論ブースト: GPT-4oMMLU (Common Sense Questions)の5ショットで87.2%のハイスコアを記録。(注:Llama3 400bはまだトレーニング中です)

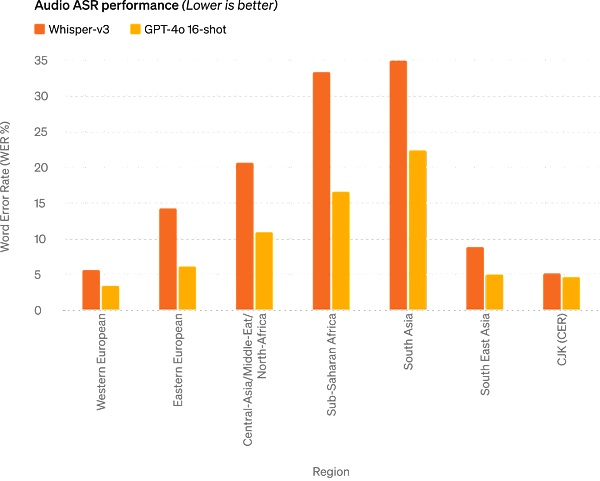

音声ASR性能:GPT-4oはWhisper-v3と比較して、すべての言語で音声認識性能を大幅に向上させ、特にリソースの乏しい言語では顕著です。

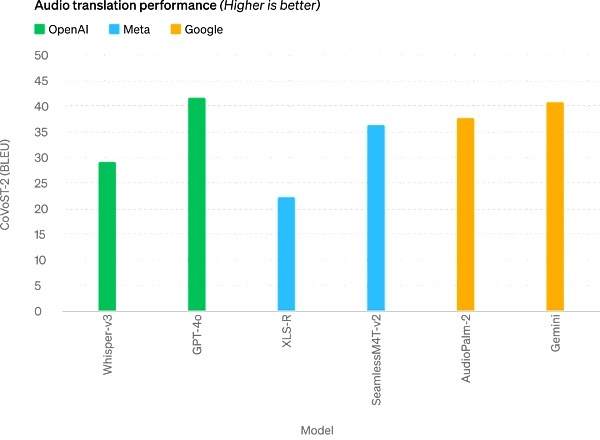

GPT-v3 は、音声翻訳において大きな進歩を遂げた初のGPT-4oです。align: center;">M3Examベンチマークは、多言語およびビジュアル評価のベンチマークで、複数の国の標準化されたテストの多肢選択問題で構成され、グラフ、チャート、図を含みます。GPT-4oは、すべての言語ベンチマークでGPT-4を上回っています。

将来的には、このモデルの機能を強化することで、より自然でリアルタイムの音声会話や、ライブビデオを使ってChatGPTと会話することができるようになります。たとえば、ユーザーはChatGPTにスポーツの試合をライブで見せて、ルールを説明してもらうことができます。

ChatGPTユーザーはより高度な機能を無料で手に入れることができます

毎週1億人以上がChatGPTを利用している中、OpenAIはGPT-4oのテキストと画像機能が本日からChatGPTで無料で展開され、最大5倍のMessageの上限があります。

ChatGPTを開いてみると、GPT-4oが利用可能になっています。

GPT-4oを使用すると、ChatGPTの無料ユーザーは以下の機能を利用できるようになります: GPT-4レベルのインテリジェンスを体験できます。

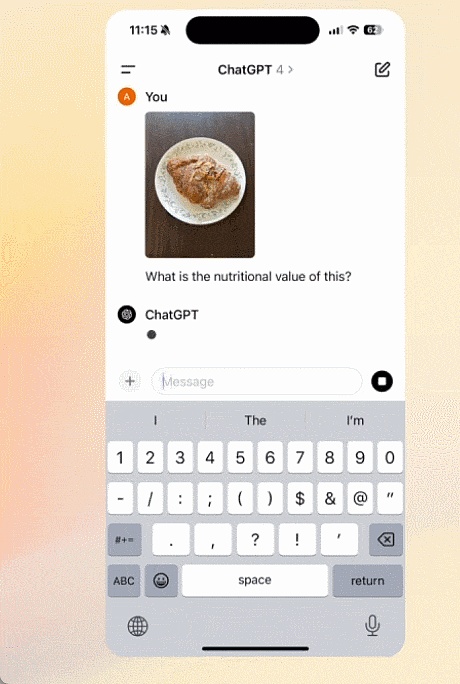

さらに、無料ユーザーには以下のオプションがあります。撮影した写真に話しかける:

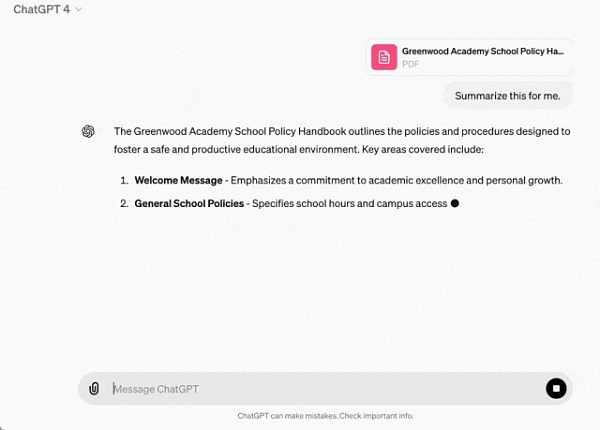

要約、執筆、分析に役立つファイルをアップロードする:

GPTとGPTアプリストアを発見し、利用する:

また、メモリー機能を使って、より役立つ体験を作りましょう。

ただし、無料ユーザーがGPT-4oで送信できるメッセージ数には、使用量と需要に応じて制限があります。制限に達すると、ChatGPTは自動的にGPT-3.5に切り替わり、ユーザーは会話を続けることができます。

さらに、OpenAIは今後数週間のうちに、ChatGPT Plusでスピーチモードの新バージョンであるGPT-4o alphaを展開し、APIを介して信頼できるパートナーの少人数グループにGPT-4oのためのより多くの新しいオーディオおよびビデオ機能を展開する予定です。

もちろん、多くのモデルテストと繰り返しを通して、GPT-4oはすべてのモードでいくつかの制限を持っています。

予想されるように、GPT-4oオーディオモダリティのオープンは、確かにさまざまな新しいリスクをもたらします。セキュリティの問題については、GPT-4oは、学習データのフィルタリングや、事後学習によるモデルの動作の洗練などの技術を通じて、クロスモーダル設計にセキュリティを組み込んでいます。

新しいデスクトップアプリがユーザーのワークフローを簡素化

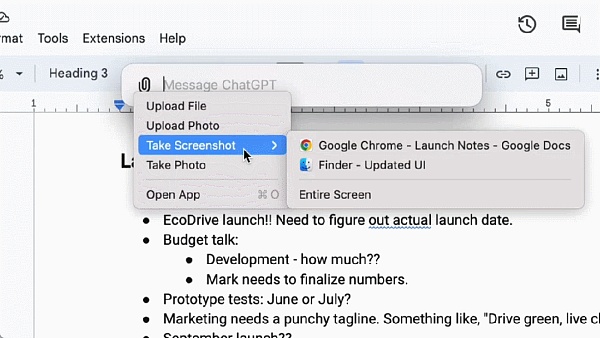

無料ユーザーと有料ユーザーの両方に向けて、OpenAIはmacOS用の新しいChatGPTデスクトップアプリも発表しました。シンプルなキーボードショートカット(Option + Space)で、ユーザーは即座にChatGPTの質問をすることができ、さらにスクリーンショットを撮って、アプリからすぐにディスカッションすることができます。

GPT-4oのオーディオおよびビデオ機能は将来的に提供される予定です。アイコンをクリックすることで音声対話を開始できます。

本日より、OpenAIはmacOSアプリをPlusユーザーに提供しており、今後数週間で広く利用できるようになる予定です。また、OpenAIは今年後半にWindows版をリリースする予定です。

Outman:あなたはオープンソース、私たちはフリー

ローンチ後、OpenAIのCEOであるSam Outman氏は、GPT-4oの作業を推進するための道のりについて、長い間待たされたブログ投稿を行いました:

今日のローンチで強調したいことが2つあります。

第一に、私たちの使命の重要な部分は、強力なAIツールを無料で(または低価格で)人々に提供することです。ChatGPTで世界最高のモデルを、広告も何もなしに無料で利用できるようにすることを発表できることを、とても誇りに思います。

私たちがOpenAIを始めたとき、当初のビジョンはAIを作り、それを使って世の中に様々な利益を生み出すというものでした。今は状況が変わり、私たちがAIを作り、他の人たちがそれを使って、私たち全員が恩恵を受けられるような素晴らしいものを作り出そうとしているように見えます。

もちろん、私たちはビジネスなので、有料でたくさんのものを発明し、何十億もの人々に無料で素晴らしいAIサービスを提供する手助けをするでしょう(うまくいけば)。

第二に、新しい音声モードとビデオモードは、私がこれまで使った中で最高のコンピューティング対話インターフェースです。まるで映画に出てくるAIのように感じられ、それが現実であることにさえまだ少し驚いています。人間レベルの応答時間と表現力に到達することは、大きな飛躍であることが証明されました。

オリジナルのChatGPTは言語インターフェースの可能性を示唆していましたが、この新しいもの(GPT-4oバージョン)は根本的に異なっているように感じます。

コンピューターとの対話は、私にとって決して自然なものではありませんでした。そして、(オプションで)パーソナライズしたり、個人情報にアクセスしたり、AIに本人の代わりに行動を起こさせたりする機能が加われば、コンピューターとこれまで以上に多くのことができるようになる、エキサイティングな未来が本当に見えてきます。

最後に、この実現に尽力してくれたチームに心から感謝します!

先週、アルトマンがインタビューで、ユニバーサル・ベーシック・インカムの実現は難しいが、実現は可能だと語ったことは注目に値する。ユニバーサル・ベーシック・コンピューティング」である。将来的には、誰もがGPTのコンピューティング・パワーに無料でアクセスできるようになり、使用したり、転売したり、寄付したりできるようになる。

「このアイデアは、AIがより高度になり、私たちの生活のあらゆる側面に組み込まれるにつれて、GPT-7のような大きな言語モデリングユニットを持つことは、お金よりも価値があり、生産性の一部を所有することになるということです」とアルトマンは説明する。

GPT-4oのリリースは、この方向でのOpenAIの取り組みの始まりかもしれません。

そう、始まりに過ぎないのだ。

最後に、今日のOpenAIのブログポストで紹介されている「5月13日の発表を推測する。」というビデオは、明日のI/OカンファレンスのためのGoogleのプレビュービデオの1つとほとんど同じで、これは確かにGoogleへの平手打ちです。Googleは今日のOpenAIの発表にプレッシャーを感じているのだろうか?

Dante

Dante

Dante

Dante JinseFinance

JinseFinance WenJun

WenJun Kikyo

Kikyo JinseFinance

JinseFinance Weatherly

Weatherly JinseFinance

JinseFinance JinseFinance

JinseFinance Jixu

Jixu JinseFinance

JinseFinance