By Eugene Cheah Compiled by J1N, Techub News

AIコンピューティング・パワーのコスト低下は、低コストのリソースでイノベーションを起こす新興企業のブームを刺激することになりそうだ。

昨年は、AIコンピューティング・パワーの供給が逼迫していたため、H100は1時間あたり8ドルもの価格でレンタルされていたが、市場にパワーが供給過剰になっている現在、価格は1時間あたり2ドル以下まで下がっている。これは、初期にリースを契約した企業の一部が、余剰電力を無駄にしないために、予約した計算リソースの転売を開始したことと、市場のほとんどがオープンソースモデルを選択し、その結果、新モデルの需要が少なくなったことによる。現在、市場におけるH100sの供給は需要をはるかに上回っており、H100sを購入するよりもレンタルする方が費用対効果が高く、新しいH100sに投資することはもはや有益ではありません。

AIレースの簡単な歴史

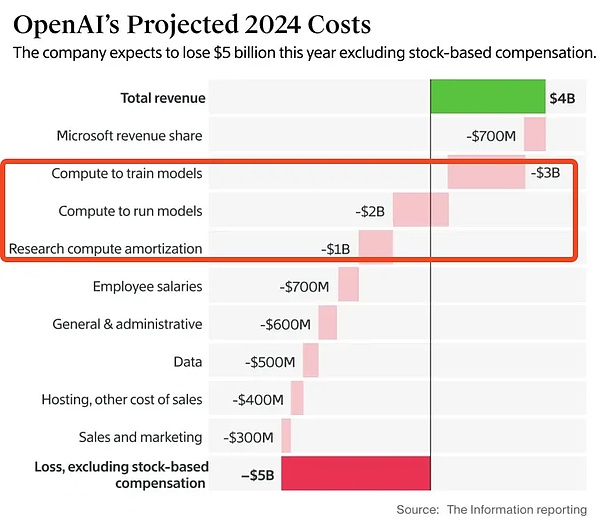

市場におけるGPUコンピューティング・パワーの価格は高騰し、H100は当初1時間あたり約4.70ドルでレンタルされ、最高で8ドル以上にまで上昇した。これは、プロジェクトの創設者たちが、次の資金調達ラウンドを達成し、投資家を説得するために、急いでAIモデルをトレーニングしなければならなかったためです。

ChatGPTはA100シリーズのGPUを使用して2022年11月にローンチし、2023年3月にNVIDIAは新しいH100シリーズのGPUを発表した。

これはAIスタートアップにとって大きな魅力です。GPUの性能は、開発可能なAIモデルの速度と規模を直接決定するため、H100のパワーは、これらの企業がこれまで以上に高速で、より大きく、より効率的なAIモデルを開発できることを意味し、OpenAIのような業界リーダーに追いつき、追い越す可能性さえあります。

H100の性能が大幅に向上し、AI分野での競争が激化しているため、多くの新興企業が巨額の資金を投じてH100を購入し、モデルのトレーニングを加速させている。この需要の急増は、H100のレンタル価格の高騰につながり、当初は1時間あたり4.70ドルだったが、その後8ドル以上にまで上昇した。

これらの新興企業が高いレンタル料を支払うことを厭わなかったのは、次の資金調達ラウンドで数億ドルの投資家の目に留まり、事業の規模を拡大し続けられるだけの速さでモデルをトレーニングすることを切望していたからだ。

H100GPUをたくさん備えた演算センターでは、GPUをリースする需要がありました。GPUのリース需要は非常に高く、H100 GPUを大量に保有する演算センター(ファーム)にとっては、「玄関先にお金がある」ようなものです。というのも、こうしたAIスタートアップ企業は、モデルを訓練するためにH100をレンタルすることを熱望しており、前払いすることさえ厭わないからだ。

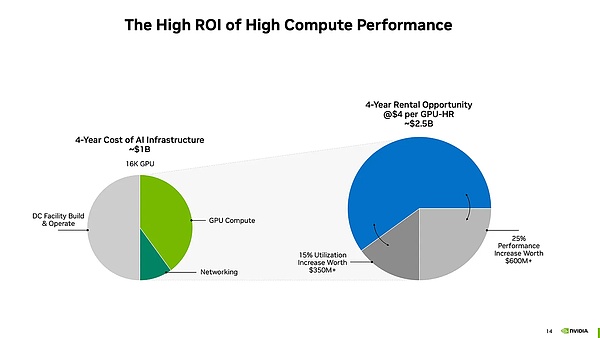

計算によると、GPUファームがそのレートでGPUを貸し出し続けることができれば、H100への投資の回収期間(購入コストを回収するのにかかる期間)は1.5年未満になります。その投資回収期間が終了した時点で、各GPUは年間10万ドル以上の純キャッシュフロー収入を生み出すことになります。

H100やその他の高性能GPUの需要が増加し続けるにつれ、GPUファームの投資家たちは、ビジネスモデルに同意するだけでなく、さらに多くのGPUに投資して、さらに多くの利益を上げることができるようになりました。

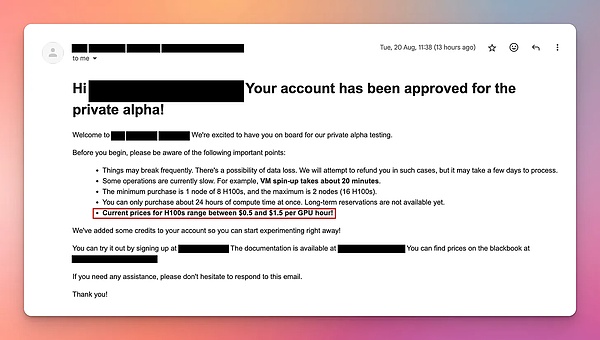

チューリップの愚行。記録史上初の投機バブルをきっかけに作られたチューリップの価格は、1634年に上昇を続け、1637年2月に暴落しました

人工知能とビッグデータ処理の需要が高まるにつれ、高性能GPU(特にNVIDIAのH100)に対する企業の需要が急増しています。需要が急増し、これらの計算集約的なタスクをサポートするため、世界の企業は当初、GPUの購入やデータセンターの建設など、計算能力を高めるためのハードウェアやインフラに約6000億ドルを投資してきました。しかし、サプライチェーンの遅れにより、H100の価格は2023年の大半は高止まりし、購入者が多額の保証金を前払いしない限り、1時間当たり4.70ドルを超えることさえある。2024年初頭には、より多くの業者が市場に参入したため、H100のレンタル価格は約2.85ドルまで下がりましたが、供給が増えるにつれて市場での競争が激化したことを反映して、さまざまな販売メールが届くようになりました。

初期のH100 GPUは、当初8ドルから10ドルでリースされていました。は当初、1時間あたり8~16ドルでリースされていましたが、2024年8月までに、オークションベースのリース価格は1時間あたり1~2ドルまで下がりました。市場価格は年間40%以上下落すると予想され、エヌビディアが4年間予測した1時間当たり4ドルをはるかに上回る。この急速な価格下落は、高価格のGPUを新規購入したばかりのユーザーにとって、リースでコストを回収できないかもしれないという経済的なリスクを生み出します。

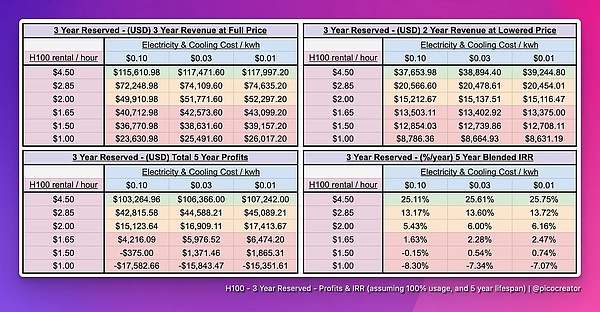

H100に50,000ドル投資した場合の資本収益率はどのくらいですか?

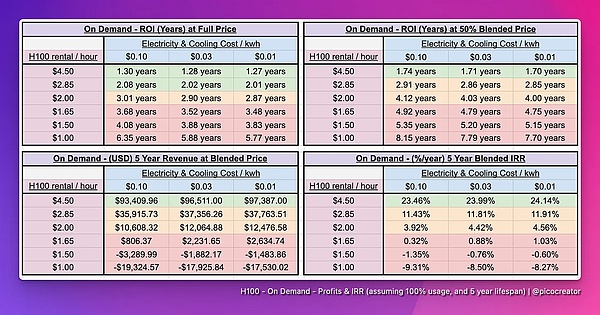

H100の購入費用は約5万ドルで、電力と冷却コストに関係なく、予測寿命は5年です。リースは通常、短期オンデマンドリースと長期予約の2つの形態で行われる。短期レンタルは割高だが柔軟性があり、長期予約は割安だが安定している。そして、この記事では、これら2つのモデルのリターンを分析し、投資家が5年以内にコストを回収し、利益を上げることができるかどうかを計算している。

短期オンデマンド賃貸

リース価格と対応する収益:

>$2.85 : 株式市場のIRRを上回る収益性。

<$2.85 : 株式市場のリターンを下回ります。

<$1.65 : 予想される投資損失。

「ブレンド価格」モデルでは、今後5年間で賃料が現在の価格の50%まで下落する可能性があると予測している。レンタル価格が1時間あたり4.50ドルのままであれば、投資収益率(IRR)は20%以上となり、採算が取れますが、価格が1時間あたり2.85ドルまで下がると、IRRはわずか10%となり、収益が大幅に減少します。価格が2.85ドルを下回ると、投資収益率は株式市場のリターンよりも低くなる可能性さえあり、価格が1.65ドルを下回ると、投資家は、特にH100サーバーを最近購入した人にとっては、損失を被る深刻なリスクにさらされることになります。

注:「混合価格」は、H100リース価格が今後5年間で現在の価格の半分まで徐々に下落するという仮定です。現在の市場価格は年率40%以上下落しているため、この試算は楽観的であると考えられ、価格引き下げを検討することは合理的である。

長期予約リース(3年以上)

長期予約リース(3年以上))

AIブームの際、多くの既存インフラプロバイダーは、過去の経験、特にGPUレンタル価格が急騰・急落した暗号通貨の初期イーサリアムPoW時代の経験に基づいて、2023年に利益を確定するために3~5年の高額先行リースを導入しました。こうした契約では通常、顧客は1時間あたり4ドル以上、あるいは50%から100%の前払いを要求される。AIの需要が急増するにつれ、特に画像生成の分野では、基本的なモデル企業は、市場に先駆けて最新のGPUクラスターをいち早く使用し、目標とするモデルを素早く完成させて競争力をつけるために、高価格にもかかわらずこうした契約を結ばざるを得なくなっている。しかし、モデルのトレーニングが完了すると、これらの企業はGPUリソースを必要としなくなりますが、契約上のロックインのため、簡単に撤退することができず、損失を最小限に抑えるために、これらのリースGPUリソースを転売して、コストの一部を回収することを選択します。その結果、市場には転売されたGPUリソースが大量に出回り、供給が増加しているため、リース価格と市場の需給に影響を与えています。

現在のH100バリューチェーン

注:バリューチェーンは、バリューチェーン分析、バリューチェーンモデルなどとも呼ばれ、1985年にマイケル・ポーターによって開発されました。1985年にマイケル・ポーターが『競争優位』の中で提唱した。ポーターは、独自の競争優位性を確立し、商品やサービスに高い付加価値を生み出すためには、企業のビジネスモデルを一連の付加価値プロセスに構造化することが経営戦略であり、この一連の付加価値プロセスが「バリューチェーン」であると指摘した。

H100のバリューチェーンは、ハードウェアからAI推論モデルまで、大きく以下のように分類できる

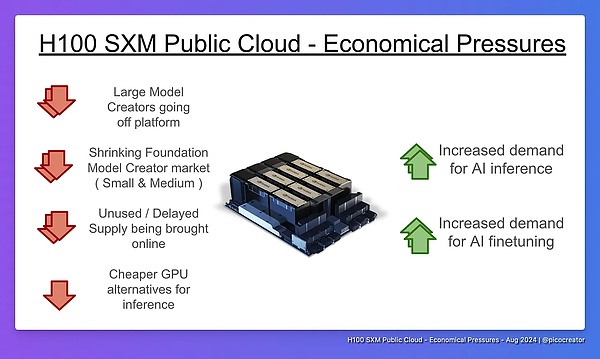

データセンター・インフラ・プロバイダーとパートナー

現在のH100のバリューチェーンには、ハードウェアベンダーからデータセンタープロバイダー、AIモデル開発企業、容量再販業者、AI推論サービスプロバイダーまで、複数のセグメントが含まれています。市場に対する主な圧力は、未使用のリソースを転売したり貸し出したりし続ける未使用のH100キャパシティの再販業者と、Llama 3などの「十分な」オープンソースモデルの普及によるもので、H100に対する需要の減少につながっている。これら2つの要因が相まって、H100の供給過剰が生じ、その結果、市場価格に下落圧力がかかっています。

市場トレンド:オープンソース・ウェイトの台頭モデルの台頭

オープンソース加重モデルとは、加重が無料で一般に配布され、正式なオープンソースライセンスがないにもかかわらず、商業的に広く使用されているモデルのことです。

これらのモデルの使用に対する需要は、LLaMA3やDeepSeek-v2のようなGPT-4に似た規模の大規模なオープンソースモデルの出現と、小規模(80億パラメータ)および中規模(700億パラメータ)の微調整モデルの成熟と広範な採用という、2つの主な要因によってもたらされています。

これらのオープンソースモデルの成熟度が高まっているため、企業はAIアプリケーションの大部分、特に推論と微調整に簡単にアクセスして使用することができます。これらのモデルは、一部のベンチマークではプロプライエタリ・モデルに若干劣るかもしれないが、ほとんどのビジネス・ユースケースでは十分な性能を発揮する。その結果、オープンソースの重み付けモデルが普及するにつれて、推論と微調整に対する市場の需要は急速に高まっています。

オープンソースの重み付けモデルには、3つの重要な利点もあります。

第1に、オープンソースのモデルは高い柔軟性を提供するため、ユーザーはモデルを特定のドメインやタスクに合わせて微調整し、さまざまなアプリケーションのシナリオによりよく適合させることができます。第二に、オープンソースモデルは、モデルの重みがいくつかのプロプライエタリモデルのように通知なしに更新されることがないため、信頼性を提供します。最後に、サードパーティのAPIエンドポイントを通じて、プロンプトや顧客データが漏洩しないことを組織が保証できるため、データプライバシーリスクが軽減され、セキュリティとプライバシーも保証されます。このような利点が、特に推論と微調整の分野において、オープンソースモデルの継続的な成長と広範な採用につながっているのです。

中小モデル作成者の需要シフト

中小モデル作成者とは、70Bパラメトリックモデルのような大規模な基本モデルをゼロからトレーニングする能力や計画を持たない企業や新興企業のことです。オープンソースモデルの台頭により、多くの企業は、既存のオープンソースモデルを微調整する方が、自社でゼロから新しいモデルをトレーニングするよりも費用対効果が高いことに気づきました。その結果、自社でモデルをトレーニングするのではなく、微調整を選択する企業が増えている。これにより、H100のような計算リソースの必要性を大幅に減らすことができます。

ファインチューニングは、ゼロからトレーニングするよりもはるかに安価です。既存のモデルを微調整することは、ベースモデルをゼロからトレーニングするよりもはるかに少ない計算リソースで済みます。大規模なベースモデルは通常、トレーニングに16台以上のH100ノードを必要とするが、ファインチューニングに必要なノードは通常1~4台である。この業界シフトは、中小企業向けの大規模クラスタの必要性を削減し、H100コンピューティング・パワーへの依存を直接的に減らします。

さらに、基盤となるモデルの構築への投資も少なくなります。2023年には、多くの中小企業が新たな基盤モデルの作成を試みましたが、今日では、イノベーション(より優れたアーキテクチャや数百の言語への対応など)をもたらさない限り、新たな基盤モデル作成プロジェクトはほとんどないでしょう。というのも、Llama 3のような強力なオープンソースモデルがすでに市場に出回っているため、中小企業が新モデルの作成を正当化するのは難しいからだ。また、投資家の関心や資金も、ゼロからモデルをトレーニングするよりも、微調整する方向にシフトしており、H100のリソースの必要性はさらに低下している。

最後に、予約ノードの過剰キャパシティも問題です。多くの企業が、2023年のピーク時に長期的にH100リソースを予約していましたが、微調整へのシフトの結果、ハードウェアの一部が陳腐化しても、これらの予約ノードがもはや必要ないことが判明しています。これらの未使用のH100ノードは現在、転売またはリースされており、市場での供給がさらに増加し、H100リソースの供給過剰につながっています。

全体として、モデルの微調整の人気、中小規模のベースモデルの作成の減少、および予約ノードの余剰により、H100市場では需要が大幅に減少し、供給過剰が増加しています。

GPUコンピューティングパワーの供給増加と需要減少に寄与するその他の要因

オープンソース・クラウドプラットフォームから離れる大規模モデル作成者

。Facebook、X.AI、OpenAIなどの大規模なAIモデル作成者が、パブリッククラウドプラットフォームから自作のプライベートコンピュータクラスターへと徐々に移行しているのには理由があります。第一に、既存のパブリック・クラウド・リソース(1,000ノードのクラスタなど)では、大規模なモデルをトレーニングするニーズに対応できなくなった。第二に、データセンターやサーバーなどの資産を購入することで企業の評価を高めることができるのに対し、パブリッククラウドを借りることは資産を強化しない単なる出費に過ぎないため、財務的な観点からは、自社でクラスターを構築する方が有益である。加えて、こうした企業は十分なリソースと専門家チームを持っており、小規模なデータセンター会社を買収してシステムの構築と管理を支援してもらっている。その結果、もはやパブリック・クラウドに頼ることはない。これらの企業がパブリック・クラウド・プラットフォームから離れると、コンピューティング・リソースに対する市場の需要が減少し、未使用のリソースが再び市場に参入して供給が増加する可能性があります。

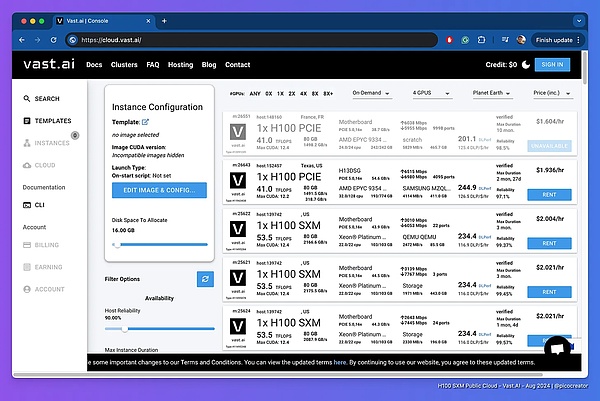

Vast.aiは基本的に自由市場システムであり、世界中のベンダーが互いに競争しています

Idle and delayed shipment of H100 coming online at the same time

H100GPUのアイドル出荷と遅延出荷が同時にオンラインになっています。Vast.aiのようなプラットフォームは、グローバルベンダーが互いに価格競争する自由市場モデルを採用しています。H100の出荷が遅れたために2023年にオンライン化が間に合わなかったリソースの多くは、新しいH200およびB200デバイス、新興企業やエンタープライズからの未使用のH100リソースとともに、現在市場に参入し始めています。新興企業やエンタープライズからの遊休コンピュート・リソース。中小規模のクラスタのオーナーは、通常8~64ノードを所有していますが、利用率が低く、資本が枯渇しているため、リソースを低価格で貸し出すことで、できるだけ早くコストを回収することを目指しています。特にオークション・モデルとフリー・マーケット・モデルは、リソースを確実にレンタルするためにベンダーが価格を競り下げるため、最終的に市場全体の価格が大幅に下落します。

Cheaper GPU alternatives

もう1つの大きな要因は、演算コストが予算外になれば、AI推論インフラには、特に小規模なモデルを実行する場合は、代替手段がいくらでもあるということです。特に小規模なモデルを実行している場合は。H100を使えば、インフィニバンドに追加料金を払う必要はありません。

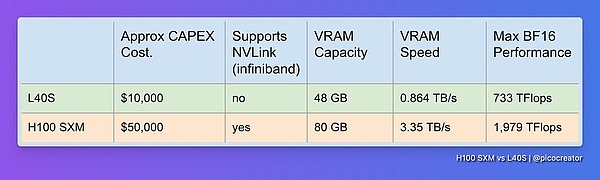

Nvidiaの市場セグメンテーション

AI推論タスク用のH100 GPUに代わる安価なGPUの出現は、H100の市場需要に直接的な影響を与えています。まず、H100はAIモデルのトレーニングや微調整には最適ですが、推論(モデルの実行)の分野では、特に小規模なモデルの需要を満たすことができる、より安価なGPUが数多く存在します。推論タスクは、インフィニバンド・ネットワークなど、H100のハイエンド機能を必要としないため、ユーザーはより手頃な代替品を選択することで、コストを節約することができます。

Nvidia自身も、推論市場において、H100のおよそ3分の1の性能と5分の1の価格を提供する推論専用GPUであるL40Sなどの代替製品を提供しています。L40Sは、マルチノードのトレーニングにはH100ほど効果的ではありませんが、シングルノードの推論や小規模クラスタの微調整には十分な性能を発揮し、より費用対効果の高い選択肢を提供します。

H100Infiniband Cluster Performance Configuration Table (August 2024)

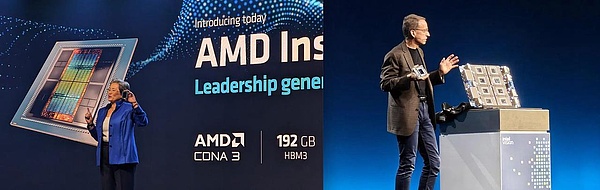

AMDとIntelの代替ベンダー

代替として、AMDとIntelは低価格のGPUを発表しました。これらのGPUは推論やシングルノード・タスクに優れており、H100よりも安価である一方、より多くのメモリと計算能力を備えています。これらのGPUは、大規模なマルチノード・クラスター・トレーニングについてはまだ十分に検証されていませんが、推論タスクについては十分に成熟しており、H100に代わる強力な選択肢となるでしょう。

これらの安価なGPUは、ほとんどの推論タスク、特にLLaMA 3などの一般的なモデルアーキテクチャの推論と微調整タスクを処理できることが証明されています。したがって、互換性の問題が解決されれば、ユーザーはコストを削減するためにこれらの代替GPUを選択することができます。要約すると、推論空間におけるこれらの代替GPUは、特に小規模な推論や微調整タスクにおいて、徐々にH100に取って代わりつつあり、H100の必要性をさらに減らしています。

Web3空間におけるGPU。使用量の減少

暗号通貨市場の変化により、暗号マイニングにおけるGPUの使用量は減少しており、その結果、大量のGPUがクラウド市場に流入しています。これらのGPUは、ハードウェアの制限により複雑なAIのトレーニングタスクには対応できませんが、より単純なAIの推論タスクでは優れた性能を発揮するため、特に小規模なモデル(10B以下のパラメータなど)を扱う予算が限られているユーザーにとっては、費用対効果の高い選択肢となります。大規模なモデルでも実行できるように最適化されたこれらのGPUは、H100ノードを使用するよりも低コストです。

AIコンピュートレンタルバブルの後、現在の市場はどうなっているのでしょうか?

今、参入することの問題点:新しいパブリッククラウドのH100クラスタは市場に参入するのが遅く、利益が出ない可能性があり、投資家の中には大損する人もいるかもしれない。

新規参入のH100パブリック・クラウド・クラスタの収益性の課題。レンタル価格が低すぎる(2.25ドル以下)場合、運用コストをカバーできず、損失につながる可能性があります。価格設定が高すぎる(3ドル以上)場合、顧客を失い、遊休容量になる可能性があります。さらに、後から参入したクラスターは、初期の高値(1時間当たり4ドル)に乗り遅れるため、コストを回収するのが難しく、投資家は利益を上げられないリスクを負うことになる。このため、クラスターへの投資は非常に難しく、投資家が大きな損失を被る可能性さえある。

早期参入者のメリット:早期に長期リースを契約した中規模または大規模のモデル・ビルダーは、すでに元を取り、利益を得ています

中規模または大規模のモデル・ビルダーは、H100コンピューティング・リソースを長期にわたってリースすることで、すでに価値を得ています。コンピューティング・リソースはすでに価値を得ており、これらのリソースのコストは融資時にカバーされています。コンピューティングリソースの一部は十分に活用されていませんが、これらの企業は、融資市場を通じて、現在および将来のモデルトレーニングにこれらのクラスタを使用することで価値を引き出しています。未使用のリソースであっても、再販やリースを通じて追加収入を得ることができるため、市場価格を下げ、悪影響を減らし、エコシステムに全体的にプラスの影響を与えている。

バブル崩壊後:安価なH100がオープンソースAIの採用の波を加速させる可能性

低価格のH100 GPUが利用可能になれば、オープンソースAIの成長が促進されるでしょう。H100の価格が下がれば、AI開発者やホビイストは、オープンソースの重み付けモデルをより安価に実行し、微調整できるようになり、これらのモデルをより広く採用できるようになります。GPT5++のような将来のクローズドソースモデルが大幅な技術的ブレークスルーを達成しない場合、オープンソースとクローズドソースのモデル間のギャップは縮小し、AIアプリケーションの成長を促進する。AIの推論と微調整のコストが下がれば、AI導入の新たな波が巻き起こり、市場全体の進歩が加速する可能性がある。

結論:新品のH100は買うな

今すぐ新品のH100 GPUに投資すれば、高い確率で損をする。しかし、プロジェクトが割安なH100を購入できたり、電力コストが安かったり、AI製品が市場で十分競争力がある場合など、特別な状況でのみ投資する意味があるかもしれません。投資を検討しているのであれば、より良い収益率を求めて他のセクターや株式市場に資金を投入することをお勧めする。

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Huang Bo

Huang Bo Olive

Olive Nell

Nell Cdixon

Cdixon Cointelegraph

Cointelegraph