著者:趙建⇦

1年前の1月27日。1月27日、「越ライトイヤー」はAI生成動画をテーマにしたサロンに参加し、AI動画生成はどれくらいのスピードで「ミッドジャーニー・モーメント」を迎えるのか、という興味深いやりとりがありました。

選択肢は、半年以内、1年以内、1~2年、あるいはそれ以上だった。

昨日、OpenAIは20日という正確な答えを発表しました。

OpenAIは昨日、新しいAI生成ビデオモデルであるSoraを発表しました。Soraは、目を見張るようなパフォーマンスの優位性とビデオ生成時間の最大60秒で、テキスト(GPT-4)と画像(DALL-E 3)に続くビデオ生成でも「リード」をとります。テキスト(GPT-4)、画像(DALL-E 3)の "先 "を行く。AGI(一般人工知能)に一歩近づいた。

なお、スターAI企業のStability AIは、もともと昨日、新しい動画モデル「SVD1.1」を発表していたが、そらと衝突したため、公式ツイートが削除され炎上している。

AI動画生成のリーダーの一人であるランウェイの共同設立者兼CEOのクリストバル・バレンズエラは、"ゲームは始まった(game on)"とツイートした。

OpenAIはまた、技術的な発表も行った。

しかし、1年ほど前のChatGPTのように、OpenAIの秘密は試行錯誤を重ねた「スケーリングの法則」です-ビデオモデルが "十分に大きい "とき。"大きい "と、知性を出現させる能力が生じる。

問題は、大きなモデルのトレーニングの「暴力的な美学」はほとんど誰もが知っているのに、なぜ今回OpenAIなのかということです。

1.データの秘密:トークンからパッチまで

動画を生成する技術的なルートは、主に4つの段階を経てきた。リカレント・ネットワーク (RNN)、生成的敵対ネットワーク (GAN)、自己回帰変換器、拡散モデルです。

今日、主要なビデオモデルのほとんどは、Runway、Pikaなどの拡散モデルです。

一方、Soraは新しい拡散変換モデルです。その名の通り、拡散モデルと自己回帰モデルの両方の特性を兼ね備えています。拡散変換アーキテクチャは、カリフォルニア大学バークレー校のWilliam Peebles氏とニューヨーク大学のSaining Xie氏によって2023年に提案されました。

この新しいモデルをトレーニングするには?技術文書の中で、OpenAIは、ビッグ・ランゲージ・モデルのトークンからヒントを得て、ビデオデータとしてパッチ(視覚的パッチ)を使用してビデオモデルを訓練する方法を提案している。トークンは、コード、数学、さまざまな自然言語など、テキストの複数のモードをエレガントに統合し、パッチはは画像と動画を統合する。

OpenAIは、視覚データの次元を減らすためにネットワークを訓練した。Sora は、この圧縮された潜在的な空間でトレーニングされ、その後ビデオを生成します。OpenAI はまた、結果の潜在的な表現をピクセル空間にマップする対応するデコーダー モデルもトレーニングします。

OpenAIによると、画像とビデオを生成するための過去の方法は、通常、標準サイズにビデオをリサイズ、クロップ、またはトリミングしており、例えば、256x256の解像度を持つ4秒のビデオなど、生成されたビデオの品質を低下させています。画像とビデオデータをパッチすることで、データを圧縮することなく、異なる解像度、持続時間、アスペクト比のビデオや画像の生データでトレーニングすることが可能です。

データ処理へのこのアプローチは、モデル学習に2つの利点をもたらします。

まず、サンプリングの柔軟性です。Soraは、ワイドスクリーンの1920x1080pビデオ、垂直の1080x1920ビデオ、およびその間のすべてをサンプリングして、さまざまなデバイス用のネイティブのアスペクト比でコンテンツを直接作成できます。これらはすべて同じモデルを使用しています。

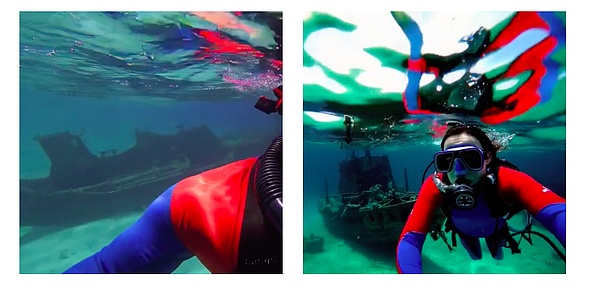

2つ目は、フレーミングと構図の改善です。構図。OpenAIは、動画を元のアスペクト比でトレーニングすることで、フレーミングとフレーミングが改善されることを経験的に発見しました。たとえば、すべてのトレーニング動画を正方形に切り抜く一般的なモデルでは、被写体の一部しか見えない動画が生成されることがあります。対照的に、Soraのビデオフレーミングは改善される。

Model trained on square crops (left), Sora's model (right)

言語理解のレベルでは、OpenAIは、非常に説明的なビデオ字幕でトレーニングすることで、ビデオの全体的な品質だけでなく、テキストの忠実度も向上することを発見しました。

これを行うために、OpenAIはDALL-E 3で導入された「再キャプション化技術」を適用します。OpenAIは、DALL-E 3で導入された「再キャプション化技術」を使って、まず記述性の高いキャプション生成モデルを訓練し、それを使って訓練データセットの動画にテキストキャプションを生成します。

さらに、DALL-E 3と同様に、OpenAIはGPTを使用して、短いユーザープロンプトを長い詳細なキャプションに変換し、ビデオモデルに送信します。これにより、Soraはユーザーのプロンプトに正確に従った高品質のビデオを生成することができます。

Cue word: カラフルなお祭りの最中、インドのムンバイを楽しく散歩する、青いジーンズと白いTシャツを着た女性。

Cue word: カラフルなお祭りの最中、インドのムンバイを楽しく散歩する、青いジーンズと白いTシャツを着た女性。

Soraはテキストからビデオに加えて、画像からビデオ、ビデオからビデオもサポートしています。

Cue word: 飾り立てられた歴史的なホールで、巨大な高波が。歴史的なホールで、巨大な高波がピークに達し、砕け始める。 瞬間をとらえた2人のサーファーが、波の面を巧みに操る。

この機能により、Soraはさまざまな画像やビデオの編集作業を行うことができ、完璧なループビデオの作成、静止画のアニメーション化、ビデオの時間的な前方または後方への拡大などが可能になります。

2.コンピューティングの極意:やはり「暴力の美学」

Soraの技術資料の中で、OpenAIはモデルの技術的な詳細を明らかにせず(イーロン・マスクはかつて、OpenAIは意図したほど「オープン」ではないと非難した)、むしろ以下のような核となる考えを表明している。

OpenAIは2020年、モデルトレーニングの秘訣である「スケーリングの法則」を初めて紹介した。スケーリングの法則によれば、言語モデルだけでなく、マルチモーダルモデルにおいても、大きな計算能力、大きなパラメータ、大きなデータに基づいて、モデルの性能はムーアの法則のように向上し続けます。

OpenAIはこの「暴力的な美学」に従い、大規模言語モデルの創発力を発見し、最終的に画期的なChatGPTを開発しました。

Soraモデルも同様で、スケーリングの法則のおかげで、2024年2月に何の前触れもなくビデオの「Midjourney moment」にぶつかった。

OpenAIによると、トランスフォーマーは言語モデリング、コンピュータビジョン、画像生成、ビデオ生成など、さまざまな分野で優れたスケーリング特性を示しています。下図は、トレーニング中の同じサンプルでトレーニング計算のサイズが大きくなるにつれて、ビデオの品質が大幅に向上することを示しています。

OpenAIは、動画モデルが大規模なトレーニング中に多くの興味深い特徴を示すことを発見しました。トレーニングにより、Soraが現実世界の人、動物、環境の特定の側面をシミュレートすることを可能にする、多くの興味深い特徴が出現することがわかりました。これらの特性の出現は、3Dやオブジェクトなどへの明示的な帰納的バイアスはなく、純粋にモデルのスケーリング現象です。

そのため、OpenAIはビデオ生成されたモデルを「ワールドシミュレーター」、または「ワールドモデル」と名付けました。

そこでOpenAIは、ビデオ生成モデルを「世界シミュレーター」、つまり「世界モデル」と名付けました>-これは、人間が世界を理解する方法を機械が学習できるようにすると解釈できます。

NVIDIAの科学者であるジム・ファン(Jim Fan)氏は次のように述べています。もう一度考えてみてください。 Soraはデータ駆動型の物理エンジンです。現実とファンタジーの両方の世界のシミュレーションです。シミュレータは、レンダリングの複雑さ、「直感的な」物理学、長期的な推論、そして意味的な基礎を、いくつかのノイズ除去やグラデーション数学を通して学びます。"

メタのチーフサイエンティストであるヤン・ルクンは、2023年6月にワールドモデルのコンセプトを提案しており、2023年12月にランウェイは次のユニバーサルワールドモデルを正式に発表し、生成AIで世界全体をシミュレートすると主張した。

そしてOpenAIは、すでに慣れ親しんでいたスケーリング法則を使うだけで、世界をモデル化する能力をSoraに与えた。OpenAIは、"私たちの結果は、ビデオ生成モデルを拡張することが、物理世界の汎用シミュレータを構築するための有望な道であることを示唆しています。"と述べています。

具体的には、Soraの世界モデルには3つの特徴があります:

3Dの一貫性。Soraは、動的なカメラの動きを持つビデオを生成できます。カメラが動いたり回転したりすると、人物やシーンの要素が 3D 空間内で一貫して動きます。

RemoteCorrelation およびオブジェクトの永続性。動画生成システムの大きな課題は、長い動画をサンプリングするときに時間的な一貫性を維持することです。OpenAIは、Soraが短期的な依存性と長期的な依存性の両方を効果的にモデル化できることを発見しました。例えば、Soraは人物、動物、オブジェクトがフレームから外れていても、それらを保持することができます。同様に、1つのサンプルで同じキャラクターの複数のショットを生成し、ビデオ全体を通してその外観を維持することができます。

世界との対話。Soraは、簡単な方法で世界の状態に影響を与えるアクションをシミュレートできることがあります。たとえば、画家はキャンバスに新しいストロークを残すことができます。

デジタル世界をシミュレートする。 Soraは人工的なプロセスをシミュレートすることもできます。 Soraは、世界とそのダイナミクスを忠実にレンダリングすると同時に、基本的な戦略によってMy Worldのプレイヤーをコントロールすることができます。これらの能力は、"My World "に言及したタイトルでソラをプロンプトすることで、ゼロ射撃で達成することができます。

しかし、他の大きなモデルと同様に、Soraはまだ完璧なモデルではなく、ガラスを割るなどの基本的な相互作用の物理的プロセスの多くを正確にシミュレートできないため、OpenAIは多くの限界があることを認めています。他の相互作用(食べ物を食べるなど)は、常に物体の状態に正しい変化をもたらすとは限りません。

3.算数はコアコンピテンシーか?

なぜOpenAIは「スケーリングの法則」に何度も頼ることができたのでしょうか。なぜOpenAIは「スケーリングの法則」に頼ることができるが、他のものはできないのか?

AGIへの信念や技術への固執など、おそらく多くの理由を見つけることができるでしょう。しかし、1つの現実として、スケーリング法則をサポートするには、OpenAIが得意とする演算能力の高い支出が必要です。

このように、ビデオモデリングは言語モデリングに少し似ており、パラメータをエンジニアリングするチームの能力、そして計算能力についてです。

結局のところ、これは明らかにNVIDIAにとって別のチャンスです。このAIブームに後押しされ、NVIDIAの市場価値は上昇し、AmazonとGoogleの両方を追い越しました。

動画モデルのトレーニングは、言語モデルよりも演算量が多くなる可能性があります。世界的なコンピューティング・パワー不足の中、OpenAIはどのようにこの問題を解決するのだろうか?OpenAIがコアを構築するという以前の噂と組み合わせれば、理にかなっているように思えます。

昨年来、OpenAIのCEOであるサム・アルトマンは、コードネーム「Tigris」と呼ばれるチップ製造プロジェクトのために、80億ドルから100億ドルの資金調達に取り組んできた。これは、Nvidiaのものに対抗できるGoogleのTPUに似たAIチップを製造し、OpenAIの運営コストとサービスコストを下げることを期待してのことだ。OpenAIは運営とサービスのコストを下げる。

オルトマン氏は2024年1月にも韓国を訪れ、チップ分野での協力を求めてサムスン電子やSKハイニックスの韓国幹部と会談した。

最近、海外メディアの報道によると、アルトマンは世界のチップ製造能力を高めることを目的としたプロジェクトを推進しており、UAE政府を含むさまざまな投資家と交渉している。この資金調達計画は、5兆~7兆米ドルに達すると誇張されている。

OpenAIの広報担当者は、「OpenAIは、AIや関連産業にとって重要なチップ、エネルギー、データセンターの世界的なインフラとサプライチェーンを増やすことについて、生産的な話し合いを行ってきました。国家の優先事項の重要性を考慮し、我々は米国政府に情報を提供し続け、後日詳細を共有することを楽しみにしています。"

エヌビディアの創業者兼CEOであるJen-Hsun Huang氏は、これに対して若干の皮肉を込めて次のように答えている。「コンピューターがより速く進化できないと考えるのであれば、その燃料を供給するために14の惑星、3つの銀河、4つの太陽が必要だと結論づけるかもしれません。しかし、コンピュータ・アーキテクチャは実際に進歩しているのです。

大型モデルの進化が速いのか、それとも演算コストの低下が速いのか。100モデル戦争の勝者となるのか?

2024年、その答えが明らかになる。

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Anais

Anais Cheng Yuan

Cheng Yuan JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Hui Xin

Hui Xin JinseFinance

JinseFinance