Nguồn: InfoQ

Vào lúc 4 giờ sáng theo giờ Bắc Kinh, ở bên kia đại dương tại Trung tâm Hội nghị San Jose ở San Jose, California, hội nghị GTC 2024, được gọi là Công nghệ NVIDIA Lễ hội đang diễn ra sôi nổi. Mở màn NVIDIA 2024, thủ lĩnh tỷ phú Huang khoác chiếc áo khoác da đặc trưng của mình đứng giữa sân khấu và bình tĩnh tung ra thêm một loạt siêu chip "bom hạt nhân" sau H100 và A100.

Lý do khiến GTC năm nay thu hút nhiều sự chú ý đến vậy là do Nvidia đã đạt được thành công lớn về mặt hiệu quả tài chính trong lĩnh vực AI trong năm qua. Từ dòng GPU Volta V100 đến chip Ampere A100 và Hopper H100 mới nhất, công ty đã và đang khẳng định danh hiệu vua chip AI.

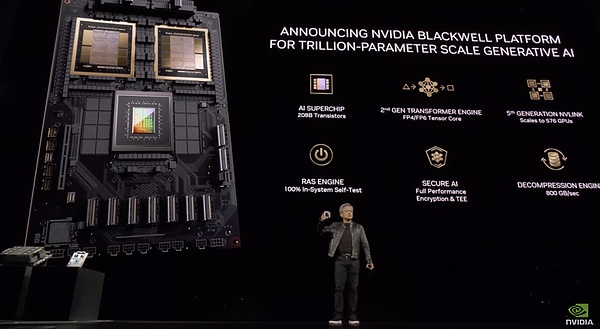

1. Gia đình GPU có thêm một "người mới", chip kiến trúc Blackwell mới đang bùng nổ

Trước khi bắt đầu hội nghị GTC này, truyền thông nước ngoài đã bắt đầu tung tin đồn: Huang Renxun sẽ có mặt tại GTC Một sản phẩm mới của dòng GPU đã được phát hành vào năm 2024, và chắc chắn rằng các chip dòng B200 và GB200 sử dụng kiến trúc Blackwell đã xuất hiện như dự kiến.

Theo NVIDIA, dòng chip kiến trúc Blackwell là dòng chip AI mạnh nhất tính đến thời điểm hiện tại.

Theo Lao Huang, B200 có 208 tỷ bóng bán dẫn (trong khi H100/H200 có 80 tỷ bóng bán dẫn), sử dụng quy trình 4NP của TSMC và có thể hỗ trợ các mô hình AI với tối đa 10 nghìn tỷ tham số. GPT- của OpenAI 3 bao gồm 175 tỷ tham số. Nó cũng mang lại hiệu suất AI 20 petaflop từ một GPU duy nhất—một H100 có thể cung cấp tới 4 petaflop điện toán AI.

Nhưng điều đáng chú ý là Blackwell B200 không phải là một GPU duy nhất theo nghĩa truyền thống. Nó bao gồm hai chip được ghép nối chặt chẽ được kết nối thông qua kết nối NV-HBI (Giao diện băng thông cao Nvidia) 10 TB/s để đảm bảo chúng hoạt động như một chip duy nhất, mạch lạc hoàn toàn.

Nền tảng GPU, được đặt theo tên của nhà toán học David Harold Blackwell, kế thừa kiến trúc Hopper mà Nvidia đã giới thiệu cách đây hai năm, và một loạt sản phẩm dựa trên kiến trúc này đã khiến hoạt động kinh doanh và giá cổ phiếu của Nvidia tăng vọt.

Cấu trúc này là một bước tiến quan trọng khác trong lĩnh vực bảo mật AI. Blackwell cung cấp AI an toàn với các dịch vụ RAS tự kiểm tra 100% trong hệ thống và mã hóa hiệu suất đầy đủ, nghĩa là dữ liệu không chỉ an toàn khi truyền mà còn ở trạng thái nghỉ và khi được tính toán.

Blackwell sẽ được tích hợp vào siêu chip GB200 Grace Blackwell của Nvidia, kết nối hai GPU B200 Blackwell với CPU Grace. Nvidia không tiết lộ giá cả.

Con chip mới dự kiến sẽ ra mắt vào cuối năm nay. Nvidia cho biết AWS, Dell Technologies, Google, Meta, Microsoft, OpenAI và Tesla đều có kế hoạch sử dụng GPU Blackwell.

"Trí tuệ nhân tạo có khả năng sáng tạo là The định nghĩa công nghệ của thời đại chúng ta”, Huang nói trong bài phát biểu của mình. "GPU Blackwell là động cơ thúc đẩy cuộc cách mạng công nghiệp mới này. Hợp tác với các công ty năng động nhất thế giới, chúng tôi sẽ hiện thực hóa lời hứa về trí tuệ nhân tạo cho mọi ngành công nghiệp."

NVIDIA cũng phát hành GB200 NVL72 Fluid- hệ thống giá đỡ, chứa 36 siêu chip GB200 Grace Blackwell và có công suất suy luận 1.440 petaflop (hay còn gọi là 1,4 exaflop), có gần hai dặm cáp bên trong, với tổng số 5.000 cáp riêng lẻ.

Nvidia cho biết GB200 NVL72 mang lại hiệu suất cải thiện gấp 30 lần so với cùng số lượng bộ xử lý đồ họa H100 Tensor Core được sử dụng cho mục đích suy luận. Ngoài ra, hệ thống có thể giảm chi phí và tiêu thụ năng lượng tới 25 lần.

GB200 NVL72

Ví dụ: đào tạo mô hình tham số 1,8 nghìn tỷ trước đây cần 8.000 GPU Hopper và 15 MW điện. Ngày nay, chỉ cần 2.000 GPU Blackwell để thực hiện việc này trong khi chỉ tiêu thụ 4 megawatt điện.

Trên benchmark GPT-3 với 175 tỷ thông số, Nvidia cho biết GB200 hoạt động tốt hơn 7 lần và đào tạo nhanh hơn H100 gấp 4 lần.

Ngoài ra, Nvidia cho biết họ cũng sẽ ra mắt bo mạch chủ máy chủ có tên HGX B200, dựa trên việc sử dụng 8 GPU B200 và CPU x86 (có thể là hai CPU) trong một nút máy chủ. Mỗi GPU B200 có thể cấu hình lên tới 1000W và GPU cung cấp thông lượng lên tới 18 petaflop FP4, khiến chúng chậm hơn 10% so với GPU trong GB200.

Hiện tại, khách hàng doanh nghiệp có thể truy cập B200 thông qua HGX B200 và GB200, kết hợp GPU B200 với CPU Grace của NVIDIA.

2. Nâng cấp toàn diện dịch vụ phần mềm

Thị trường đang nóng lên, cạnh tranh cả về phần cứng và phần mềm ngày càng gay gắt. Tại GTC này, Nvidia không chỉ tham gia cuộc cạnh tranh với những cải tiến phần cứng mới mà còn cho thấy chiến lược phần mềm AI của họ đang giúp khẳng định vị trí dẫn đầu trong lĩnh vực này như thế nào và công ty sẽ phát triển như thế nào trong những năm tới.

Huang Renxun cũng đang tập trung quảng bá gói dịch vụ đăng ký phần mềm AI của mình, điều này rõ ràng phù hợp với chiến lược mới "bán phần cứng kèm phần mềm" của công ty và cũng hoàn toàn khác với chiến lược "bán phần mềm" trước đây. phần mềm với phần cứng". tạm biệt.

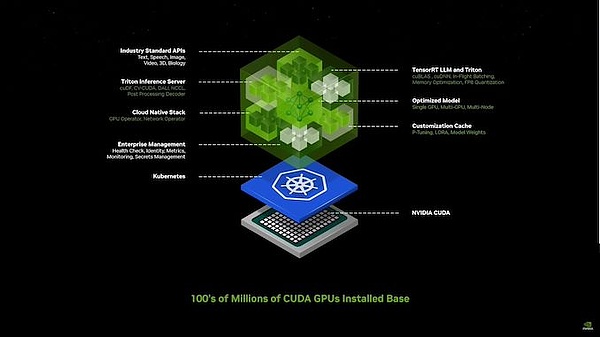

Nvidia có quyền truy cập vào một số lượng lớn các mô hình trên tất cả các lĩnh vực, nhưng họ tin rằng các mô hình này vẫn còn quá khó để các doanh nghiệp sử dụng. Họ đã ra mắt Nvidia Inference Microservices (NIM), hợp nhất các mô hình và phần phụ thuộc thành một gói ngắn gọn, được tối ưu hóa cho ngăn xếp của người dùng và được kết nối với API dễ sử dụng.

Mô hình được đào tạo trước được đóng gói và tối ưu hóa có thể được cài đặt trên NVIDIA Run, chứa tất cả các phần mềm cần thiết để chạy nó. Thư viện CUDA, API, v.v. về cơ bản là các gói AI được đóng gói được tối ưu hóa cho GPU NV với một API đơn giản để truy cập chúng.

Lao Huang đã chỉ ra: "Đây là cách chúng ta sẽ viết phần mềm trong tương lai" - bằng cách lắp ráp một loạt trí tuệ nhân tạo.

Lao Huang đã giới thiệu cách NVIDIA sử dụng NVIDIA Inference Microservices (NIM) để tạo An nội bộ chatbot được thiết kế để giải quyết các câu hỏi thường gặp khi xây dựng chip. Ông nói: “Chúng tôi cần một công cụ mô phỏng để thể hiện thế giới bằng kỹ thuật số cho robot,” và đó chính là Omniverse. Những “dịch vụ vi mô” này sẽ cho phép các nhà phát triển nhanh chóng tạo và triển khai các “đồng thí điểm” hoặc trợ lý AI bằng cách sử dụng các mô hình tùy chỉnh và độc quyền.

Ông cho biết robot là trụ cột chính của Nvidia, cùng với trí tuệ nhân tạo và công việc Ominverse/Digital Twin, tất cả đều phối hợp với nhau để tận dụng tối đa hệ thống của công ty.

Có thông tin cho rằng Omniverse là một nền tảng được thiết kế để xây dựng và vận hành các ứng dụng Metaverse, về cơ bản là những thế giới ảo được chia sẻ, nơi mọi người có thể tương tác, làm việc và sáng tạo. Nền tảng Omniverse cho phép tạo ra các bản sao kỹ thuật số và mô phỏng nâng cao. Tầm nhìn của NVIDIA dành cho Omniverse bao gồm việc trở thành nền tảng nền tảng cho Metaverse, nơi người sáng tạo và doanh nghiệp có thể cộng tác trong một không gian ảo chung. Bản sao kỹ thuật số được tạo trong Omniverse có thể được sử dụng trong nhiều ứng dụng khác nhau trong Metaverse, chẳng hạn như đào tạo ảo, thiết kế sản phẩm và bảo trì dự đoán.

Lao Huang cho biết NVIDIA đã ra mắt hàng chục dịch vụ AI siêu nhỏ cấp doanh nghiệp. Các doanh nghiệp có thể sử dụng các dịch vụ này để tạo ứng dụng trên nền tảng của riêng mình trong khi vẫn giữ toàn quyền sở hữu và kiểm soát quyền sở hữu trí tuệ của mình.

Lao Huang cũng đã công bố tính năng phát trực tuyến Omniverse Cloud tới tai nghe Apple Vision Pro.

Ông cũng nói rằng NVIDIA đang nghiêm túc xem xét việc thiết kế lại về cơ bản toàn bộ lớp dưới cùng. ngăn xếp phần mềm hy vọng sẽ sử dụng sức mạnh của AI để tạo ra mã tốt hơn cho con người.

Lý do cho ý tưởng này rất đơn giản: trong nhiều thập kỷ, thế giới đã tuân theo khung tính toán truyền thống được phát triển xung quanh CPU, nơi con người viết ứng dụng để lấy dữ liệu đã chuẩn bị sẵn từ cơ sở dữ liệu.

Huang Renxun đã chỉ ra trong cuộc họp báo: "Phương pháp tính toán của chúng tôi ngày nay trước tiên yêu cầu phải xác định ai đã viết và tạo ra thông tin, có nghĩa là thông tin đó trước tiên phải được ghi lại."

Nvidia's GPU đã mở ra một con đường mới tới điện toán thuật toán để tăng tốc tính toán và có thể dựa vào lý luận sáng tạo (chứ không phải logic vốn có) để xác định các kết quả có liên quan.

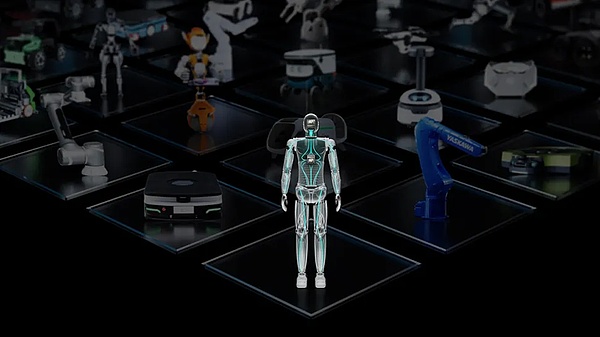

Ngoài ra, Nvidia hy vọng sẽ thúc đẩy sự phát triển của robot hình người bằng cách phát hành một bộ sưu tập API mới khác, Project GROOT.

Project GROOT là mẫu robot hình người do Nvidia sản xuất cùng với Jetson Thor, một SoC cũng là phiên bản nâng cấp của Nvidia Isaac. NVIDIA cho biết robot GROOT sẽ hiểu ngôn ngữ tự nhiên và học sự khéo léo bằng cách bắt chước chuyển động của con người. Jetson Thor chạy GPU dựa trên Blackwell mang lại hiệu suất AI 800 teraflop khi xử lý dữ liệu 8 bit.

Lao Huang tiết lộ rằng các robot được điều khiển bởi nền tảng này sẽ được thiết kế để hiểu ngôn ngữ tự nhiên và bắt chước chuyển động của robot, quan sát hành vi của con người. Điều này cho phép robot GROOT nhanh chóng học cách phối hợp, tính linh hoạt và các kỹ năng khác để điều hướng, thích ứng và tương tác với thế giới thực—và chắc chắn không dẫn đến sự nổi loạn của robot.

“Xây dựng mô hình cơ bản cho robot hình người phổ quát là một trong những vấn đề thú vị nhất mà chúng ta có thể giải quyết trong lĩnh vực trí tuệ nhân tạo ngày nay,” Lao Huang nói. "Những công nghệ hỗ trợ này đang kết hợp với nhau để giúp các chuyên gia robot hàng đầu trên thế giới tạo ra những bước nhảy vọt về robot nhân tạo đa năng."

3. Tác động đến các nhà phát triển

Theo dự đoán của các chuyên gia rằng trong 5 năm nữa, thông tin ở dạng văn bản, hình ảnh, video và giọng nói sẽ được đưa vào các mô hình ngôn ngữ lớn (LLM) trong thời gian thực. Khi đó, máy tính sẽ có quyền truy cập trực tiếp vào tất cả các nguồn thông tin và sẽ liên tục tự cải thiện thông qua các tương tác đa phương thức.

Huang Renxun cho biết: "Trong tương lai, chúng ta sẽ bước vào kỷ nguyên học tập liên tục. Chúng ta có thể quyết định xem có triển khai kết quả của việc học tập liên tục hay không và sự tương tác với máy tính sẽ không còn phụ thuộc vào C++ nữa. "

Đây chính là nội dung của công nghệ AI - con người có thể, sau khi suy luận, yêu cầu máy tính tạo mã để đạt được một mục tiêu cụ thể. Nói cách khác, trong tương lai, con người có thể sử dụng các ngôn ngữ đơn giản thay vì C++ hay Python để giao tiếp thông suốt với máy tính.

“Theo tôi, bản thân giá trị của việc lập trình đang âm thầm vượt qua bước ngoặt lịch sử suy giảm.” Huang Renxun cũng nói thêm rằng AI đã và đang thu hẹp khoảng cách giữa con người và công nghệ.

"Hiện tại, khoảng hàng chục triệu người đang dựa vào kiến thức lập trình máy tính của mình để tìm việc làm và kiếm thu nhập, trong khi 8 tỷ người còn lại còn kém xa. Tình hình tương lai sẽ có những thay đổi."

Theo quan điểm của Huang Renxun, tiếng Anh sẽ trở thành ngôn ngữ lập trình mạnh mẽ nhất và tương tác cá nhân hóa là yếu tố then chốt giúp thu hẹp khoảng cách công nghệ.

Generative AI sẽ trở thành một hệ điều hành cấp vĩ mô nơi con người có thể hướng dẫn máy tính tạo ra các ứng dụng bằng ngôn ngữ đơn giản. Huang Renxun cho rằng các mô hình ngôn ngữ lớn sẽ giúp con người biến cảm hứng thành hiện thực thông qua máy tính.

Ví dụ: con người đã có thể yêu cầu các ngôn ngữ lớn tạo mã Python cho các ứng dụng dành riêng cho miền, với tất cả lời nhắc được viết bằng tiếng Anh đơn giản.

"Làm cách nào chúng ta có thể khiến máy tính thực hiện những gì chúng ta muốn? Làm cách nào để chúng ta tinh chỉnh các hướng dẫn trên máy tính? Câu trả lời cho những câu hỏi này là kỹ thuật soạn thảo văn bản nhanh chóng và nó mang tính nghệ thuật hơn là một kỹ thuật công nghệ thuần túy ."

Nói cách khác, con người sẽ có thể tập trung vào chuyên môn về lĩnh vực, trong khi AI có khả năng tạo sinh sẽ bù đắp những thiếu sót về kỹ năng lập trình. Huang Renxun tin rằng điều này sẽ phá vỡ hoàn toàn bối cảnh phát triển phần mềm.

Huang Renxun trước đây đã so sánh các mô hình ngôn ngữ lớn với những sinh viên tốt nghiệp đại học đã được đào tạo trước và có tư duy sáng suốt. NVIDIA đang cung cấp kiến thức chuyên môn trong các lĩnh vực như chăm sóc sức khỏe và tài chính xung quanh các mô hình lớn để hỗ trợ hiệu quả cho khách hàng doanh nghiệp.

JinseFinance

JinseFinance

JinseFinance

JinseFinance Edmund

Edmund Edmund

Edmund Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist Bitcoinist

Bitcoinist