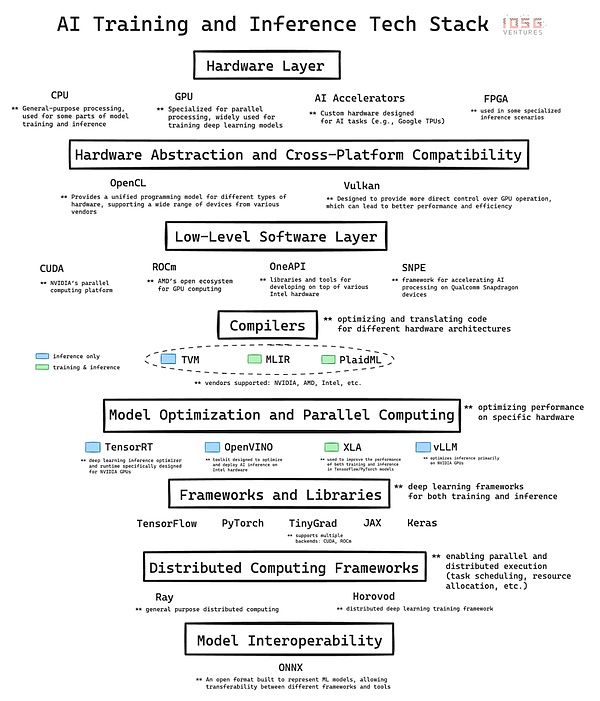

دليل يعتمد التطور السريع للذكاء على بنية تحتية معقدة. إن مجموعة تقنيات الذكاء الاصطناعي عبارة عن بنية متعددة الطبقات تتكون من الأجهزة والبرامج، وهي العمود الفقري لثورة الذكاء الاصطناعي الحالية. سنقدم هنا تحليلًا متعمقًا للطبقات الرئيسية لمجموعة التكنولوجيا ونوضح مساهمة كل طبقة في تطوير الذكاء الاصطناعي وتنفيذه. أخيرًا، سنفكر في أهمية إتقان هذه الأساسيات، خاصة عند تقييم الفرص عند تقاطع العملة المشفرة والذكاء الاصطناعي، مثل مشاريع DePIN (البنية التحتية المادية اللامركزية) مثل شبكات GPU.

1.طبقة الأجهزة: أساس السيليكون

في أدنى مستوى توجد الطبقة الأجهزة، والتي توفر قوة الحوسبة المادية للذكاء الاصطناعي.

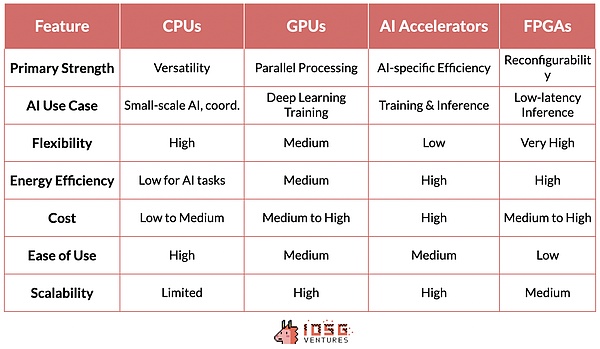

وحدة المعالجة المركزية (وحدة المعالجة المركزية): هي المعالج الأساسي للحوسبة. إنها تتفوق في معالجة المهام المتسلسلة وهي مهمة للحوسبة ذات الأغراض العامة، بما في ذلك المعالجة المسبقة للبيانات، ومهام الذكاء الاصطناعي صغيرة الحجم، وتنسيق المكونات الأخرى.

GPU (وحدة معالجة الرسومات): تم تصميمها في الأصل لعرض الرسومات، ولكنها أصبحت جزءًا مهمًا من الذكاء الاصطناعي بسبب قدرتها على إجراء أعداد كبيرة من العمليات الحسابية البسيطة معًا. إن قدرة المعالجة المتوازية هذه تجعل وحدات معالجة الرسومات مثالية لتدريب نماذج التعلم العميق، وبدون تطوير وحدات معالجة الرسومات، لن تكون نماذج GPT الحديثة ممكنة.

مسرع الذكاء الاصطناعي: شرائح مصممة خصيصًا لأحمال عمل الذكاء الاصطناعي، وقد تم تحسينها لعمليات الذكاء الاصطناعي الشائعة وتوفر أداءً عاليًا لمهام التدريب والاستدلال وكفاءة عالية في استخدام الطاقة .

FPGA (منطق المصفوفة القابل للبرمجة): يوفر المرونة بطبيعته القابلة لإعادة البرمجة. ويمكن تحسينها لمهام ذكاء اصطناعي محددة، خاصة في سيناريوهات الاستدلال التي تتطلب زمن وصول منخفض.

2. البرمجيات الأساسية: البرامج الوسيطة

تعتبر هذه الطبقة في مجموعة تقنيات الذكاء الاصطناعي ضرورية لأنها تبني الاتصال بين إطار عمل الذكاء الاصطناعي عالي المستوى و الأجهزة الأساسية بين. تعمل التقنيات مثل CUDA وROCm وOneAPI وSNPE على تعزيز الاتصال بين أطر العمل عالية المستوى وبنيات الأجهزة المحددة لتحقيق تحسين الأداء.

باعتبارها طبقة برمجيات مملوكة لشركة NVIDIA، تعد CUDA حجر الزاوية في صعود الشركة في سوق أجهزة الذكاء الاصطناعي. لا يرجع موقع الريادة لشركة NVIDIA إلى مزايا أجهزتها فحسب، بل يعكس أيضًا تأثير الشبكة القوي لتكامل برامجها ونظامها البيئي.

تتمتع CUDA بتأثير كبير لأنها مدمجة بعمق في مجموعة تقنيات الذكاء الاصطناعي وتوفر مجموعة من المعايير الفعلية في مكتبة التحسين. لقد بنى هذا النظام البيئي البرمجي تأثيرًا شبكيًا قويًا: قام باحثو ومطورو الذكاء الاصطناعي المتخصصون في CUDA بنشر استخدامه في الأوساط الأكاديمية والصناعة أثناء عملية التدريب.

تعزز الدورة الحميدة الناتجة ريادة NVIDIA في السوق حيث أصبح النظام البيئي القائم على CUDA للأدوات والمكتبات متاحًا بشكل متزايد لممارسي الذكاء الاصطناعي كلما أصبح لا غنى عنه.

هذا التعايش بين البرامج والأجهزة لا يعزز مكانة NVIDIA في طليعة حوسبة الذكاء الاصطناعي فحسب، بل يمنح الشركة أيضًا قوة تسعير كبيرة على الأجهزة التي يتم سلعتها عادةً نادر في السوق.

يمكن أن تعزى هيمنة CUDA والغموض النسبي لمنافسيها إلى عدد من العوامل التي تخلق حواجز كبيرة أمام الدخول. إن ميزة NVIDIA الأولى في الحوسبة المسرَّعة بوحدة معالجة الرسومات تسمح لـ CUDA ببناء نظام بيئي قوي قبل أن يحصل المنافسون على موطئ قدم. على الرغم من أن المنافسين مثل AMD وIntel لديهم أجهزة ممتازة، إلا أن طبقة البرامج الخاصة بهم تفتقر إلى المكتبات والأدوات اللازمة ولا تتكامل بسلاسة مع مجموعة التكنولوجيا الحالية. وهذا هو سبب وجود فجوة كبيرة بين NVIDIA/CUDA والمنافسين الآخرين.

3. المترجم: مترجم

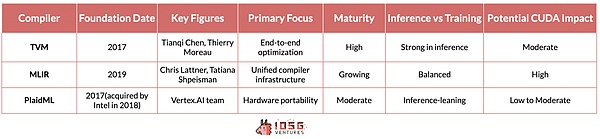

TVM (جهاز موتر افتراضي)، MLIR (متعدد- طبقة التمثيل المتوسط) وPlaidML يقدمان حلولاً مختلفة للتحدي المتمثل في تحسين أعباء عمل الذكاء الاصطناعي عبر بنيات الأجهزة المتعددة.

نشأت TVM من بحث في جامعة واشنطن وهي معروفة بقدرتها على تحسين نماذج التعلم العميق لمجموعة متنوعة من الأجهزة، بدءًا من وحدات معالجة الرسومات عالية الأداء وحتى الموارد - أجهزة الحافة المقيدة تجذب الانتباه بسرعة. تكمن ميزتها في عملية التحسين الشاملة، والتي تكون فعالة بشكل خاص في سيناريوهات الاستدلال. فهو يلخص تمامًا الاختلافات الأساسية بين البائعين والأجهزة، مما يسمح بتشغيل أحمال عمل الاستدلال بسلاسة على أجهزة مختلفة، سواء كانت أجهزة NVIDIA أو AMD أو Intel وما إلى ذلك.

ولكن بعيدًا عن المنطق، يصبح الوضع أكثر تعقيدًا. لا يزال الهدف النهائي المتمثل في الحوسبة القابلة للاستبدال بالأجهزة للتدريب على الذكاء الاصطناعي دون حل. ومع ذلك، هناك العديد من المبادرات الجديرة بالذكر في هذا الصدد.

يتبع MLIR، وهو مشروع تابع لشركة Google، منهجًا أكثر أساسية. من خلال توفير تمثيل وسيط موحد لمستويات تجريد متعددة، فإنه يهدف إلى تبسيط البنية التحتية للمترجم بالكامل لكل من حالات استخدام الاستدلال والتدريب.

وضعت شركة PlaidML، التي تقودها الآن شركة Intel، نفسها كالحصان الأسود في هذا السباق. وهو يركز على قابلية النقل عبر بنيات الأجهزة المتعددة، بما في ذلك تلك التي تتجاوز مسرعات الذكاء الاصطناعي التقليدية، ويتصور مستقبلًا حيث يمكن تشغيل أحمال عمل الذكاء الاصطناعي بسلاسة على مجموعة متنوعة من منصات الحوسبة.

إذا كان من الممكن دمج أي من هذه المترجمات بشكل جيد في حزمة التكنولوجيا، ولا تؤثر على أداء النموذج، ولا تتطلب أي تعديلات إضافية من قبل المطورين، فمن المحتمل أن يكون ذلك لتهديد خندق CUDA. ومع ذلك، فإن MLIR وPlaidML حاليًا ليسا ناضجين بدرجة كافية ولم يتم دمجهما بشكل جيد في مجموعة تكنولوجيا الذكاء الاصطناعي، لذلك لا يشكلان حاليًا تهديدًا واضحًا للموقع القيادي لـ CUDA.

4. الحوسبة الموزعة: المنسق

يمثل راي وهوروفود طريقتين مختلفتين للحوسبة الموزعة في مجال الذكاء الاصطناعي، وكل نهج يحل متطلبًا بالغ الأهمية للمعالجة القابلة للتطوير في تطبيقات الذكاء الاصطناعي واسعة النطاق.

Ray الذي طوره RISELab بجامعة كاليفورنيا في بيركلي هو إطار عمل عام للحوسبة الموزعة. فهو يتميز بالمرونة، مما يسمح بتوزيع أنواع مختلفة من أعباء العمل بما يتجاوز التعلم الآلي. يعمل النموذج القائم على الممثل في Ray على تبسيط عملية الموازاة في كود Python إلى حد كبير، مما يجعلها مناسبة بشكل خاص للتعلم المعزز ومهام الذكاء الاصطناعي الأخرى التي تتطلب سير عمل معقد ومتنوع.

يركز Horovod، الذي صممته شركة Uber في الأصل، على التنفيذ الموزع للتعلم العميق. فهو يوفر حلاً موجزًا وفعالًا لتوسيع نطاق عملية التدريب على التعلم العميق عبر وحدات معالجة الرسومات وعقد الخادم المتعددة. إن أهم ما يميز Horovod هو سهولة الاستخدام وتحسين التدريب الموازي لبيانات الشبكة العصبية، مما يسمح له بالتكامل بشكل مثالي مع أطر التعلم العميق السائدة مثل TensorFlow وPyTorch، مما يسمح للمطورين بتوسيع كود التدريب الحالي الخاص بهم بسهولة، دون الحاجة إلى ذلك. لإجراء تعديلات واسعة النطاق على التعليمات البرمجية.

5. الاستنتاج: من منظور العملة المشفرة

مقارنة بمجموعة الذكاء الاصطناعي الحالية يعد التكامل أمرًا بالغ الأهمية لمشروع DePin، الذي يهدف إلى بناء أنظمة حوسبة موزعة. يضمن هذا التكامل التوافق مع سير عمل وأدوات الذكاء الاصطناعي الحالية، مما يقلل من حاجز التبني.

في مجال العملات المشفرة، تعد شبكة GPU الحالية في الأساس عبارة عن منصة لامركزية لتأجير GPU، مما يمثل خطوة نحو أساس أكثر تعقيدًا للذكاء الاصطناعي الموزع بواسطة المنشأة. تعمل هذه المنصات بشكل يشبه الأسواق على غرار Airbnb أكثر من كونها سحابات موزعة. وعلى الرغم من أنها مفيدة لتطبيقات معينة، إلا أن هذه المنصات ليست قوية بما يكفي لدعم التدريب الموزع بشكل حقيقي، وهو مطلب أساسي لتعزيز تطوير الذكاء الاصطناعي على نطاق واسع.

لم يتم تصميم معايير الحوسبة الموزعة الحالية مثل Ray وHorovod للشبكات الموزعة عالميًا، ومن أجل شبكة لا مركزية تعمل حقًا، نحتاج إلى تطوير إطار عمل آخر فوق إطار واحد طبقة. حتى أن بعض المتشككين يعتقدون أنه نظرًا لأن نماذج المحولات تتطلب اتصالات مكثفة وتحسينًا للوظائف العالمية أثناء عملية التعلم، فهي غير متوافقة مع أساليب التدريب الموزعة. ومن ناحية أخرى، يحاول المتفائلون التوصل إلى أطر حوسبة موزعة جديدة تعمل بشكل جيد مع الأجهزة الموزعة عالميًا. Yotta هي إحدى الشركات الناشئة التي تحاول حل هذه المشكلة.

NeuroMesh يذهب خطوة أبعد. فهو يعيد تصميم عملية التعلم الآلي بطريقة مبتكرة بشكل خاص. من خلال استخدام شبكات الترميز التنبؤية (PCNs) لإيجاد التقارب في تقليل الأخطاء المحلية، بدلاً من العثور مباشرة على الحل الأمثل لوظيفة الخسارة العالمية، تعمل NeuroMesh على حل عنق الزجاجة الأساسي في تدريب الذكاء الاصطناعي الموزع.

لا يتيح هذا النهج تحقيق توازي غير مسبوق فحسب، بل يتيح أيضًا تدريب النماذج على أجهزة GPU المخصصة للمستهلكين مثل RTX 4090، مما يجعل تدريب الذكاء الاصطناعي ديمقراطيًا . على وجه التحديد، تتشابه قوة الحوسبة لوحدة معالجة الرسومات 4090 مع قوة H100، ولكن نظرًا لعدم كفاية عرض النطاق الترددي، لا يتم استخدامها بالكامل أثناء التدريب على النموذج. نظرًا لأن PCN يقلل من أهمية عرض النطاق الترددي، مما يجعل من الممكن الاستفادة من وحدات معالجة الرسومات المنخفضة هذه، فقد يؤدي ذلك إلى توفير كبير في التكاليف ومكاسب في الكفاءة.

تهدف GenSyn، وهي شركة ناشئة أخرى طموحة تعمل في مجال الذكاء الاصطناعي في مجال العملات المشفرة، إلى بناء مجموعة من المترجمين. تسمح برامج التحويل البرمجي الخاصة بـ Gensyn باستخدام أي نوع من أجهزة الحوسبة بسلاسة لأعباء عمل الذكاء الاصطناعي. على سبيل المثال، ما يفعله TVM للاستدلال، يحاول GenSyn بناء أدوات مماثلة للتدريب النموذجي.

في حالة نجاحه، يمكنه توسيع قدرات شبكات حوسبة الذكاء الاصطناعي اللامركزية بشكل كبير للتعامل مع مهام الذكاء الاصطناعي الأكثر تعقيدًا وتنوعًا من خلال استخدام الأجهزة المختلفة بكفاءة. هذه الرؤية الطموحة، على الرغم من أنها تمثل تحديًا بسبب التعقيد والمخاطر التقنية العالية للتحسين عبر بنيات الأجهزة المتنوعة، يمكن أن تكون تقنية إذا أمكن تنفيذها، والتغلب على العقبات مثل الحفاظ على أداء النظام غير المتجانس، وإضعاف خنادق CUDA وNVIDIA.

حول الاستدلال: يجمع نهج Hyperbolic بين الاستدلال الذي يمكن التحقق منه وشبكة لا مركزية من موارد الحوسبة غير المتجانسة، مما يجسد استراتيجية عملية نسبيًا. من خلال الاستفادة من معايير المترجم مثل TVM، يمكن لـ Hyperbolic الاستفادة من مجموعة واسعة من تكوينات الأجهزة مع الحفاظ على الأداء والموثوقية. يمكنه تجميع الرقائق من بائعين متعددين (من NVIDIA إلى AMD وIntel وما إلى ذلك)، بما في ذلك الأجهزة المخصصة للمستهلكين والأجهزة عالية الأداء.

تبشر هذه التطورات عند تقاطع الذكاء الاصطناعي المشفر بمستقبل قد تصبح فيه حوسبة الذكاء الاصطناعي أكثر توزيعًا وكفاءة وسهولة في الوصول إليها. ولن يعتمد نجاح هذه المشاريع على مزاياها التقنية فحسب، بل سيعتمد أيضًا على قدرتها على التكامل بسلاسة مع سير عمل الذكاء الاصطناعي الحالي ومعالجة المخاوف العملية لممارسي الذكاء الاصطناعي والمؤسسات.

ZeZheng

ZeZheng

ZeZheng

ZeZheng JinseFinance

JinseFinance JinseFinance

JinseFinance WenJun

WenJun Hafiz

Hafiz JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Bitcoinworld

Bitcoinworld