ソース:There's a newin

5月15日未明、Googleの開発者会議I/Oが正式に開催されました。.Geminiについて

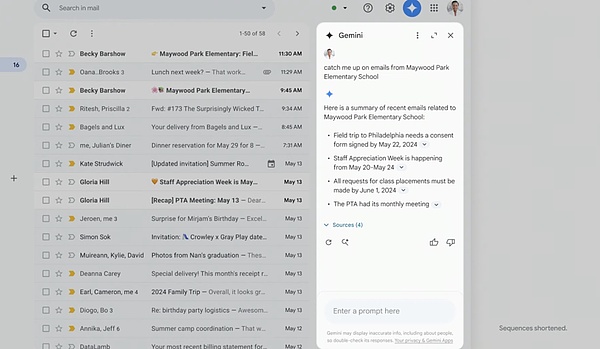

1) GmailのGemini

Gmailユーザーは、GeminiのAI技術を使ってメールを検索、要約、下書きできるようになる。また、受信トレイを検索し、レシートを見つけ、オンラインフォームに記入することで、電子商取引の返品を支援するなど、より複雑なタスクを実行するために電子メールに作用することもできるようになる。

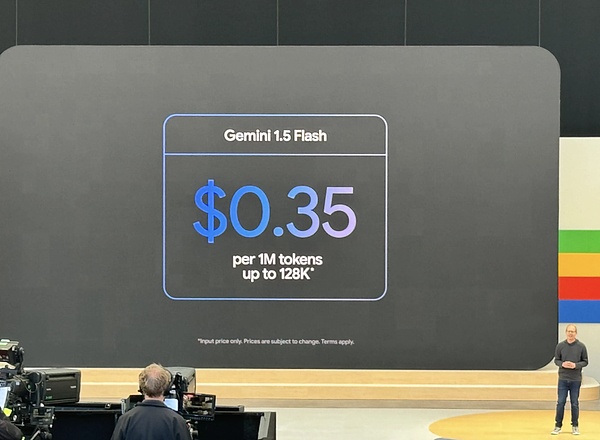

2) Gemini 1.5 Pro & Flash

もう1つのアップグレードは、Geminiがこれまで以上に長いドキュメント、コードベース、ビデオ、オーディオレコーディングを分析できるようになったことです。Googleの現在のフラッグシップモデルであるGemini 1.5 Proの新バージョンのプライベートプレビューでは、最大200万トークンを保持できることが明らかにされました。これは以前の2倍であり、新しいGemini 1.5 Proは、あらゆる商用モデルの中で最大の入力をサポートしています。

Gemini 1.5 Proの "改良版 "であるGemini 1.5 Flashのパブリックプレビューが開始された。「Flashは最大200万トークンのコンテキストウィンドウを持ち、Gemini 1.5 Proと同様にマルチモーダルである。Flashは、最大200万トークンのコンテキストウィンドウを持ち、Gemini 1.5 Proと同様に、マルチモーダルである。

さらに、150カ国以上、35言語以上のGemini Advancedユーザーは、Gemini 1.5 Proのより大きなコンテキストを利用することができ、チャットボットが長いドキュメント(1,500ページまで)を分析し、要約し、質問に答えることができる。

Gemini Advancedのユーザーは、本日からGemini 1.5 Proとの対話を開始することができ、Google Driveからドキュメントをインポートすることもできます。からドキュメントをインポートしたり、モバイルデバイスから直接ドキュメントをアップロードすることもできます。

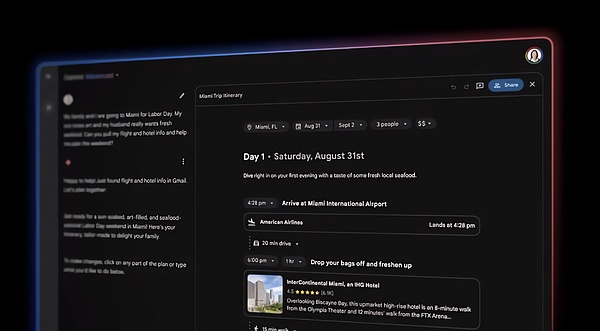

今後数ヶ月の間に、Gemini Advancedは、プロンプトに基づいてカスタマイズされた旅行日程を作成できる新しい「プランニングエクスペリエンス」を手に入れる予定です。フライト時間(ユーザーのGmailの受信トレイにあるEメールから)、食事の好み、地元の観光スポットに関する情報(Google検索と地図データから)、およびそれらの観光スポット間の距離などの要素を考慮し、Geminiは変更を反映した自動更新の旅程を作成します。

近い将来、Gemini Advancedのユーザーは、GoogleのGeminiモデルによって動くカスタムチャットボットであるGemsを作成できるようになるだろう。OpenAIのGPTのラインに沿って、Gemsは自然言語の説明から生成することができます-たとえば、「あなたは私のランニングコーチです。例えば、「あなたは私のランニングコーチです。

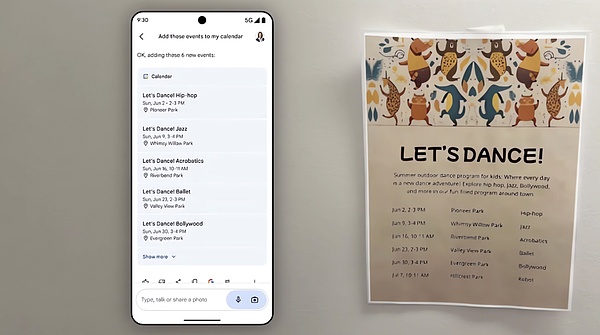

Gems と Gemini は間もなく、Google カレンダー、Tasks、Keep、YouTube Music などの Google サービスとの拡張統合を利用できるようになります。さまざまな作業を省力化することができます。

3) Gemini Live

Gemini Liveと呼ばれるGeminiの新しいエクスペリエンスをGoogleはプレビューしました。

GoogleはGemini Liveと呼ばれるGeminiの新しいエクスペリエンスをプレビューしました。

ユーザーは、チャットボットが話している間にGeminiを中断して明確な質問をすることができ、Geminiはリアルタイムでユーザーの音声パターンに適応します。

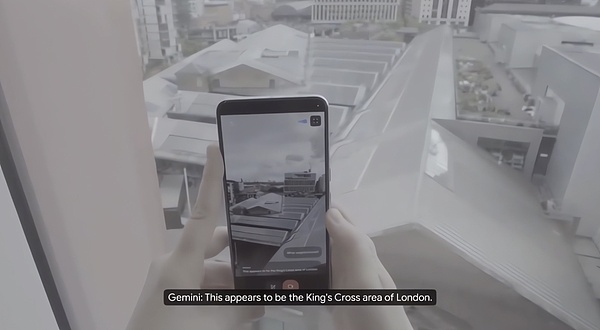

Geminiは、スマートフォンのカメラで撮影された写真やビデオを通して、ユーザーの周囲を見て反応することができます。

グーグルによると、ジェネレーティブAIの新技術を活用して、エラーの起こりやすい優れた画像解析を実現し、それらを強化された音声エンジンと組み合わせることで、より一貫性があり、感情表現が豊かで、リアルな複数ラウンドの会話を実現しているという。

ある意味、Gemini Liveは、画像やビデオを分析するためのGoogleの長年のコンピュータビジョンプラットフォームであるGoogle Lensと、携帯電話、スマートスピーカー、テレビにまたがるGoogleのAIを搭載し、音声を生成・認識するバーチャルアシスタントであるGoogle Assistantの進化版です。

DeepMindのチーフサイエンティストであるOriol Vinyals氏は、非常に強力なマルチモーダル機能と長いコンテキストを持つリアルタイムの音声インターフェースだと述べています。

Liveを動かしている技術革新の一部は、リアルタイムのマルチモーダルな理解を可能にするAI主導のアプリやインテリジェンスを作成するDeepMind内の新しいイニシアチブであるProject Astraに由来しています。

DeepMind CEOのDemis Hassabis氏は、Googleは常に日常生活に役立つ汎用的なインテリジェンスを構築したいと考えており、私たちが何をしているかを見聞きし、環境をよりよく理解し、会話の中で素早く反応することで、対話のスピードと質がより自然に感じられるようなエージェントを想像していると述べています。

Gemini Liveは、今年後半にならないと利用できないが、スマートフォンのカメラの視野の中にある(あるいはその近くにある)物事、例えばユーザーがいるであろう近所や、破損した自転車の部品の名前などの質問に答えるという。コンピュータコードの一部を指さすと、ライブはそのコードが何をするのかを説明することができる。また、メガネのありかを尋ねられたとき、Liveは最後に「見た」場所を言うことができる。

Live はまた、一種のバーチャルコーチとして機能するように設計されており、ユーザーがアクティビティをリハーサルしたり、アイデアをブレインストーミングしたりするのを手助けします。例えば、就職やインターンシップの面接でどのスキルを強調すべきかを提案したり、人前で話すためのアドバイスを提供したりすることができます。

新しいChatGPTとGemini Liveの大きな違いは、Gemini Liveが無料ではないことだ。ライブはGemini Advancedの専用バージョンとなり、月額20ドルのGoogle One AIプレミアムプランで保護されたGeminiのより洗練されたバージョンとなります。

4) Gemini Nano

Google はまた、最小のAIモデルを構築する Chrome 126 から開始しています。Gemini NanoをChromeデスクトップクライアントに直接組み込んだ。グーグルによると、これによって開発者はデバイス上のモデルを使用して、独自のAI機能をサポートできるようになるという。たとえば、グーグルはこの新機能を使用して、ワークスペース・ラボの既存の「Help Me Write」ツールのような機能をGmailでサポートする予定です。

GoogleのChrome製品管理担当ディレクターであるJon Dahlke氏は、Googleは他のブラウザベンダーと、この機能または同様の機能を自社のブラウザで利用できるようにするための話し合いを行っていると述べています。

GoogleのChrome製品管理担当ディレクターであるJon Dahlke氏は、Googleは他のブラウザベンダーと、この機能または同様の機能を自社のブラウザで利用できるようにするための話し合いを行っていると述べています。

5) Gemini on Android

Google の Gemini on Android は、Google アシスタントに代わる AI であり、Android モバイル オペレーティング システムと統合する能力とまた、Google Appsとの深い統合機能も利用できるようになる予定です。

ユーザーは、 AI が生成した画像を、GmailやGoogleメッセージ、その他のアプリに直接ドラッグ&ドロップできるようになります。

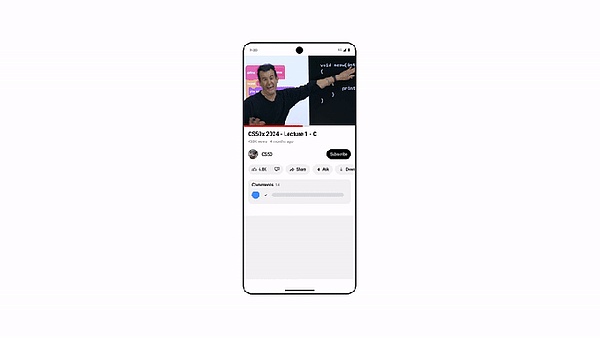

Googleは同時に、YouTubeユーザーは「この動画について質問する」をクリックして、そのYouTube動画から特定の情報を見つけられるようになると述べています。

Googleによると、YouTubeユーザーは同時に、「この動画について質問する」をクリックして、そのYouTube動画から特定の情報を見つけることができるようになる。

アップグレードされたGemini Advancedを購入したユーザーは、「このPDFについて質問する」オプションも利用できるようになる。2TBのストレージとその他のGoogle Oneの利点。

Googleによると、Android版Geminiの最新機能は、今後数ヶ月のうちに数億台のサポート対象デバイスに展開されるとのことです。

Gemini for Androidの最新機能は、今後数ヶ月のうちに、数億台のサポート対象デバイスに展開される予定だとGoogleは述べています。

その間に、AndroidデバイスのベースモデルのGemini Nanoは、マルチモダリティを含むようにアップグレードされます。これは、テキスト入力だけでなく、視覚、音声、話し言葉を含む他の情報処理方法にも対応できるようになることを意味します。

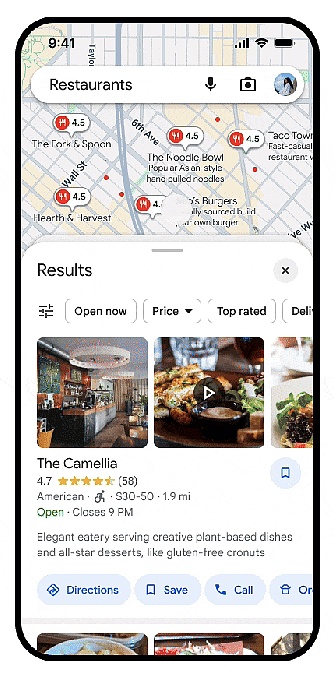

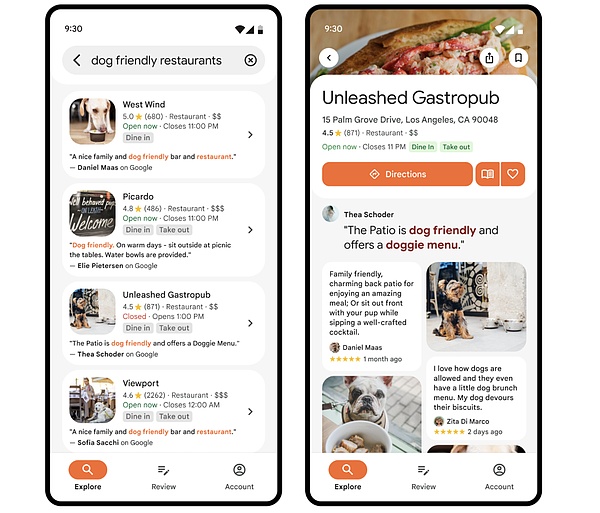

6) Gemini on Google Maps

Places APIを皮切りに、Geminiモデル機能は開発者が使用できるようにGoogle Mapsプラットフォームに導入される予定です。開発者は、生成された場所や地域のAI要約をアプリやウェブサイトに表示できます。これらの要約は、Google Mapsコミュニティへの3億人以上の投稿者からの洞察のGeminiの分析に基づいて作成されます。

これらの要約は、Googleマップコミュニティへの3億人以上の投稿者からの洞察のGeminiの分析に基づいて作成されます。この新機能により、開発者は独自のカスタムロケーション説明を書く必要がなくなります。

たとえば、開発者がレストラン予約アプリを持っている場合、この新機能は、ユーザーがどのレストランが最適かを理解するのに役立ちます。ユーザーがアプリでレストランを検索すると、レストランのスペシャルメニューやハッピーアワーのお得な情報、レストランの雰囲気など、最も重要な情報をすべてすぐに見ることができるようになります。

新しい要約は、レストラン、ショップ、スーパーマーケット、公園、映画館など、さまざまなタイプの場所で機能する。ユーザーが開発者の製品で場所を検索すると、開発者はその検索に関連するレビューや写真を表示できるようになりました。

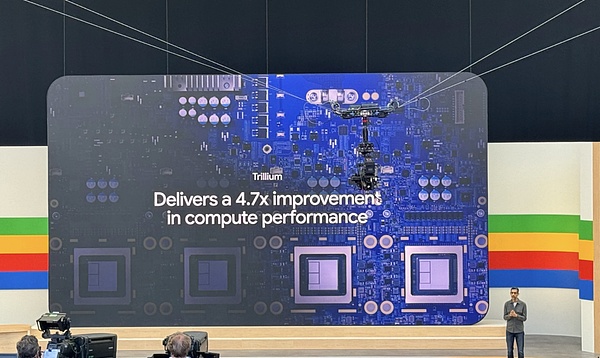

7) TPUのパフォーマンスが向上

Google は次世代、正確には第6世代のTPUを発表しました。- 正確には第6世代のTPU AIチップだ。これはTrilliumと呼ばれ、今年後半に発売される予定だ。思い起こせば、次世代のTPUを発表するのはI/Oカンファレンスの恒例行事になっているが、これらのチップは今年後半に発売されるだけだ。

これらの新しいTPUは、第5世代と比較して、チップあたり4.7倍の計算性能を提供します。 Trilliumは、Googleが「高度なランキングを処理するための新技術」と説明する第3世代のSparseCoreを搭載しています。Trilliumは第3世代のSparseCoreを搭載しており、Googleはこれを「高度なランキングや推奨ワークロードで一般的な、非常に大きなエンベッディングを処理するための専用アクセラレータ」と説明しています。

Pichai氏は、この新しいチップについて、グーグルがこれまでで「最もエネルギー効率の高い」TPUであると説明した。

同氏は、MLコンピューティングに対する業界の需要は過去6年間で100万倍、つまり毎年約10倍に成長しており、これらのチップの電力要件を減らすための投資なしでは維持できないと述べた。グーグルは、新しいTPUは第5世代のチップよりも67%エネルギー効率が高いと約束している。

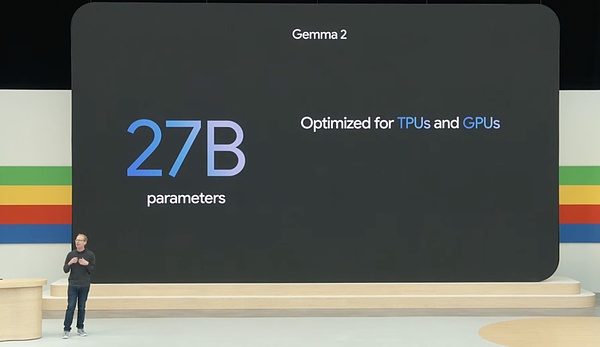

さらにGoogleは、Gemma 2に新しい270億パラメータモデルを追加します。次世代のGoogle Gemmaモデルは6月に利用可能になる予定です。Googleによると、このサイズは次世代GPUで動作するようにNvidiaによって最適化されており、単一のTPUホストと頂点AIで効率的に動作するようになっているとのことです。

2.新モデル

1) Imagen3

グーグルは、Imagenモデルの最新製品であるImagen 3を発表した。ディープマインドのデミス・ハサビスCEOは、前身のImagen 2と比較して、Imagen 3は画像に変換されたテキストの合図をより正確に理解できると述べた。より創造的でニュアンスに富んでいる。

グーグルは、Imagenモデルの最新製品であるImagen 3を発表した。ディープマインドのデミス・ハサビスCEOは、前身のImagen 2と比較して、Imagen 3は画像に変換されたテキストの合図をより正確に理解できると述べた。より創造的でニュアンスに富んでいる。

ディープフォージェリーの可能性に対する懸念を軽減するため、グーグルはImagen 3はディープマインドが開発した、メディアに不可視の暗号透かしを適用する方法であるSynthIDを使用すると述べた。

GoogleのImageFXツールは、Imagen 3のプライベートプレビューのために登録することができ、Googleは、このモデルは、Googleの企業向けジェネレーティブAI開発プラットフォームであるVertex AIを使用する開発者や企業顧客に対して「非常に近いうちに」利用可能になると述べた。

2)Veo 動画生成モデル

Google は、OpenAI の Sora を Veo で狙っています。Veoは、風景やコマ撮り映像など、さまざまなビジュアルや映画のようなスタイルをキャプチャし、生成された映像を編集したり微調整したりすることができます。

また、4月にプレビューされたGoogleのビデオ生成における最初の商業的な仕事をベースにしており、ループするビデオクリップを作成するために、同社の画像生成モデルのImagen 2ファミリーを使用しています。

Demis Hassabis氏によると、Googleは、Veoで何ができるかを知るために、ストーリーボードや長いシーンの生成などの機能を模索しており、Googleは動画において信じられないほどの進歩を遂げているとのことです。

Veo は多くの映像を使ってトレーニングされます。これは、生成AIモデルがどのように機能するかということです。ある形式のデータの例を次々に入力すると、モデルはデータのパターンを見つけ出し、新しいデータ(Veoの場合は動画)を生成できるようにします。

しかしグーグルは、ドナルド・グローヴァー(別名チャイルディッシュ・ガンビーノ)と彼のクリエイティブ・エージェンシーであるギルガを含む、選ばれたクリエイターがVeoを利用できるようにした。

3) LearnLMモデル

GoogleはLearnLMを導入しました。これは、学習のために "微調整 "された、生成的な AI モデルの新しいファミリーです。これはグーグルのDeepMind AI research departmentとグーグルリサーチのコラボレーションである。グーグルによると、LearnLMのモデルは、さまざまな教科の学生を「会話形式で」個人指導するように設計されているという。

LearnLM はすでにグーグルの複数のプラットフォームで利用可能で、LearnLMはグーグルクラスルームでのパイロットプログラムを通じて利用されている。Googleによると、LearnLMは教師が新しいアイデアやコンテンツ、アクティビティを発見したり、特定の生徒グループのニーズに合った教材を見つけたりするのに役立つという。

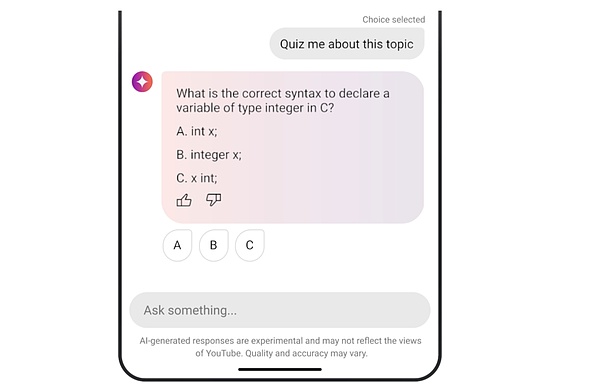

YouTube の新機能として、AI が作成したクイズがあります。この新しい会話型AIツールにより、ユーザーは教育ビデオを見ながら比喩的に「手を挙げる」ことができる。視聴者は、分かりやすい質問をしたり、親切な説明を受けたり、トピックに関するクイズに答えたりすることができます。

この新機能は、Geminiモデルのロングコンテクスト機能により、米国の一部のAndroidユーザーに展開されます。

4) Project IDX

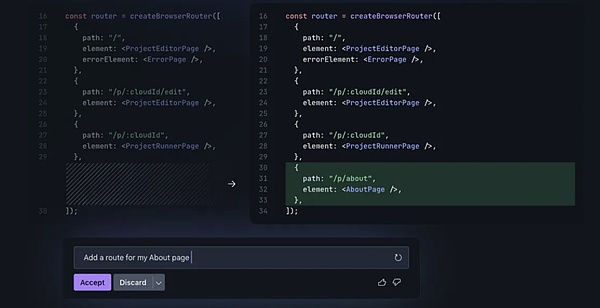

Project IDXは、Googleの次世代の、 AI 中心の、ブラウザベースの開発環境であり、現在パブリックベータ版となっています。

Google のバイスプレジデント兼ゼネラルマネージャー兼 Developer X の責任者であるジェニーン・バンクス(Jeanine Banks)氏は、AI がユビキタス化するにつれて、これらすべてのテクノロジーを展開する複雑さは本当に難しく、大きくなっていると述べています。グーグルはこの課題の解決を支援したいと考えている。開発者関係は、それが Project IDX を構築したものです。

IDX は、アプリの構築を迅速かつ簡単にするマルチプラットフォーム開発エクスペリエンスで、Next.js、Astro、Flutter、Dart、Angular、Goなどの使いやすいテンプレートを使って、お気に入りのフレームワークや言語を簡単に使用できます。

さらにGoogleは、アプリにジオロケーション機能を追加するのに役立つGoogle Maps Platformとの統合をIDEに追加し、アプリのデバッグに役立つChrome Developer ToolsとLighthouseとの統合を追加しました。また間もなく、Googleはフロントエンドとバックエンドのサービスを実行するためのGoogle CloudのサーバーレスプラットフォームであるCloud Runへのアプリのデプロイもサポートする予定です。

開発環境はまた、グーグルのAI主導のコンプライアンス・プラットフォームである Checks とも統合される。

それを実現するために、IDXには、コード補完やチャットアシスタントのサイドバーといった、今では標準的な機能のほか、コードのスニペットをハイライトする機能や、塗りつぶしを生成するPhotoshopのような機能といった革新的な機能も数多く含まれている。

これを実現するために、同社のGeminiモデルは、その動作方法を変える。GoogleのGeminiモデルにコードスニペットを変更してもらう。

Geminiがコードを提案するときはいつでも、元のソースとそれに関連するライセンスにリンクします。 GoogleがオープンソースのVisual Studioの中核に構築したProject IDXは、そのコアにあるコードです。また、既存のワークフローと簡単に統合できるように、GitHubとも統合されている。IDXの最新バージョンの1つでは、Googleはモバイル開発者のためにIDEにビルトインiOSおよびAndroidシミュレーターも追加しました。

3.アプリとツールのアップデート

1)検索におけるAI

Googleの検索責任者であるLiz Reid氏は、Googleが検索用にカスタマイズしたGeminiモデルを構築したと述べました。

Googleは、ChatGPTやPerplexityのような競合にシェアを奪われているという懸念を和らげるため、検索にさらにAIを追加している。

Googleは検索にAIを追加しています。

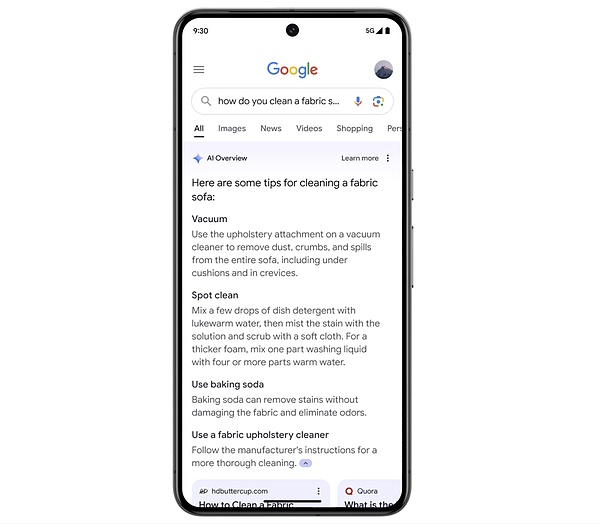

グーグルは、AIを搭載した概要を米国のユーザーに展開している。

グーグルは、AIを搭載した概要を米国のユーザーに展開している。

グーグルは、特定の検索結果について、生成的な AI を使って検索結果ページ全体を整理することを計画している。これは、検索しているトピックに関する情報が集約された短いスニペットを作成する、既存の AI Overview機能を補完するものです。Google AI Labs によって計画された期間を経て、 AI Overview 機能は火曜日に完全に利用可能になります。

Googleは昨年からSGE(Search Generation Experience)を通じて、AIを活用したオーバービューをテストしてきました。

グーグルは昨年から、検索ジェネレーションエクスペリエンス(SGE)を通じて、AIによる概要表示をテストしてきました。

彼女はまた、AI概要機能のテスト中に、グーグルは人々がより多様なサイトをクリックするのを観察したと述べた。従来の検索で十分な結果が得られる場合、ユーザーはAIの概要を見ることはなく、この機能は、情報が散在している、より複雑なクエリに対してより有用である。

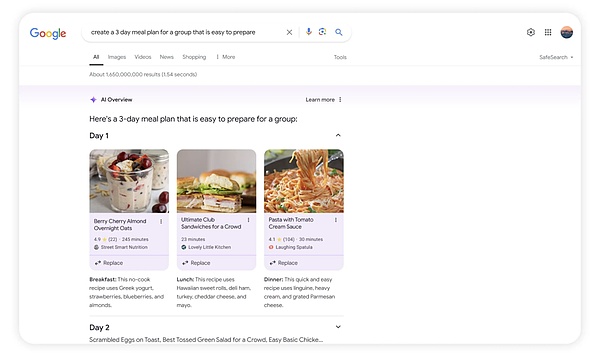

Gemini はまた、食事や旅行の計画などのタスクに、インテリジェント・ボディ・エージェントとして使用したいと考えています。ユーザーは「家族4人分の3日間の食事を計画する」といったクエリを入力し、その3日間のリンクやレシピを得ることができる。

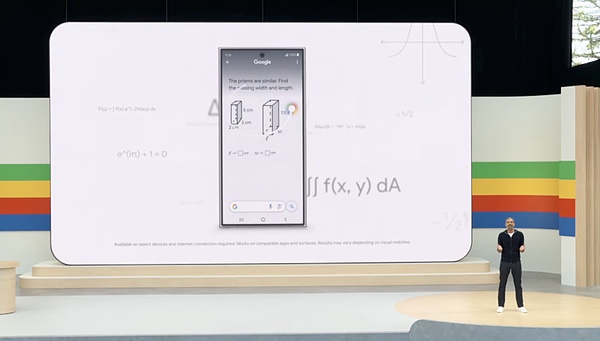

2)サークル検索

AIを搭載した「サークル検索」機能は、Androidユーザーが円を描くように回転するなどのジェスチャーを使って即座に答えを得ることができる機能で、より複雑な心理学や数学のアプリを解くことができるようになります。

これは、ユーザーが携帯電話のどこからでも、丸で囲む、ハイライトする、落書きする、タップするなど、さまざまな操作でGoogle検索をより自然に使えるようにするためのものです。

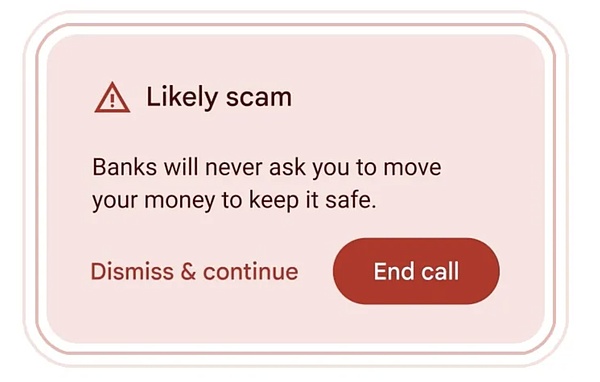

3) 通話中に詐欺を検知する

Google は、通話中にユーザーに詐欺の可能性に注意するよう警告する機能をプレビューしました。を警告する機能をプレビューしました。

この機能は、将来のAndroidのバージョンに組み込まれる予定で、Gemini Nanoを利用します。Gemini Nanoは、Googleが提供するジェネレーティブAIの最小バージョンで、完全にデバイス上で動作します。このシステムは、「詐欺に典型的に関連する対話のパターン」をリアルタイムで効果的に聞き取ります。

グーグルは、「銀行の担当者」のふりをする人物の例を挙げた。このシステムは、パスワードの要求やギフトカードのような一般的な詐欺の手口によっても作動します。これらはあなたからお金を引き出すよく知られた方法ですが、世界中の多くの人々はまだこのような詐欺の被害に遭いやすいのです。一度起動すると、厄介な人物の被害に遭うかもしれないという事実をユーザーに警告する通知をポップアップ表示します。

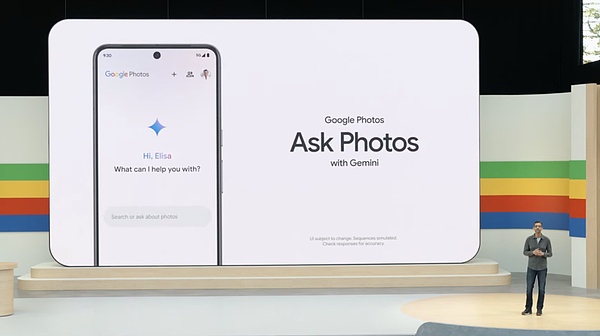

4) Ask Photos

Google Photosは、「Ask Photos」と呼ばれる実験的な機能の開始により、AIをミックスしています。GoogleのGemini AIモデルを搭載した「Ask Photos」と呼ばれる実験的な機能を発表した。

この新機能は今年の夏以降に開始され、ユーザーは写真のコンテンツやその他のメタデータに対するAIの理解を活用した自然言語クエリを使用して、Googleフォトコレクションを検索できるようになります。

以前は、ユーザーは自然言語処理の助けを借りて、写真の中の特定の人物や場所、物を検索することができましたが、このAIアップグレードにより、適切なコンテンツをより直感的に見つけることができるようになり、手動での検索プロセスが軽減されます。

5) Firebase Genkit

Firebaseプラットフォームは、Firebase Genkitと呼ばれる新機能を追加しました。開発者がJavaScript/TypeScriptを使用してAI駆動アプリを簡単に構築できるように設計されており、Goのサポートも間もなく行われる予定です。

Firebaseプラットフォームは、Firebase Genkitと呼ばれる新機能を追加しました。開発者がJavaScript/TypeScriptを使用してAI駆動アプリを簡単に構築できるように設計されており、Goのサポートも間もなく行われる予定です。

これはApache 2.0ライセンスを使用したオープンソースのフレームワークで、開発者は新規および既存のアプリケーションにAIを迅速に組み込むことができます。

さらにGoogleは、コンテンツ生成と要約、テキスト翻訳、画像生成といった標準的なGenAIのユースケースの多くを含む、Genkitのユースケースのいくつかを強調しています。

6) Google Play

Google Playは、新しいアプリ発見機能、ユーザーを獲得する新しい方法、Playポイントの更新、そして世界で最も人気のあるモバイルアプリとなりました。Google Playは、新しいアプリ発見機能、ユーザーを獲得する新しい方法、Play Pointsのアップデート、そしてGoogle Play SDK ConsoleやPlay Integrity APIといった開発者向けツールのその他の強化で注目を集めています。

開発者にとって特に興味深いのは、Engage SDKと呼ばれるもので、アプリメーカーが個々のユーザー向けにパーソナライズされたフルスクリーンの没入型エクスペリエンスでユーザーにコンテンツを見せる方法を紹介するものです。しかし、グーグルによれば、現時点では、ユーザーはこの表面を見ることはできない。

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Coinlive

Coinlive  Twitter

Twitter Bitcoinist

Bitcoinist