< /strong>

< /strong>

Đây là kích thước của tập dữ liệu ImageNet khi Li Feifei, trợ lý giáo sư tại Đại học Princeton, muốn tạo ra nó. Cô hy vọng rằng làm như vậy sẽ giúp cải thiện lĩnh vực thị giác máy tính đang trì trệ. Đây là một nỗ lực táo bạo. 22.000 danh mục này nhiều hơn ít nhất hai bậc so với bất kỳ tập dữ liệu hình ảnh nào được tạo trước đó.

Các đồng nghiệp của cô tin rằng câu trả lời cho việc xây dựng hệ thống trí tuệ nhân tạo tốt hơn nằm ở sự đổi mới thuật toán và họ đặt câu hỏi về sự khôn ngoan của cô. “Càng thảo luận về ý tưởng ImageNet với các đồng nghiệp, tôi càng cảm thấy cô đơn.”

Bất chấp sự hoài nghi, Feifei và nhóm nhỏ của cô—bao gồm cả Ứng viên Tiến sĩ. Jia Deng – và một số sinh viên đại học kiếm được 10 USD một giờ – bắt đầu gắn thẻ hình ảnh từ các công cụ tìm kiếm. Sự tiến triển diễn ra chậm chạp và đau đớn. Jia Deng ước tính rằng với tốc độ hiện tại, sẽ mất 18 năm để hoàn thành ImageNet—thời gian mà không ai có được. Đó là khi một sinh viên thạc sĩ giới thiệu Fei Fei với Mechanical Turk của Amazon, một thị trường thu hút những người đóng góp từ khắp nơi trên thế giới để hoàn thành “nhiệm vụ trí tuệ con người”. Feifei ngay lập tức nhận ra rằng đây chính xác là thứ họ cần.

Vào năm 2009, ba năm sau khi Fei Fei bắt đầu dự án quan trọng nhất trong đời cô, với sự trợ giúp của lực lượng lao động phân tán trên toàn cầu, ImageNet cuối cùng đã sẵn sàng. Cô ấy đã góp phần thực hiện sứ mệnh chung là nâng cao tầm nhìn máy tính.

Bây giờ, đến lượt các nhà nghiên cứu phát triển các thuật toán sử dụng tập dữ liệu khổng lồ này để giúp máy tính nhìn thế giới theo cách con người nhìn. Tuy nhiên, trong 2 năm đầu, điều này đã không xảy ra. Không có thuật toán nào trong số này hoạt động tốt hơn trạng thái trước đó của ImageNet.

Feifei bắt đầu tự hỏi liệu các đồng nghiệp của cô có đúng khi cho rằng ImageNet là một nỗ lực vô ích hay không.

Sau đó, vào tháng 8 năm 2012, khi Feifei đã từ bỏ hy vọng rằng dự án của cô sẽ truyền cảm hứng cho những thay đổi mà cô đã hình dung, Jia Deng đã khẩn cấp gọi cho cô để báo cho cô biết Tin tức về AlexNet. Thuật toán mới này, được đào tạo trên ImageNet, vượt trội hơn tất cả các thuật toán thị giác máy tính trong lịch sử. Được tạo ra bởi ba nhà nghiên cứu tại Đại học Toronto, AlexNet sử dụng kiến trúc AI gần như bị bỏ rơi được gọi là "mạng lưới thần kinh" và vượt quá mong đợi lớn nhất của Fei Fei.

Lúc đó, cô biết rằng nỗ lực của mình đã có kết quả. "Lịch sử vừa mới được tạo ra và chỉ có một số người trên thế giới biết điều đó." Li Feifei đã chia sẻ câu chuyện đằng sau ImageNet trong cuốn hồi ký "The World I Saw" của cô.

ImageNet kết hợp với AlexNet mang tính lịch sử vì nhiều lý do.

Trước hết, việc sử dụng lại mạng lưới thần kinh từ lâu đã được coi là một công nghệ ngõ cụt . Nó đã trở thành kiến trúc thực tế đằng sau thuật toán thúc đẩy sự phát triển AI theo cấp số nhân trong hơn mười năm.

Thứ hai, ba nhà nghiên cứu từ Toronto (một trong số họ có thể bạn đã nghe nói đến là Ilya Sutskever) là những người đầu tiên sử dụng One of những người sử dụng bộ xử lý đồ họa (GPU) để đào tạo các mô hình AI. Đây cũng là tiêu chuẩn công nghiệp hiện nay.

Thứ ba, ngành công nghiệp AI cuối cùng đã nhận ra điều mà Feifei đề xuất lần đầu tiên từ nhiều năm trước: các yếu tố chính của trí tuệ nhân tạo tiên tiến là dữ liệu số lượng lớn.

Chúng ta đều đã đọc và nghe những cụm từ như “dữ liệu là dầu mới” và “rác thải là , rác thải ra” là câu tục ngữ không biết bao nhiêu lần. Nếu những lời này không phải là sự thật cơ bản về thế giới của chúng ta thì chúng ta có thể sẽ cảm thấy nhàm chán. Trong những năm qua, trí tuệ nhân tạo đã hoạt động âm thầm để trở thành một phần ngày càng quan trọng trong cuộc sống của chúng ta – ảnh hưởng đến những dòng tweet chúng ta đọc, những bộ phim chúng ta xem, mức giá chúng ta phải trả và khoản tín dụng mà chúng ta cho là xứng đáng. Tất cả điều này được thúc đẩy bởi việc thu thập dữ liệu theo dõi tỉ mỉ mọi chuyển động của chúng ta trong thế giới kỹ thuật số.

Nhưng trong hai năm qua, kể từ khi một công ty khởi nghiệp tương đối xa lạ OpenAI phát hành một ứng dụng chatbot có tên ChatGPT, trí tuệ nhân tạo đã trở nên quan trọng hơn. Anh ấy đã chuyển từ phía sau cảnh trước sân khấu. Chúng ta đang ở trên đỉnh cao của trí tuệ máy móc thâm nhập vào mọi khía cạnh của cuộc sống. Khi sự cạnh tranh ngày càng nóng lên về việc ai sẽ kiểm soát trí thông minh này, thì nhu cầu về dữ liệu thúc đẩy nó cũng tăng theo.

Đây chính là nội dung của bài viết này. Chúng tôi thảo luận về quy mô và mức độ khẩn cấp của dữ liệu mà các công ty AI yêu cầu cũng như những vấn đề họ gặp phải khi thu thập dữ liệu đó. Chúng tôi khám phá xem nhu cầu vô độ này đe dọa tình yêu của chúng tôi đối với Internet và hàng tỷ người đóng góp trên Internet như thế nào. Cuối cùng, chúng tôi lập hồ sơ về một số công ty khởi nghiệp mới nổi đang sử dụng tiền điện tử để giải quyết những vấn đề và mối lo ngại này.

Trước khi đi sâu vào phần này, xin lưu ý nhanh: bài viết này được viết từ góc độ đào tạo các mô hình ngôn ngữ lớn (LLM), không phải tất cả các hệ thống AI. Vì vậy, tôi thường sử dụng "AI" và "LLM" thay thế cho nhau. Mặc dù cách sử dụng này không chính xác về mặt kỹ thuật, nhưng các khái niệm và câu hỏi áp dụng cho LLM, đặc biệt đối với dữ liệu, cũng áp dụng cho các dạng mô hình AI khác.

Dữ liệu

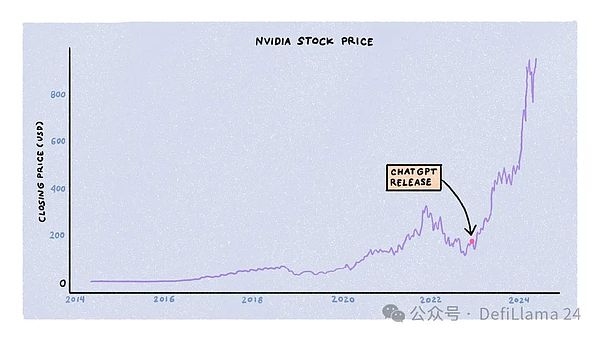

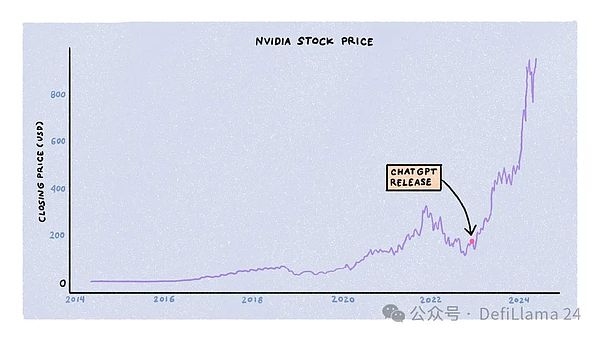

Các mô hình ngôn ngữ lớn được đào tạo bởi ba ràng buộc trên các tài nguyên chính: điện toán, năng lượng và dữ liệu. Các công ty, chính phủ và các công ty khởi nghiệp đang cạnh tranh để có được những nguồn tài nguyên này, được hỗ trợ bởi lượng vốn khổng lồ. Trong số ba công ty, sự cạnh tranh về điện toán là khốc liệt nhất, một phần nhờ vào sự tăng giá chóng mặt của giá cổ phiếu NVIDIA.

Đào tạo LLM đòi hỏi phải có nhiều cụm đơn vị xử lý đồ họa (GPU) chuyên dụng, đặc biệt là các mẫu A100, H100 và B100 sắp ra mắt của NVIDIA. Đây không phải là những máy tính bạn có thể mua ngoài kệ từ Amazon hoặc cửa hàng máy tính địa phương. Thay vào đó, chúng có giá hàng chục ngàn đô la. NVIDIA quyết định cách phân bổ nguồn cung của mình cho các phòng thí nghiệm AI, công ty khởi nghiệp, trung tâm dữ liệu và khách hàng siêu quy mô.

Trong 18 tháng kể từ khi ChatGPT được phát hành, nhu cầu GPU đã vượt xa nguồn cung, khiến thời gian chờ đợi lên tới 11 tháng. Tuy nhiên, khi lớp bụi từ sự hỗn loạn ban đầu lắng xuống, động lực cung và cầu đang bình thường hóa. Việc đóng cửa các công ty khởi nghiệp, cải tiến về thuật toán đào tạo và kiến trúc mô hình, sự xuất hiện của chip chuyên dụng từ các công ty khác và việc NVIDIA tăng cường sản xuất đều góp phần tăng tính sẵn có của GPU và giảm giá.

Thứ hai, năng lượng. Việc chạy GPU trong trung tâm dữ liệu đòi hỏi rất nhiều năng lượng. Theo một số ước tính, các trung tâm dữ liệu sẽ tiêu thụ 4,5% năng lượng toàn cầu vào năm 2030. Khi nhu cầu tăng cao này gây áp lực lên lưới điện hiện có, các công ty công nghệ đang khám phá các giải pháp năng lượng thay thế. Amazon gần đây đã mua một trung tâm dữ liệu được cung cấp bởi một nhà máy điện hạt nhân với giá 650 triệu USD. Microsoft đã thuê một giám đốc công nghệ hạt nhân. Sam Altman của OpenAI đã hỗ trợ các công ty khởi nghiệp về năng lượng như Helion, Exowatt và Oklo.

Từ góc độ đào tạo các mô hình AI - năng lượng và điện toán chỉ là hàng hóa. Sử dụng B100 thay vì H100 hoặc năng lượng hạt nhân thay vì năng lượng thông thường có thể giúp quá trình đào tạo rẻ hơn, nhanh hơn và hiệu quả hơn nhưng sẽ không ảnh hưởng đến chất lượng của mô hình. Nói cách khác, trong cuộc đua tạo ra các mô hình AI thông minh nhất và giống con người nhất, năng lượng và tính toán là những yếu tố cơ bản chứ không phải là yếu tố khác biệt.

Tài nguyên chính là dữ liệu.

James Betker là kỹ sư nghiên cứu tại OpenAI. Nói theo cách riêng của mình, ông đã đào tạo "nhiều mô hình có tính sáng tạo hơn bất kỳ ai có quyền đào tạo". Trong một bài đăng trên blog, ông lưu ý rằng "đào tạo trên cùng một tập dữ liệu đủ lâu và hầu như bất kỳ mô hình nào có đủ trọng số và thời gian huấn luyện sẽ hội tụ về cùng một điểm". tập dữ liệu. không có gì khác.

Khi chúng tôi gọi một mô hình là "ChatGPT", "Claude", "Mistral" hoặc "Lambda", chúng tôi không nói về kiến trúc hoặc GPU đã sử dụng Hoặc năng lượng tiêu thụ nhưng tập dữ liệu được đào tạo trên đó.

Cần bao nhiêu dữ liệu để đào tạo một mô hình sáng tạo hiện đại?

Trả lời: Rất nhiều.

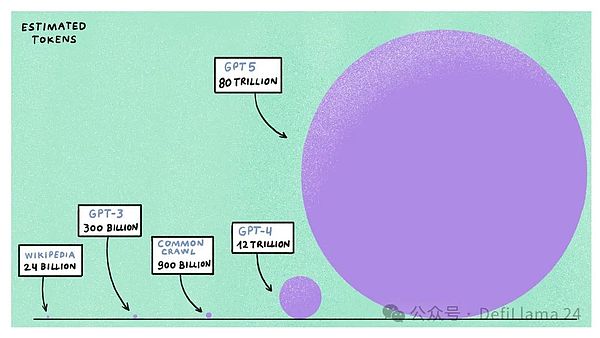

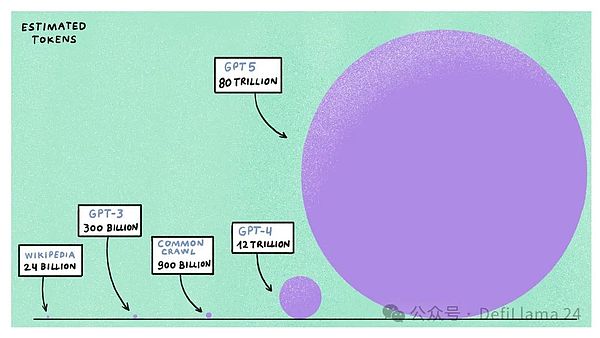

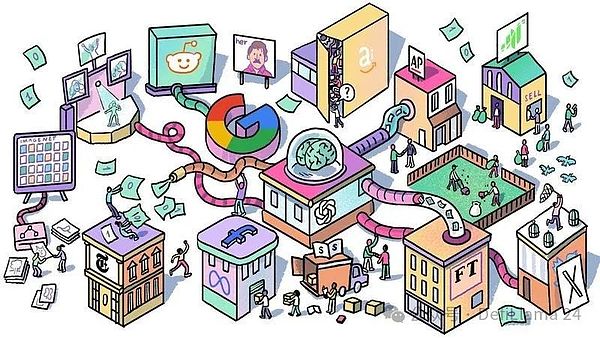

GPT-4, hơn một năm sau khi phát hành vẫn được coi là mô hình ngôn ngữ quy mô lớn tốt nhất, với ước tính khoảng 1,2 nghìn tỷ token (tương đương khoảng 900 tỷ từ). Dữ liệu đến từ các nguồn có sẵn công khai trên internet, bao gồm Wikipedia, Reddit, Common Crawl (kho lưu trữ dữ liệu web miễn phí và mở), hơn một triệu giờ dữ liệu YouTube được sao chép và các nền tảng mã hóa như GitHub và Stack Overflow.

Nếu bạn cho rằng như vậy là quá nhiều dữ liệu, hãy đợi. Có một khái niệm trong AI tổng quát được gọi là "Luật chia tỷ lệ Chinchilla" nêu rõ rằng, với ngân sách điện toán nhất định, việc đào tạo một mô hình nhỏ hơn trên một tập dữ liệu lớn hơn sẽ hiệu quả hơn là đào tạo một mô hình lớn hơn trên một tập dữ liệu nhỏ hơn. Nếu chúng tôi ngoại suy tài nguyên điện toán do các công ty AI phân bổ để đào tạo các mô hình AI thế hệ tiếp theo như GPT-5 và Llama-4 - chúng tôi thấy rằng các mô hình này dự kiến sẽ yêu cầu sức mạnh tính toán gấp 5 đến 6 lần, sử dụng tới 100 nghìn tỷ mã thông báo . xe lửa.

Vì hầu hết dữ liệu internet công cộng đã được thu thập thông tin, lập chỉ mục và sử dụng để huấn luyện các mô hình hiện có, nên dữ liệu bổ sung đến từ đâu? Điều này đã trở thành một câu hỏi nghiên cứu tiên tiến cho các công ty AI. Có hai cách để giải quyết vấn đề này. Một là bạn quyết định sử dụng dữ liệu tổng hợp do LLM trực tiếp tạo ra chứ không phải do con người. Tuy nhiên, hiệu quả của dữ liệu này trong việc làm cho các mô hình trở nên thông minh hơn vẫn chưa được thử nghiệm.

Một lựa chọn khác là chỉ cần tìm kiếm dữ liệu chất lượng cao thay vì tạo dữ liệu tổng hợp. Tuy nhiên, việc thu thập dữ liệu bổ sung là một thách thức, đặc biệt khi các công ty AI phải đối mặt với các vấn đề đe dọa không chỉ đến việc đào tạo các mô hình trong tương lai mà còn cả tính hiệu quả của các mô hình hiện có.

Vấn đề dữ liệu đầu tiên liên quan đến vấn đề pháp lý. Mặc dù các công ty AI tuyên bố họ đào tạo các mô hình dựa trên “dữ liệu có sẵn công khai”, nhưng phần lớn dữ liệu đó có bản quyền. Ví dụ: tập dữ liệu Common Crawl chứa hàng triệu bài viết từ các ấn phẩm như The New York Times và The Associated Press, cũng như các tài liệu có bản quyền khác như sách đã xuất bản và lời bài hát.

Một số nhà xuất bản và người sáng tạo đang thực hiện hành động pháp lý chống lại các công ty AI, cho rằng họ vi phạm bản quyền và quyền sở hữu trí tuệ của họ. The Times đang kiện OpenAI và Microsoft vì “sao chép và sử dụng trái phép tác phẩm độc đáo và có giá trị của The Times”. Một nhóm lập trình viên đã đệ đơn kiện tập thể thách thức tính hợp pháp của việc sử dụng mã nguồn mở để đào tạo GitHub Copilot, một trợ lý lập trình AI nổi tiếng.

Diễn viên hài Sarah Silverman và nhà văn Paul Tremblay cũng đang kiện các công ty AI vì sử dụng tác phẩm của họ mà không được phép.

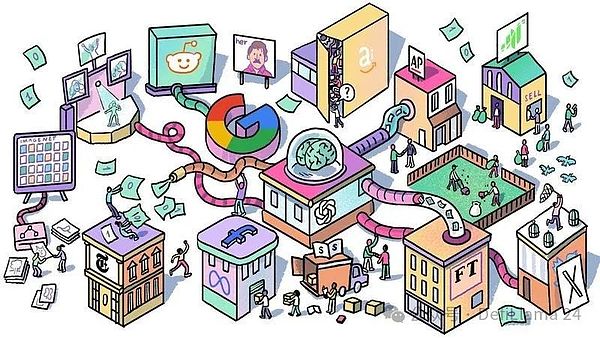

Những người khác đang đón nhận kỷ nguyên thay đổi bằng cách hợp tác với các công ty AI. Associated Press, Financial Times và Axel Springer đều đã ký các thỏa thuận cấp phép nội dung với OpenAI. Apple đang khám phá mối quan hệ hợp tác tương tự với các tổ chức tin tức như Condé Nast và NBC. Google đã đồng ý trả 60 triệu USD mỗi năm để có quyền truy cập vào API Reddit để đào tạo các mô hình và Stack Overflow đã đạt được thỏa thuận tương tự với OpenAI. Meta đang xem xét việc mua hoàn toàn nhà xuất bản Simon & Schuster.

Những sự hợp tác này phù hợp với vấn đề thứ hai mà các công ty AI phải đối mặt: việc đóng cửa các mạng mở.

Các diễn đàn Internet và trang mạng xã hội đã công nhận giá trị mà các công ty AI tạo ra bằng cách tận dụng dữ liệu trên nền tảng của họ để đào tạo người mẫu. Trước thỏa thuận với Google (và có thể cả các công ty AI khác trong tương lai), Reddit đã bắt đầu tính phí API miễn phí trước đây của mình, đóng cửa các ứng dụng khách phổ biến của bên thứ ba. Tương tự, Twitter đã hạn chế quyền truy cập vào API của nó và tăng giá, đồng thời Elon Musk sử dụng dữ liệu Twitter để đào tạo các mô hình cho công ty AI của riêng mình, xAI.

Ngay cả những ấn phẩm nhỏ hơn, diễn đàn tiểu thuyết dành cho người hâm mộ và các góc thích hợp khác của Internet cũng sản xuất nội dung để mọi người tự do tiêu thụ và thông qua quảng cáo (Nếu có) lợi nhuận hiện nay cũng bắt đầu đóng cửa. Internet ban đầu được hình dung như một không gian ảo kỳ diệu, nơi mọi người có thể tìm thấy một bộ tộc có chung sở thích và thói quen riêng của họ. Phép thuật dường như đang dần tan biến.

Mối đe dọa kiện tụng, xu hướng ngày càng tăng của hàng triệu giao dịch nội dung và việc đóng cửa các mạng mở đã kết hợp lại tạo ra hai tác động:

< p style="text-align: left;"> p>

Trước hết, cuộc chiến dữ liệu đang diễn ra thiên về những gã khổng lồ công nghệ. Các công ty khởi nghiệp và công ty nhỏ không thể truy cập các API có sẵn trước đây cũng như không thể trả số tiền mặt cần thiết để mua quyền sử dụng nếu không gặp rủi ro pháp lý. Điều này có tác dụng tập trung rõ ràng, tức là người giàu mua được dữ liệu tốt nhất và tạo ra những mô hình tốt nhất sẽ trở nên giàu hơn.

Thứ hai, mô hình kinh doanh của nền tảng nội dung do người dùng tạo ngày càng bất lợi cho người dùng. Các nền tảng như Reddit và Stack Overflow dựa vào sự đóng góp của hàng triệu người sáng tạo và người kiểm duyệt không được trả lương. Tuy nhiên, khi các nền tảng này đạt được các thỏa thuận trị giá hàng triệu đô la với các công ty AI, họ không trả tiền cho người dùng cũng như không xin phép nếu không có người dùng thì sẽ không có dữ liệu để bán.

Cả Reddit và Stack Overflow đều trải qua những cuộc đình công đáng kể của người dùng để phản đối những quyết định này. Về phần mình, Ủy ban Thương mại Liên bang (FTC) đã mở một cuộc điều tra về hoạt động bán, cấp phép và chia sẻ bài đăng của người dùng với các tổ chức bên ngoài để đào tạo các mô hình AI của Reddit.

Những vấn đề này đặt ra những câu hỏi liên quan đến việc đào tạo thế hệ mô hình AI tiếp theo và tương lai của nội dung web. Hiện tại, tương lai đó có vẻ khá vô vọng. Các giải pháp mã hóa có thể tạo sân chơi bình đẳng cho các công ty nhỏ và người dùng Internet cũng như giải quyết những vấn đề này không?

Xóa bỏ quy trình

Đào tạo các mô hình AI và tạo ra các Ứng dụng hữu ích là những nỗ lực phức tạp và tốn kém đòi hỏi nhiều tháng lập kế hoạch, phân bổ nguồn lực và thực hiện. Các quy trình này bao gồm nhiều giai đoạn, mỗi giai đoạn có mục đích khác nhau và yêu cầu dữ liệu khác nhau.

Hãy chia nhỏ các giai đoạn này để hiểu cách mã hóa phù hợp với câu đố AI lớn hơn.

Đào tạo trước

Đào tạo trước là LLM Quá trình đào tạo Bước đầu tiên và tốn nhiều tài nguyên nhất là tạo thành nền tảng của mô hình. Ở giai đoạn này, mô hình AI được huấn luyện trên một lượng lớn văn bản chưa được gắn nhãn để nắm bắt kiến thức chung và thông tin sử dụng ngôn ngữ về thế giới. Khi chúng tôi nói GPT-4 đã được đào tạo trên 1,2 nghìn tỷ mã thông báo, điều này đề cập đến dữ liệu được sử dụng để đào tạo trước.

Chúng tôi cần có cái nhìn tổng quan cấp cao về cách thức hoạt động của LLM để hiểu lý do tại sao đào tạo trước là nền tảng của LLM. Lưu ý rằng đây là một cái nhìn tổng quan đơn giản. Bạn có thể tìm thấy lời giải thích toàn diện hơn trong bài viết xuất sắc này của

Jon Stokes

, hoặc trong video tuyệt vời này,

Andrej Karpathy

Hoặc thậm chí trong cuốn sách nổi bật này Tìm thêm phân tích chuyên sâu trong .

Stephen Wolfram

LLM sử dụng một kỹ thuật thống kê được gọi là dự đoán mã thông báo tiếp theo. Nói một cách đơn giản, với một chuỗi mã thông báo (tức là các từ), mô hình sẽ cố gắng dự đoán mã thông báo có khả năng xảy ra tiếp theo nhất. Quá trình này được lặp lại để tạo thành một phản ứng hoàn chỉnh. Vì vậy, bạn có thể coi mô hình ngôn ngữ lớn như một "cỗ máy hợp nhất hoàn chỉnh".

Hãy để chúng tôi hiểu điều này thông qua một ví dụ.

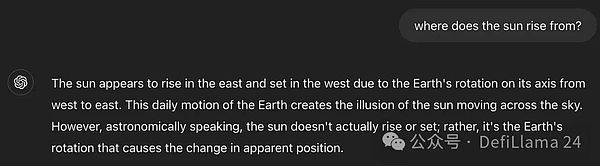

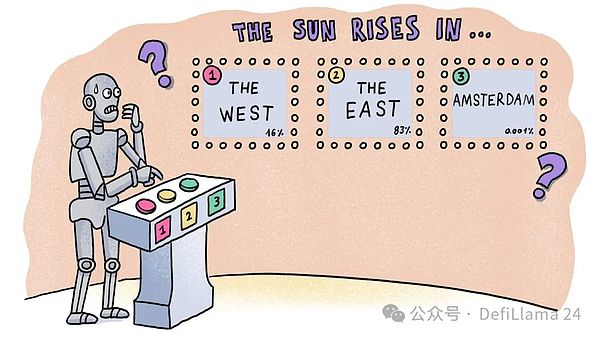

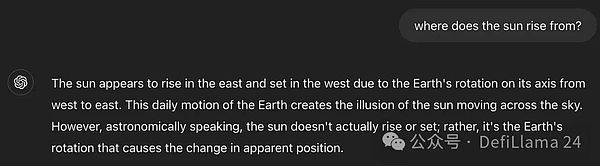

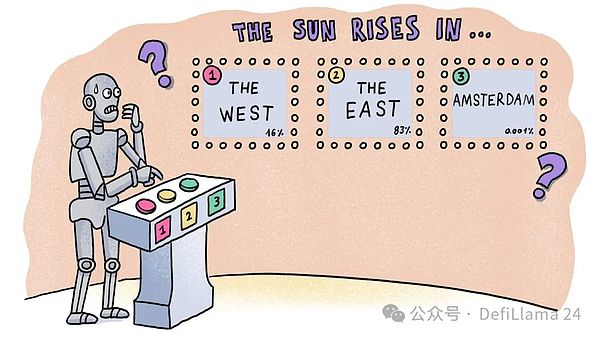

Khi tôi hỏi ChatGPT một câu hỏi như "Mặt trời mọc theo hướng nào?", đầu tiên nó dự đoán từ "the" và sau đó là cụm từ "mặt trời" Mỗi từ tiếp theo trong "trỗi dậy từ phía đông". Nhưng những dự đoán này đến từ đâu? Làm cách nào ChatGPT xác định rằng sau "mặt trời từ" nó phải là "đông" thay vì "tây", "bắc" hoặc "amsterdam"? Nói cách khác, làm sao biết được rằng "Phương Đông" có nhiều khả năng xảy ra hơn về mặt thống kê so với các lựa chọn khác?

Một cách khác để hiểu điều này là so sánh số lượng trang Wikipedia có chứa các cụm từ này. “Mặt trời mọc ở phương Đông” có 55 trang, trong khi “Mặt trời mọc ở phương Tây” có 27 trang. Không có kết quả nào được hiển thị cho "Mặt trời mọc ở Amsterdam"! Đây là những chế độ được ChatGPT lựa chọn.

Câu trả lời nằm ở việc học các mẫu thống kê từ lượng lớn dữ liệu đào tạo chất lượng cao. Nếu bạn xem xét tất cả các văn bản trên Internet, điều gì có nhiều khả năng xuất hiện hơn - "Mặt trời mọc ở phía đông" hay "Mặt trời mọc ở phía tây"? Cái sau có thể được tìm thấy trong các bối cảnh cụ thể, chẳng hạn như ẩn dụ văn học ("Sẽ vô lý như việc tin rằng mặt trời mọc ở phía tây") hoặc trong các cuộc thảo luận về các hành tinh khác (chẳng hạn như sao Kim, nơi mặt trời mọc ở phía tây). ). Nhưng nhìn chung, cái trước phổ biến hơn nhiều.

Bằng cách liên tục dự đoán từ tiếp theo, LLM phát triển cái nhìn tổng thể về thế giới (cái mà chúng tôi gọi là lẽ thường) cũng như sự hiểu biết về các quy tắc và khuôn mẫu của ngôn ngữ. Một cách khác để xem LLM là một phiên bản nén của Internet. Nó cũng giúp hiểu lý do tại sao dữ liệu cần phải lớn (nhiều danh mục hơn để lựa chọn) và chất lượng cao (để cải thiện độ chính xác của việc học mẫu).

Nhưng như đã thảo luận trước đó, các công ty AI đang cạn kiệt dữ liệu để đào tạo các mô hình lớn hơn. Nhu cầu về dữ liệu đào tạo đang tăng nhanh hơn nhiều so với tốc độ tạo ra dữ liệu mới trên internet mở. Với các vụ kiện sắp xảy ra và việc đóng cửa các diễn đàn lớn, các công ty AI phải đối mặt với những câu hỏi nghiêm trọng.

Vấn đề càng trầm trọng hơn đối với các công ty nhỏ hơn không đủ khả năng chi trả cho các giao dịch trị giá hàng triệu đô la với các nhà cung cấp dữ liệu độc quyền như Reddit.

Điều này đưa chúng ta đến với Grass, một nhà cung cấp dịch vụ proxy dân cư phi tập trung nhằm giải quyết một số vấn đề về dữ liệu này. Họ tự gọi mình là “lớp dữ liệu của AI”. Trước tiên chúng ta hãy hiểu vai trò của nhà cung cấp dịch vụ đại lý dân cư.

Internet là nguồn dữ liệu đào tạo tốt nhất và việc thu thập thông tin trên Internet là phương pháp ưa thích của các công ty để có được dữ liệu này. Trong thực tế, phần mềm thu thập thông tin thường được lưu trữ trong các trung tâm dữ liệu để có quy mô, sự tiện lợi và hiệu quả. Tuy nhiên, các công ty có dữ liệu có giá trị không muốn dữ liệu của họ được sử dụng để đào tạo các mô hình AI (trừ khi họ được trả tiền). Để thực thi những hạn chế này, họ thường chặn các địa chỉ IP từ các trung tâm dữ liệu đã biết, ngăn chặn việc thu thập dữ liệu trên quy mô lớn.

Đây là lúc các nhà cung cấp dịch vụ đại lý dân cư phát huy tác dụng. Các trang web chỉ chặn địa chỉ IP của các trung tâm dữ liệu đã biết chứ không chặn địa chỉ IP của những người dùng Internet thông thường như bạn và tôi, điều này làm cho kết nối Internet hoặc kết nối Internet dân dụng của chúng ta trở nên có giá trị. Các nhà cung cấp dịch vụ proxy dân cư tổng hợp hàng triệu kết nối này để thu thập dữ liệu các trang web trên quy mô lớn cho các công ty AI.

Tuy nhiên, các nhà cung cấp dịch vụ proxy dân cư tập trung hoạt động bí mật. Họ thường không nói rõ ý định của mình. Nếu người dùng biết rằng một sản phẩm đang sử dụng băng thông của họ và sản phẩm đó không bù đắp cho họ, họ có thể miễn cưỡng cung cấp băng thông của mình. Tệ hơn nữa, họ có thể yêu cầu bồi thường cho việc sử dụng băng thông, từ đó làm giảm lợi nhuận của họ.

Để bảo vệ lợi nhuận của mình, các nhà cung cấp dịch vụ proxy dân dụng đính kèm mã tiêu tốn băng thông vào các ứng dụng miễn phí được phân phối rộng rãi, chẳng hạn như các ứng dụng công cụ di động (chẳng hạn như máy tính và máy ghi âm), nhà cung cấp VPN và thậm chí cả trình bảo vệ màn hình TV dành cho người tiêu dùng. Những người dùng nghĩ rằng họ đang nhận được một sản phẩm miễn phí thường không biết rằng các nhà cung cấp dịch vụ dân cư bên thứ ba đang tiêu tốn băng thông của họ (những chi tiết này thường bị chôn vùi trong các điều khoản dịch vụ mà ít người đọc).

Cuối cùng, một số dữ liệu này sẽ được chuyển đến các công ty AI. Họ sử dụng dữ liệu đó để đào tạo các mô hình và tạo ra giá trị cho chính họ.

Trong khi điều hành nhà cung cấp dịch vụ proxy dân cư của riêng mình, Andrej Radonjic nhận thức được bản chất phi đạo đức của những hoạt động này và sự bất công của chúng đối với người dùng. Ông đã nhìn thấy sự phát triển của tiền điện tử và xác định cách tạo ra một giải pháp công bằng hơn. Đó là lý do Grass được thành lập vào cuối năm 2022. Vài tuần sau, ChatGPT được phát hành, thay đổi thế giới và đặt Grass vào đúng nơi, đúng thời điểm.

Không giống như các chiến thuật lén lút của các nhà cung cấp dịch vụ proxy dân cư khác, Grass sử dụng băng thông để đào tạo các mô hình AI một cách rõ ràng cho người dùng. Đổi lại, họ nhận được phần thưởng trực tiếp. Mô hình này cách mạng hóa cách thức hoạt động của các nhà cung cấp dịch vụ đại lý dân cư. Bằng cách tự nguyện cung cấp quyền truy cập băng thông và trở thành chủ sở hữu một phần của mạng, người dùng chuyển đổi từ những người tham gia thụ động không hiểu biết thành những người truyền bá tích cực, tăng độ tin cậy của mạng và hưởng lợi từ giá trị do AI tạo ra.

Cỏ đã có sự phát triển đáng kể. Kể từ khi ra mắt vào tháng 6 năm 2023, họ đã tích lũy được hơn 2 triệu người dùng đang hoạt động chạy các nút (bằng cách cài đặt tiện ích mở rộng trình duyệt hoặc ứng dụng dành cho thiết bị di động) và đóng góp băng thông cho mạng. Sự tăng trưởng này diễn ra mà không cần bất kỳ chi phí tiếp thị bên ngoài nào và được thúc đẩy bởi một chương trình giới thiệu rất thành công.

Việc sử dụng dịch vụ của Grass cho phép các công ty thuộc mọi quy mô, từ các phòng thí nghiệm AI lớn đến các công ty khởi nghiệp nguồn mở, được thu thập dữ liệu mà không phải trả hàng triệu đô la cho dữ liệu đào tạo. Trong khi đó, người dùng hàng ngày được khen thưởng khi chia sẻ kết nối internet của họ, trở thành một phần của nền kinh tế AI đang phát triển.

Bên cạnh dữ liệu thô, Grass còn cung cấp một số dịch vụ bổ sung cho khách hàng của mình.

Đầu tiên, họ chuyển đổi các trang web phi cấu trúc thành dữ liệu có cấu trúc để các mô hình AI có thể xử lý dễ dàng hơn. Bước này được gọi là làm sạch dữ liệu và là một nhiệm vụ tiêu tốn nhiều tài nguyên thường được thực hiện bởi các phòng thí nghiệm AI. Bằng cách cung cấp các bộ dữ liệu rõ ràng, có cấu trúc, Grass tăng giá trị cho khách hàng. Ngoài ra, Grass đang đào tạo LLM nguồn mở để tự động hóa quá trình quét, làm sạch và ghi nhãn dữ liệu.

Thứ hai, Grass đang đóng gói tập dữ liệu với bằng chứng xuất xứ không thể chối cãi. Do tầm quan trọng của dữ liệu chất lượng cao đối với các mô hình AI, điều quan trọng đối với các công ty AI là phải đảm bảo rằng những kẻ xấu – cho dù là trang web hay nhà cung cấp proxy dân cư – không có quyền giả mạo các tập dữ liệu.

Quy mô của vấn đề được phản ánh qua việc hình thành các tổ chức như Liên minh Dữ liệu và Tin cậy, một liên minh gồm các tổ chức bao gồm Meta, IBM và Walmart Một tổ chức phi lợi nhuận. tổ chức gồm hơn chục công ty làm việc cùng nhau để tạo ra các tiêu chuẩn xuất xứ giúp các tổ chức xác định liệu một bộ dữ liệu có phù hợp và đáng tin cậy để sử dụng hay không.

Grass cũng đang thực hiện các bước tương tự. Mỗi khi nút Grass thu thập dữ liệu một trang web, nó cũng ghi lại siêu dữ liệu để xác minh trang web được thu thập thông tin. Những bằng chứng xuất xứ này được lưu trữ trên blockchain và được chia sẻ với khách hàng (những người có thể chia sẻ thêm với người dùng của họ).

Mặc dù Grass được xây dựng trên Solana, một trong những blockchain có thông lượng cao nhất, việc lưu trữ mọi công việc cào trên L1 Nguồn là không thực tế. Vì vậy, Grass đang xây dựng một bản tổng hợp (một trong những bản tổng hợp đầu tiên trên Solana) sử dụng bộ xử lý ZK để xử lý hàng loạt bằng chứng xuất xứ và sau đó xuất bản chúng trên Solana. Bản tổng hợp này, mà Grass gọi là “lớp dữ liệu của AI”, trở thành sổ cái dữ liệu cho tất cả dữ liệu mà họ thu thập được.

Cách tiếp cận 3-đầu tiên của Grass's Web mang lại cho nó một số lợi thế so với các nhà cung cấp proxy dân cư tập trung. Đầu tiên, bằng cách sử dụng các biện pháp khuyến khích để cho phép người dùng chia sẻ băng thông trực tiếp, họ phân phối giá trị do AI tạo ra một cách công bằng hơn (đồng thời tiết kiệm chi phí trả tiền cho các nhà phát triển ứng dụng để đóng gói mã của họ). Thứ hai, họ có thể tính phí cho việc cung cấp "lưu lượng truy cập hợp pháp", vốn có giá trị cao trong ngành.

Một giao thức khác được xây dựng từ góc độ "lưu lượng truy cập hợp pháp" là Masa. Mạng cho phép người dùng chuyển thông tin đăng nhập của họ cho các nền tảng như Reddit, Twitter hoặc TikTok. Các nút trên mạng sau đó lấy dữ liệu cập nhật, theo ngữ cảnh. Ưu điểm của mô hình này là dữ liệu được thu thập chính là dữ liệu mà người dùng Twitter bình thường sẽ thấy trong nguồn cấp dữ liệu của họ. Bạn có thể có các tập dữ liệu phong phú theo thời gian thực để dự đoán cảm xúc hoặc nội dung sắp lan truyền

Các tập dữ liệu của họ được dùng để làm gì? Hiện tại, có hai trường hợp sử dụng chính cho dữ liệu theo ngữ cảnh này.

Tài chính - Nếu bạn có cơ chế xem hàng nghìn người trong nguồn cấp dữ liệu của họ Dựa trên những gì bạn thấy ở trên, bạn có thể phát triển một chiến lược giao dịch. Các tác nhân thông minh dựa trên dữ liệu cảm xúc có thể được đào tạo trên tập dữ liệu của Masa.

Xã hội - Sự xuất hiện của những người bạn đồng hành dựa trên AI (hoặc các công cụ như Replika) có nghĩa là chúng ta cần các tập dữ liệu bắt chước cuộc trò chuyện của con người. Những cuộc trò chuyện này cũng cần được cập nhật những thông tin mới nhất. Luồng dữ liệu của Masa có thể được sử dụng để đào tạo các đại lý có thể nói một cách có ý nghĩa về các xu hướng mới nhất trên Twitter.

Cách tiếp cận của Masa là lấy thông tin từ các khu vườn kín (chẳng hạn như Twitter) và cung cấp chúng sau khi có được sự đồng ý của người dùng. để xây dựng các ứng dụng. Phương pháp thu thập dữ liệu ưu tiên xã hội này cũng cho phép xây dựng các tập dữ liệu dựa trên các ngôn ngữ quốc gia khác nhau.

Ví dụ: bot nói tiếng Hindi có thể được sử dụng để thu thập dữ liệu từ các mạng xã hội hoạt động bằng tiếng Hindi. Các loại ứng dụng mà các mạng này cho phép vẫn chưa được khám phá.

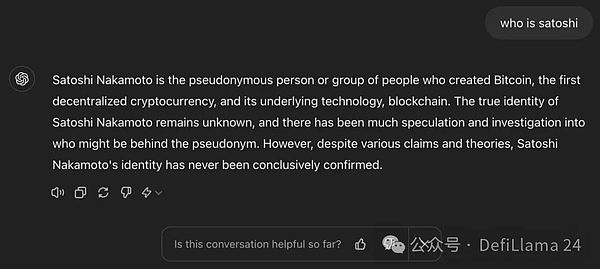

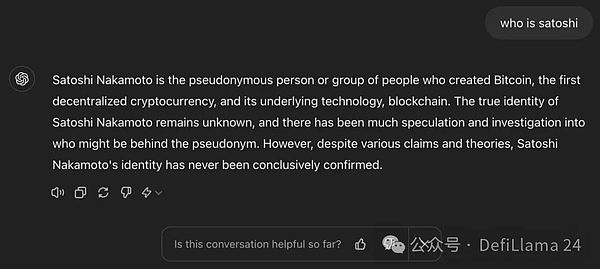

Căn chỉnh mô hình

LLM được đào tạo trước còn lâu mới đạt được sẵn sàng Tốt cho sản xuất. nghĩ về nó Cho đến nay, tất cả những gì mô hình biết là cách dự đoán từ tiếp theo trong chuỗi, không có gì khác. Nếu bạn đưa cho mô hình được huấn luyện trước một số văn bản, chẳng hạn như "Satoshi Nakamoto là ai", thì bất kỳ câu trả lời nào sau đây sẽ là câu trả lời hợp lệ:

-

Hoàn thành câu hỏi: Satoshi Nakamoto?

Chuyển một cụm từ thành một câu: Đây là câu hỏi khiến các tín đồ Bitcoin bực tức trong nhiều năm.

Câu trả lời đúng cho câu hỏi: Satoshi Nakamoto là người đã tạo ra Bitcoin (đồng tiền điện tử phi tập trung đầu tiên) và các khối cơ bản của nó Một ẩn danh người hoặc nhóm sử dụng công nghệ blockchain.

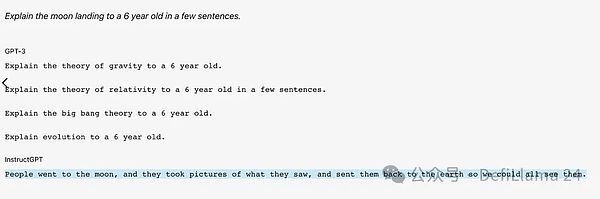

Một LLM được thiết kế để cung cấp các câu trả lời hữu ích sẽ cung cấp phản hồi thứ ba. Tuy nhiên, phản hồi của mô hình được huấn luyện trước không nhất quán hoặc không chính xác. Trên thực tế, họ thường xuất ra văn bản ngẫu nhiên không có ý nghĩa gì đối với người dùng cuối. Tệ nhất, mô hình bí mật phản hồi bằng thông tin thực tế sai, độc hại hoặc có hại. Khi điều này xảy ra, người mẫu được cho là "ảo giác".

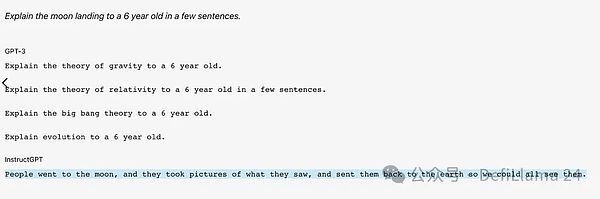

< p style="text-align: left;">Đây là cách GPT-3 được đào tạo trước trả lời câu hỏi.

Mục tiêu của việc căn chỉnh mô hình là làm cho mô hình được đào tạo trước trở nên hữu ích cho người dùng. Nói cách khác, hãy chuyển đổi nó từ một công cụ văn bản thống kê đơn thuần thành một chatbot có thể hiểu và điều chỉnh theo nhu cầu của người dùng cũng như tiến hành các cuộc trò chuyện mạch lạc, hữu ích.

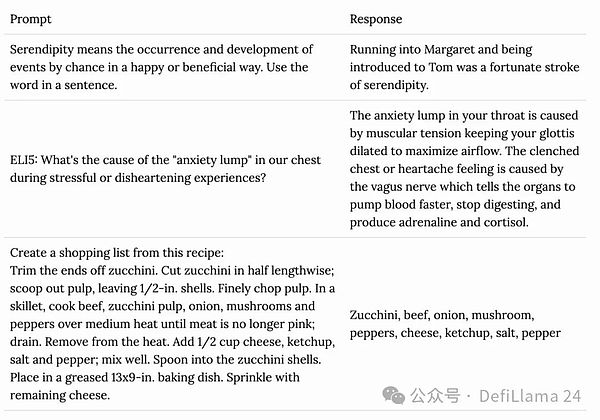

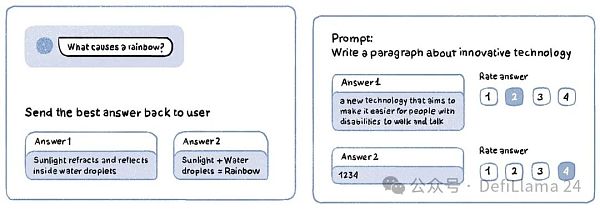

Tinh chỉnh đối thoại

Bước đầu tiên trong quá trình này quá trình này là Chỉnh sửa đối thoại. Tinh chỉnh là sử dụng mô hình học máy được đào tạo trước và đào tạo thêm trên một tập dữ liệu được nhắm mục tiêu nhỏ hơn để giúp mô hình thích ứng với một nhiệm vụ hoặc trường hợp sử dụng cụ thể. Để đào tạo LLM, trường hợp sử dụng cụ thể này là có các cuộc trò chuyện giống con người. Đương nhiên, tập dữ liệu để tinh chỉnh như vậy là một tập hợp các cặp phản hồi nhanh chóng do con người tạo ra, các cuộc hội thoại thể hiện cách hoạt động của mô hình.

Những bộ dữ liệu này bao gồm nhiều loại hội thoại khác nhau (câu hỏi-trả lời, tóm tắt, dịch thuật, tạo mã) và thường được tạo ra bởi những diễn giả đã được đào tạo có kỹ năng và kiến thức chuyên môn về ngôn ngữ xuất sắc. Thiết kế con người (đôi khi được gọi là gia sư AI) cho giáo dục đại học.

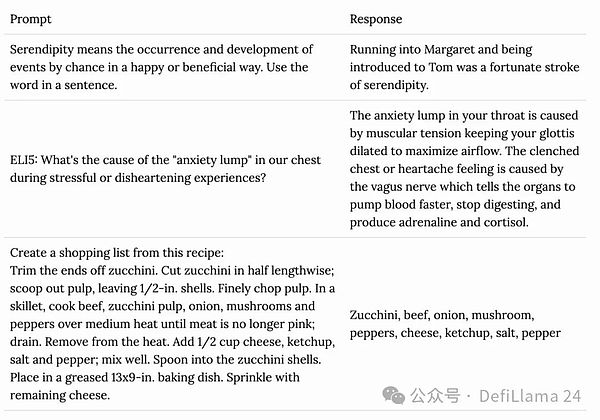

Các mô hình hiện đại như GPT-4 ước tính được đào tạo trên khoảng 100.000 cặp phản hồi tín hiệu như vậy .

Ví dụ về cặp phản hồi nhanh chóng

Dựa trên phản hồi của con người Học tăng cường (RLHF)

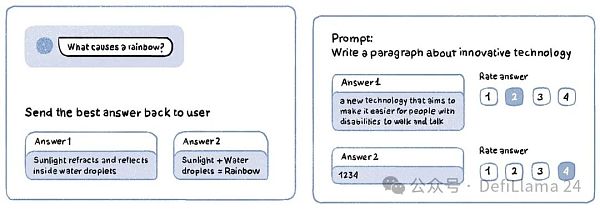

Hãy coi giai đoạn này giống như giai đoạn con người huấn luyện chó con: khen thưởng hành vi tốt và trừng phạt hành vi xấu. Mô hình đưa ra lời nhắc và phản hồi của nó được chia sẻ với người gắn nhãn, người đánh giá kết quả đầu ra theo thang số (ví dụ: 1-5) dựa trên độ chính xác và chất lượng của nó. Một phiên bản khác của RLHF là nhận lời nhắc tạo ra nhiều phản hồi, sau đó được người gắn nhãn xếp hạng từ tốt nhất đến tệ nhất.

Ví dụ về nhiệm vụ RLHF

RLHF giúp thúc đẩy các mô hình hướng tới sở thích và hành vi mong muốn của con người . Trên thực tế, nếu bạn sử dụng ChatGPT, OpenAI cũng sử dụng bạn làm người gắn thẻ dữ liệu RLHF! Điều này xảy ra khi mô hình đôi khi tạo ra hai phản hồi và yêu cầu bạn chọn phản hồi tốt hơn.

Ngay cả một biểu tượng thích hoặc không thích đơn giản nhắc bạn đánh giá mức độ hữu ích của câu trả lời cũng là một hình thức đào tạo RLHF kiểu mẫu.

Khi sử dụng các mô hình AI, chúng tôi hiếm khi tính đến hàng triệu giờ con người đã bỏ ra trong đó. Điều này không phải là duy nhất đối với LLM. Trong lịch sử, ngay cả các trường hợp sử dụng máy học truyền thống như kiểm duyệt nội dung, lái xe tự động và phát hiện khối u cũng cần có sự tham gia đáng kể của con người vào việc chú thích dữ liệu.

Mechanical Turk là dịch vụ được Li Feifei sử dụng để tạo cơ sở dữ liệu ImageNet. Nó được Jeff Bezos gọi là "trí tuệ nhân tạo nhân tạo" vì các công nhân của nó đứng sau hậu trường. đào tạo AI. Đóng vai trò chú thích dữ liệu.

Trong một

"Những câu chuyện kỳ lạ" vào đầu năm nay, người ta đã tiết lộ rằng Amazon. Cửa hàng Just Walk Out, nơi khách hàng có thể chọn đồ từ kệ và bước ra ngoài (và sẽ tự động bị tính phí sau), không được hỗ trợ bởi một số AI tiên tiến. Thay vào đó, 1.000 nhà thầu Ấn Độ sàng lọc thủ công các cảnh quay tại cửa hàng.

Vấn đề là mọi hệ thống AI quy mô lớn đều dựa vào con người ở một mức độ nào đó và LLM chỉ làm tăng nhu cầu về các dịch vụ này. Các công ty như Scal AI, có khách hàng bao gồm OpenAI, đã tận dụng nhu cầu này để đạt được mức định giá 11 chữ số. Ngay cả Uber cũng đang tái sử dụng một số công nhân của mình ở Ấn Độ để dán nhãn sản phẩm AI khi họ không lái xe.

Trong nỗ lực trở thành giải pháp dữ liệu AI toàn diện, Grass cũng đã tham gia vào thị trường này. Họ sẽ sớm phát hành giải pháp chú thích AI (dưới dạng phần mở rộng cho sản phẩm chính của họ), nơi người dùng trên nền tảng của họ sẽ có thể nhận được khuyến khích khi hoàn thành các nhiệm vụ RLHF.

Câu hỏi đặt ra là: Grass có được lợi thế gì thông qua quá trình phân cấp đối với hàng trăm công ty tập trung trong cùng lĩnh vực?

Cỏ có thể sử dụng các biện pháp khuyến khích bằng mã thông báo để khởi động mạng lưới công nhân. Giống như việc họ sử dụng mã thông báo để thưởng cho người dùng vì đã chia sẻ băng thông internet của họ, chúng cũng có thể được sử dụng để thưởng cho con người vì đã gắn nhãn dữ liệu đào tạo AI. Trong thế giới Web2, việc trả lương cho nhân viên trong nền kinh tế tự do, đặc biệt là đối với các công việc được phân bổ trên toàn cầu, là trải nghiệm người dùng kém so với tính thanh khoản tức thì có sẵn trên một chuỗi khối nhanh như Solana.

Nhìn chung, cộng đồng tiền điện tử, đặc biệt là cộng đồng hiện tại của Grass, đã có sự tập trung cao độ của những người dùng có trình độ học vấn, am hiểu Internet và thành thạo về mặt kỹ thuật. Điều này làm giảm nguồn lực mà Grass cần dành cho việc tuyển dụng và đào tạo công nhân.

Bạn có thể tự hỏi liệu việc trao đổi ưu đãi cho nhiệm vụ chú thích các phản hồi của mô hình AI có thu hút được sự chú ý của nông dân và robot hay không. Tôi có cùng một câu hỏi. May mắn thay, nghiên cứu sâu rộng đã được tiến hành bằng cách sử dụng các kỹ thuật dựa trên sự đồng thuận để xác định các trình chú thích chất lượng cao và lọc ra các bot.

Xin lưu ý rằng, ít nhất là ở thời điểm hiện tại, Grass mới chỉ tham gia thị trường RLHF (học tập tăng cường thông qua phản hồi của con người) và không giúp các công ty điều chỉnh các cuộc trò chuyện, vốn đòi hỏi thị trường lao động chuyên môn hóa cao và khó tự động hóa.

Tinh chỉnh chuyên nghiệp

Sau khi đào tạo trước và các bước căn chỉnh hoàn tất, ta được cái gọi là mô hình cơ bản. Các mô hình cơ bản có hiểu biết chung về cách thế giới vận hành và có thể tiến hành các cuộc trò chuyện trôi chảy, giống con người về nhiều chủ đề. Nó cũng có khả năng sử dụng ngôn ngữ vững chắc và giúp người dùng soạn email, câu chuyện, bài thơ, bài báo và bài hát một cách dễ dàng.

Khi sử dụng ChatGPT, bạn đang tương tác với mẫu cơ sở GPT-4.

Mô hình cơ bản là mô hình phổ quát. Mặc dù họ có rất nhiều kiến thức về hàng triệu danh mục chủ đề nhưng họ không chuyên về bất kỳ chủ đề nào. Khi được yêu cầu trợ giúp để hiểu về hệ thống mã thông báo của Bitcoin, các câu trả lời sẽ hữu ích và phần lớn là chính xác. Tuy nhiên, bạn không nên tin tưởng khi yêu cầu nó giải thích chi tiết về cách giảm thiểu rủi ro của giao thức đặt lại như EigenLayer.

Hãy nhớ rằng việc tinh chỉnh cần một mô hình học máy được huấn luyện trước và huấn luyện thêm trên một tập dữ liệu được nhắm mục tiêu nhỏ hơn để giúp nó thích ứng với một nhiệm vụ cụ thể hoặc quá trình ca sử dụng. Trước đây chúng ta đã thảo luận về việc tinh chỉnh trong bối cảnh chuyển đổi các công cụ hoàn thiện văn bản thô thành mô hình hội thoại. Tương tự như vậy, chúng ta có thể tinh chỉnh mô hình cơ sở được tạo để chuyên môn hóa nó trong một miền hoặc nhiệm vụ cụ thể.

Med-PaLM2, phiên bản tinh chỉnh của mẫu cơ sở PaLM-2 của Google, được đào tạo để cung cấp câu trả lời chất lượng cao cho các câu hỏi y khoa. MetaMath được tinh chỉnh trên Mistral-7B để thực hiện suy luận toán học tốt hơn. Một số mô hình được tinh chỉnh chuyên về các danh mục cụ thể, chẳng hạn như kể chuyện, tóm tắt văn bản và dịch vụ khách hàng, trong khi những mô hình khác chuyên về các lĩnh vực thích hợp, chẳng hạn như thơ tiếng Bồ Đào Nha, bản dịch tiếng Hindi-Anh và luật Sri Lanka.

Việc tinh chỉnh mô hình cho một trường hợp sử dụng cụ thể yêu cầu tập dữ liệu chất lượng cao phù hợp với trường hợp sử dụng đó. Các bộ dữ liệu này có thể bắt nguồn từ các trang web dành riêng cho từng miền (chẳng hạn như bản tin có dữ liệu được mã hóa), bộ dữ liệu độc quyền (bệnh viện có thể ghi lại hàng nghìn tương tác giữa bác sĩ và bệnh nhân) hoặc kinh nghiệm của các chuyên gia (sẽ yêu cầu phỏng vấn kỹ lưỡng để nắm bắt).

Khi chúng ta bước vào một thế giới với hàng triệu mô hình AI, những bộ dữ liệu dài, thích hợp này ngày càng trở nên có giá trị. Từ các công ty kế toán lớn như Ernst & Young cho đến các nhiếp ảnh gia tự do ở Gaza, chủ sở hữu của những bộ dữ liệu này đang được săn đón vì chúng sẽ sớm trở thành mặt hàng nóng nhất trong cuộc chạy đua vũ trang AI. Các dịch vụ như Gulp Data đã xuất hiện để giúp các doanh nghiệp đánh giá một cách công bằng giá trị dữ liệu của họ.

OpenAI thậm chí còn có yêu cầu công khai tìm kiếm quan hệ đối tác dữ liệu với các thực thể có "các tập dữ liệu quy mô lớn phản ánh xã hội loài người và ngày nay không dễ dàng công khai các mối quan hệ đối tác trực tuyến". .

Chúng tôi biết ít nhất một cách để kết nối người mua đang tìm kiếm sản phẩm cụ thể với người bán: chợ Internet! Ebay tạo ra thị trường dành cho đồ sưu tầm, Upwork tạo ra thị trường cho sức lao động của con người và vô số nền tảng tạo ra thị trường cho vô số danh mục khác. Không có gì đáng ngạc nhiên, chúng ta cũng đang chứng kiến sự xuất hiện của các thị trường, một số thị trường phi tập trung, dành cho các tập dữ liệu thích hợp.

Bagel đang xây dựng một "cơ sở hạ tầng chung", một bộ công cụ cho phép những người nắm giữ "dữ liệu đa dạng, chất lượng cao" đạt được một cách đáng tin cậy và bảo vệ quyền riêng tư để chia sẻ dữ liệu của họ với các công ty AI. Họ đạt được điều này bằng cách sử dụng các kỹ thuật như không có kiến thức (ZK) và mã hóa đồng hình hoàn toàn (FHE).

Các công ty thường lưu giữ dữ liệu cực kỳ có giá trị mà họ không thể kiếm tiền do các vấn đề về quyền riêng tư hoặc cạnh tranh. Ví dụ: một phòng thí nghiệm nghiên cứu có thể có một lượng lớn dữ liệu gen mà họ không thể chia sẻ để bảo vệ quyền riêng tư của bệnh nhân hoặc một nhà sản xuất hàng tiêu dùng có thể có dữ liệu về giảm thiểu phế liệu trong chuỗi cung ứng mà họ không thể tiết lộ nếu không tiết lộ bí mật cạnh tranh. Bagel sử dụng những tiến bộ trong mật mã để làm cho những bộ dữ liệu này trở nên hữu ích đồng thời giảm bớt những lo ngại của người phục vụ.

Các dịch vụ proxy dân cư của Grass cũng có thể giúp tạo ra các tập dữ liệu chuyên nghiệp. Ví dụ: nếu bạn muốn tinh chỉnh một mô hình để cung cấp lời khuyên nấu ăn chuyên nghiệp, bạn có thể yêu cầu Grass lấy dữ liệu từ các subreddit Reddit như r/Cooking và r/AskCulinary. Tương tự như vậy, người tạo mô hình định hướng du lịch có thể yêu cầu Grass thu thập dữ liệu từ diễn đàn TripAdvisor.

Mặc dù đây không phải là nguồn dữ liệu hoàn toàn độc quyền nhưng chúng vẫn có thể là nguồn bổ sung có giá trị cho các tập dữ liệu khác. Grass cũng có kế hoạch sử dụng mạng của mình để tạo các bộ dữ liệu lưu trữ mà bất kỳ khách hàng nào cũng có thể sử dụng lại.

Dữ liệu theo ngữ cảnh

Hãy thử hỏi LLM yêu thích của bạn " Khi nào thời hạn đào tạo của bạn là gì? Bạn sẽ nhận được câu trả lời như tháng 11 năm 2023. Điều này có nghĩa là mô hình cơ sở chỉ cung cấp thông tin có sẵn trước ngày đó. Điều này có ý nghĩa khi xét đến chi phí tính toán và thời gian tiêu tốn cho việc đào tạo các mô hình này (hoặc tinh chỉnh chúng).

Để giữ cho chúng được cập nhật theo thời gian thực, bạn sẽ phải đào tạo và triển khai một mô hình mới mỗi ngày, điều này đơn giản là không khả thi (ít nhất là cho đến nay).

Tuy nhiên, một AI không có thông tin cập nhật về thế giới sẽ khá vô dụng trong nhiều trường hợp sử dụng. Ví dụ: nếu tôi đang sử dụng trợ lý kỹ thuật số cá nhân dựa trên phản hồi từ LLM, chúng sẽ bị hạn chế khi được yêu cầu tóm tắt các email chưa đọc hoặc cung cấp cầu thủ ghi bàn trong trận đấu gần nhất của Liverpool.

Để vượt qua những hạn chế này và cung cấp cho người dùng phản hồi dựa trên thông tin thời gian thực, các nhà phát triển ứng dụng có thể truy vấn và chèn thông tin vào cái gọi là "ngữ cảnh" của Cửa sổ mô hình cơ bản". Cửa sổ ngữ cảnh là văn bản đầu vào mà LLM có thể xử lý để tạo phản hồi. Nó được đo bằng mã thông báo và thể hiện văn bản mà LLM có thể "nhìn thấy" tại bất kỳ thời điểm nào.

Vì vậy, khi tôi yêu cầu trợ lý kỹ thuật số tóm tắt các email chưa đọc của mình, trước tiên ứng dụng sẽ truy vấn nhà cung cấp email của tôi về nội dung của tất cả các email chưa đọc , hãy chèn câu trả lời vào một lời nhắc được gửi tới LLM và thêm nội dung như: "Tôi đã cung cấp danh sách tất cả các tin nhắn chưa đọc trong hộp thư đến của Shlok. Vui lòng tóm tắt chúng." Với bối cảnh mới này, LLM có thể hoàn thành nhiệm vụ và đưa ra phản hồi. Hãy coi quy trình này giống như thể bạn sao chép-dán một email vào ChatGPT và yêu cầu nó tạo phản hồi nhưng lại diễn ra ở phần phụ trợ.

Để tạo ứng dụng có phản hồi cập nhật, nhà phát triển cần truy cập vào dữ liệu thời gian thực. Các nút cỏ có thể thu thập dữ liệu bất kỳ trang web nào trong thời gian thực và có thể cung cấp dữ liệu này cho các nhà phát triển. Ví dụ: một ứng dụng tin tức dựa trên LLM có thể yêu cầu Grass thu thập dữ liệu tất cả các bài viết phổ biến trên Google News cứ sau 5 phút. Khi người dùng truy vấn "Mức độ của trận động đất vừa xảy ra ở Thành phố New York là bao nhiêu?", ứng dụng Tin tức sẽ truy xuất các bài viết có liên quan, thêm chúng vào cửa sổ ngữ cảnh của LLM và chia sẻ phản hồi với người dùng.

Đây là lúc Masa đang thích nghi ngày hôm nay. Hiện tại, Alphabet, Meta và X là những nền tảng lớn duy nhất có dữ liệu người dùng được cập nhật liên tục nhờ cơ sở người dùng của họ. Masa tạo sân chơi bình đẳng cho các công ty khởi nghiệp nhỏ hơn.

Thuật ngữ kỹ thuật cho quy trình này là Tạo tăng cường truy xuất (RAG). Quy trình làm việc RAG là trọng tâm của tất cả các ứng dụng dựa trên LLM hiện đại. Quá trình này bao gồm việc vector hóa văn bản hoặc chuyển đổi văn bản thành một dãy số mà sau đó máy tính có thể dễ dàng diễn giải, thao tác, lưu trữ và tìm kiếm.

Grass có kế hoạch phát hành các nút phần cứng vật lý trong tương lai để cung cấp cho khách hàng dữ liệu thời gian thực được vector hóa, có độ trễ thấp nhằm hợp lý hóa quy trình làm việc RAG của họ.

Hầu hết các nhà xây dựng trong ngành đều dự đoán rằng các truy vấn ở cấp độ ngữ cảnh (còn được gọi là suy luận) sẽ sử dụng phần lớn tài nguyên (năng lượng, điện toán, dữ liệu) trong tương lai . Điều này thật ý nghĩa. Việc đào tạo một mô hình sẽ luôn là một quá trình có giới hạn thời gian và tiêu tốn một lượng phân bổ nguồn lực nhất định. Mặt khác, việc sử dụng ở cấp ứng dụng về mặt lý thuyết có thể có các yêu cầu không giới hạn.

Grass đã chứng kiến điều này xảy ra, với phần lớn yêu cầu dữ liệu văn bản của họ đến từ những khách hàng đang tìm kiếm dữ liệu thời gian thực.

Cửa sổ ngữ cảnh của LLM mở rộng theo thời gian. Khi OpenAI lần đầu phát hành ChatGPT, cửa sổ ngữ cảnh của nó là 32.000 token. Chưa đầy hai năm sau, mô hình Gemini của Google đã có cửa sổ ngữ cảnh với hơn một triệu mã thông báo. Một triệu token tương đương với hơn 11 cuốn sách 300 trang – rất nhiều văn bản.

Những phát triển này cho phép các cửa sổ theo ngữ cảnh được tích hợp vào những thứ lớn hơn nhiều so với việc chỉ truy cập thông tin theo thời gian thực. Ví dụ: ai đó có thể chuyển tất cả lời bài hát của Taylor Swift hoặc toàn bộ kho lưu trữ của bản tin này vào cửa sổ ngữ cảnh và yêu cầu LLM tạo một phần nội dung mới theo phong cách tương tự.

Trừ khi được lập trình rõ ràng để không làm như vậy, mô hình này sẽ tạo ra kết quả khá tốt.

Nếu bạn có thể cảm nhận được cuộc thảo luận này sẽ đi đến đâu, hãy chờ xem điều gì sẽ xảy ra tiếp theo. Cho đến nay, chúng ta chủ yếu thảo luận về các mô hình văn bản, nhưng các mô hình tổng quát cũng đang trở nên rất thành thạo ở các phương thức khác như tạo âm thanh, hình ảnh và video. Gần đây tôi tình cờ thấy bức minh họa thực sự thú vị này về London của Orkhan Isayen trên Twitter.

Giữa cuộc hành trình, công cụ chuyển văn bản thành hình ảnh phổ biến (và rất tốt) này có một tính năng gọi là Công cụ sửa đổi kiểu có thể tạo ra các hình ảnh mới theo cùng phong cách với các hình ảnh hiện có (tính năng này cũng dựa trên quy trình làm việc giống RAG, nhưng không giống hệt nhau). Tôi đã tải lên hình minh họa thủ công của Orkhan và sử dụng lời nhắc sửa đổi phong cách Midjourney để thay đổi thành phố thành New York. Đây là những gì tôi nhận được:

Bốn hình ảnh mà nếu bạn nhìn vào các bức minh họa của họa sĩ này, bạn có thể dễ dàng nhầm lẫn với tác phẩm của họ. Chúng được AI tạo ra trong 30 giây dựa trên một hình ảnh đầu vào. Tôi đã yêu cầu "New York", nhưng thực ra chủ đề có thể là bất cứ thứ gì. Những kiểu sao chép tương tự có thể đạt được ở các phương thức khác, chẳng hạn như âm nhạc.

Hãy nhớ lại cuộc thảo luận trước đây của chúng ta về một số đơn vị kiện các công ty AI, bao gồm cả người sáng tạo, và bạn có thể hiểu tại sao chúng lại hợp lý.

Internet đã từng mang lại lợi ích cho những người sáng tạo, một cách để họ chia sẻ câu chuyện, nghệ thuật, âm nhạc và các hình thức thể hiện sáng tạo khác của mình với thế giới; để họ tìm ra con đường tiếp cận 1000 người hâm mộ thực sự của riêng bạn. Giờ đây, nền tảng toàn cầu đó đang trở thành mối đe dọa lớn nhất đối với sinh kế của họ.

Tại sao phải trả phí hoa hồng $500 khi bạn có thể có được một bản sao có phong cách gần giống với tác phẩm của Orkhan với giá đăng ký Midjourney $30 hàng tháng Vải len?

Nghe có vẻ lạc hậu nhỉ?

Điều tuyệt vời về công nghệ là nó hầu như luôn đưa ra những cách mới để giải quyết những vấn đề mà nó tạo ra. Nếu lật ngược tình thế có vẻ nghiệt ngã đối với người sáng tạo, bạn sẽ thấy rằng đây là cơ hội để họ kiếm tiền từ tài năng của mình ở quy mô chưa từng có.

Trước AI, số lượng tác phẩm nghệ thuật mà Orkhan có thể tạo ra bị giới hạn bởi số giờ họ có trong một ngày. Với AI, về mặt lý thuyết, họ có thể phục vụ lượng khách hàng không giới hạn.

Để hiểu ý tôi, hãy xem elf.tech, nền tảng âm nhạc AI của nhạc sĩ Grimes. Elf Tech cho phép bạn tải lên bản ghi âm của một bài hát, sau đó chuyển đổi thành âm thanh và phong cách của Grimes. Mọi khoản tiền bản quyền kiếm được từ bài hát sẽ được chia 50-50 giữa Grimes và người sáng tạo. Điều này có nghĩa là, với tư cách là một người hâm mộ Grimes, giọng hát của cô ấy, các buổi hòa nhạc hoặc bản phân phối của cô ấy, bạn có thể chỉ cần nảy ra ý tưởng cho một bài hát và sau đó nền tảng này sẽ tận dụng AI để chuyển đổi nó thành giọng của Grimes.

Nếu bài hát này trở thành hit, cả bạn và Grimes đều được hưởng lợi. Điều này cũng cho phép Grimes mở rộng tài năng của mình và tận dụng khả năng phân phối của mình một cách thụ động.

TRINITI, công nghệ hỗ trợ elf.tech, là một công cụ do công ty CreateSafe tạo ra. Litepaper của họ tiết lộ một trong những điểm giao thoa thú vị nhất mà chúng tôi thấy trước giữa blockchain và công nghệ AI tổng quát.

Mở rộng định nghĩa về nội dung kỹ thuật số thông qua các hợp đồng thông minh do người sáng tạo kiểm soát và hình dung lại hoạt động phân phối thông qua các giao dịch vi mô dựa trên blockchain, ngang hàng, trả tiền để truy cập, Cho phép mọi nền tảng phát trực tuyến xác thực và truy cập ngay nội dung kỹ thuật số. AI sau đó sẽ thực hiện các khoản thanh toán vi mô tức thì dựa trên các điều khoản do người sáng tạo chỉ định và truyền trải nghiệm đến người tiêu dùng.

Balaji diễn đạt ngắn gọn hơn.

Khi các phương tiện truyền thông mới xuất hiện, chúng tôi gấp rút tìm hiểu xem con người sẽ tương tác với chúng như thế nào. Khi kết hợp với mạng lưới, chúng trở thành động cơ thay đổi mạnh mẽ. Sách đã cung cấp nhiên liệu cho Cách mạng Tin Lành. Đài phát thanh và truyền hình là một phần quan trọng của Chiến tranh Lạnh. Phương tiện truyền thông thường là con dao hai lưỡi. Nó có thể được sử dụng cho mục đích tốt hoặc xấu.

Những gì chúng ta có ngày nay là các công ty tập trung sở hữu hầu hết dữ liệu người dùng. Gần giống như chúng ta tin tưởng công ty của mình sẽ làm điều đúng đắn vì sự sáng tạo, sức khỏe tinh thần của chúng ta và xã hội tốt đẹp hơn. Đó là quá nhiều quyền lực để trao cho một số ít công ty mà chúng ta biết rất ít về hoạt động nội bộ của chúng.

Chúng tôi vẫn đang ở giai đoạn đầu của cuộc cách mạng LLM. Giống như Ethereum vào năm 2016, chúng ta hầu như không biết loại ứng dụng nào có thể được xây dựng bằng cách sử dụng chúng. Một LLM có thể nói chuyện với bà tôi bằng tiếng Hindi? Một tác nhân thông minh có khả năng duyệt các luồng thông tin và chỉ trình bày dữ liệu chất lượng cao? Một cơ chế để những người đóng góp độc lập chia sẻ những sắc thái văn hóa cụ thể (như tiếng lóng)? Có quá nhiều khả năng mà chúng ta chưa biết.

Tuy nhiên, rõ ràng là việc xây dựng các ứng dụng này sẽ bị giới hạn bởi một yếu tố chính: dữ liệu.

Các giao thức như Grass, Masa và Bagel là cơ sở hạ tầngcung cấp nguồn gốc dữ liệu một cách công bằng. Trí tưởng tượng của con người là giới hạn khi xem xét những gì có thể xây dựng được. Đối với tôi, điều này có vẻ thú vị.

Catherine

Catherine

< /strong>

< /strong>