13回連続ツイート!

イリヤに続いて退社したばかりのOpenAIスーパーアライメント・リードヤン・ライクが、退社の本当の理由などを内部で明かしています。

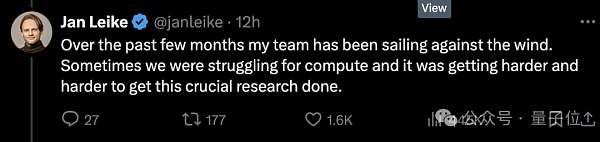

ひとつには、算数が足りなかったこと、スーパーアライメントチームに約束された20%が欠けていたことで、チームはトレンドに逆行することになったが、ますます難しくもなった。

セキュリティは優先事項ではなく、AGIのセキュリティガバナンスは「ピカピカの製品」を立ち上げることよりも優先度が低い。

さらに他の人が掘り起こしたゴシップが続く。

たとえば、OpenAIの退社するメンバーは、退社後、OpenAIの悪口を言わないことを約束する契約書に署名する必要があり、それを怠ると、会社の株を自動的に放棄したとみなされた。

しかし、セキュリティの優先順位についてコアリーダーシップと意見が合わない長い歴史を持つ、筋金入りの非署名者がまだいます(笑)。

2つの派閥間の認識の衝突は昨年の宮廷闘争で転換点に達したが、今になってようやく、むしろ名誉ある形で崩壊しつつあるように見える。

だから、ウルトラマンがスーパーアライメントチームを引き継ぐために共同創設者を送り込んだとはいえ、まだ良い状況とは言えない。

最前線に駆けつけたツイッター民は、ヤンがこの驚くべきことを勇気を持って発言したことに感謝した。

なんということだ、OpenAIは本当にこのセキュリティにあまり集中していないようだ!

しかし、振り返ってみると、現在OpenAIの舵取りをしているウルトラマンの側は、まだ闇の中にいる。アルトマンの側は、今のところおとなしくしている。

彼は表に出て、OpenAIの超整列とセキュリティに対するヤンの貢献に感謝し、ヤンがいなくなるのは実は悲しいことだと言った。

もちろん、要点は本当にこれだ:

待って、数日中にこれより長いツイートを投稿するよ。

20%の数学の約束は、実際には絵に描いた餅だ!

昨年のOpenAIの法廷闘争から現在に至るまで、会社の魂であり元チーフ・サイエンティストであるイリヤは、公の場に姿を現すことも、公の場で声明を発表することもほとんどやめてしまった。

彼が退社を公に発表する前から、意見は分かれていた。多くの人は、イリヤが人類を滅ぼしかねないAIシステムか何か、恐ろしいものを見たと考えた。

意見の相違は非常に深刻であり、その結末はもはや目に見えている。

Voxによると、OpenAIに詳しい情報筋は、セキュリティ重視の社員がウルトラマンへの信頼を失い、「信頼が少しずつ崩れていく過程だ」と明かした。"

しかし、おわかりのように、離職した従業員の多くは、公のプラットフォームや場で、このことについてオープンに語ろうとはしません。

その理由のひとつは、OpenAIには長い間、従業員に非仲介契約を含む退職合意書に署名させるという伝統があったからです。サインを拒否することは、それまでOpenAIから受けていたオプションを放棄することに等しく、つまり、表に出て発言した従業員は、巨額の金銭を失う可能性があるのです。

しかし、ドミノ倒しは次々と起こった。

イリヤの辞任は、OpenAIの最近の離職の波を悪化させた。

脱退の発表は、SuperAlignmentチームの責任者であるヤンに加えて、セキュリティチームの少なくとも5人のメンバーが脱退するという発表と密接に関連しています。

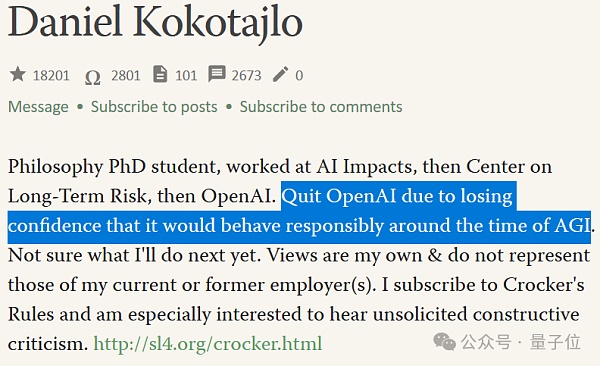

その中には、誹謗中傷禁止契約を結んでいない強硬派、ダニエル・ココタジロ(以後、ブラザーDKと呼ぶ)も含まれている。

△昨年ブラザーDKは、AIにとって存亡の大惨事が起こる可能性は70%だと思うと書いています

ブラザーDKは2022年にOpenAIに入社し、ガバナンスチームで、OpenAIがAIを安全に展開できるように導くことに注力しています。

しかし、彼は最近辞任し、一般向けのインタビューにも答えている:

オープンAIは、より強力なAIシステムを訓練しており、最終的には全面的に人間の知能を超えることを目標としている。

オープンAIは、より強力なAIシステムを訓練し、最終的にはあらゆる面で人間を凌駕することを目標としています。

これは人類にとって最高の出来事かもしれませんが、慎重に進まなければ最悪の事態にもなりかねません。

ブラザーDKは、その昔、彼はOpenAIがAGIに近づけば近づくほど説明責任を果たすことを期待し、セキュリティ・ガバナンスへの復讐心と希望を持ってOpenAIに参加したと詳しく説明した。しかし、チームの多くの人は、OpenAIがそのようなものではないことに徐々に気づいた。

「次第にOpenAOのリーダーシップと、責任を持ってAGIを処理する彼らの能力に対する信頼を失っていきました。

AGIセキュリティの将来に対する幻滅が、群衆が辞任した理由のひとつです。イリヤによって強化された離脱の波の中で、群衆が去っていく理由の一部である。

理由のもう1つは、スーパーアライメントチームが、残念なことに、研究のためのリソースがそれほど充実していないことです。

スーパーアライメントチームがフル稼働しても、チームはOpenAIが約束した演算能力の20%しか利用できないでしょう。

そして、チームの要求のいくつかは、しばしば拒否された。

もちろん、演算リソースはAI企業にとって非常に重要であるため、その隅々まで適切に割り当てられなければならないし、SuperAlignedチームの仕事は、"企業がAGIの構築に成功した場合に実際に発生するであろう、別のタイプのセキュリティ問題を解決すること "だからだ。

言い換えれば、スーパーアライメント・チームは、OpenAIが直面しなければならないであろう将来のセキュリティ問題に対処しているのです。

この記事を書いている時点では、アルトマンはまだ記事を発信していません。"(ヤンが内部で破ったものより)長い)ツイート"

しかし、彼はヤンがセキュリティーを心配するのは正しいことだと短く言及し、"我々はもっとやるべきことがたくさんある。""我々はそうすることを約束する "と述べた。

その点については、みんなは少しベンチを走って待っていればいい。

まとめると、スーパーアラインドはイリヤとヤンを中心に多くの人材を失い、嵐の中でリーダー不在のチームとなった。

そのあおりで、共同創設者のジョン・シュルマが後を継いでいるが、もはや献身的なチームはない。

新しいSuperAlignedチームは、より緩やかなグループとなり、メンバーは社内に分散することになりますが、OpenAIの広報担当者はこれを「より深い統合」と表現しています。

ジョンの本来のフルタイムの仕事は、現在のOpenAI製品のセキュリティを確保することであったため、これにも疑問が呈されています。

私は、ジョンが追加された責任をこなし、現在と将来のセキュリティに焦点を当てた2つのチームを率いることができるかどうか疑問に思っています。

イリヤとアルトマンの戦い

時系列で見ると、今日の転落は実はOpenAIの「法廷闘争」の結果です。

時系列を延ばせば、今日のフォールアウトはOpenAIのイリヤ・アルトマンとの「法廷闘争」の続編です。

時はさかのぼり、イリヤがまだいた昨年11月、彼はOpenAIの取締役会と協力して、アルトマンを解雇しようとしました。

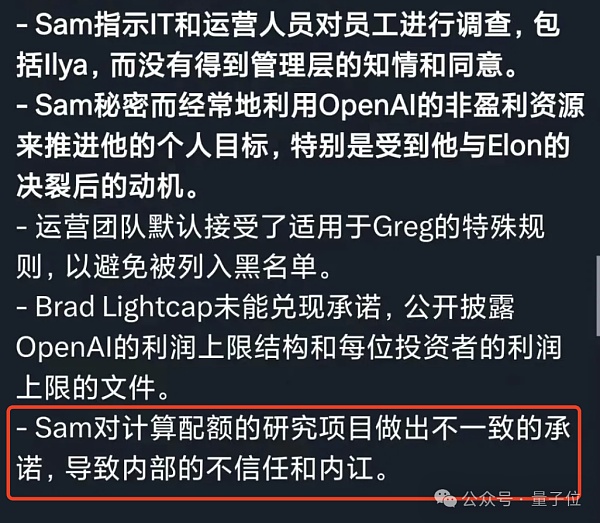

当時の理由は、アルトマンのコミュニケーションに誠意が足りないというものでした。言い換えれば、私たちは彼を信用していなかったのです。

しかし結局、結果は明らかだった。アルトマンは「同盟者」とともにマイクロソフトに加わると脅し、取締役会は屈服して彼を取締役から解任できず、イリヤは取締役を去った。イリヤは取締役会を去り、アルトマンの方は自分に好意的なメンバーを選んで取締役会に加わった。

その後、イリヤは数日前に退任が発表されるまで、ソーシャルメディアから姿を消した。そして、彼がOpenAIのオフィスに姿を現してから約半年が経過したと伝えられている。

当時、興味をそそるツイートが残されていたが、すぐに削除された。

この1ヶ月で多くのことを学んだ。そのうちのひとつは、「士気が向上するまで叩かれ続ける」という言葉が必要以上に頻繁に当てはまるということだ。

しかし、内部関係者によれば、イリヤは、この1ヶ月間、多くの教訓を得た。イリヤは遠隔操作でスーパーアライメント・チームを率いているという。

そしてアルトマン側では、従業員からの彼に対する最大の非難は、彼の言動が一貫していないということだ。例えば、彼は安全を優先したいと主張したが、彼の行動は矛盾していた。

当初約束したコンピューティング資源が与えられなかったという事実もある。また、しばらく前にサウジアラビアなどを見つけてコアを建設する資金を調達したようなこともある。

セキュリティに特化した社員たちは無知だった。

可能な限り安全な方法でAIを構築し、配備することを本当に気にかけているのであれば、技術を加速させるためにチップを必死に集めるはずがない。

以前、オープンAIはアルトマンが投資した新興企業にもチップを発注していた。その額はなんと5100万ドル(およそ3億6000万ルピー)だった。

そして、当時の宮内庁闘争時代のOpenAIの元従業員からの内部告発の手紙に書かれたウルトラマンの記述は、それを再確認させるようです。

そして、それこそが最初から最後まで"言動"の運用で、社員はウルトラマンと同様にOpenAIへの信頼を徐々に失っていった。

イリヤもそうだったし、ヤン・ライクもそうだったし、スーパーアラインドのチームもそうだった。

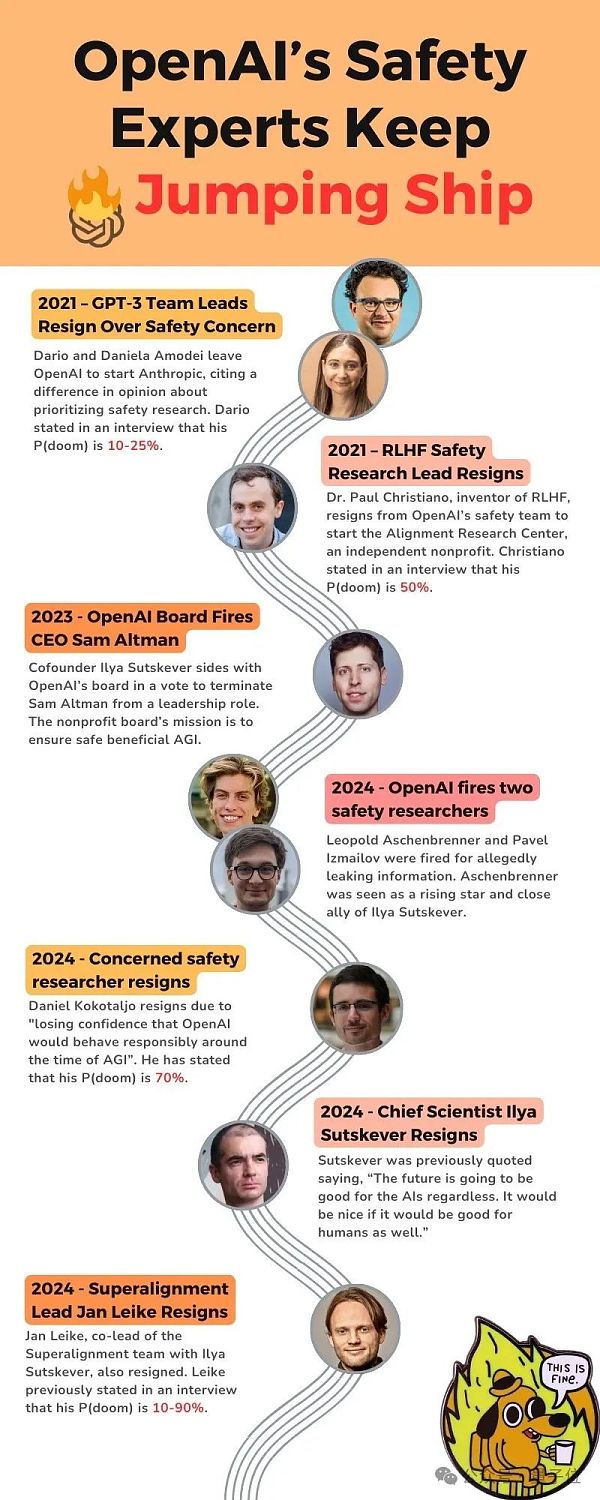

ある思慮深いユーザーが、その間に起こった関連する事柄の重要なノードをリストアップしてくれました。「AIが黙示録的なシナリオを引き起こす可能性」を意味する。

2021年、GPT-3チームのトップは「セキュリティ」の問題でOpenAIを去り、Anthropicを設立しました。

2021年、RLHFのセキュリティ研究主任が退社、P(doom)は50%に;

2023年、OpenAI理事会がAnthropicを解雇;

2023年、OpenAI理事会がAnthropicを解雇;

2023年、OpenAI理事会がAnthropicを解雇;

2023年、OpenAI理事会がAnthropicを解雇;2024年、OpenAIは2人のセキュリティ研究者を解雇する。

2024年、セキュリティに特に力を入れていたOpenAIの研究者が、P(doom)がすでに70%に達していると考え、退職する。

2024年、イリヤ、ヤン・ライクが退社。

技術かマーケティングか?

「AGIをどう実現するか」というビッグモデルのこれまでの展開は、実は2つのルートに集約される。

技術は、技術が成熟し、それを適用する前に制御可能であることを望み、市場は、それを開放し、同時に適用することが、最後まで「段階的」な方法であると考えている。

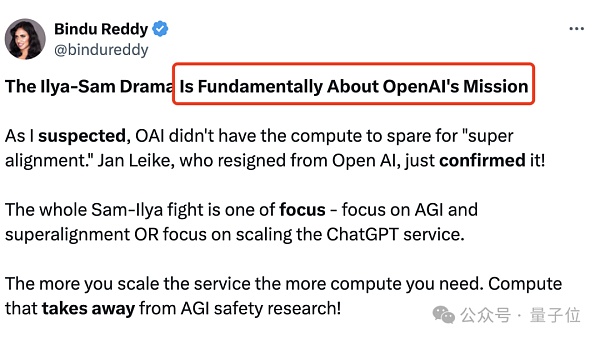

これが、イリヤとアルトマンの議論における根本的な違いであり、OpenAIのミッションである

AGIとスーパーアライメントに注力するのか、それともChatGPTサービスの拡大に注力するのか。

ChatGPTサービスの規模が大きくなればなるほど、より多くの計算が必要になります。これはまた、AGIのセキュリティ研究から時間を奪うことになります。

OpenAIが研究に専念する非営利組織であるならば、スーパーアライメントにもっと時間を費やすべきです。

そして、OpenAIのいくつかの対外的な取り組みから判断すると、そうでないことは明らかであり、彼らはただビッグモデル競争に先んじ、企業や消費者により多くのサービスを提供しようとしているだけなのです。

イリヤの考えでは、これは非常に危険なことだ。規模を拡大したときに何が起こるかわからないとしても、イリヤの考えでは、まずは安全であることが一番なのだ。

私たち人間が、AGIが秘密裏に構築されたものではなく、安全に構築されたものであることを確認できるようにするための、公開性と透明性。

しかし、アルトマン率いるOpenAIは、オープンソースもスーパーアライメントも追求していないようだ。その代わりに、堀を築こうとしながらAGIの方向に暴走しているのだ。

では、AI科学者のイリヤは正しい選択をしたのか、それともシリコンバレーの実業家アルトマンがトップに立ったのか?

まだ知る由もない。しかし、少なくともOpenAIは今、重大な決断を迫られている。

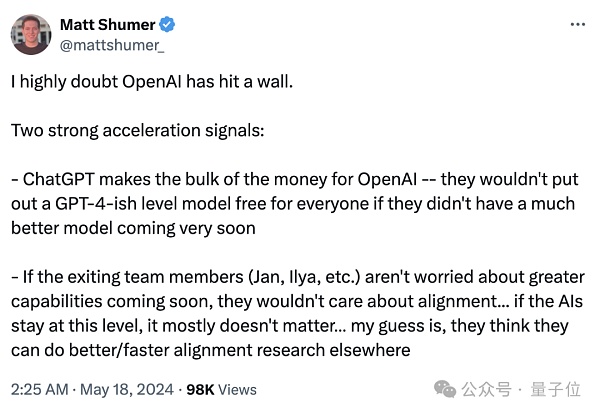

ある業界関係者は、2つの重要なシグナルをまとめました。

もう1つは、もし離脱するチームメンバー(ヤン、イリヤなど)がすぐにより強力になることを心配していないのであれば、彼らはアライメントを気にしないだろう...ということです。...そして、AIがそのレベルにとどまるかどうかは、基本的に問題ではない。

しかし、OpenAIの根本的な矛盾は解決されていません。しかし、OpenAIの根本的な矛盾は解決されていない。一方では、火事場泥棒のようなAI科学者がAGIの責任ある開発を懸念し、他方では、シリコンバレーの市場関係者が商業的に持続可能な方法で技術を押し進めようと必死になっている。

両者は和解不可能となり、科学側はOpenAIから完全に手を引きつつあり、外の世界はGPTがどこまで進んでいるのかまだ知らない。

その答えを知りたくてたまらない群衆は、少々疲れてきている。

イリヤの恩師であり、チューリング賞三人組の一人であるヒントンが言ったように、無力感が襲ってきた:

私は年をとっているし、心配もしているが、できることは何もない。

参考リンク:

[1]https://www.vox.com/future-perfect/2024/5/17/24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2]https://x.com/janleike/status/1791498174659715494

[3]https://twitter.com/sama/status/1791543264090472660

XingChi

XingChi

XingChi

XingChi JinseFinance

JinseFinance JinseFinance

JinseFinance Weatherly

Weatherly Glassnode

Glassnode Coindesk

Coindesk Others

Others Cointelegraph

Cointelegraph 链向资讯

链向资讯 Ftftx

Ftftx